- Python Keywords

- 數學

- Notes

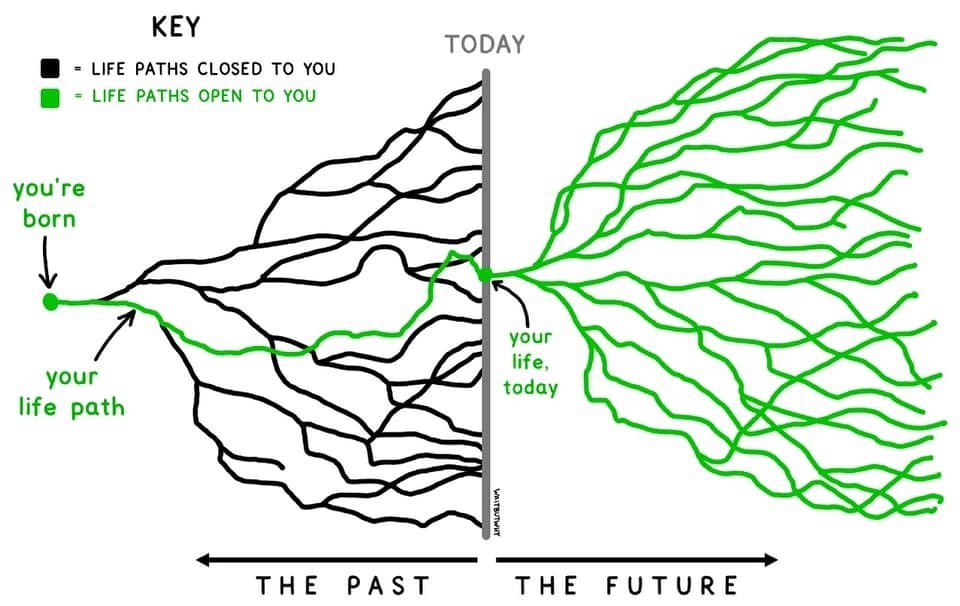

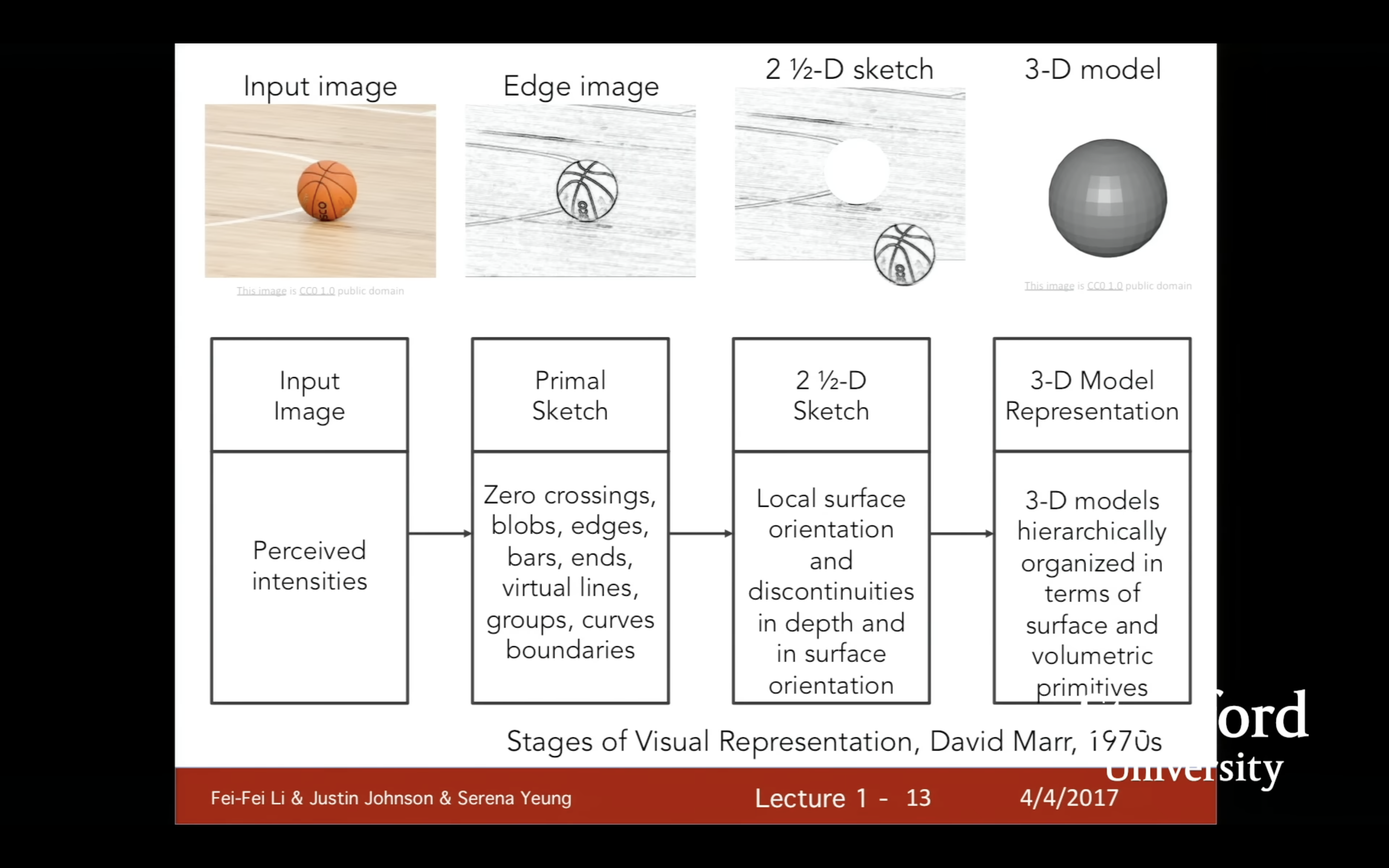

- Lecture 1

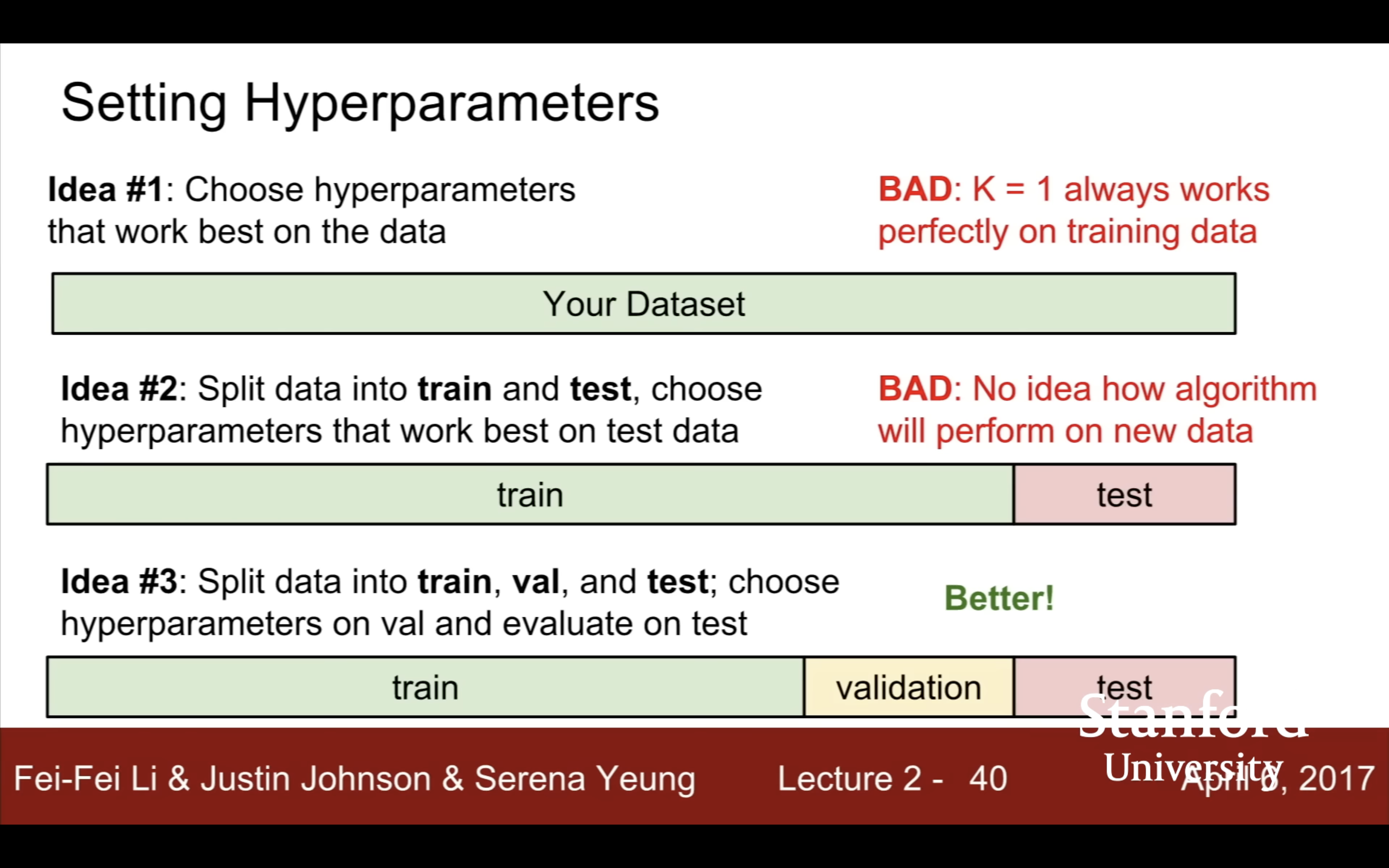

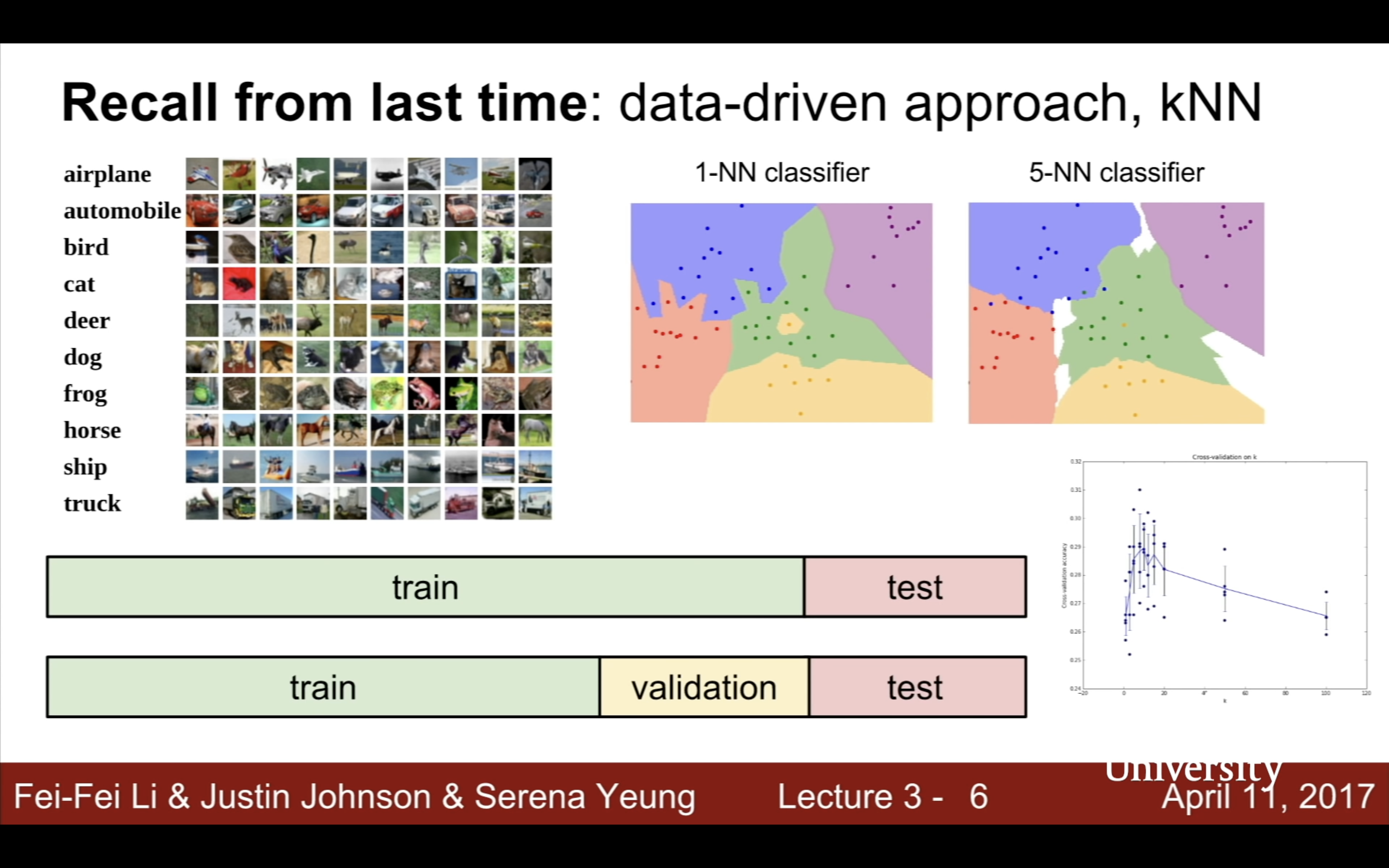

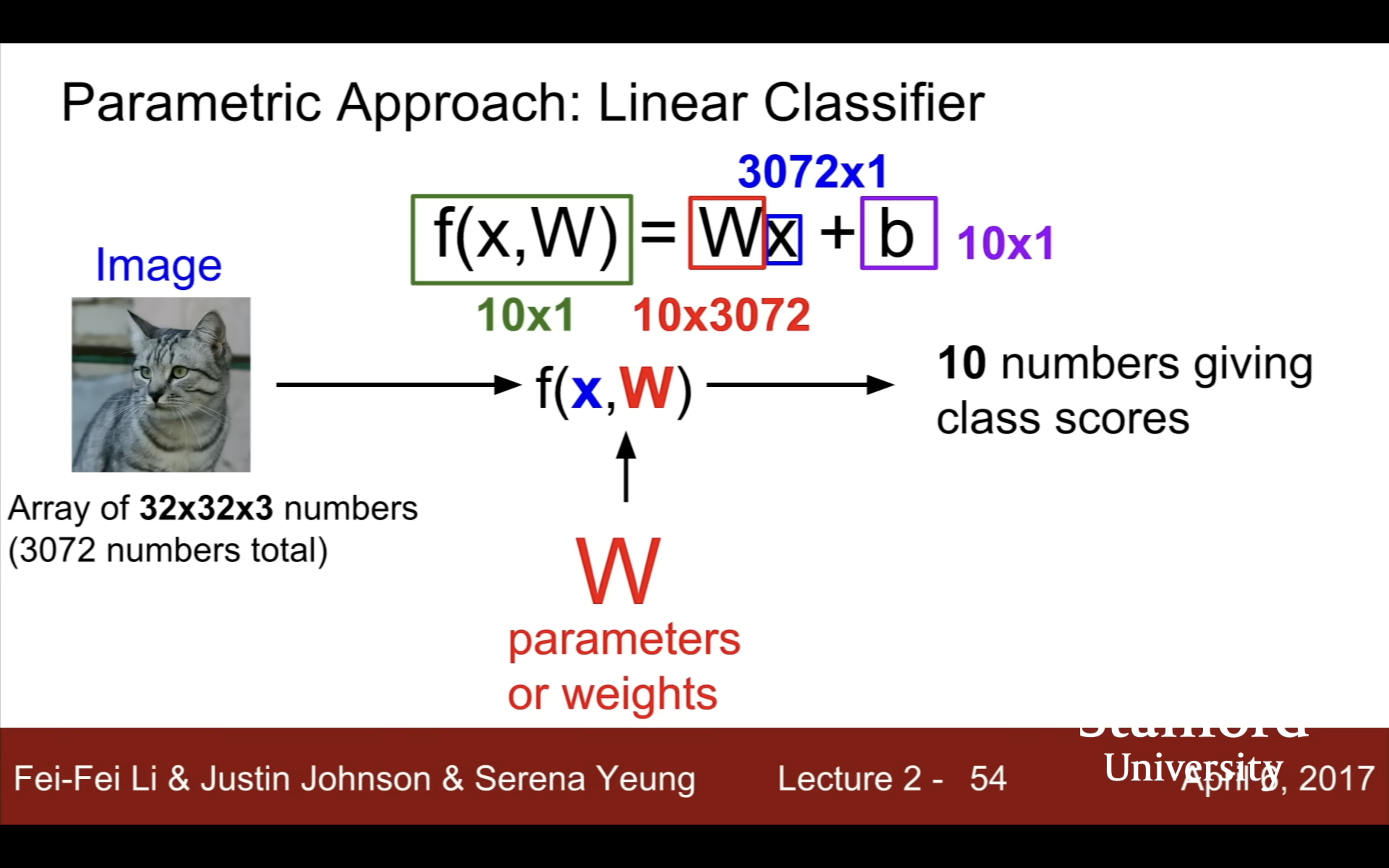

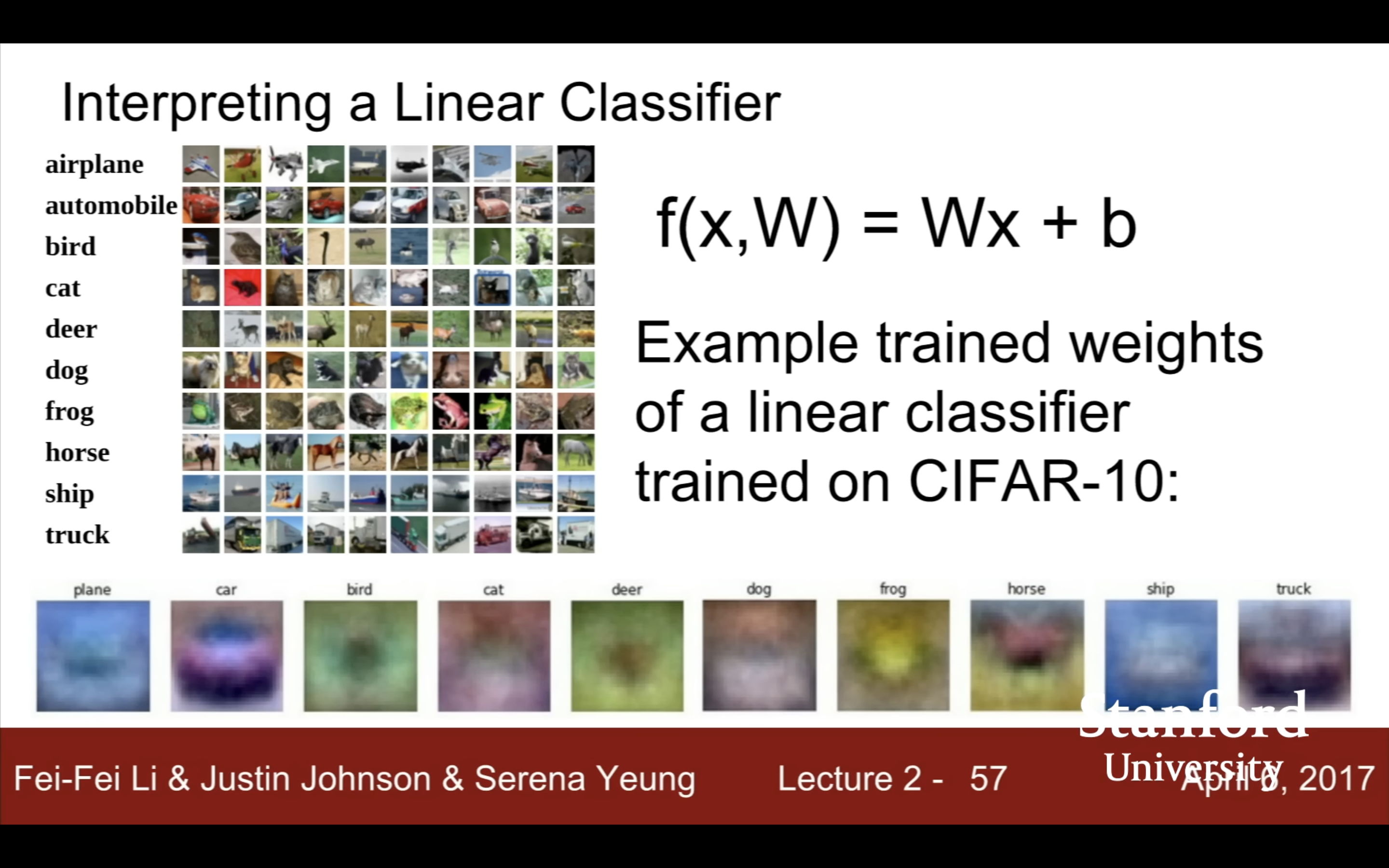

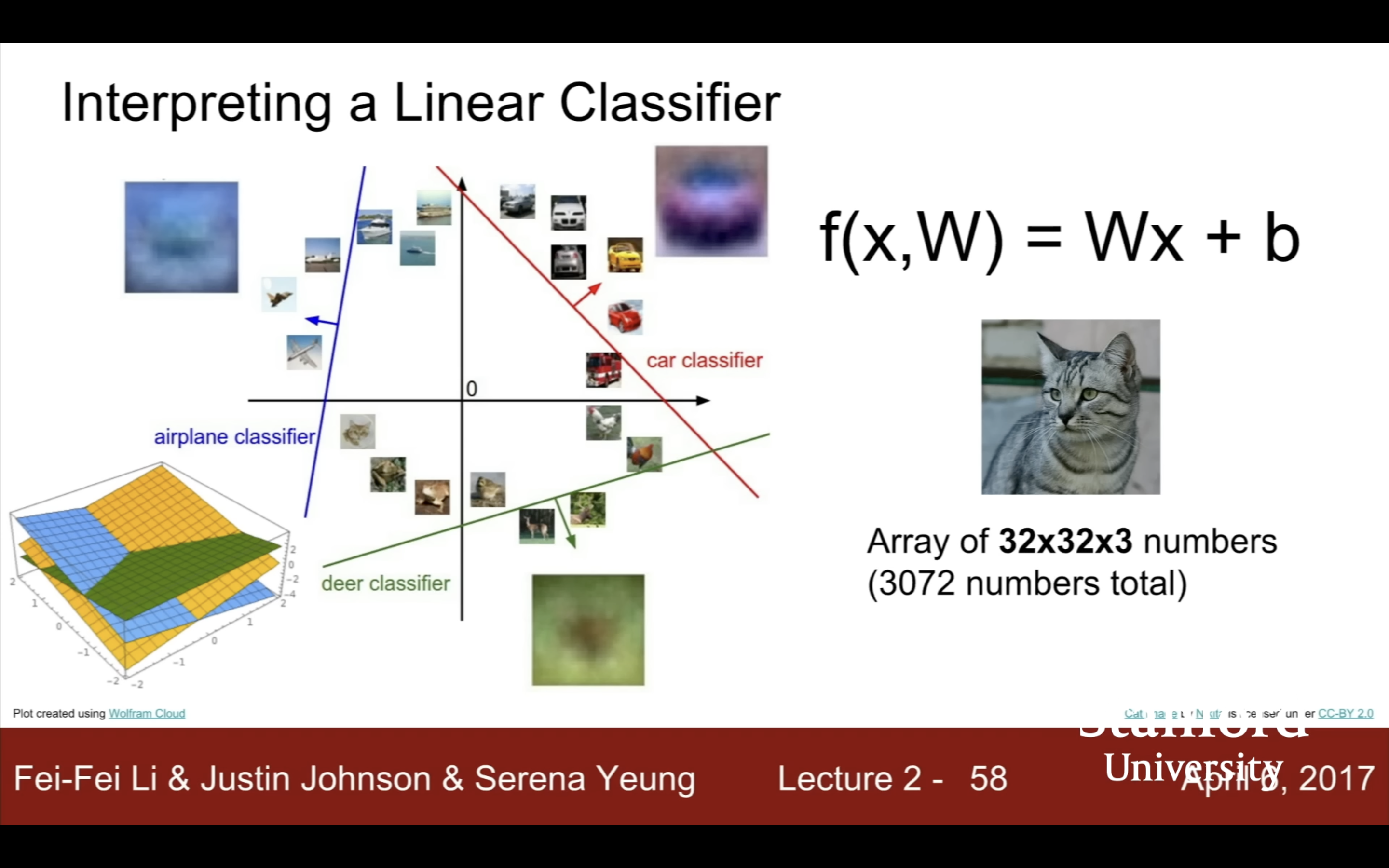

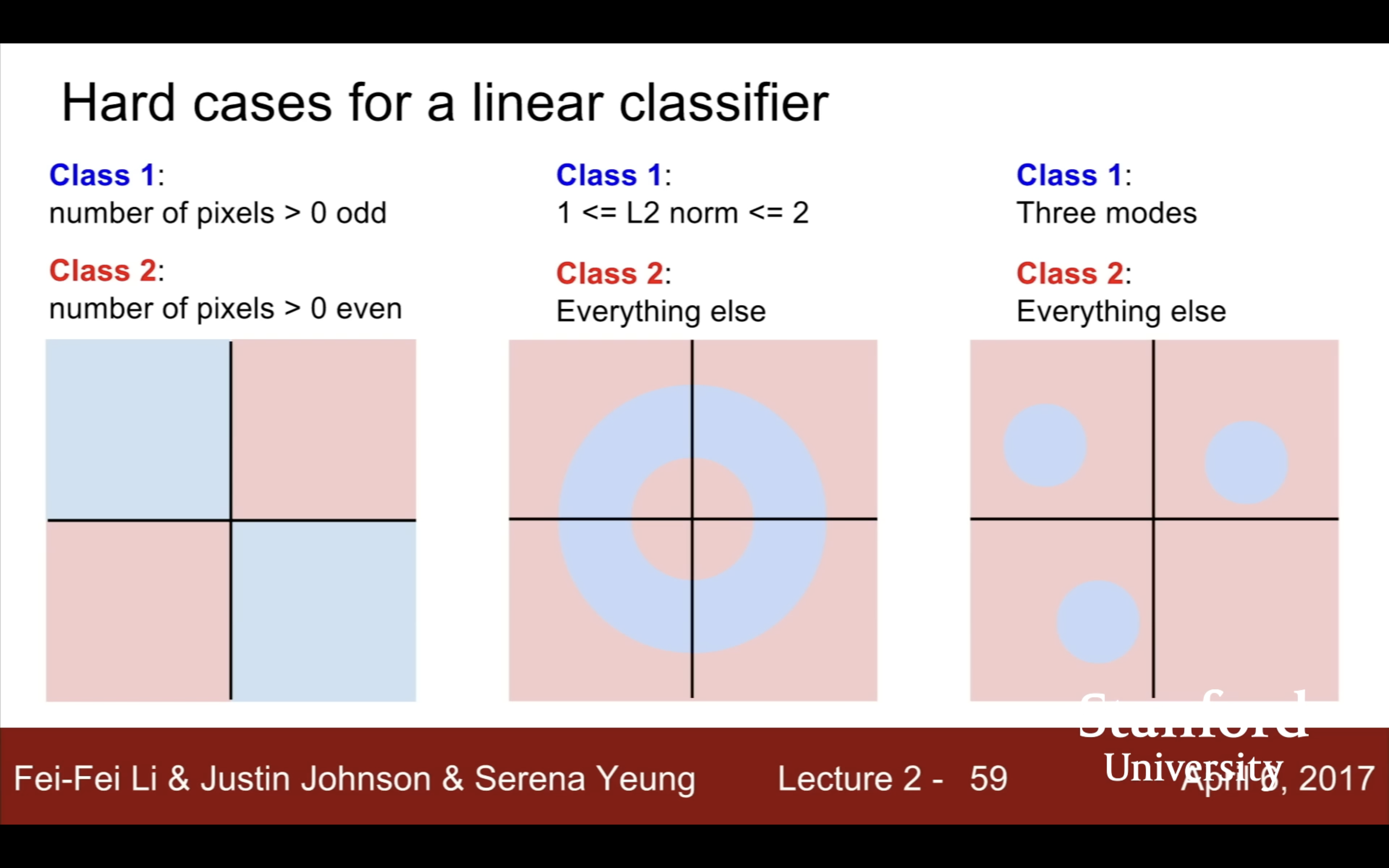

- Lecture 2

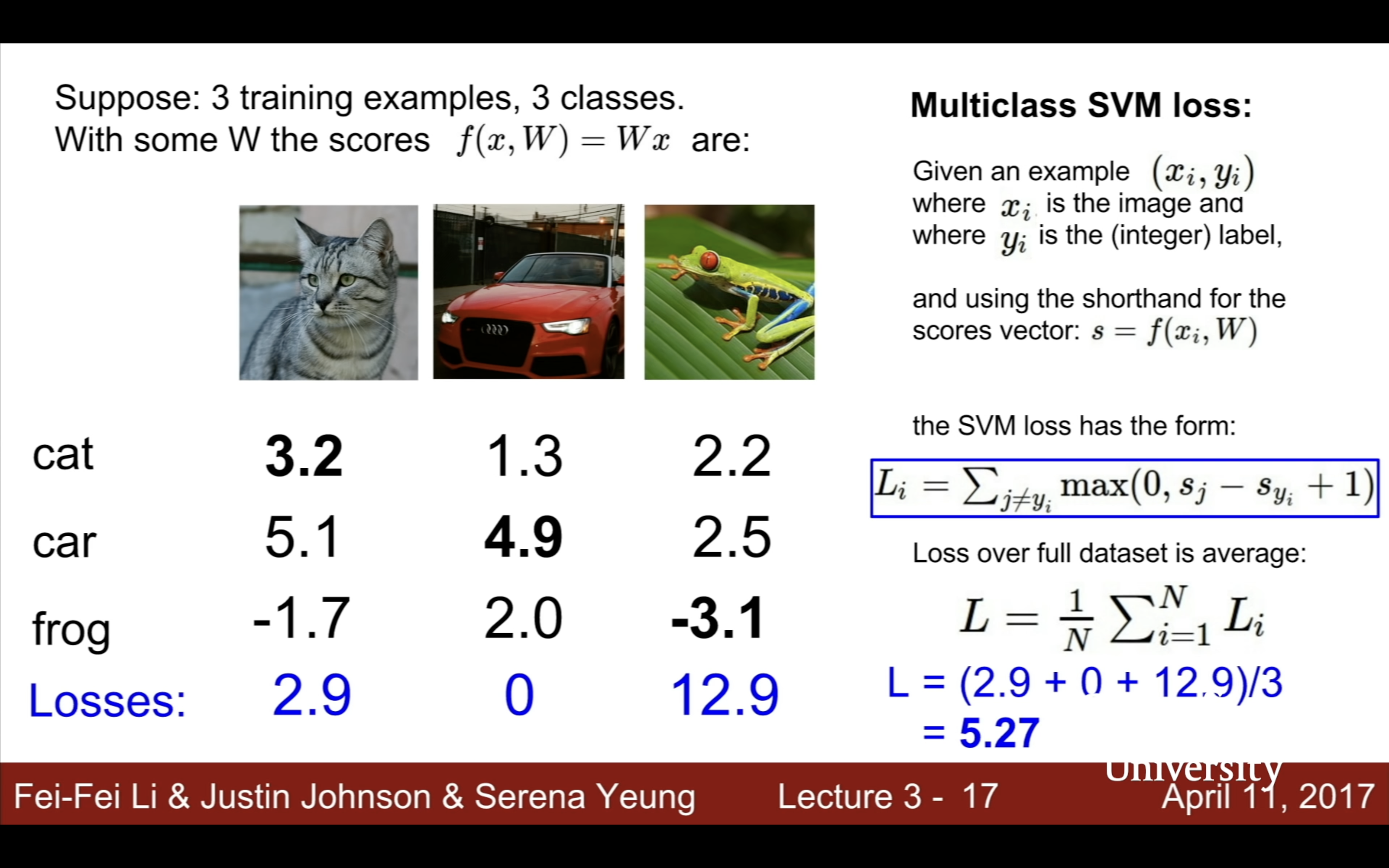

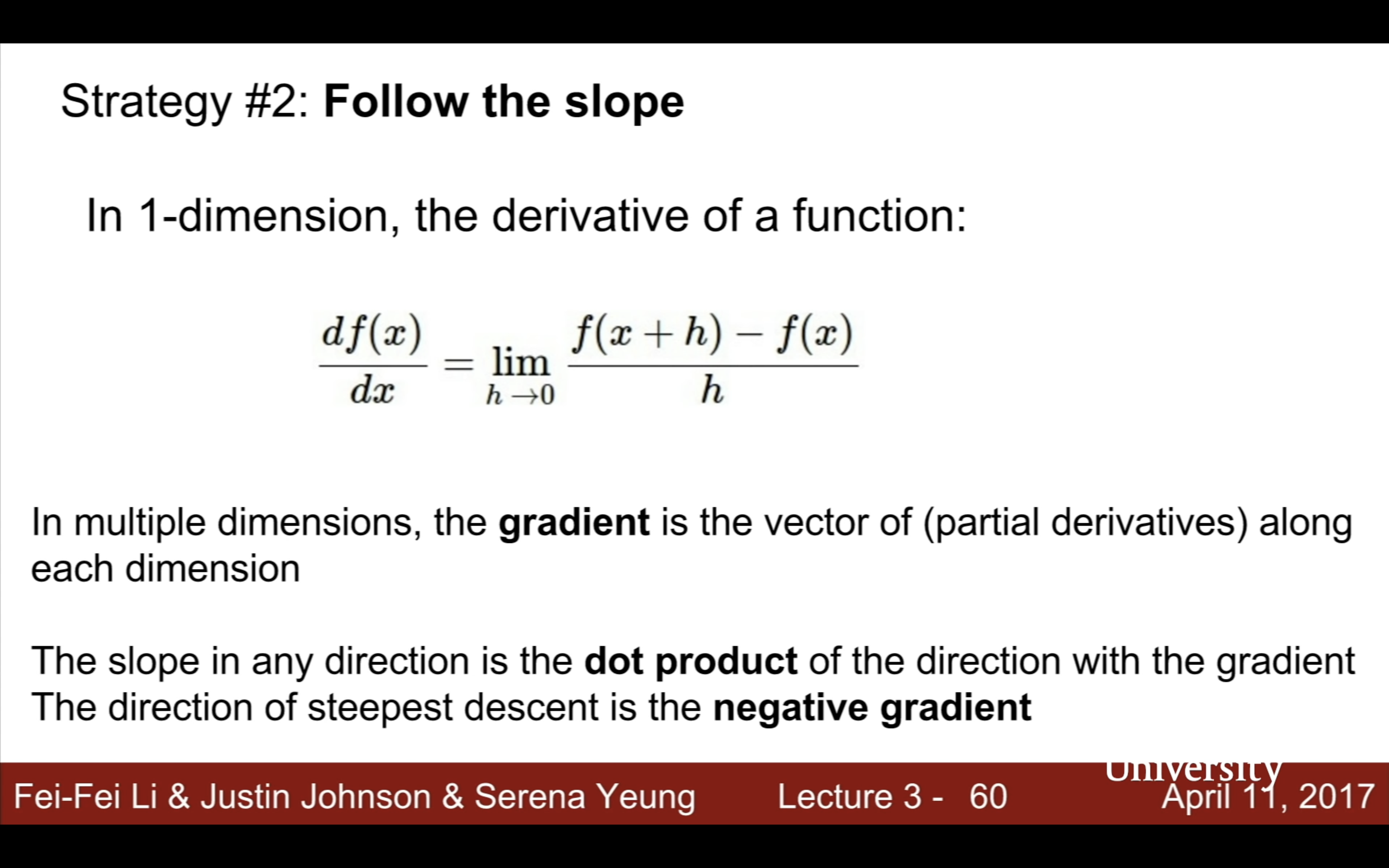

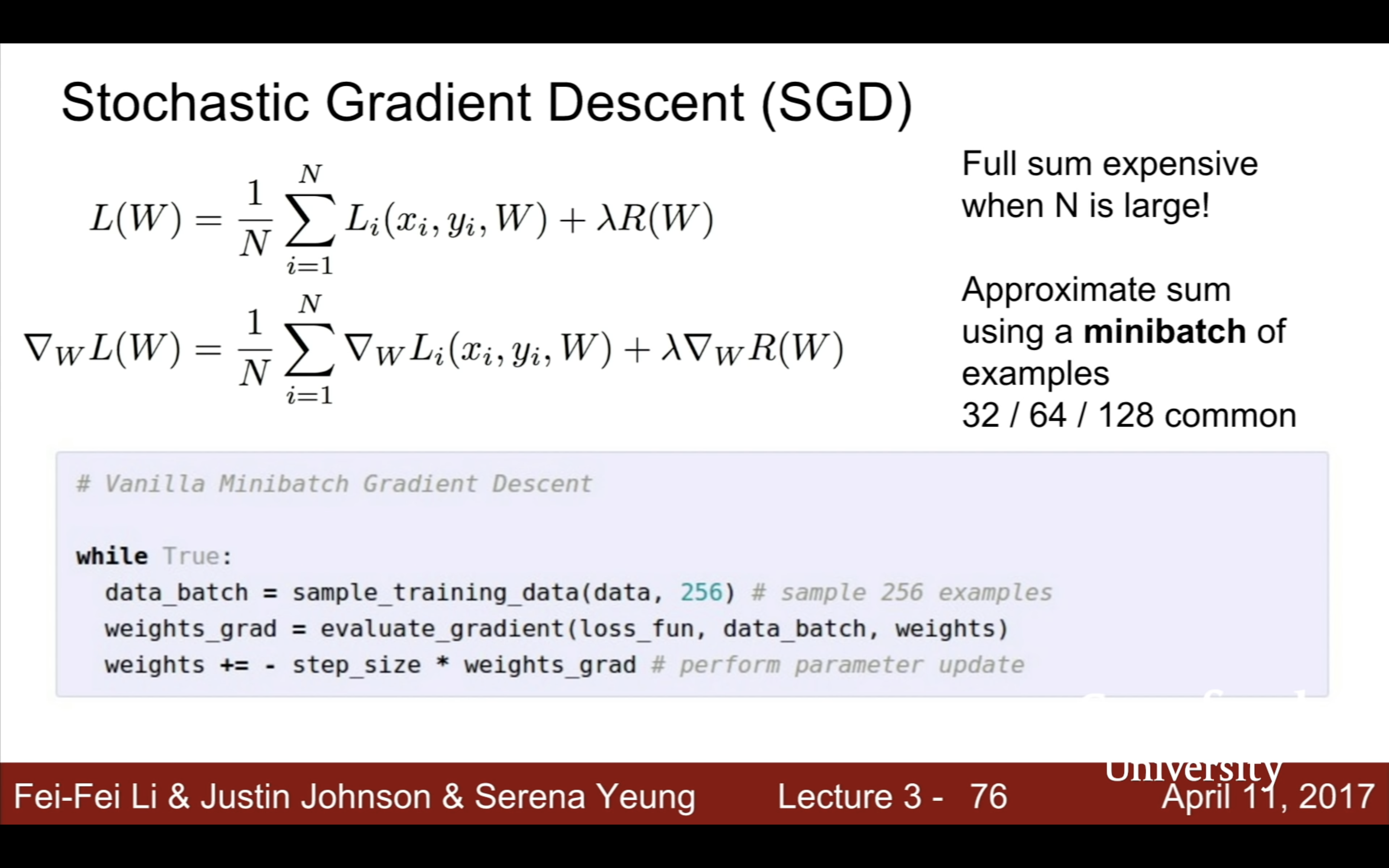

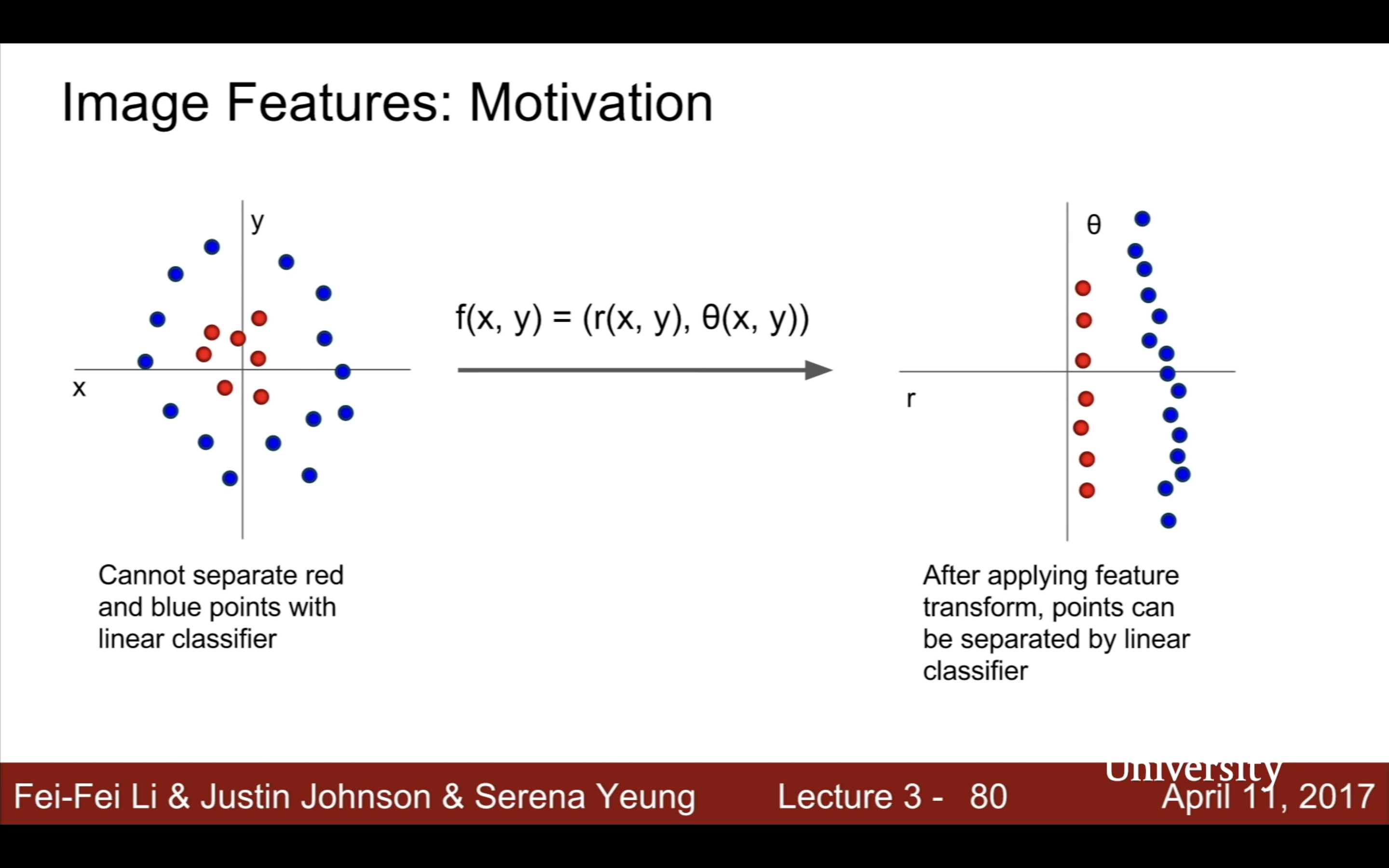

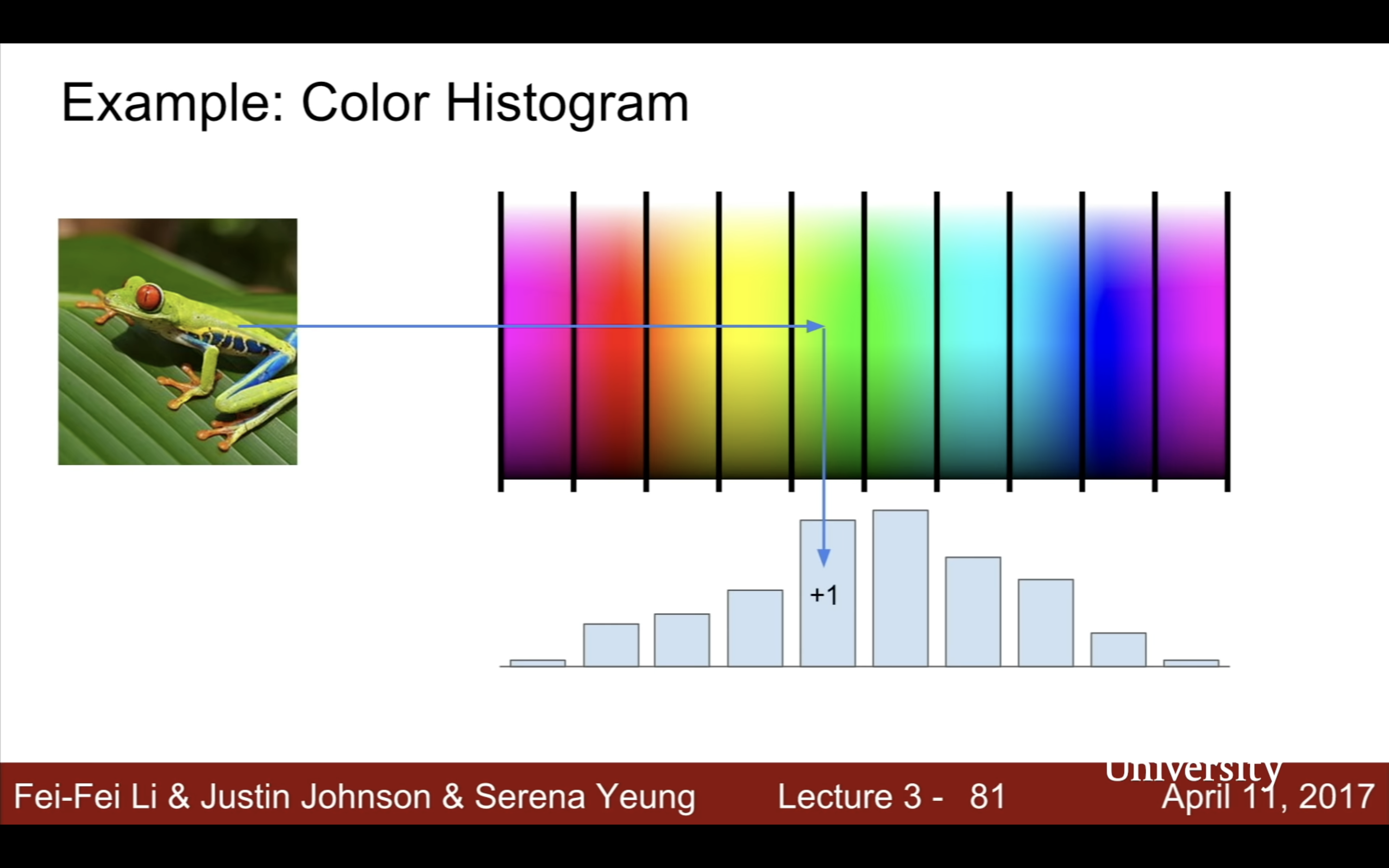

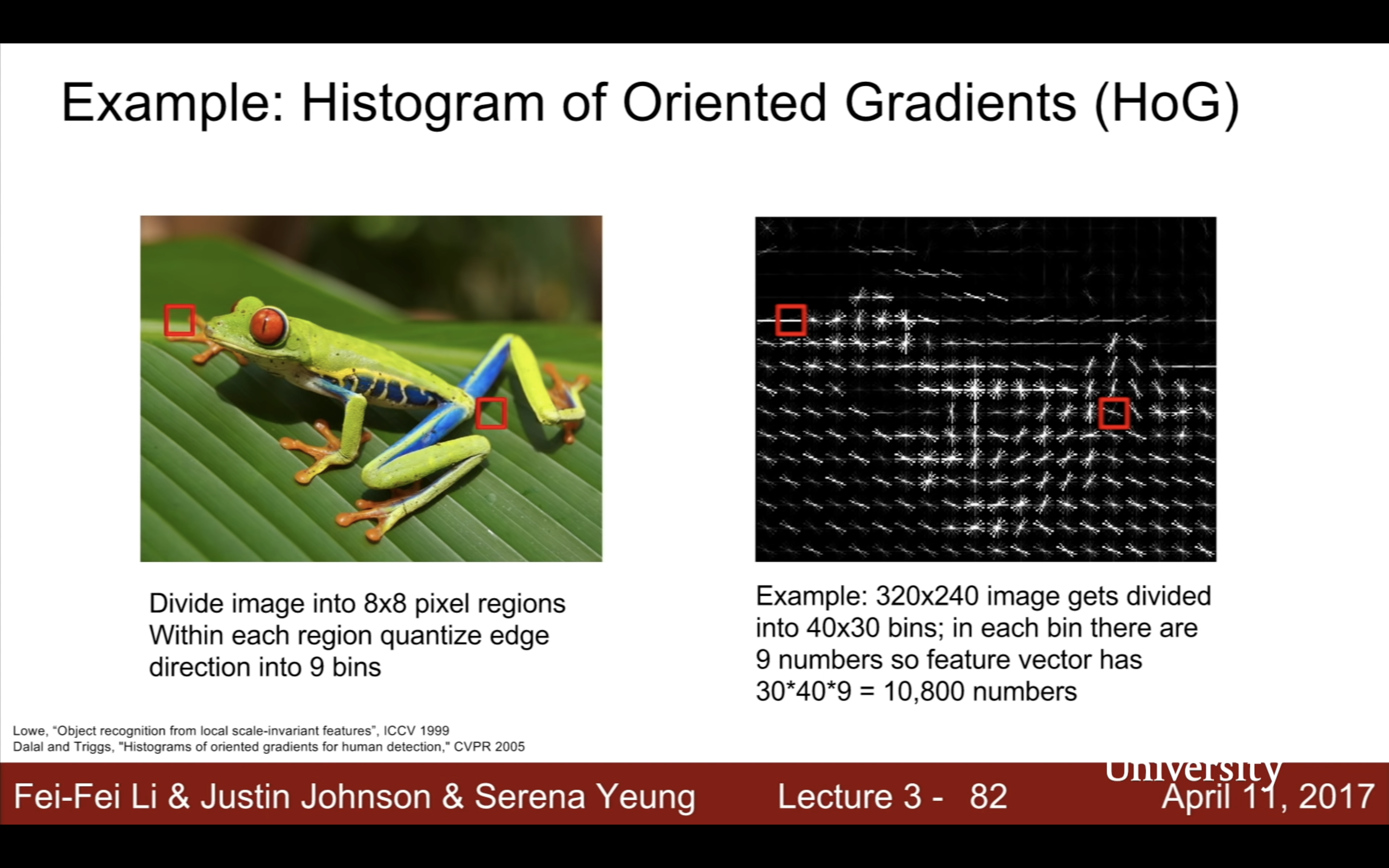

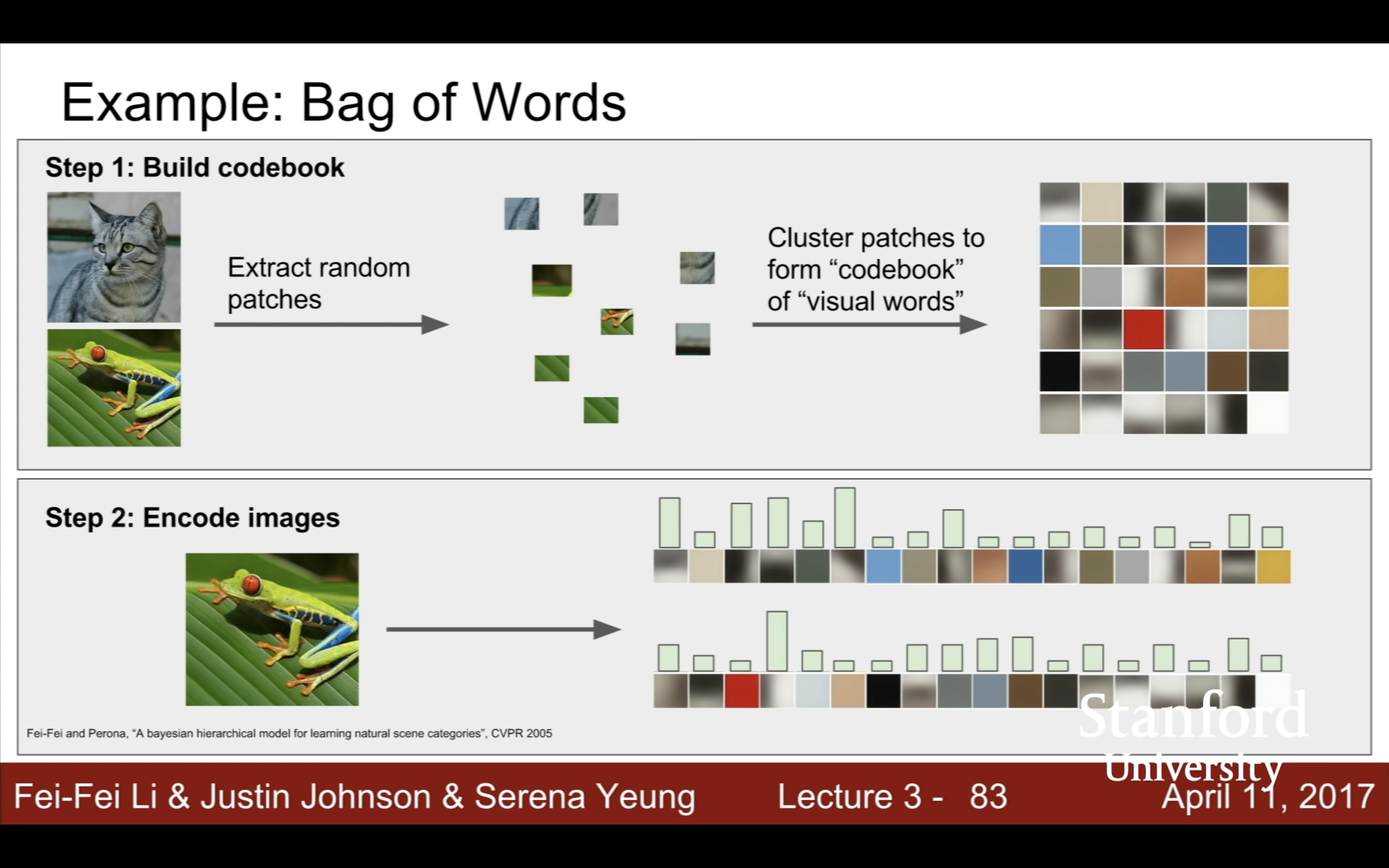

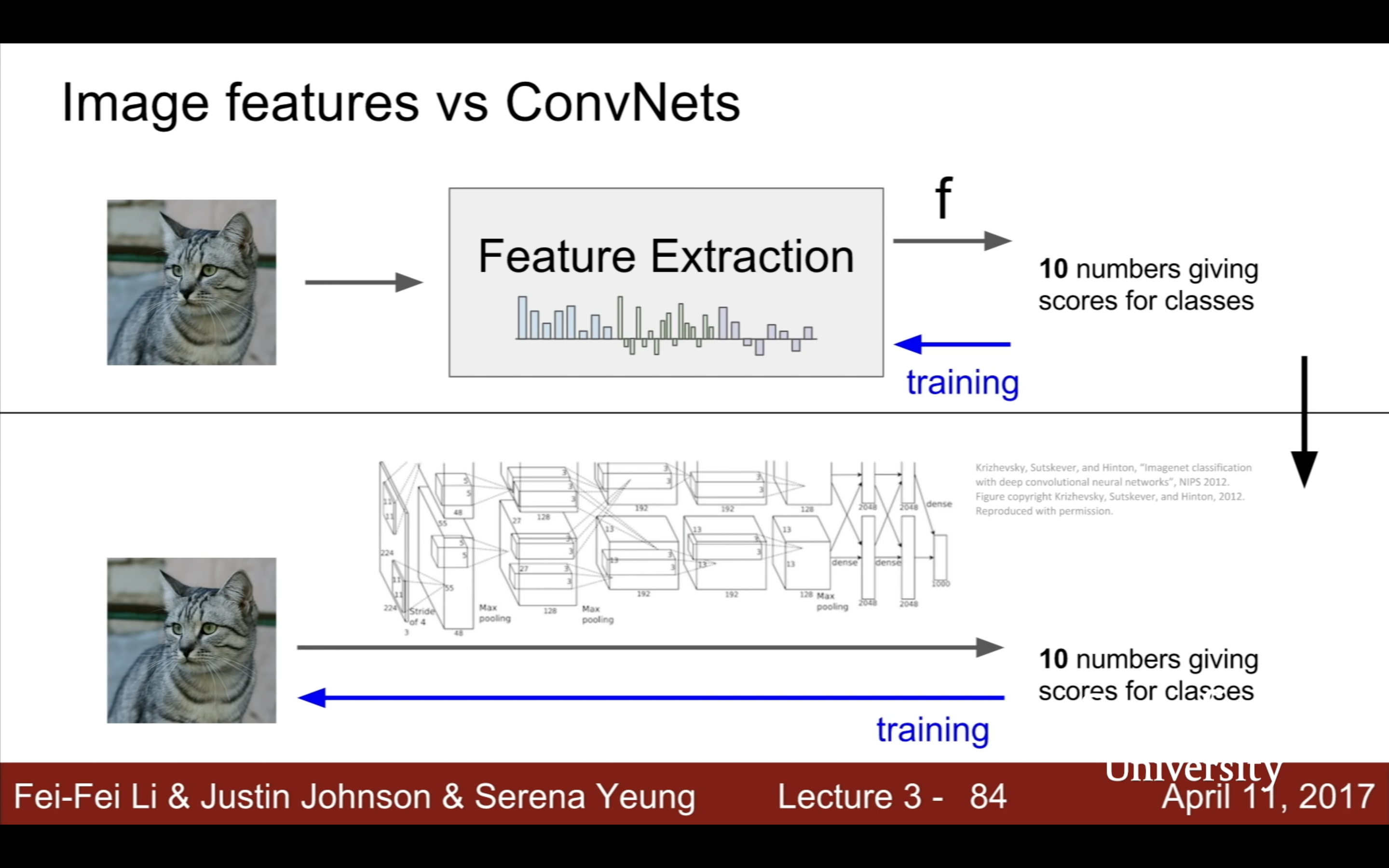

- Lecture 3

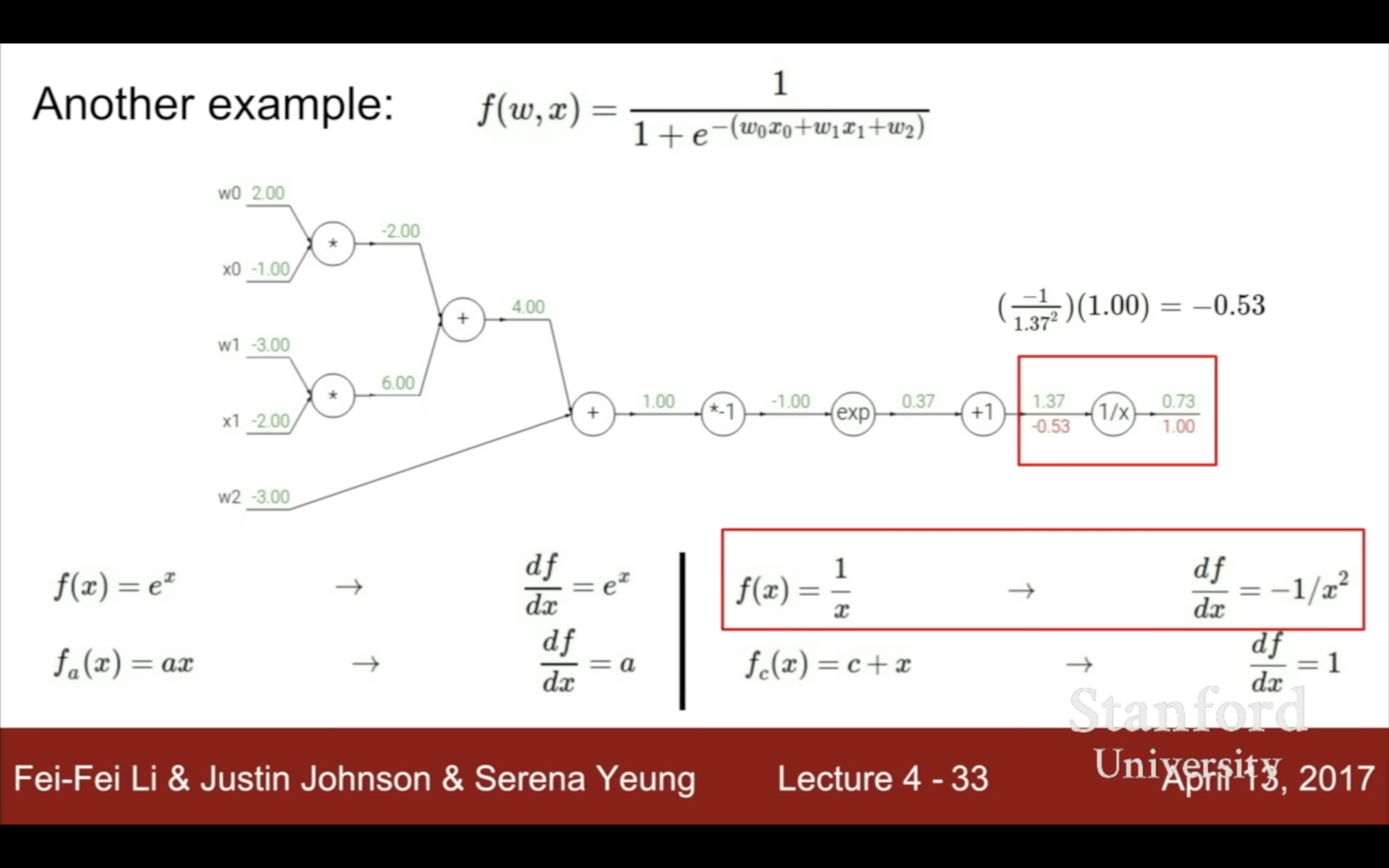

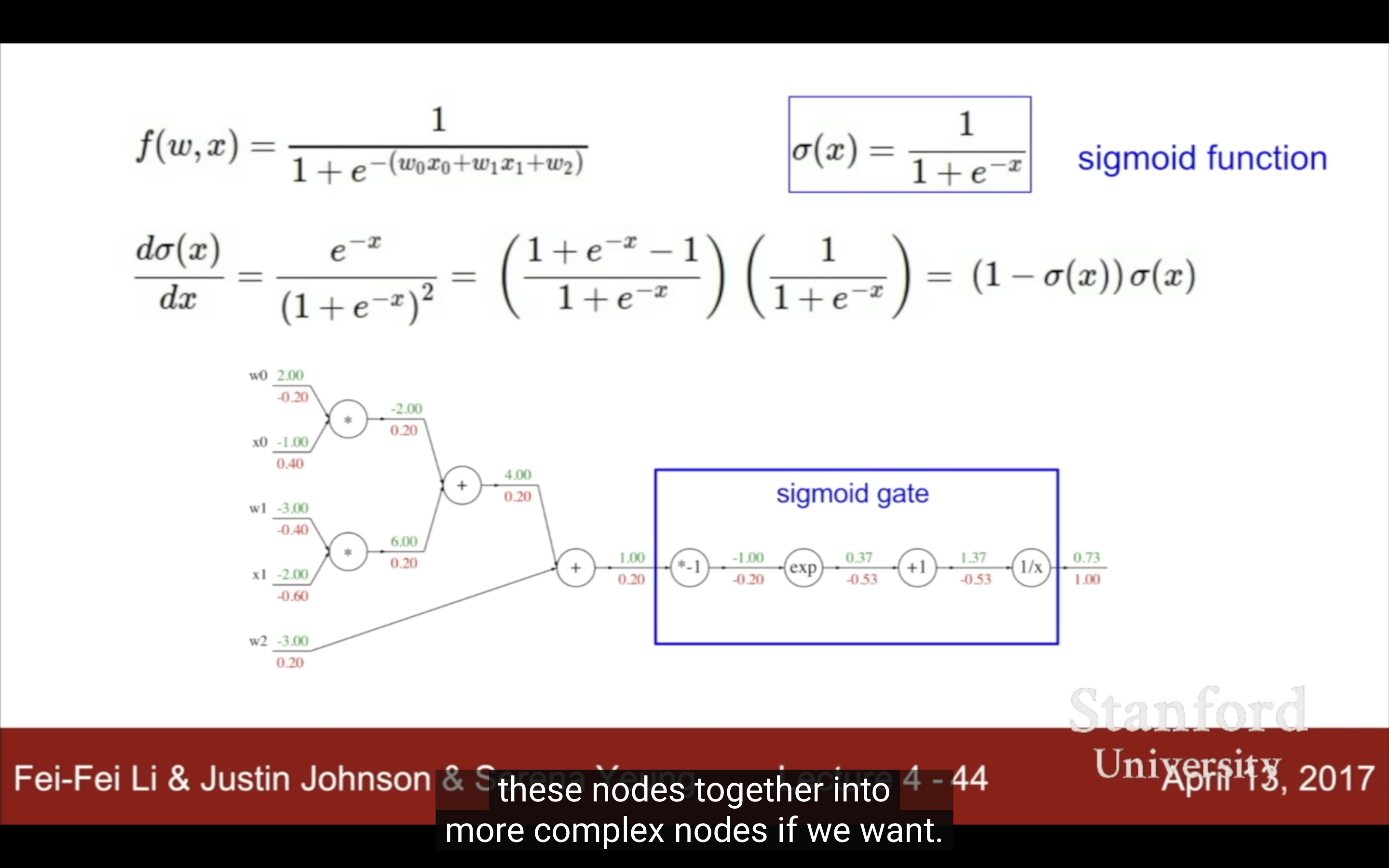

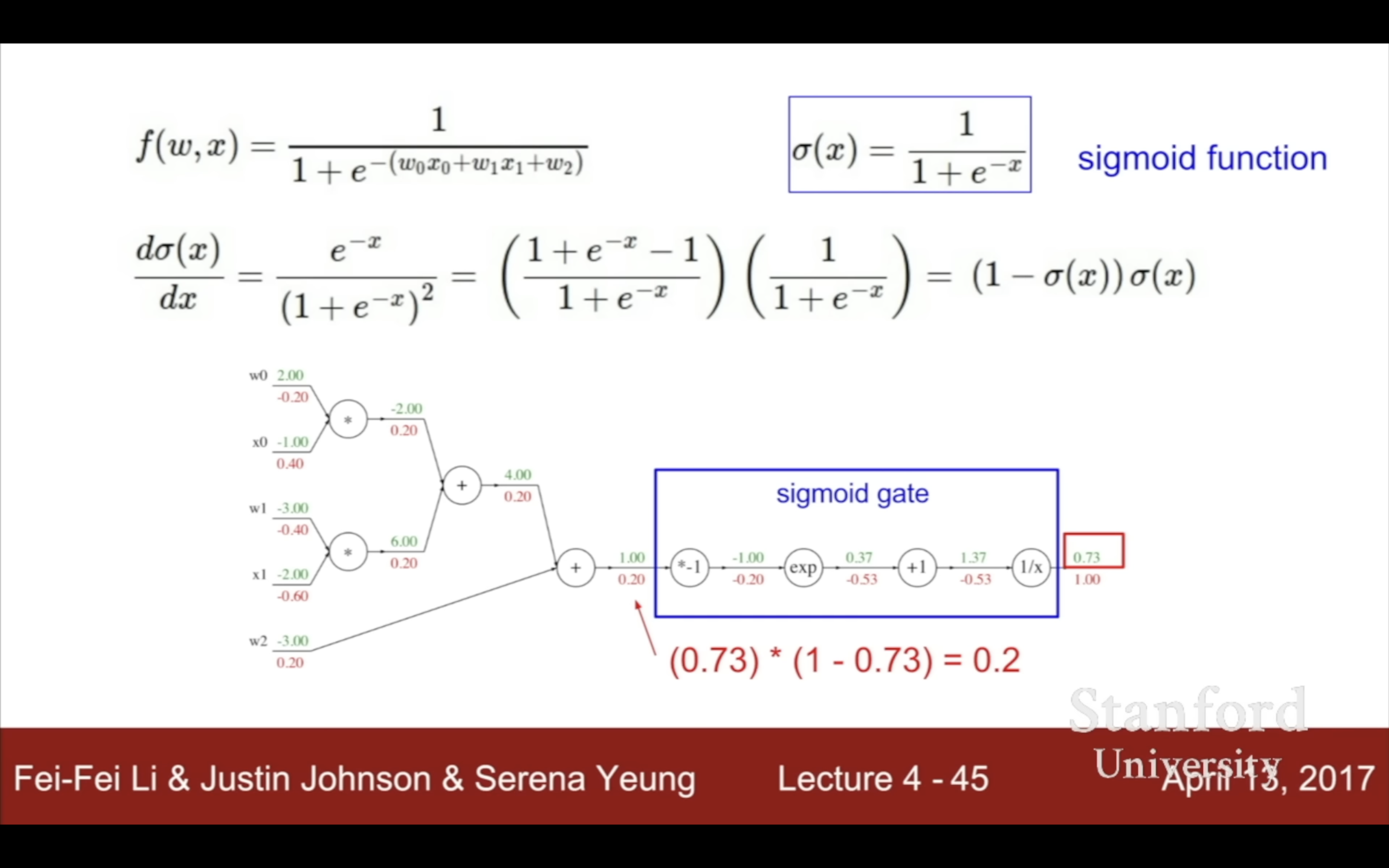

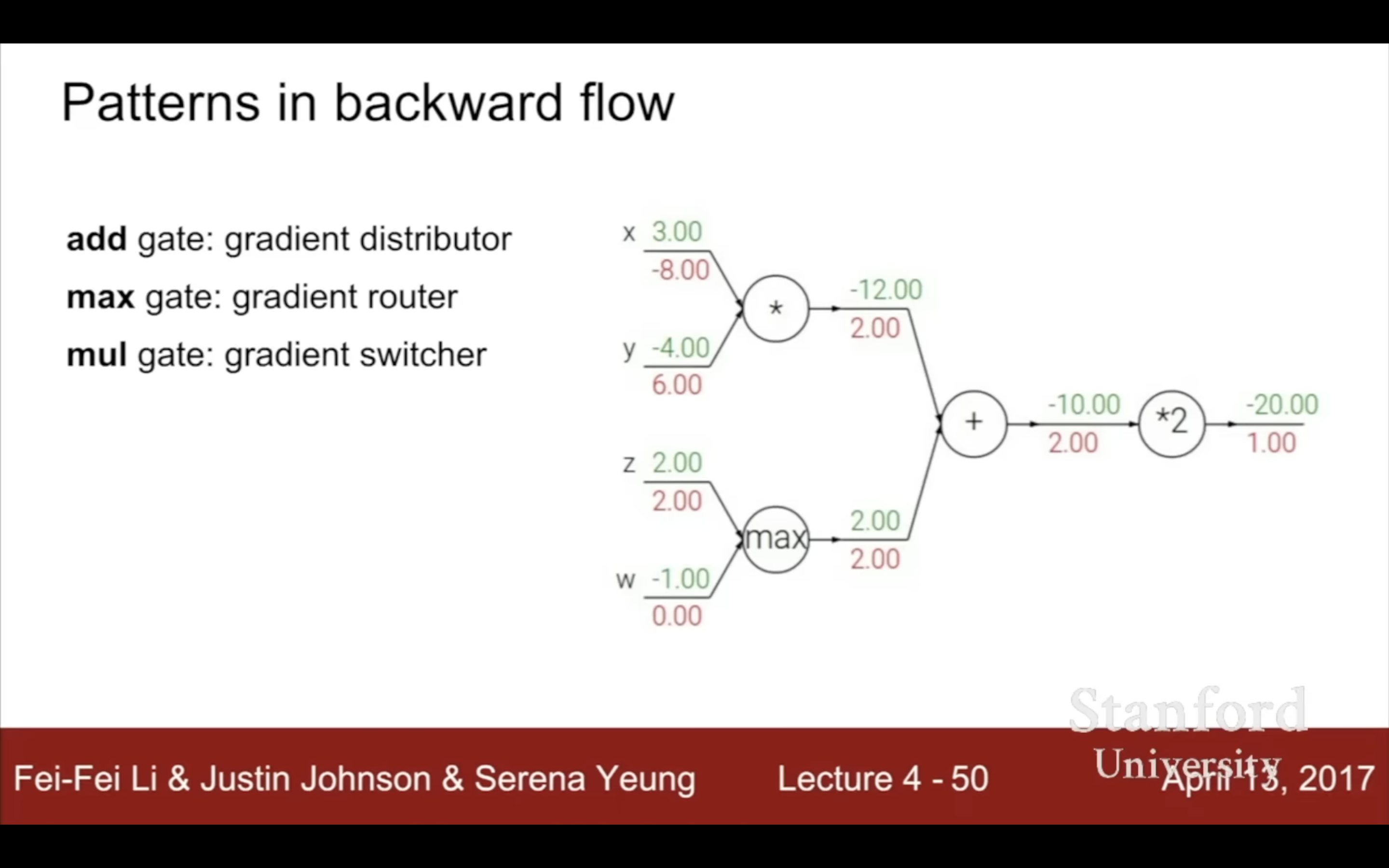

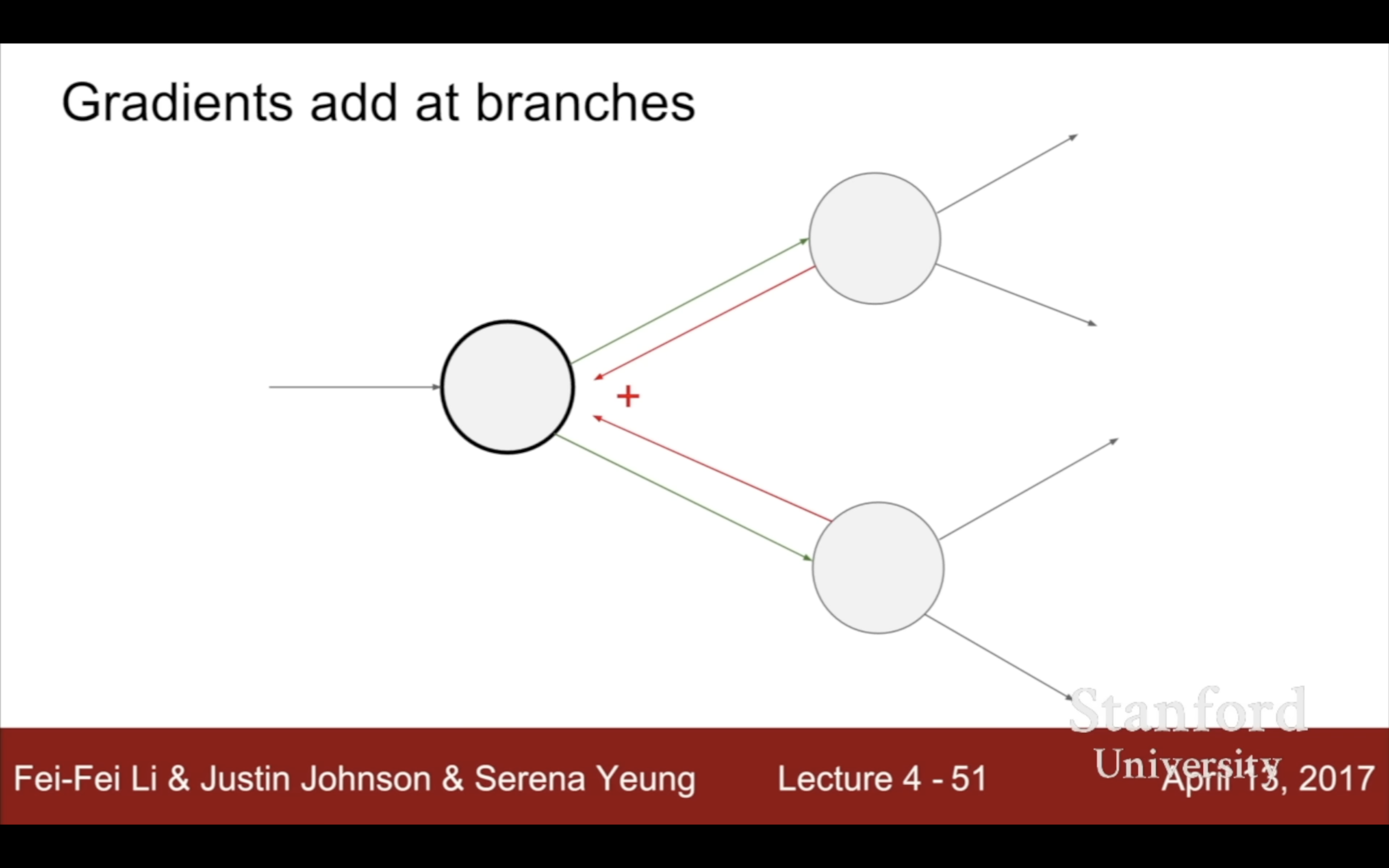

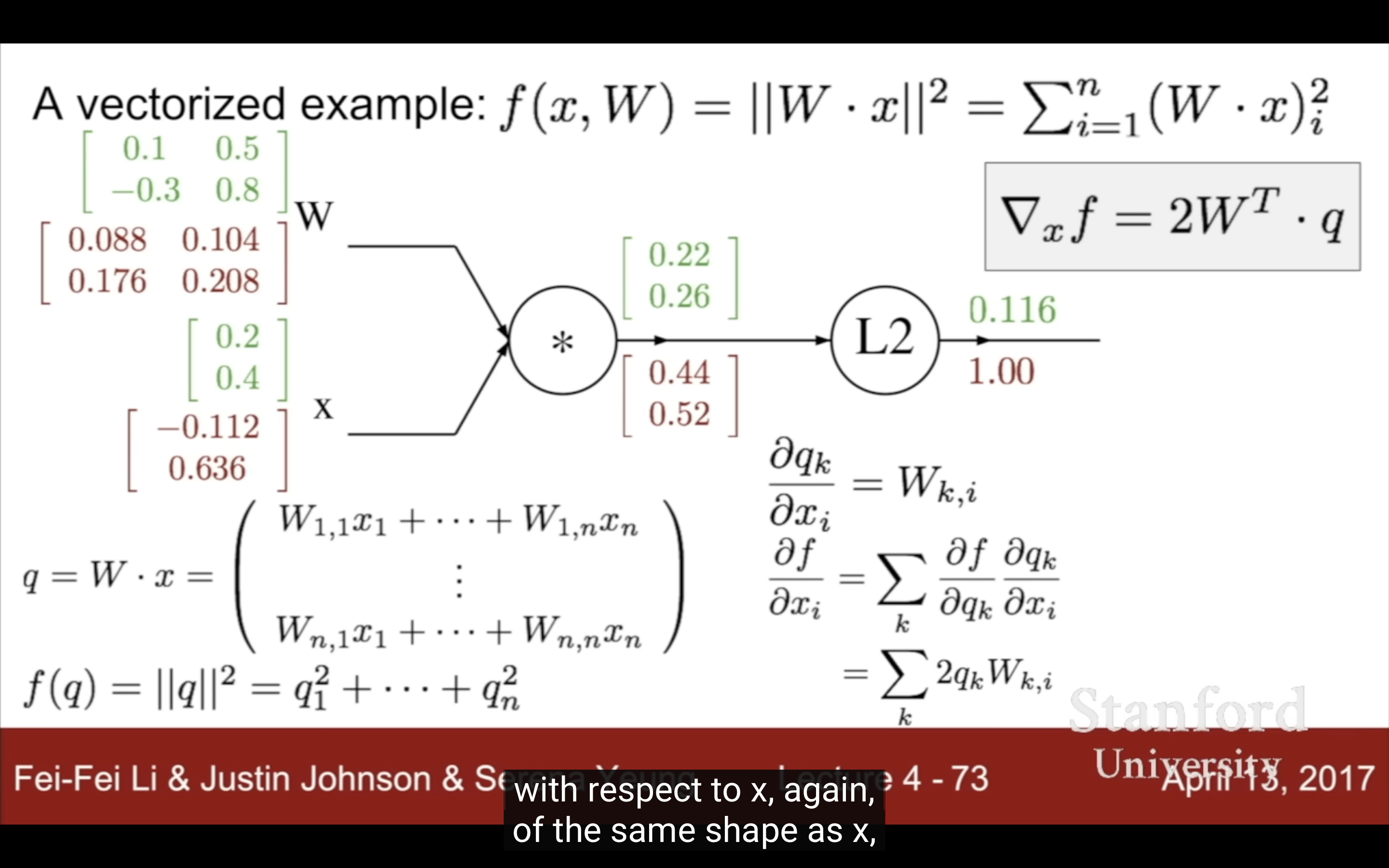

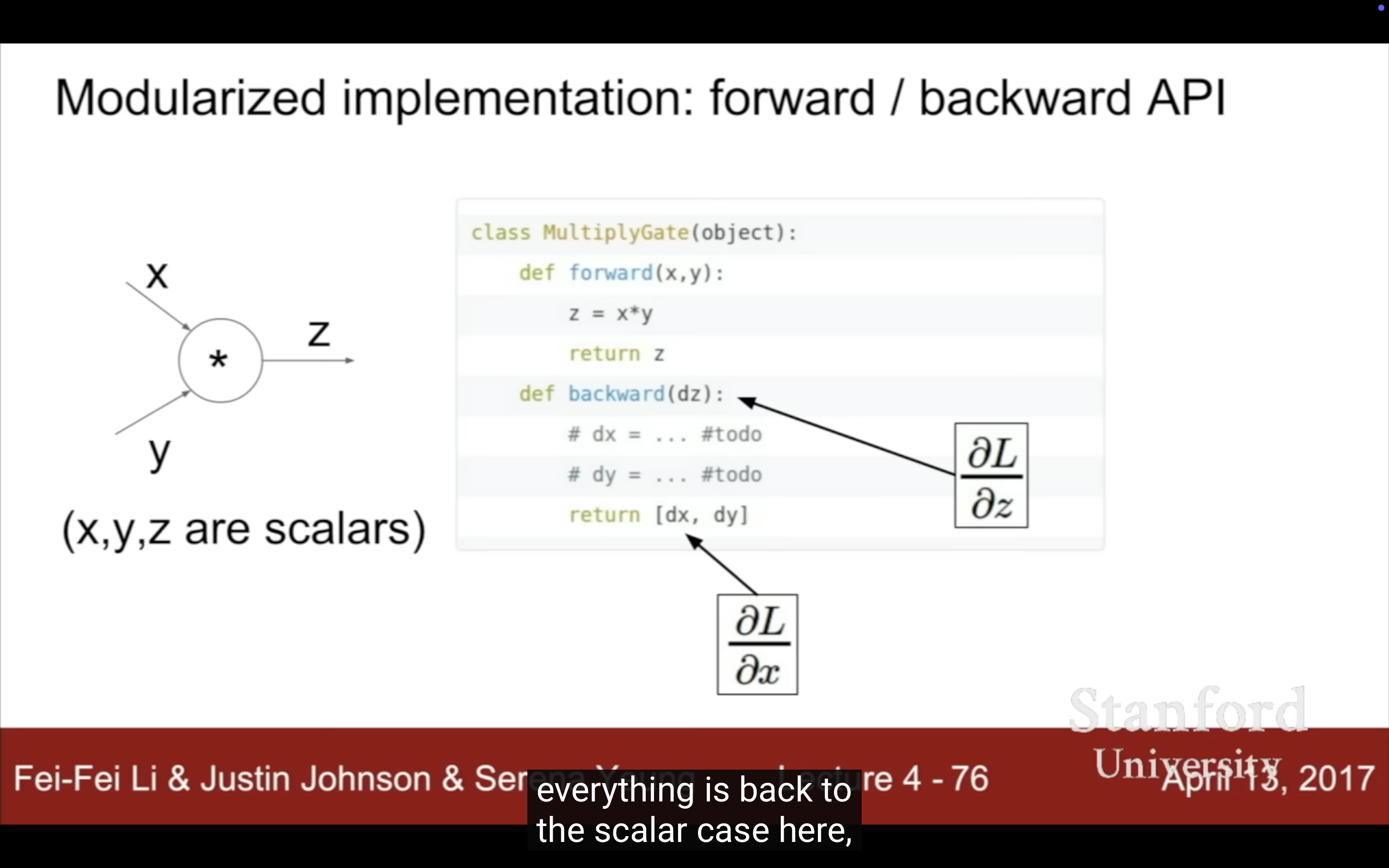

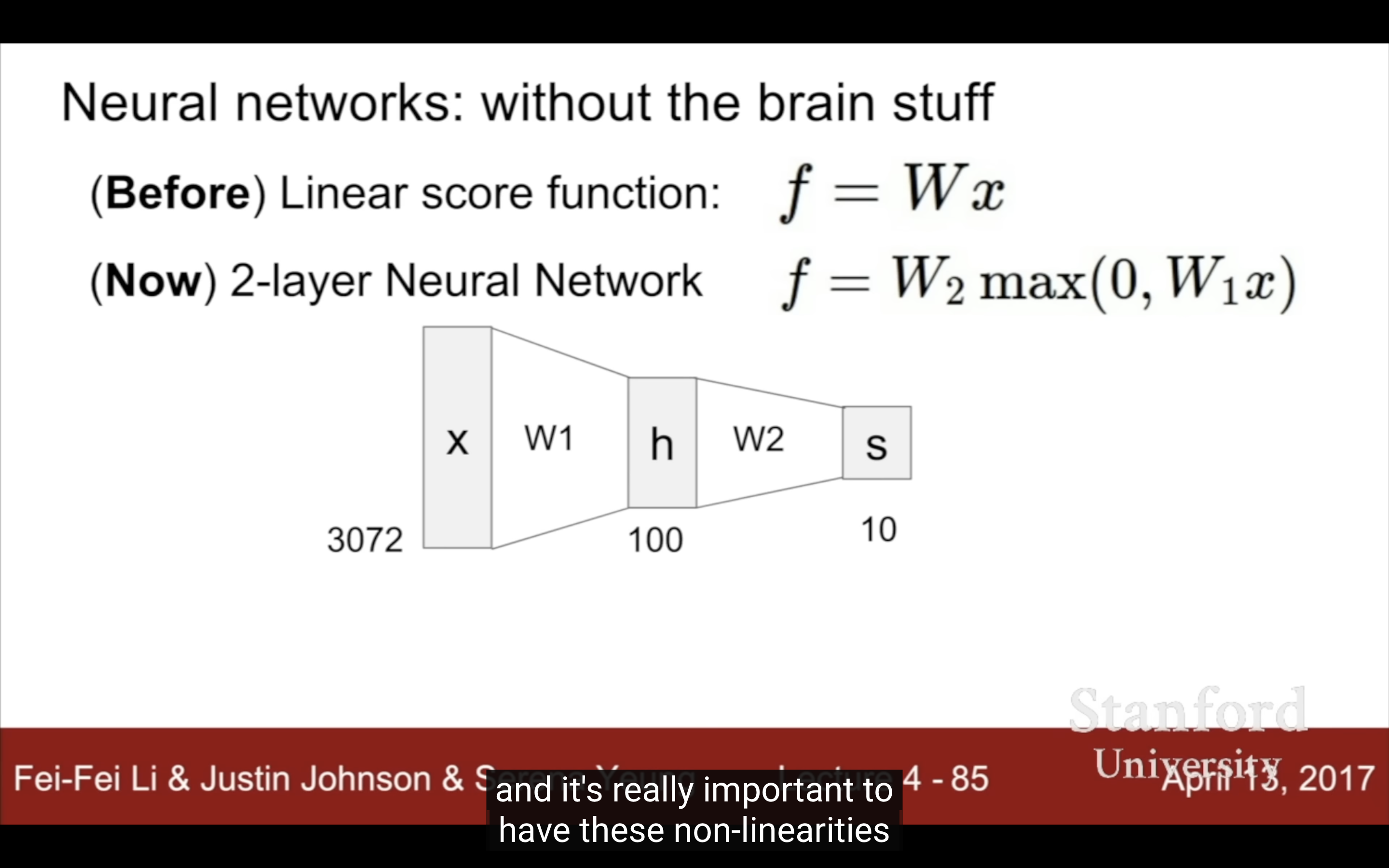

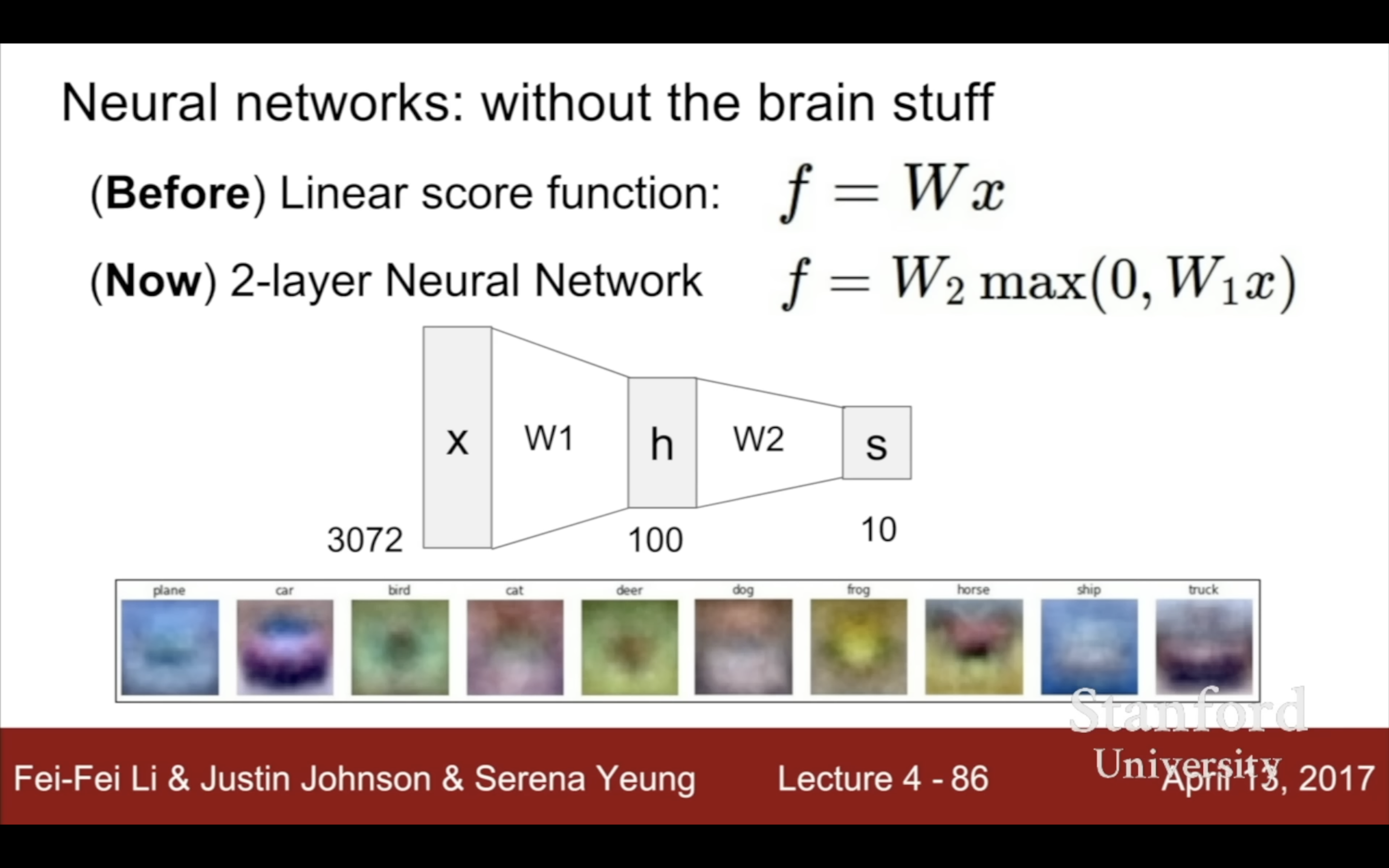

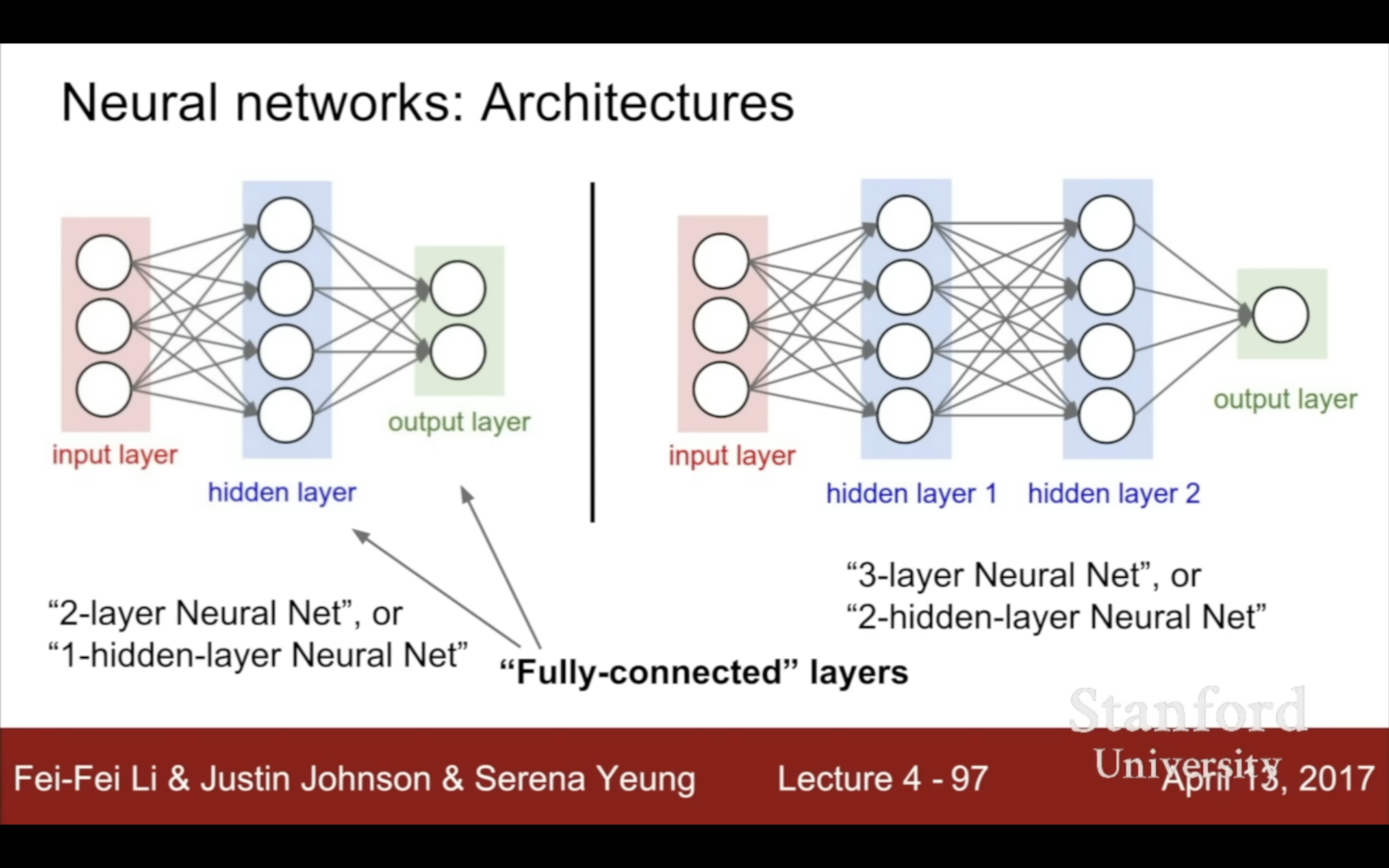

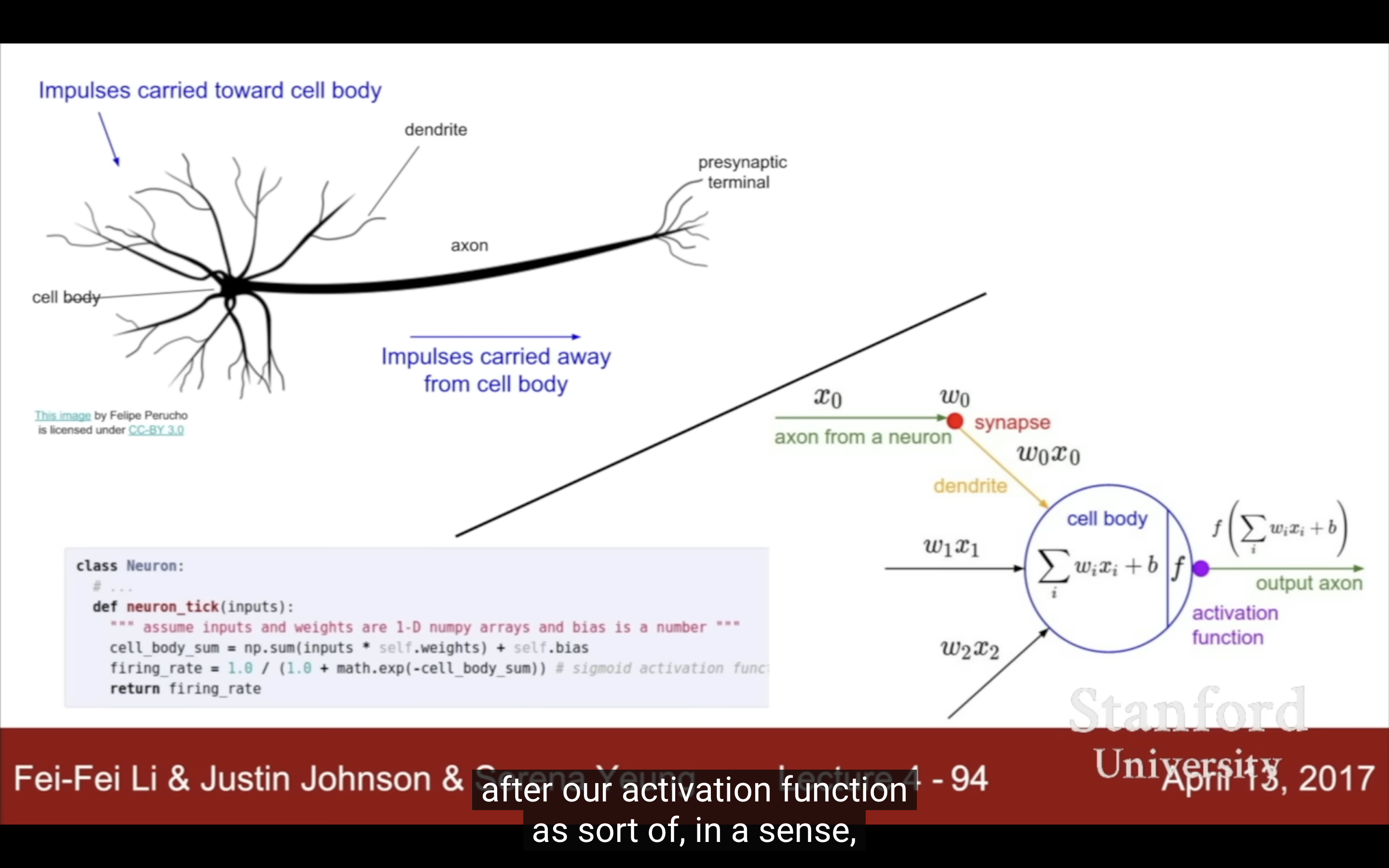

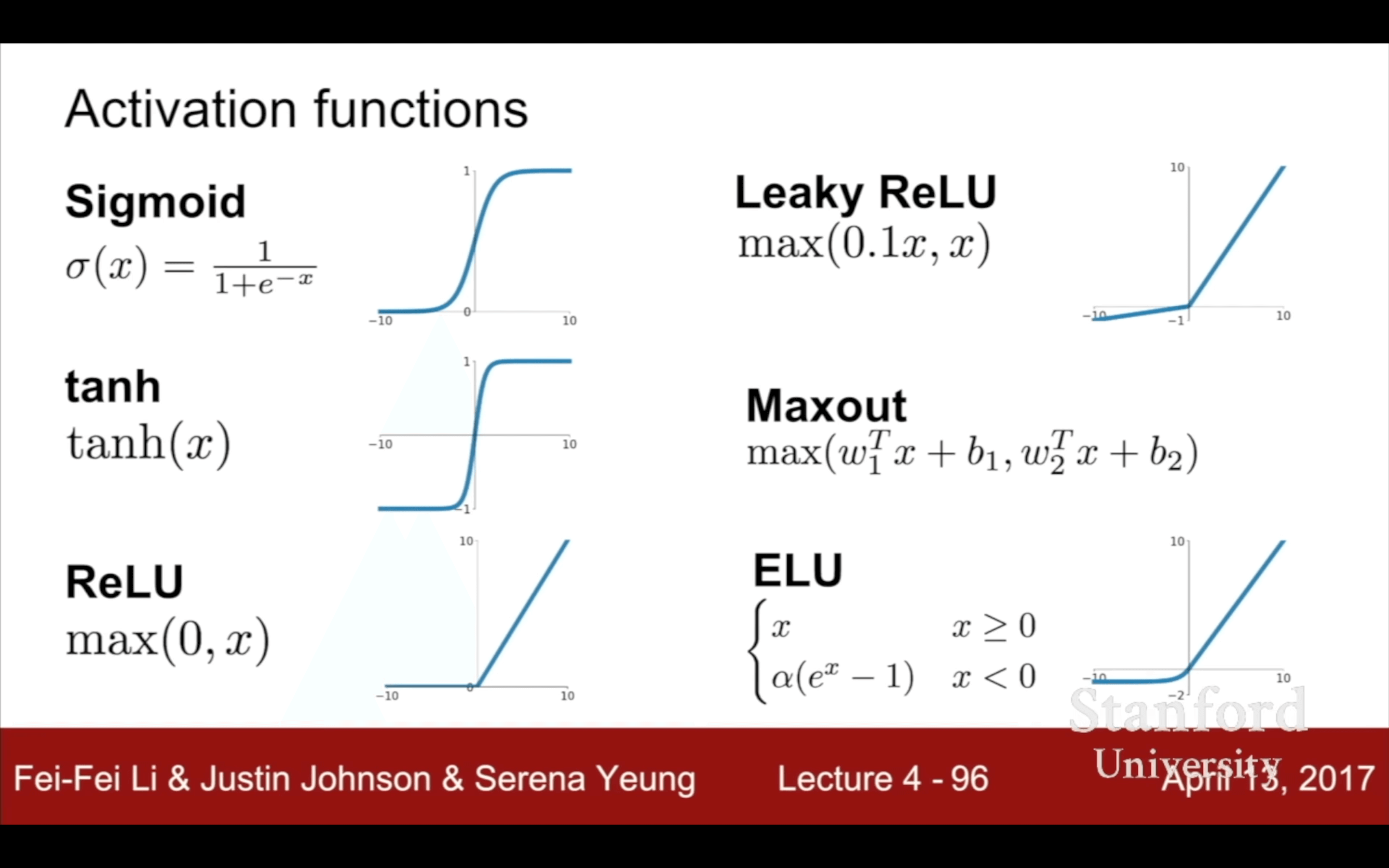

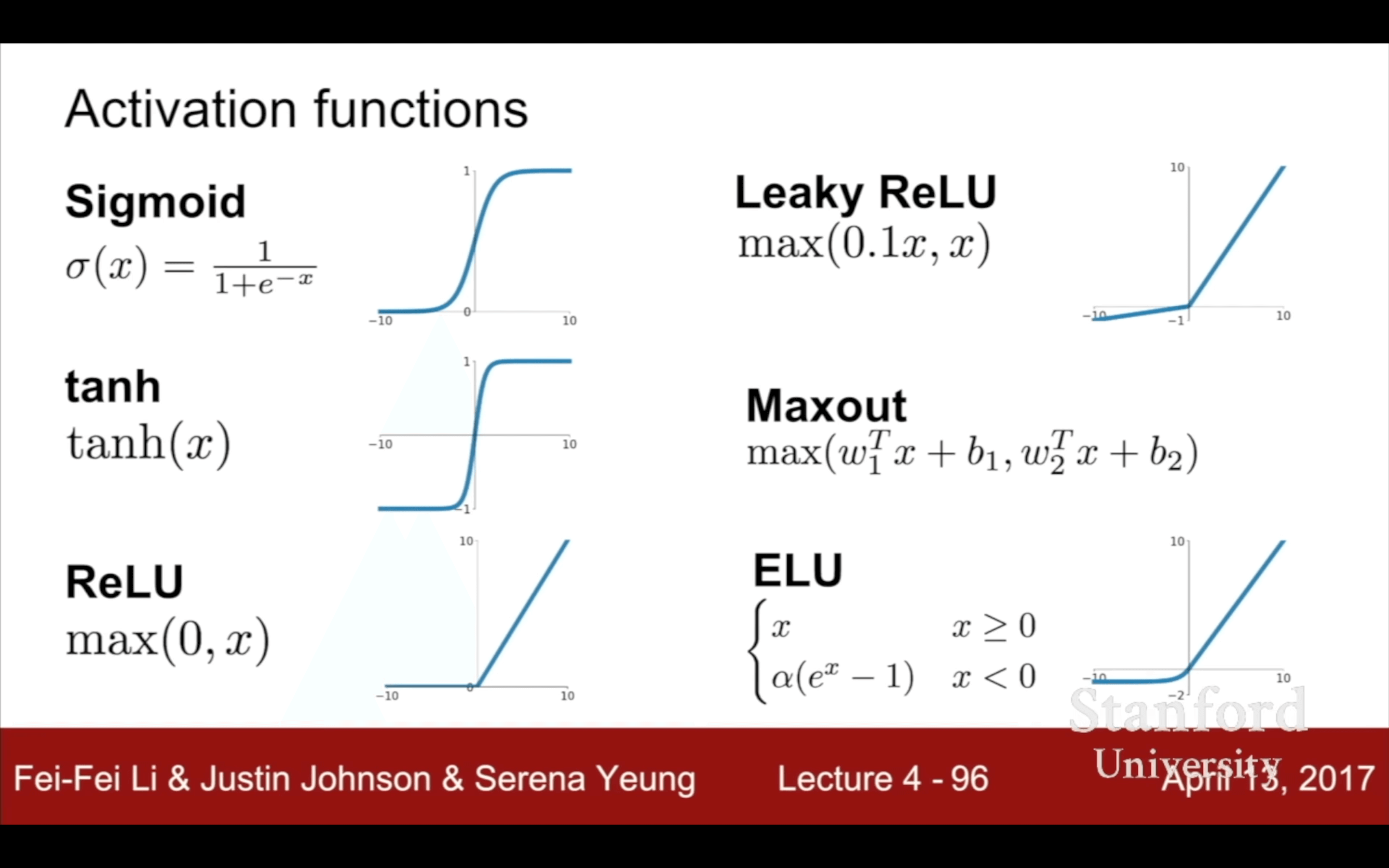

- Lecture 4 計算圖(local gradient and chain rule)

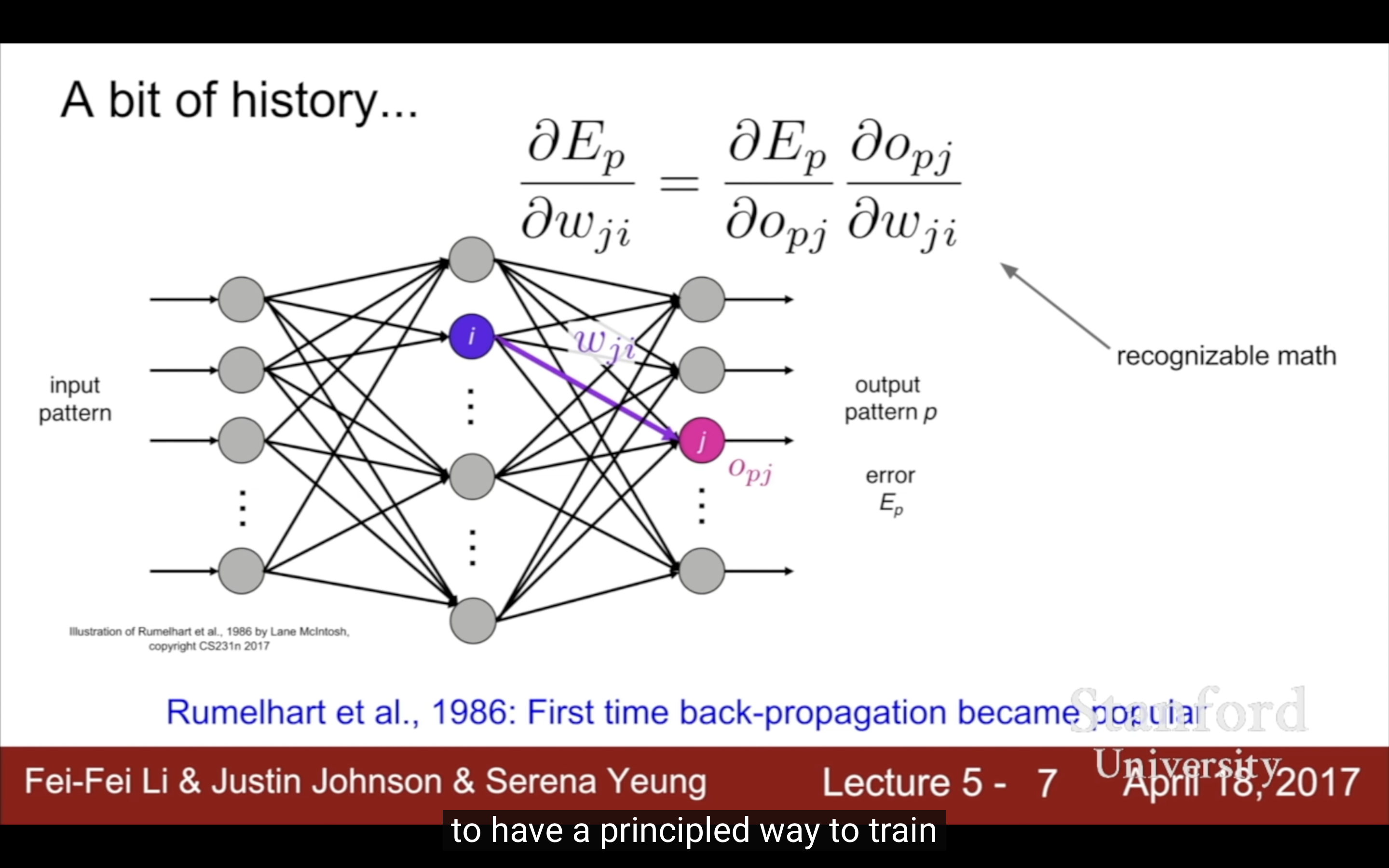

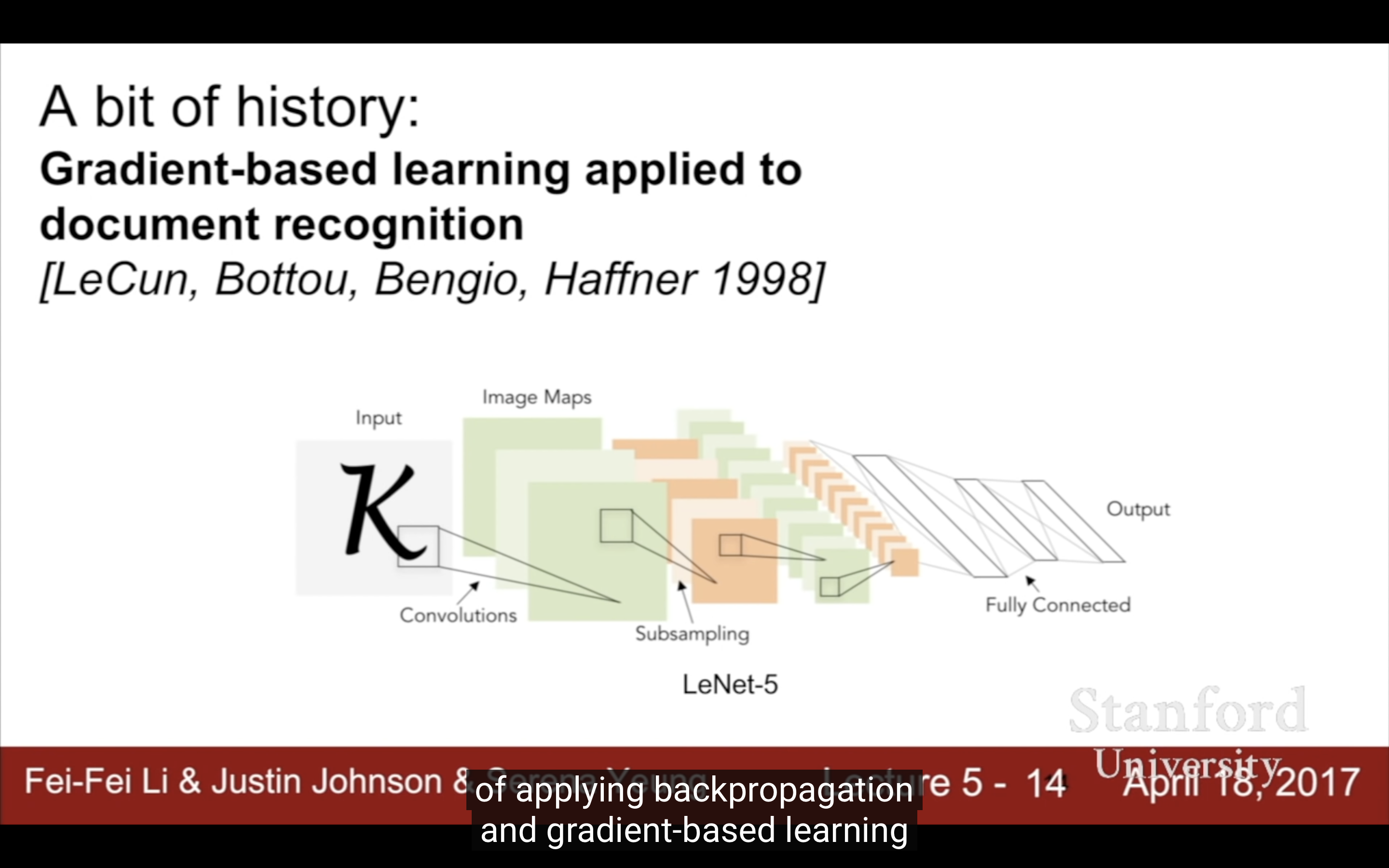

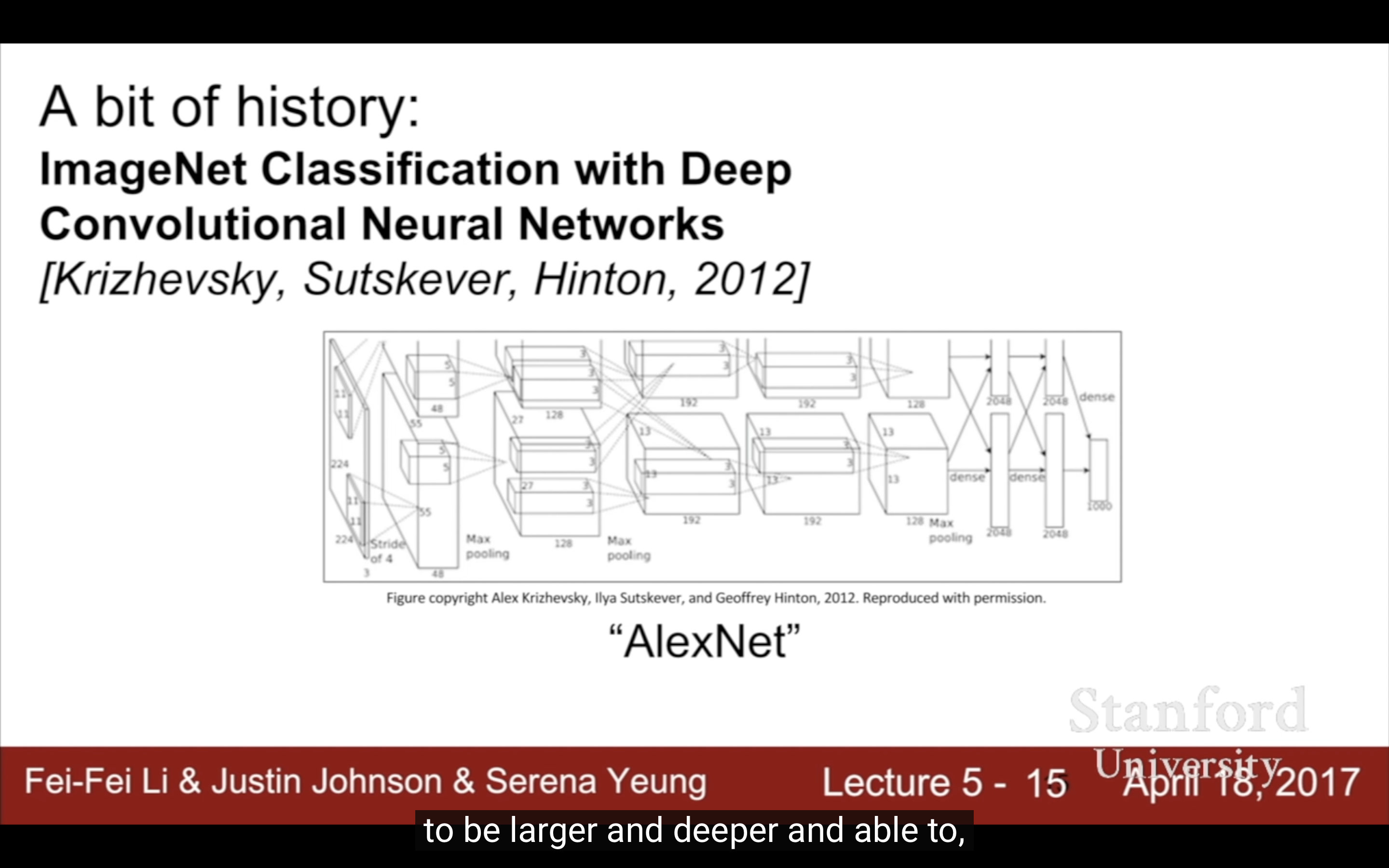

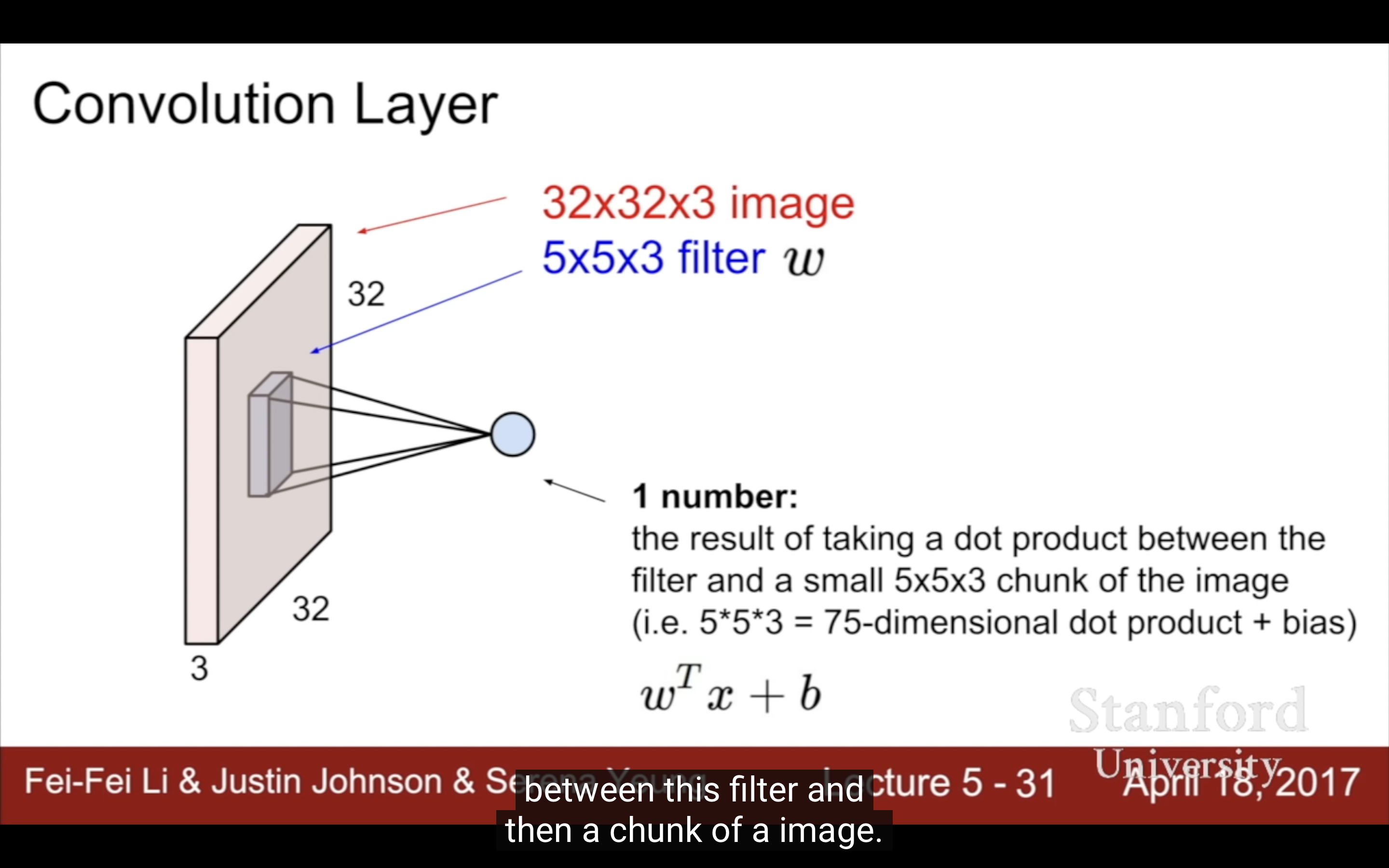

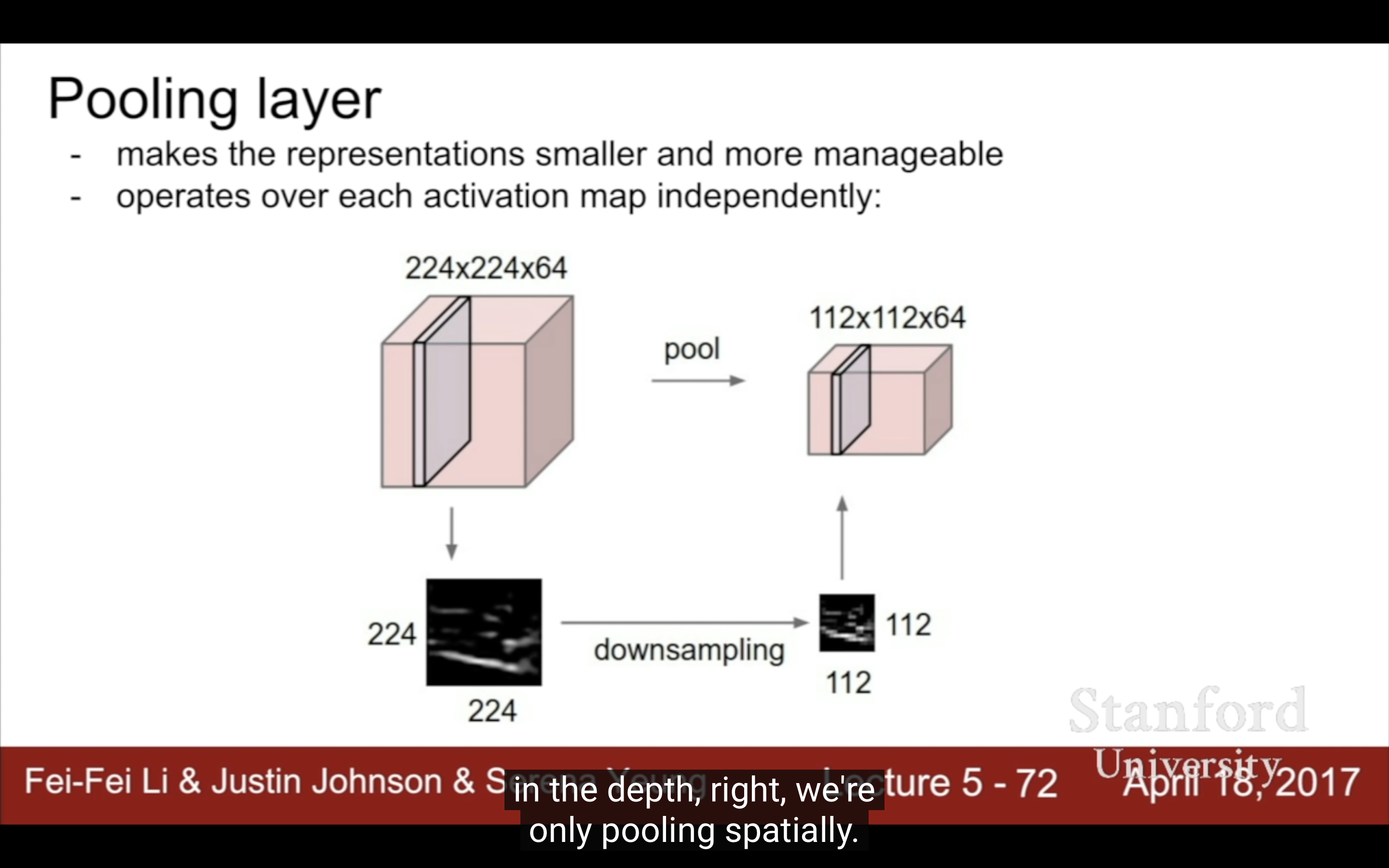

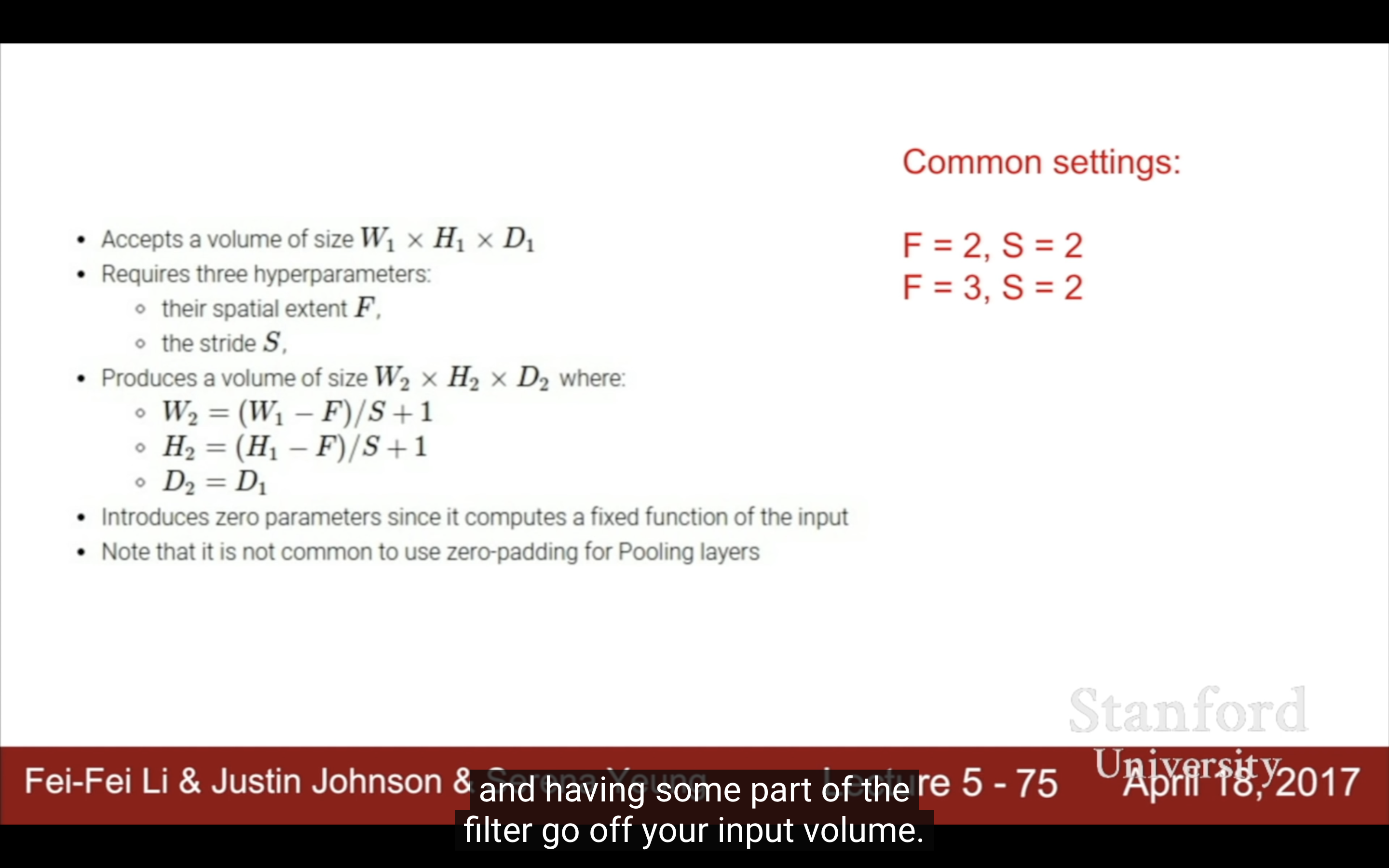

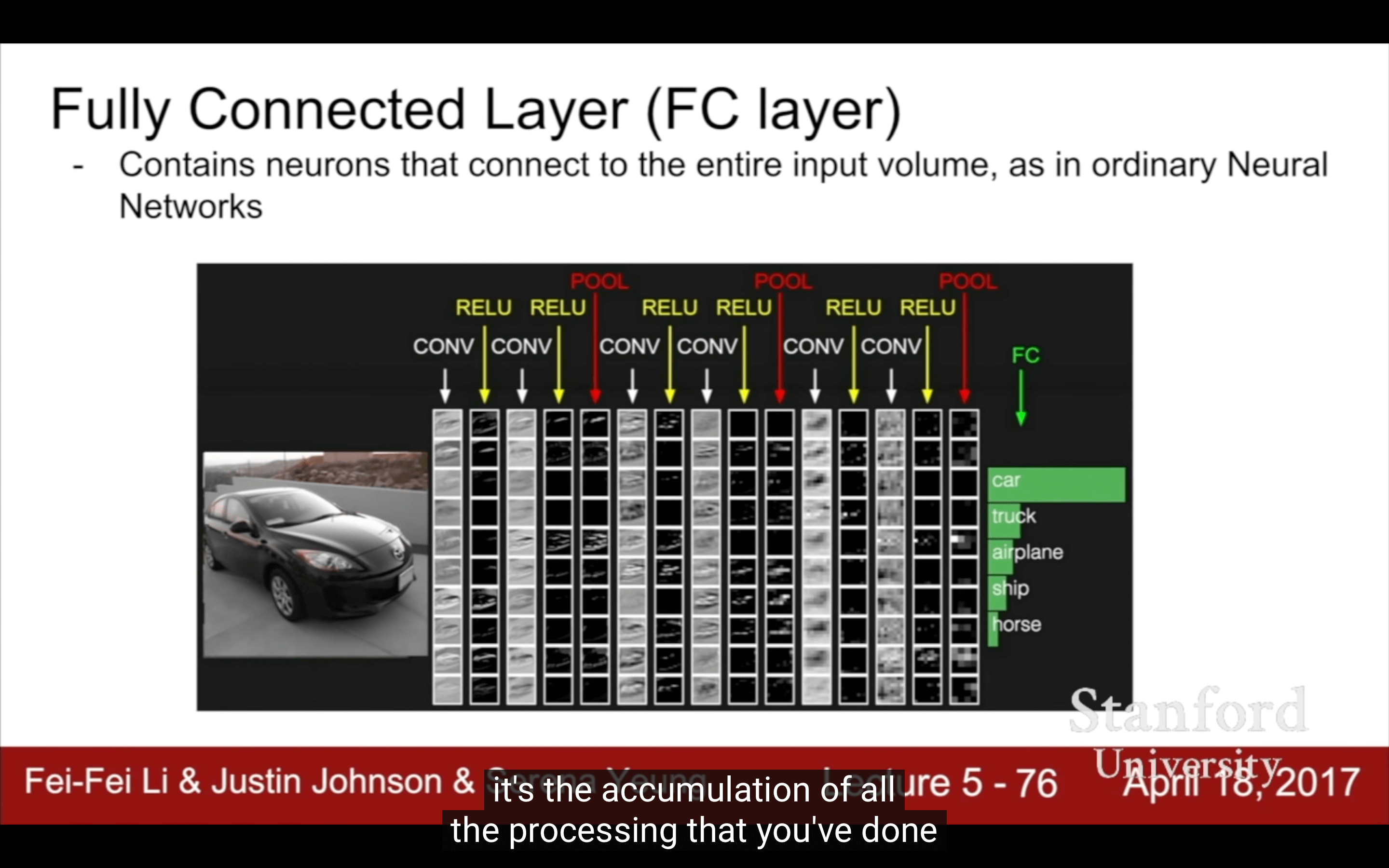

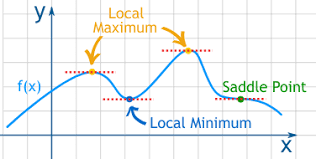

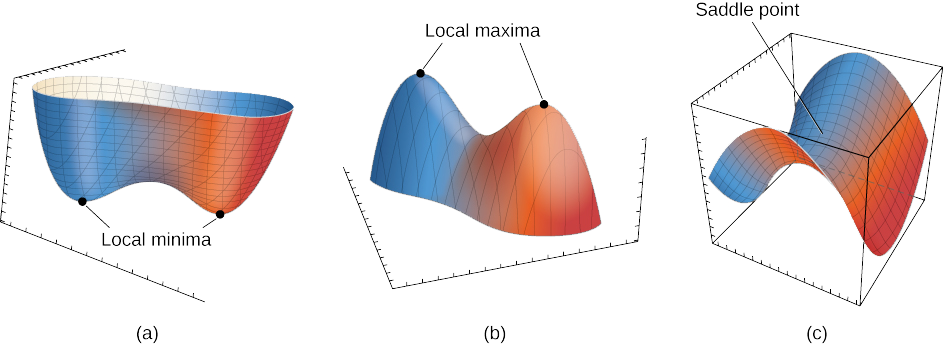

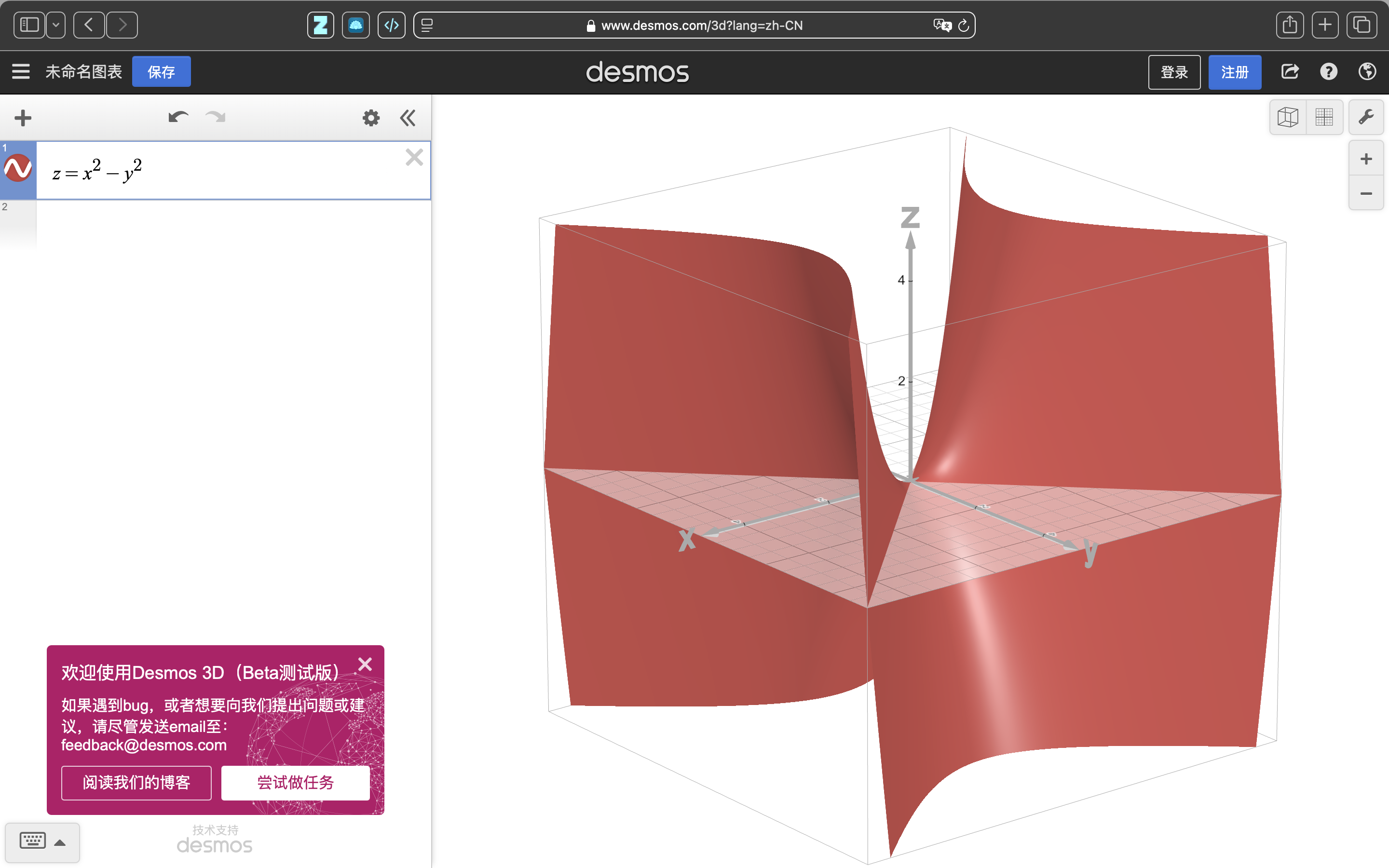

- Lecture 5

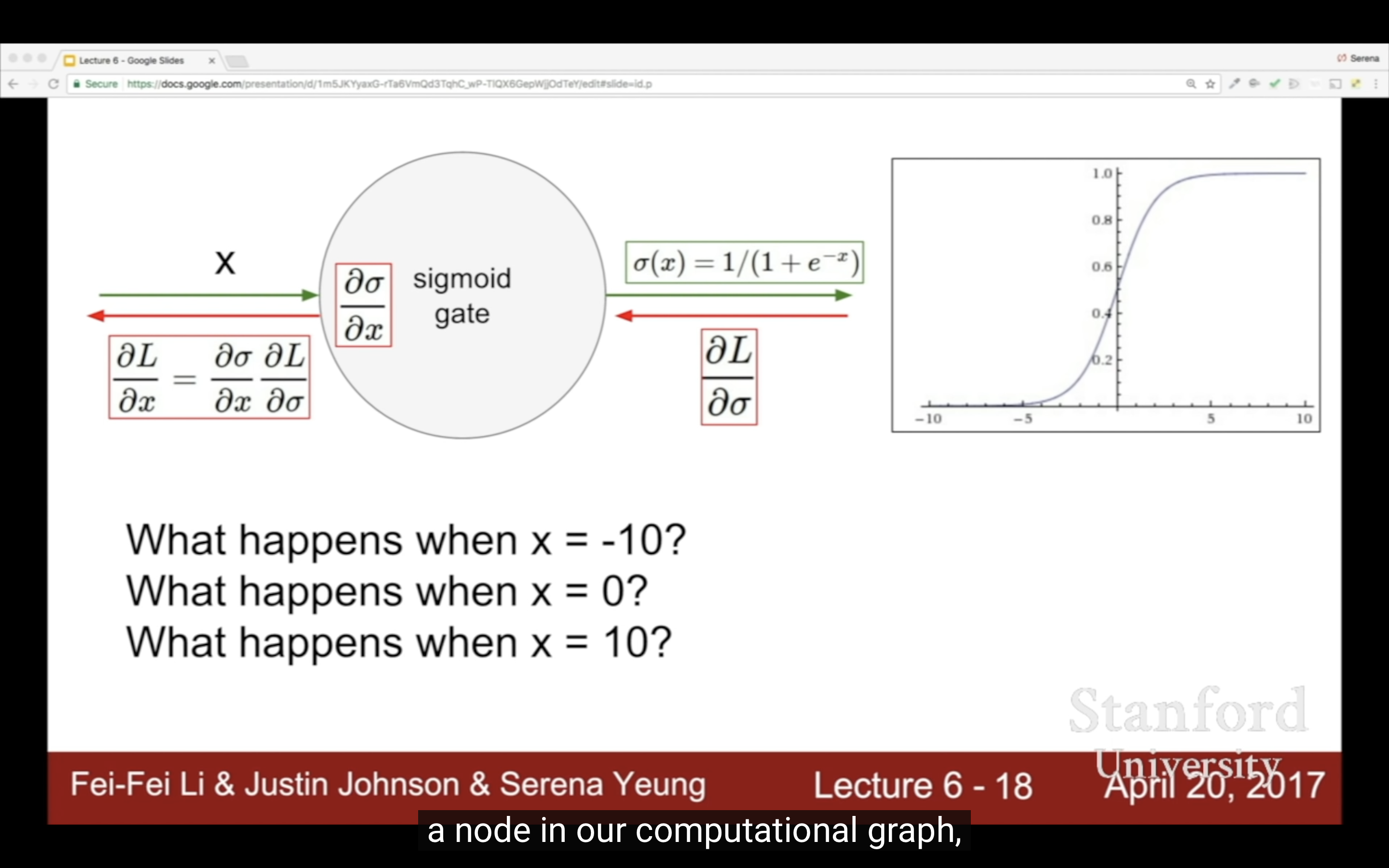

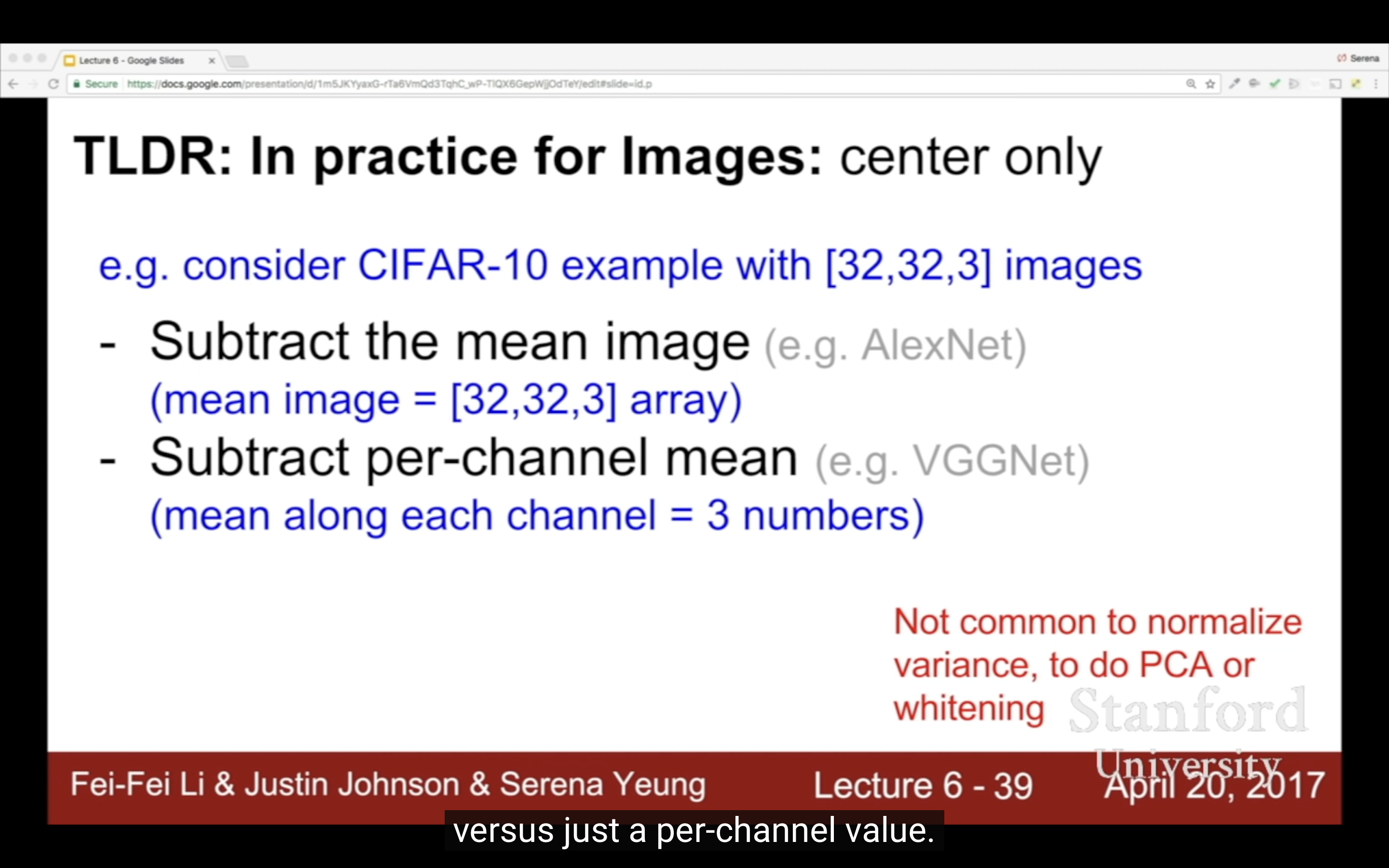

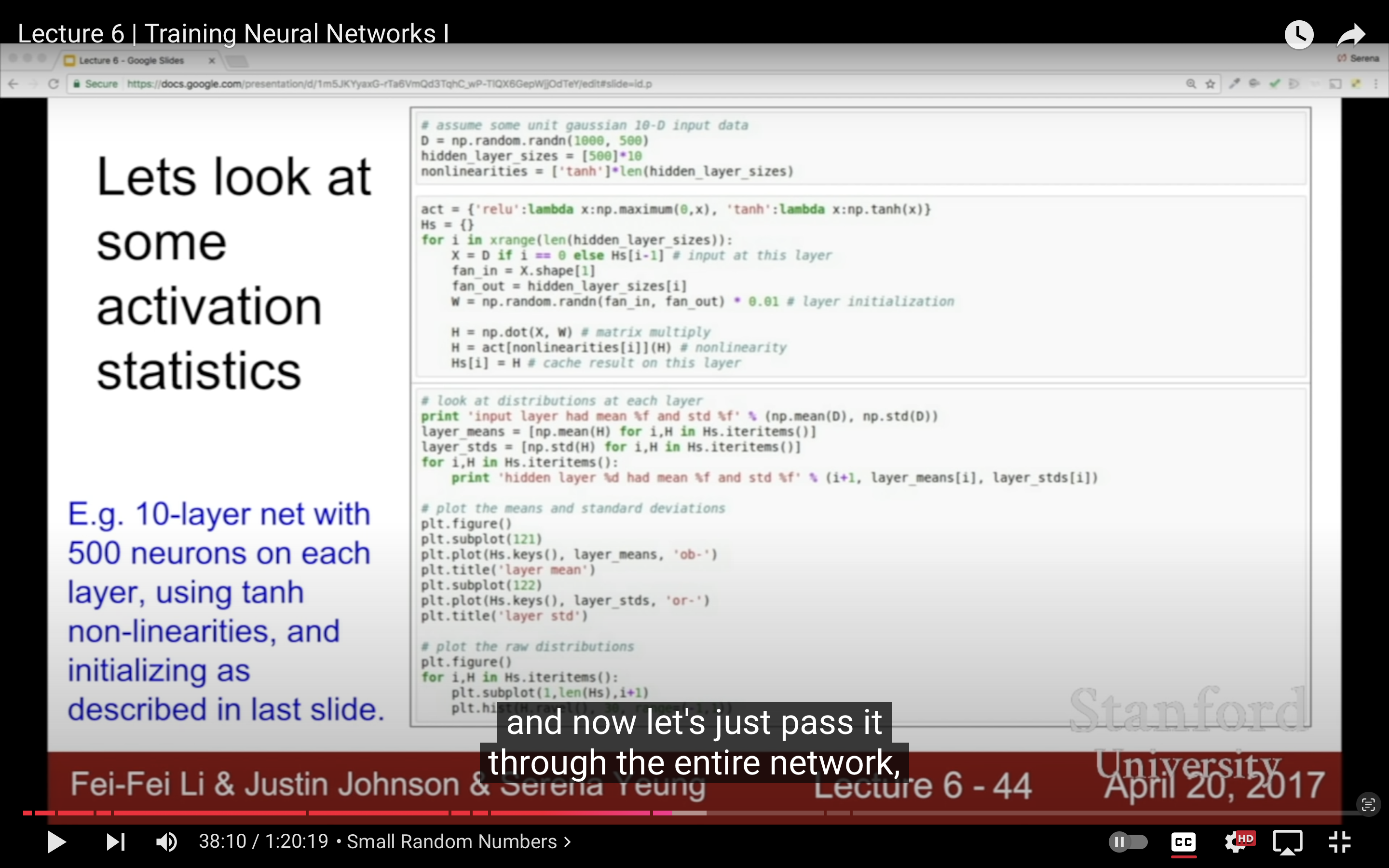

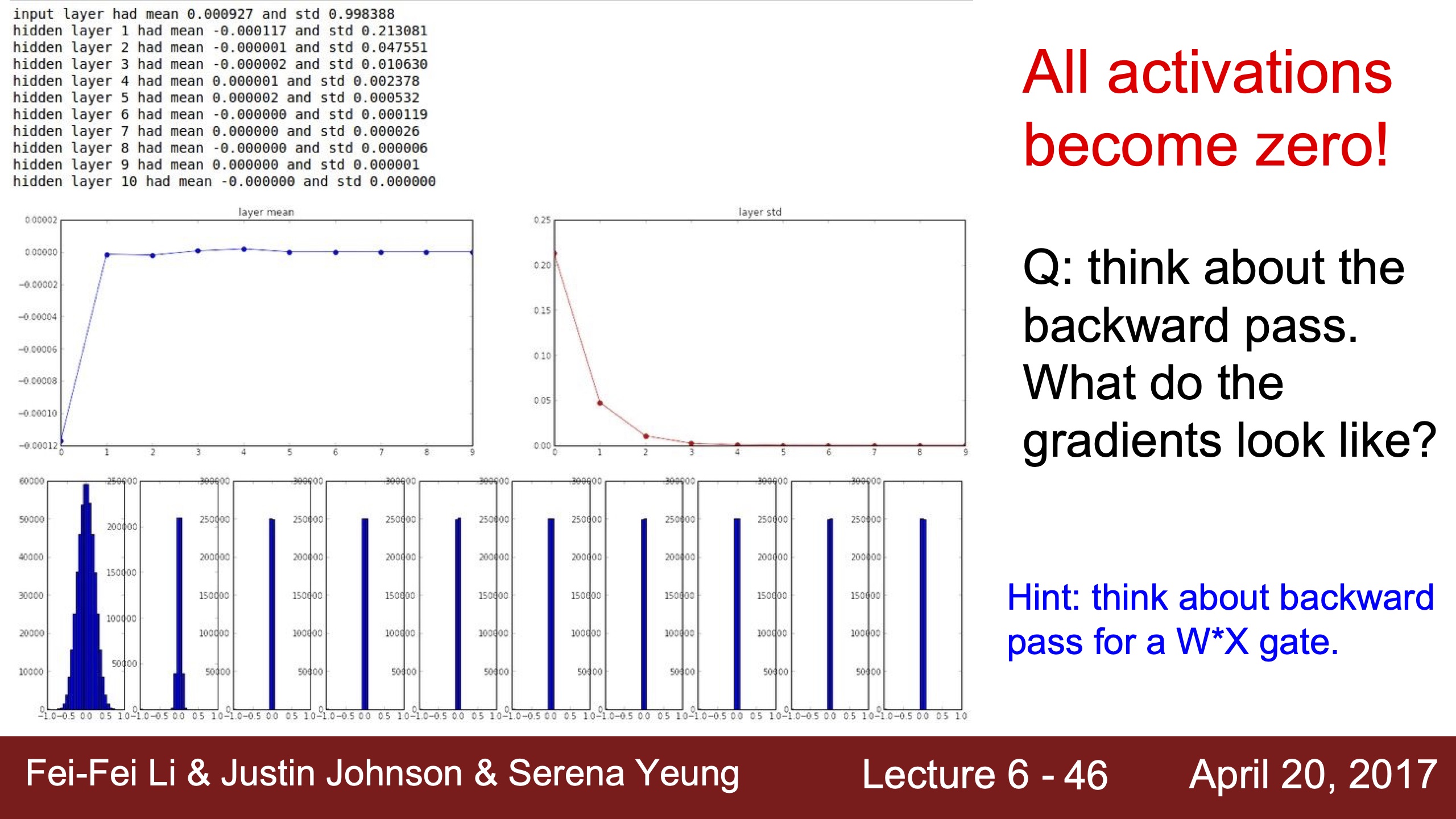

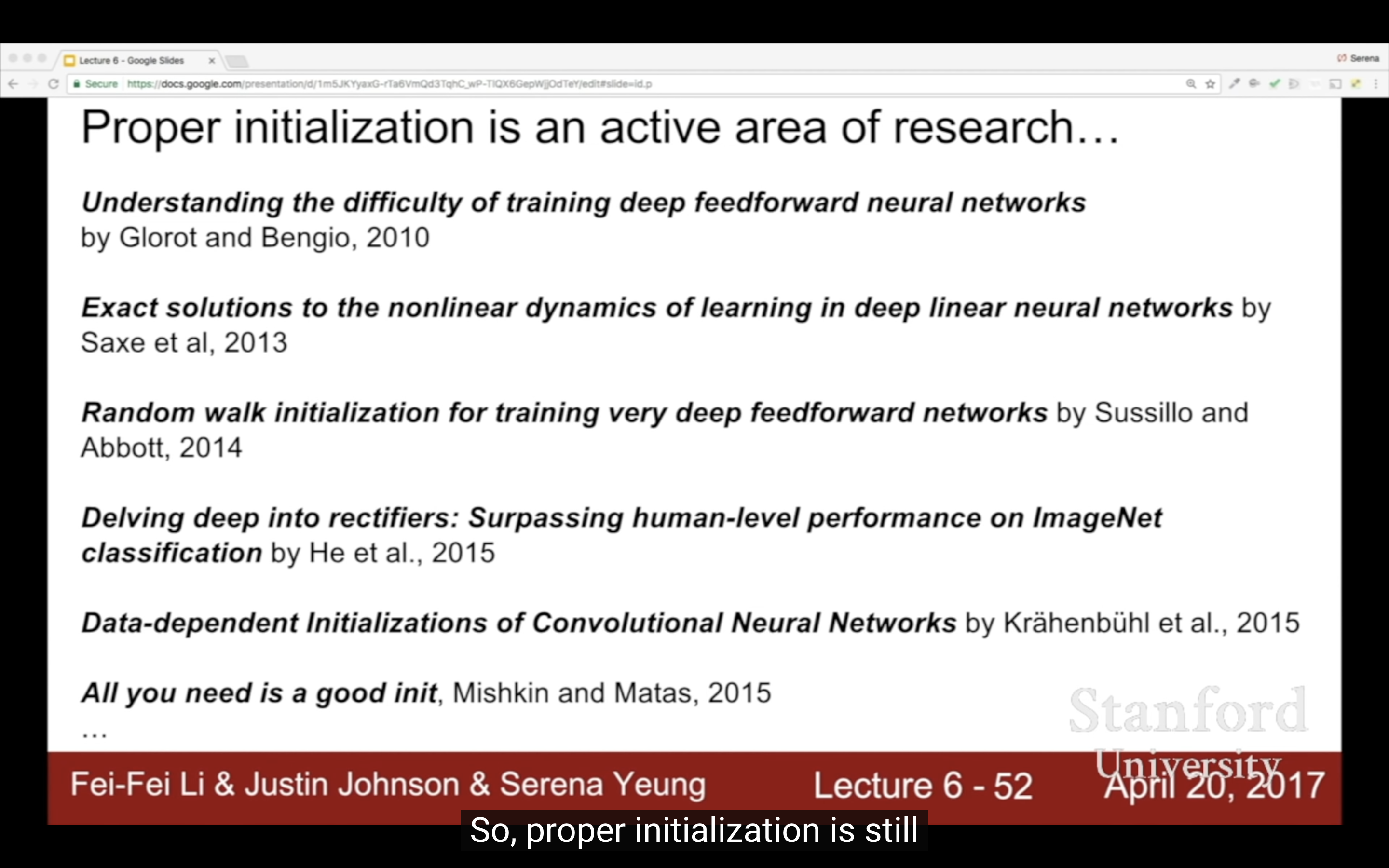

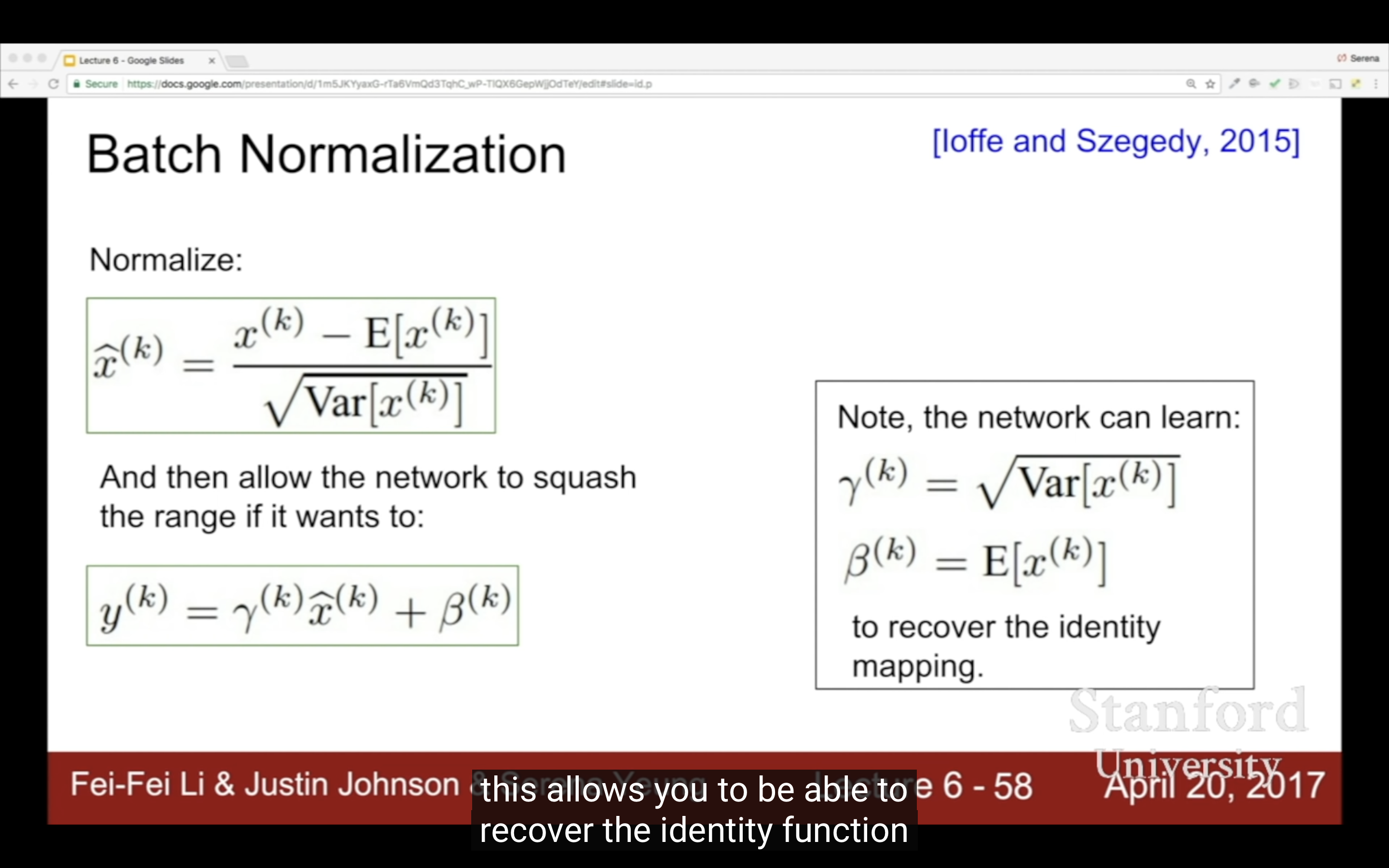

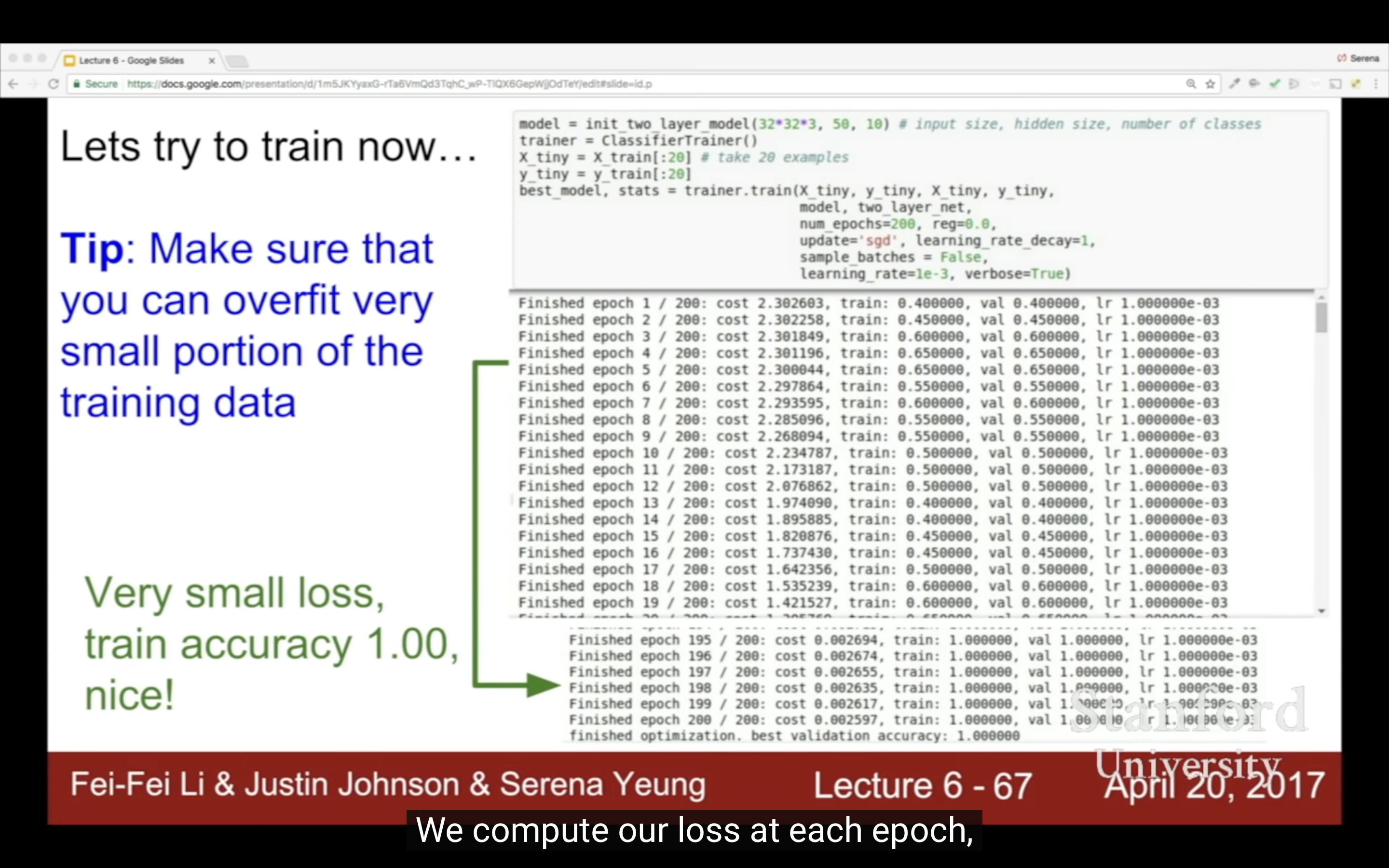

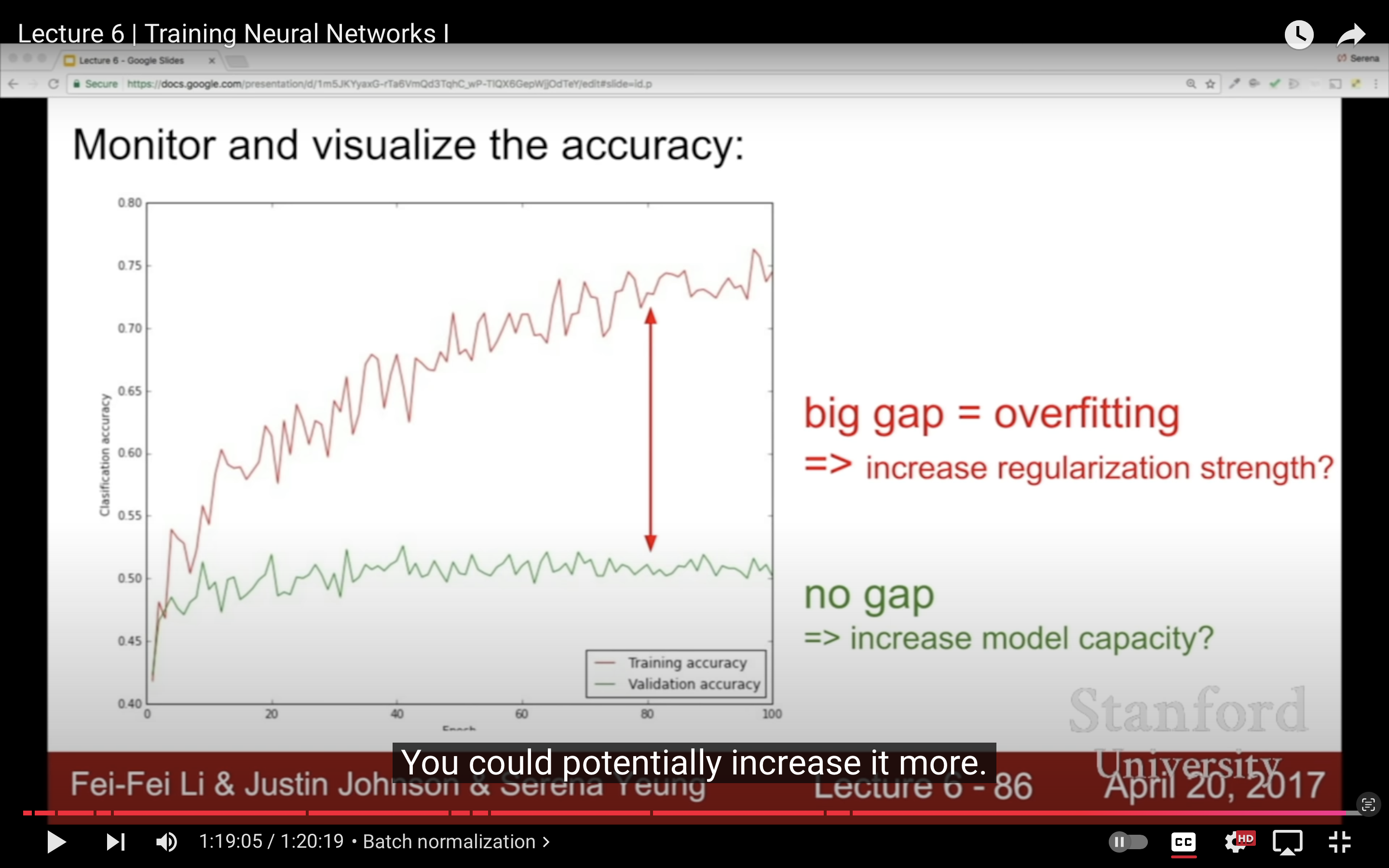

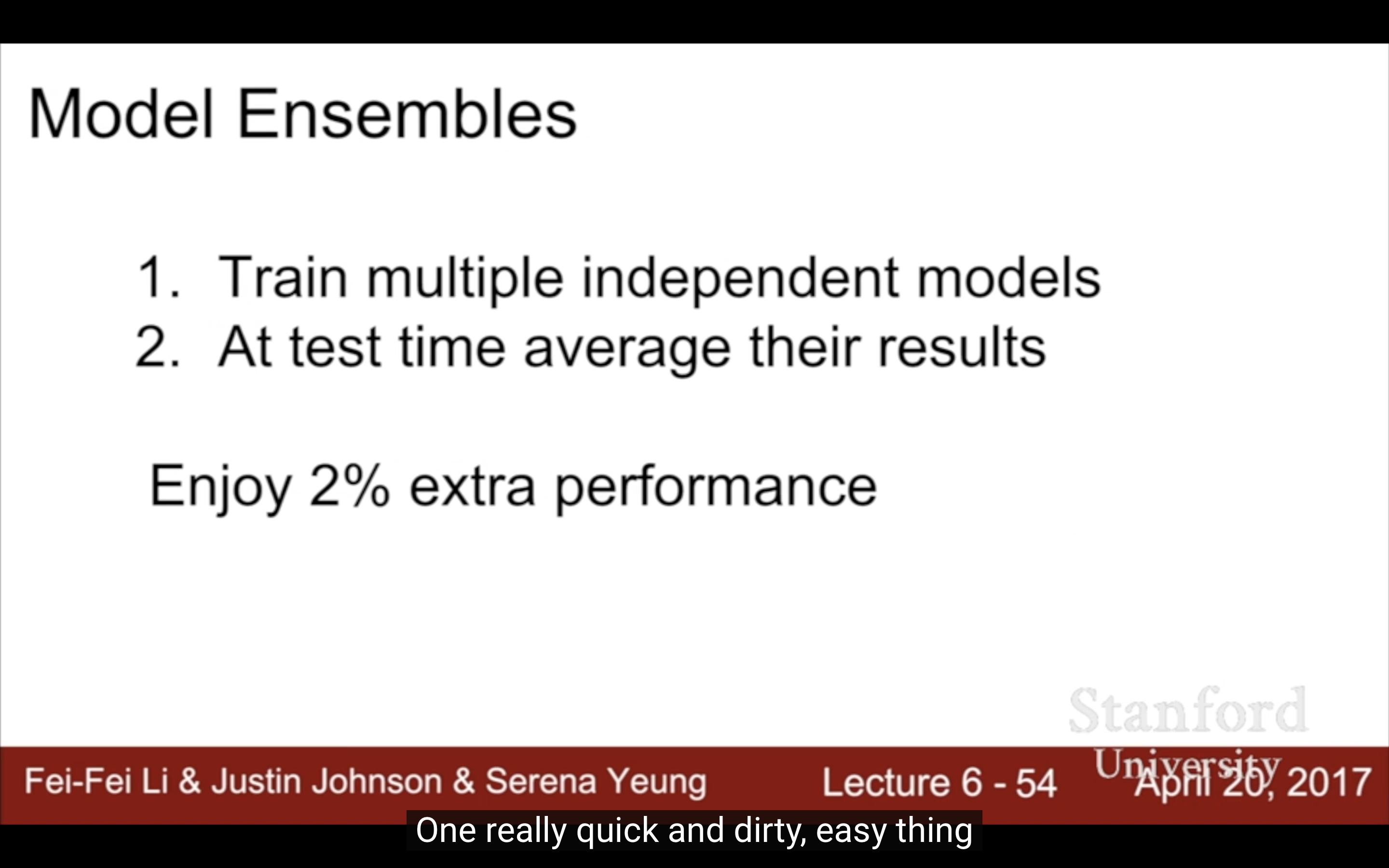

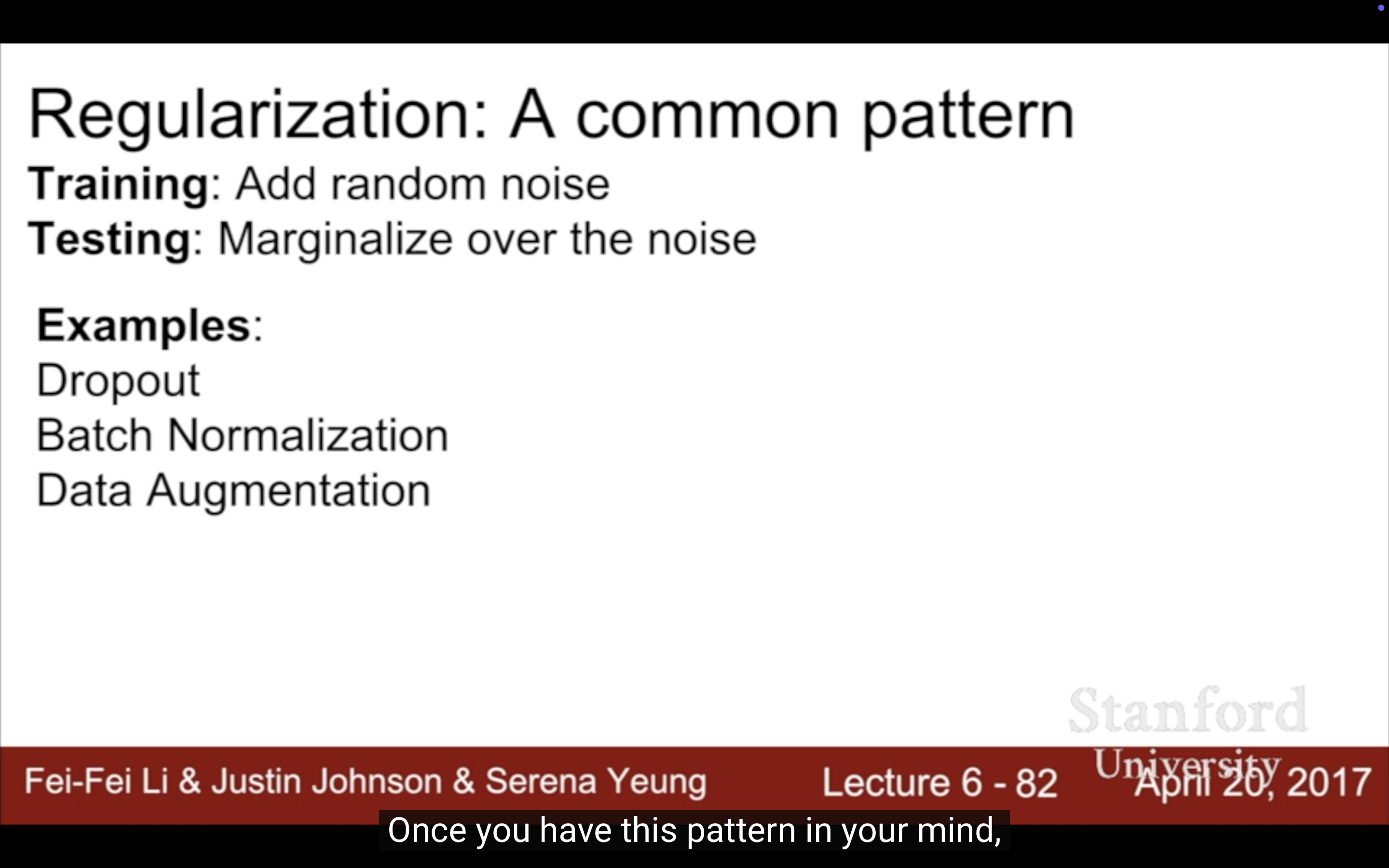

- Lecture 6

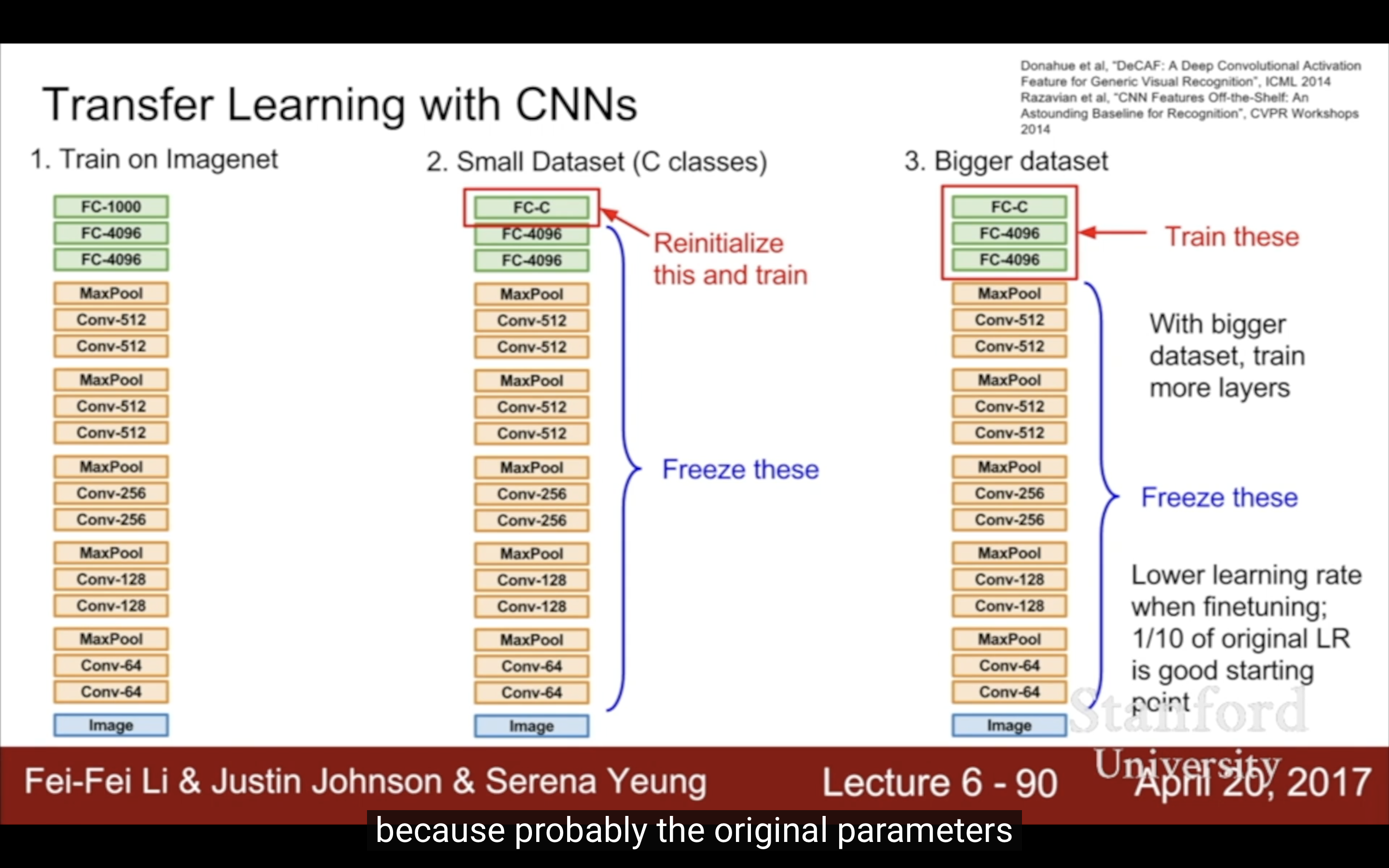

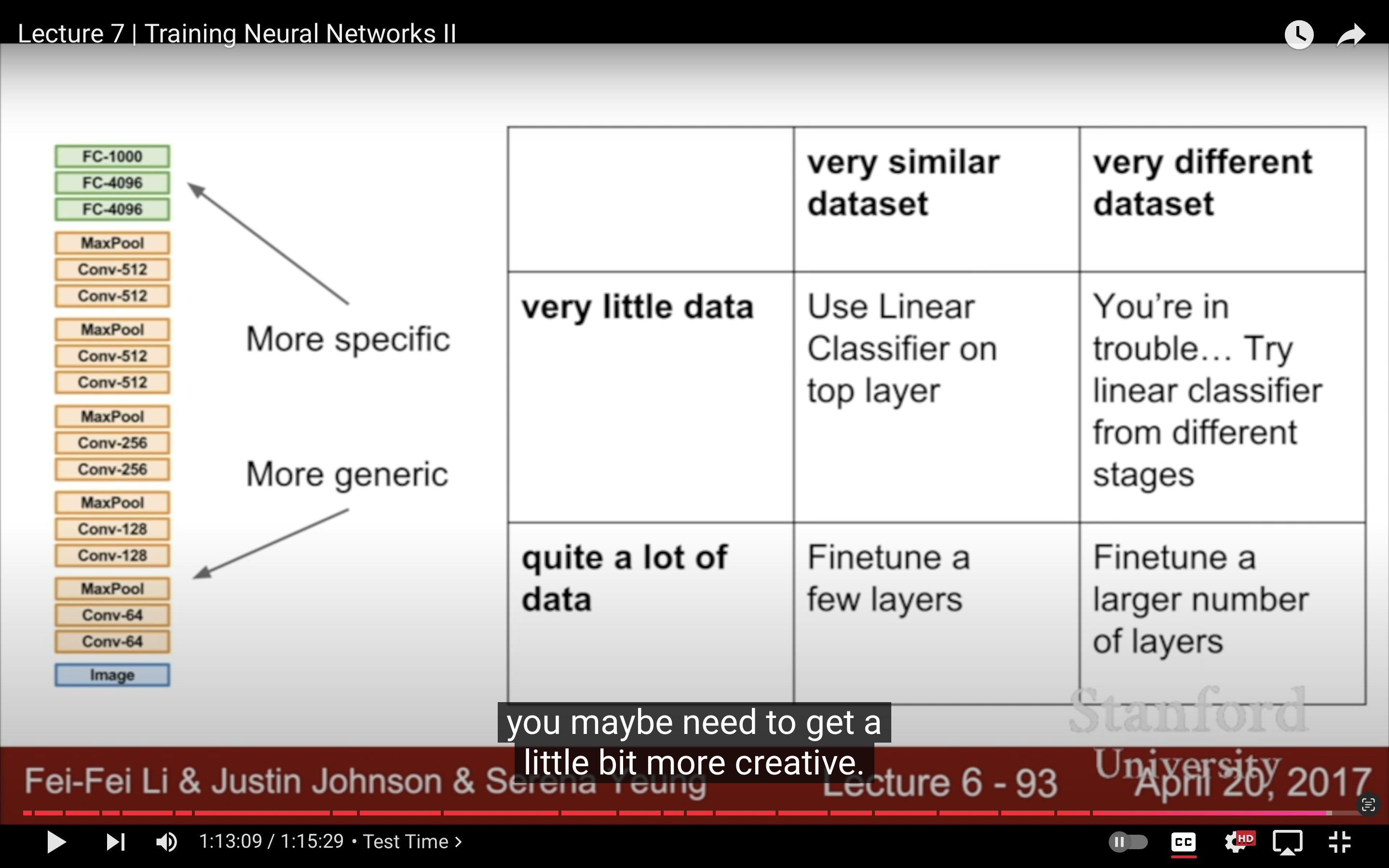

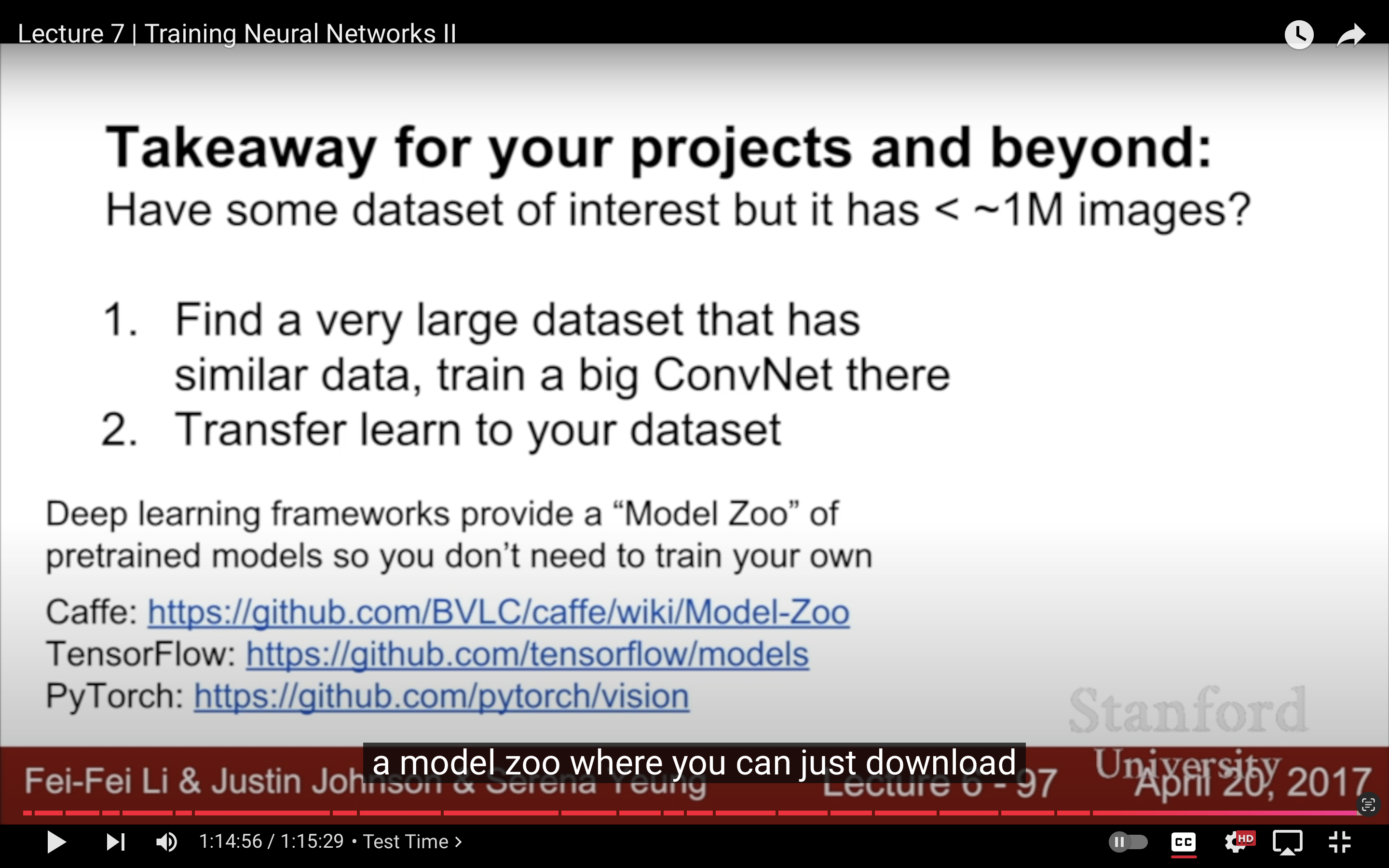

- Lecture 7

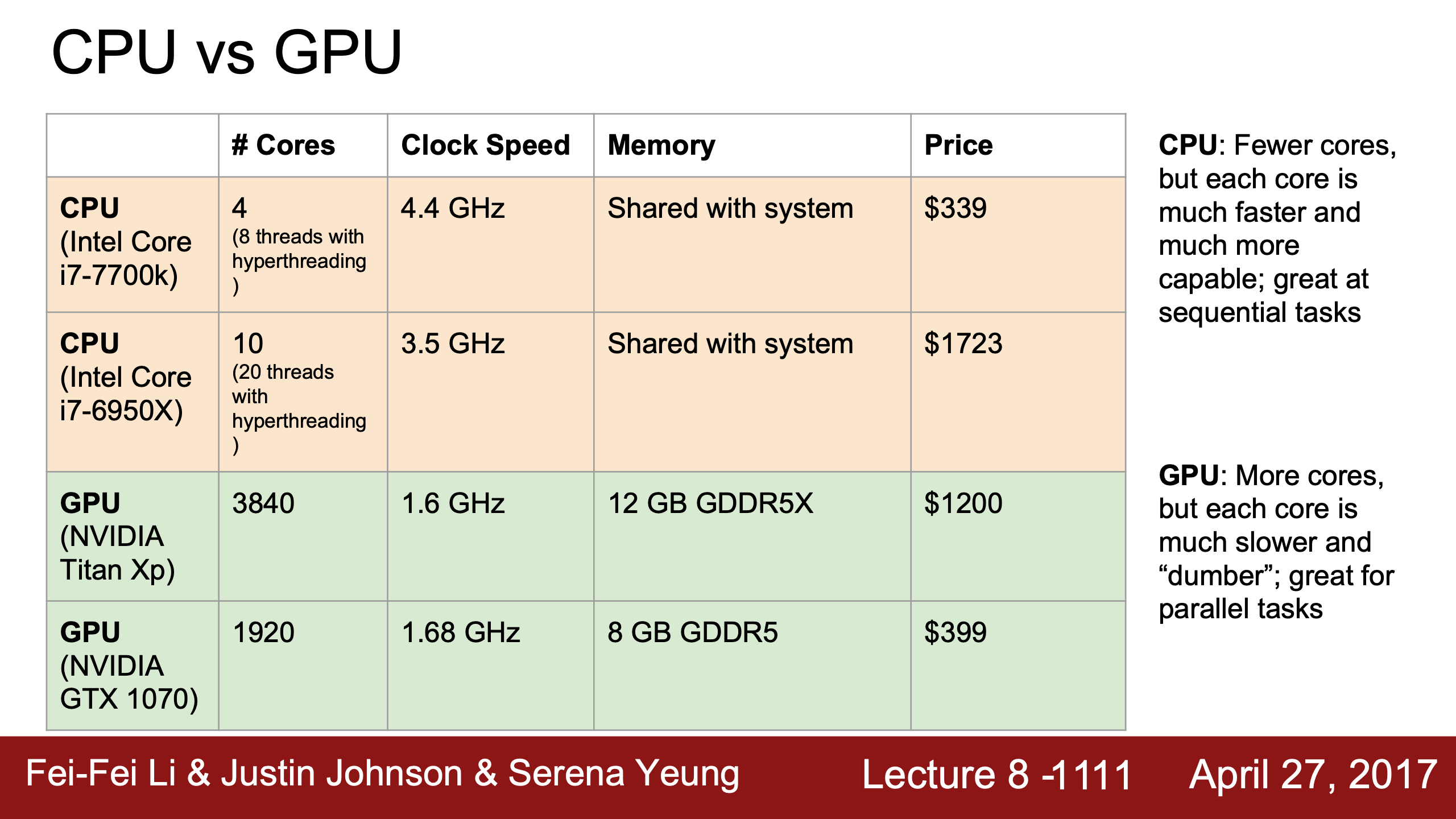

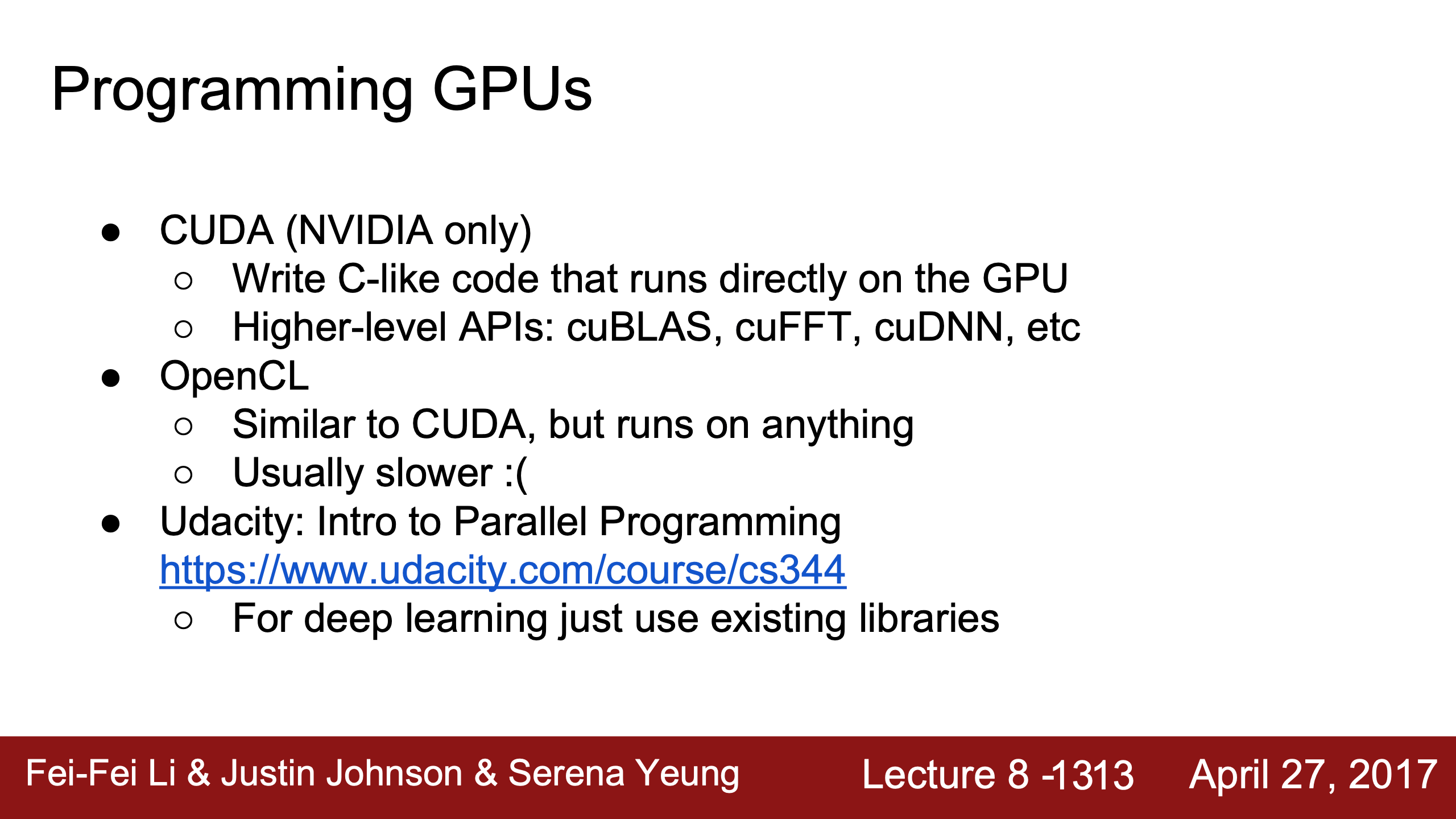

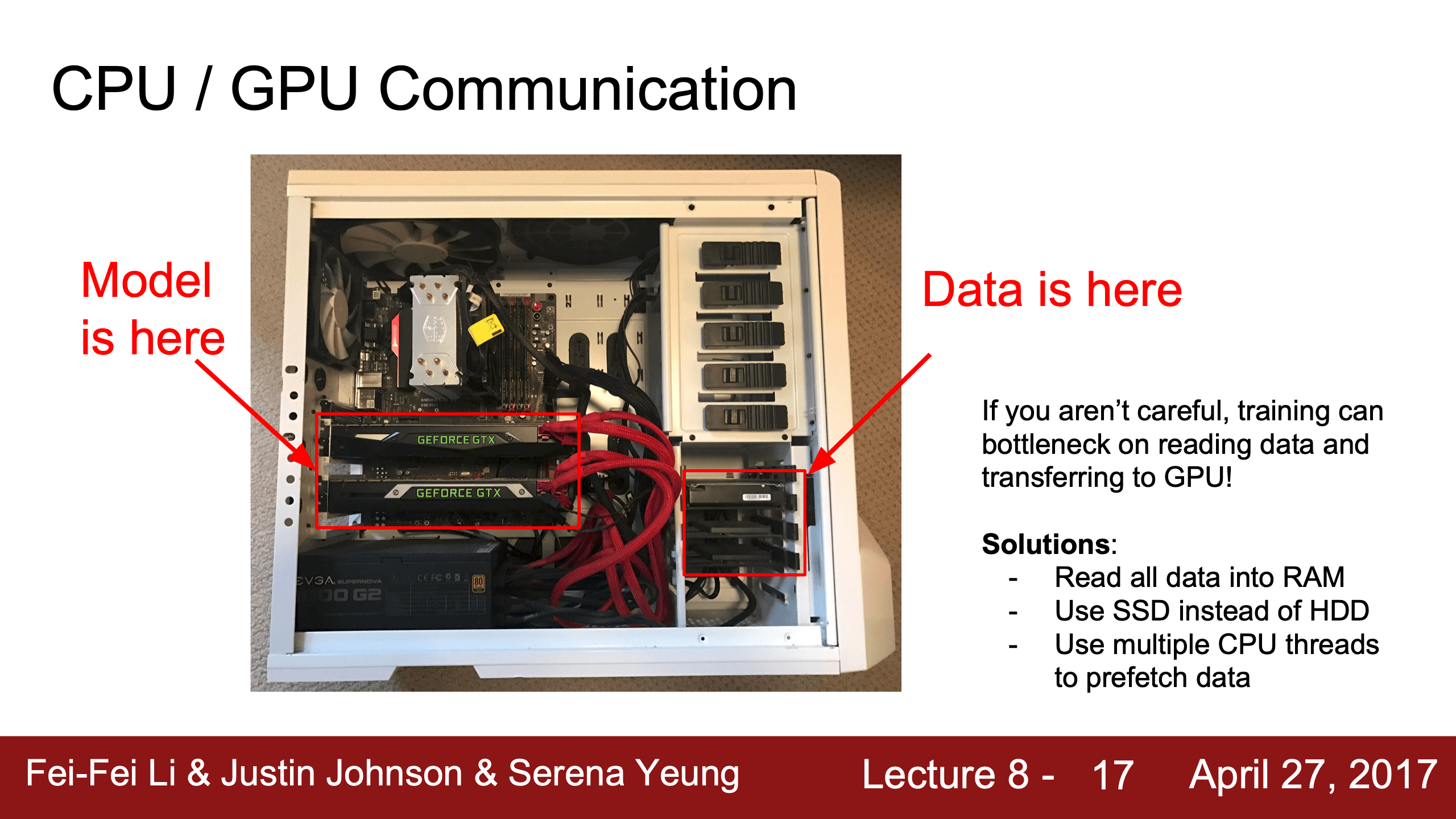

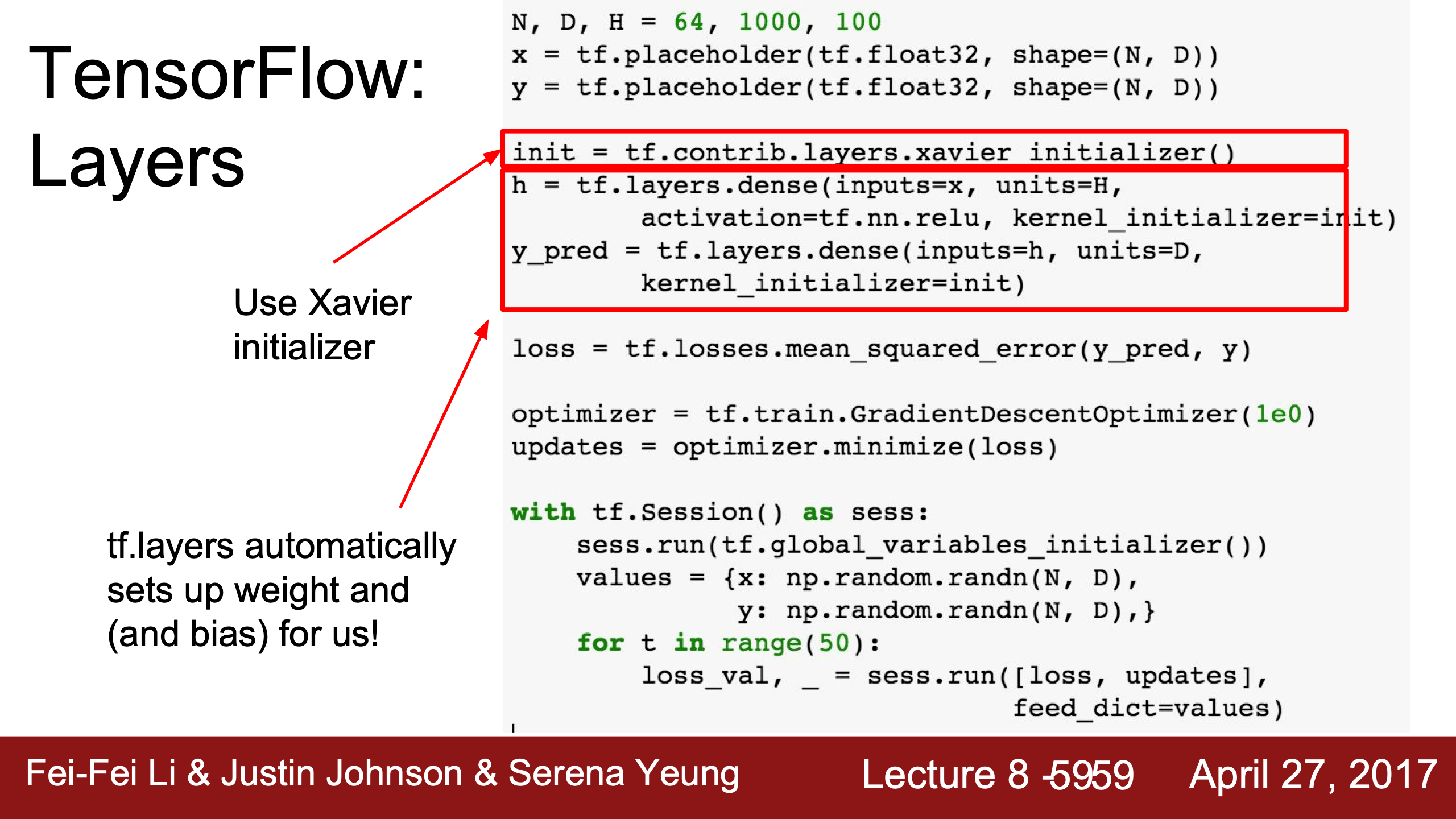

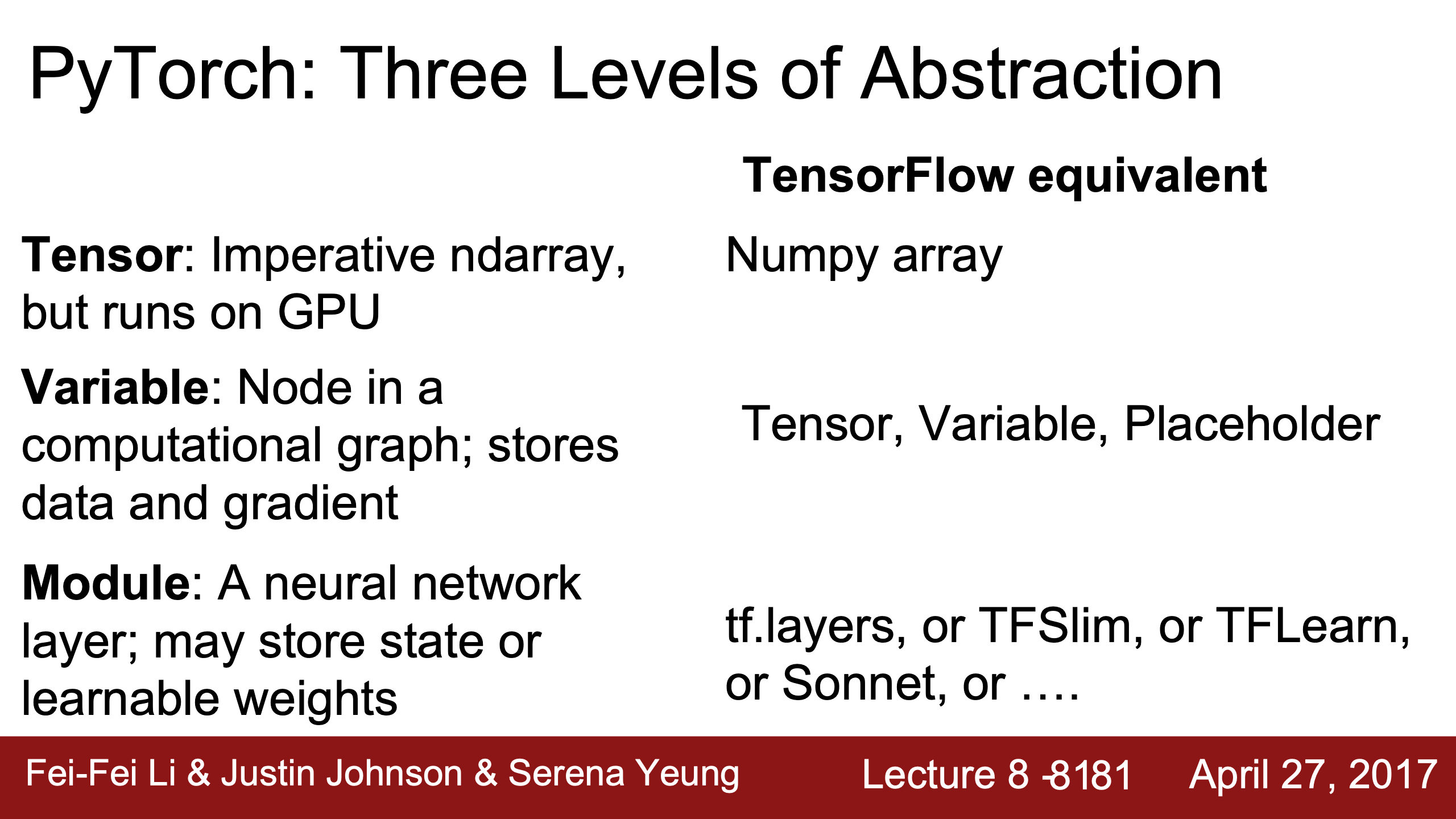

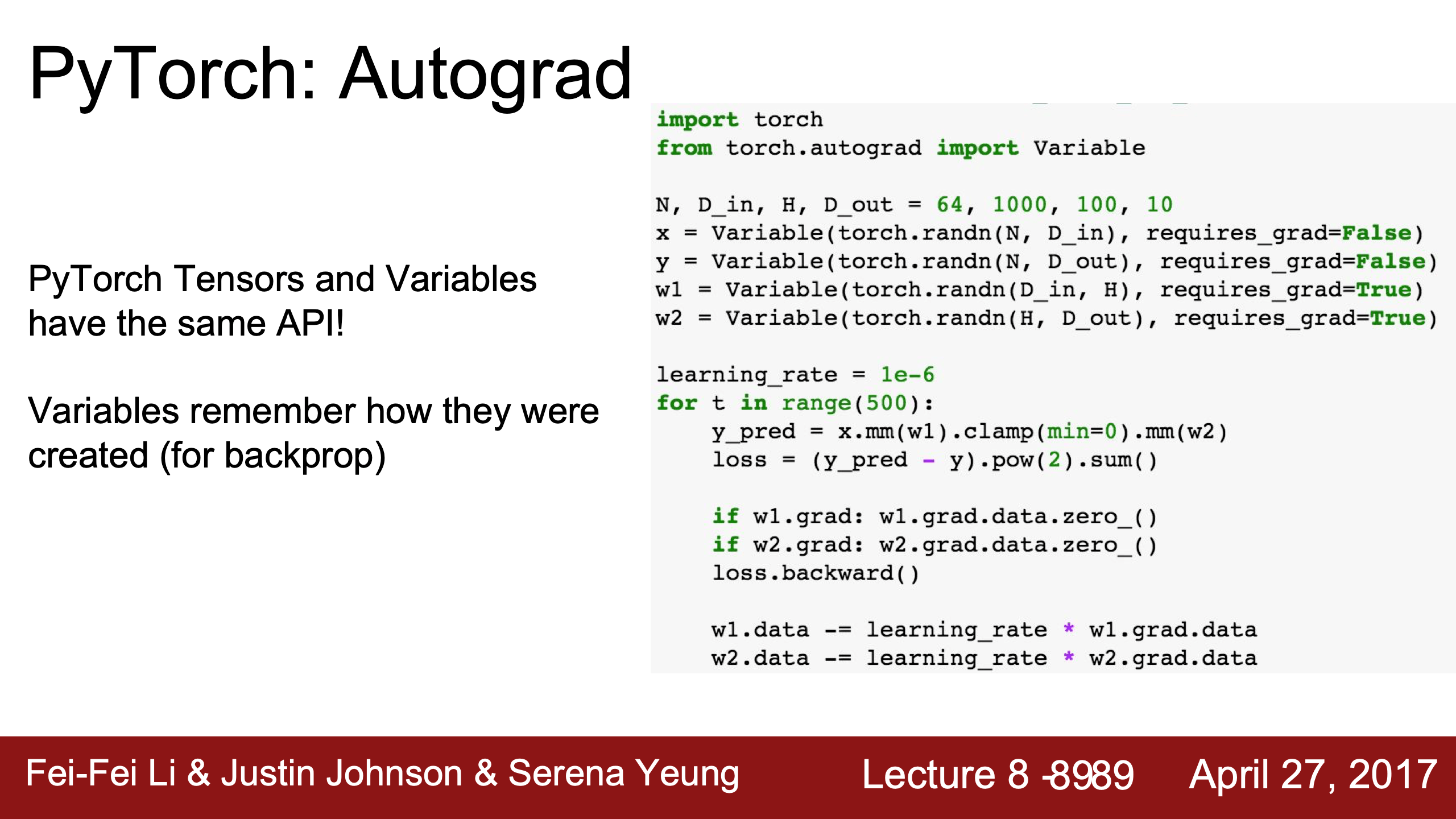

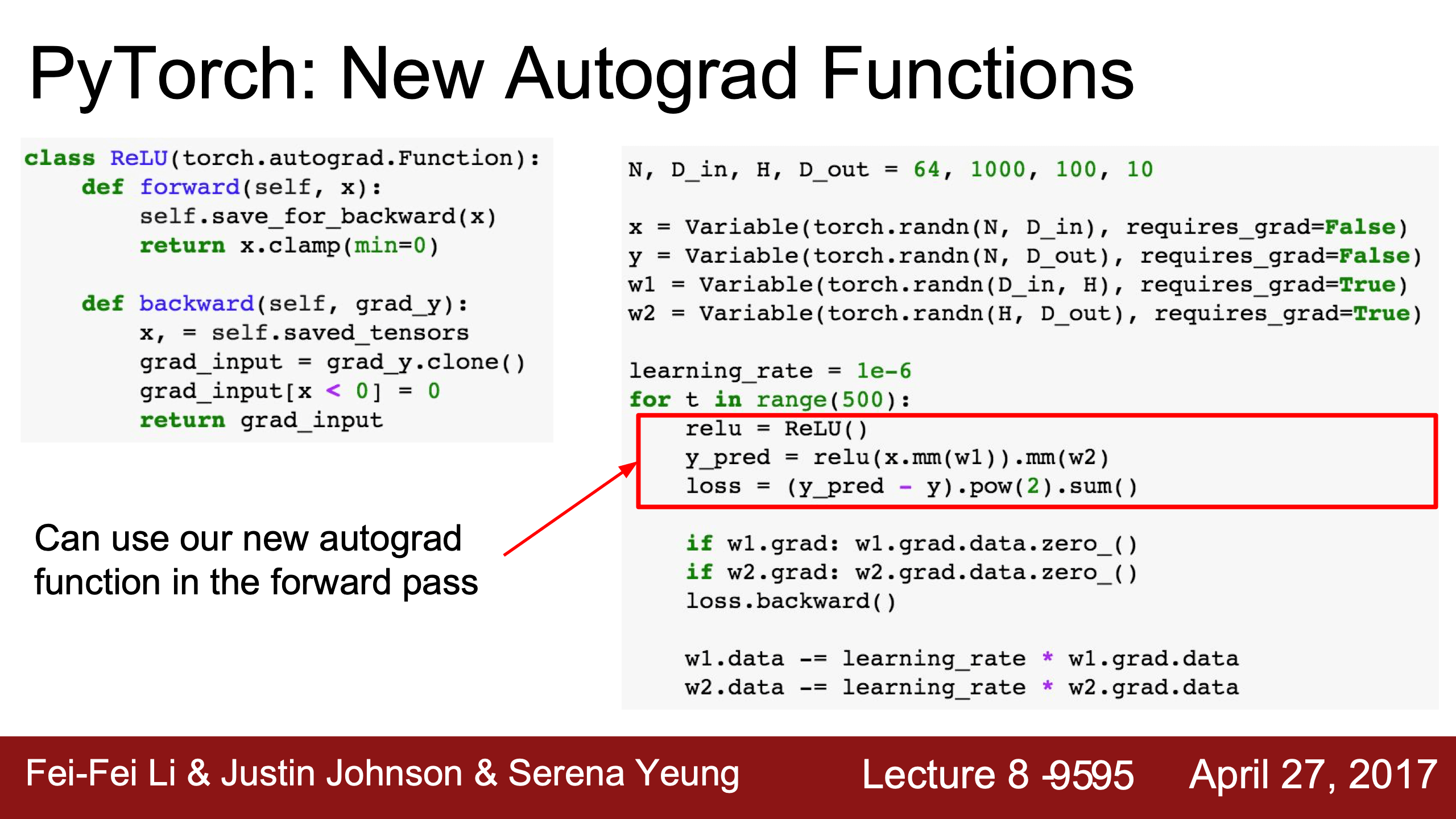

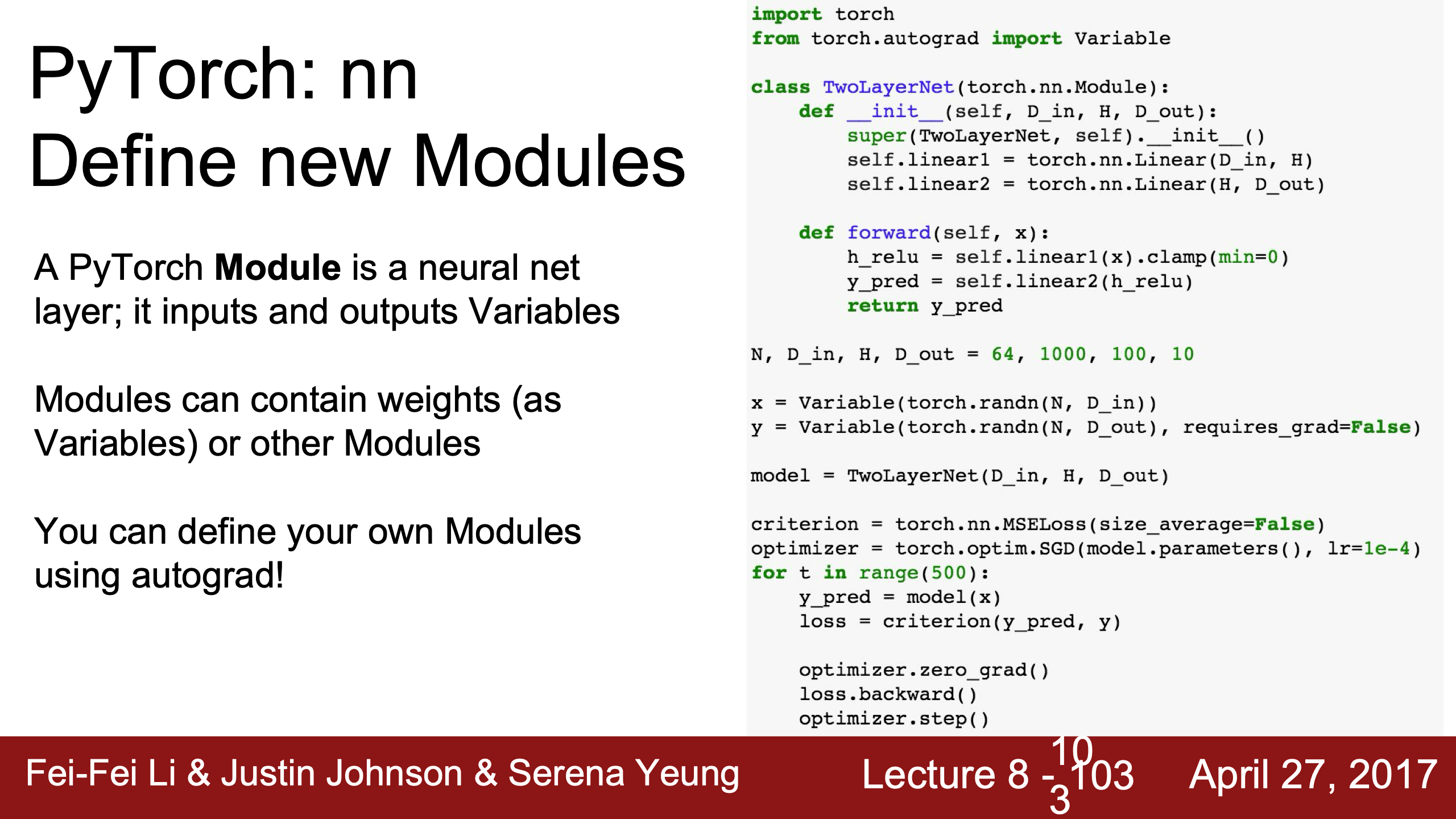

- Lecture 8

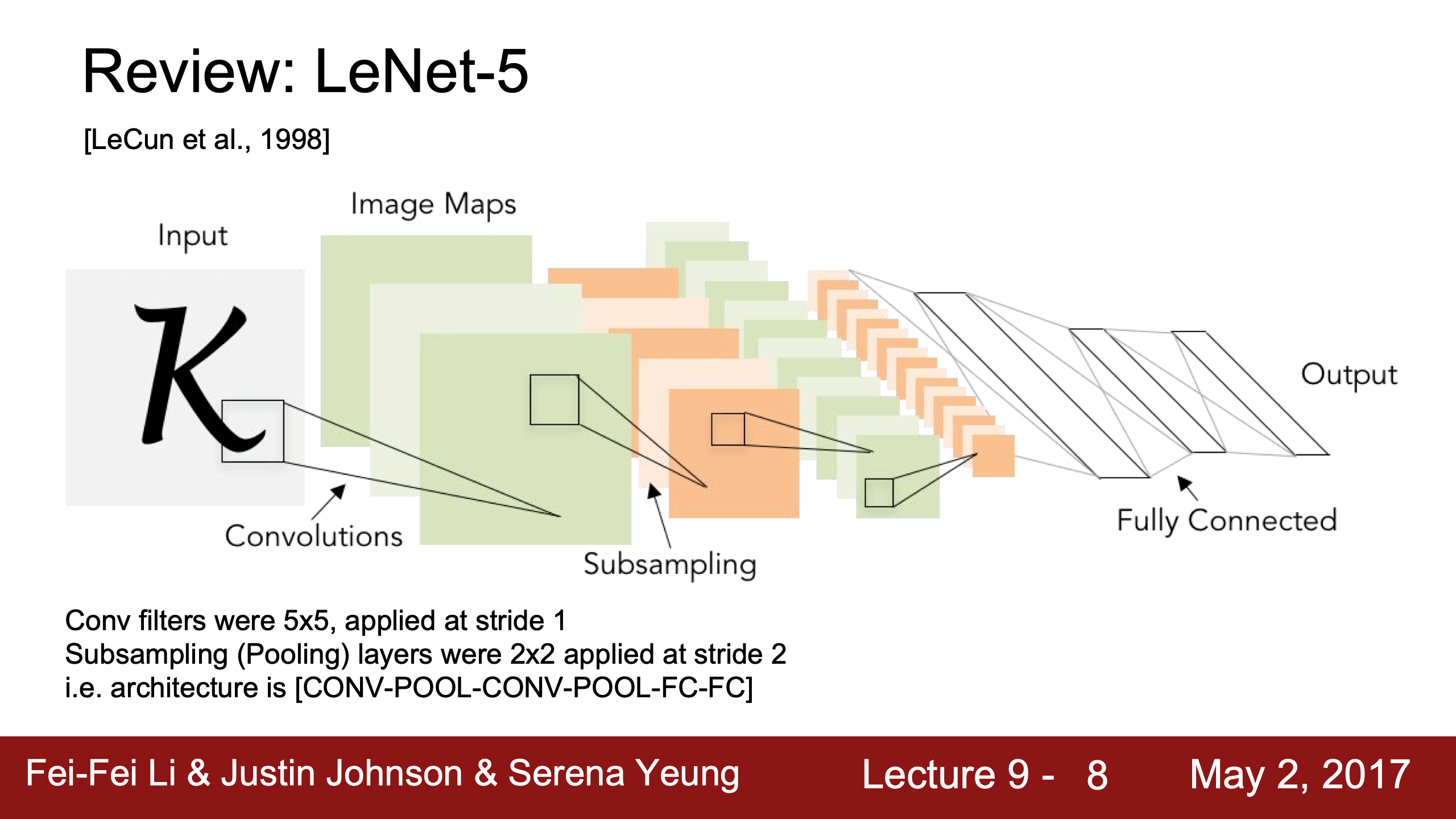

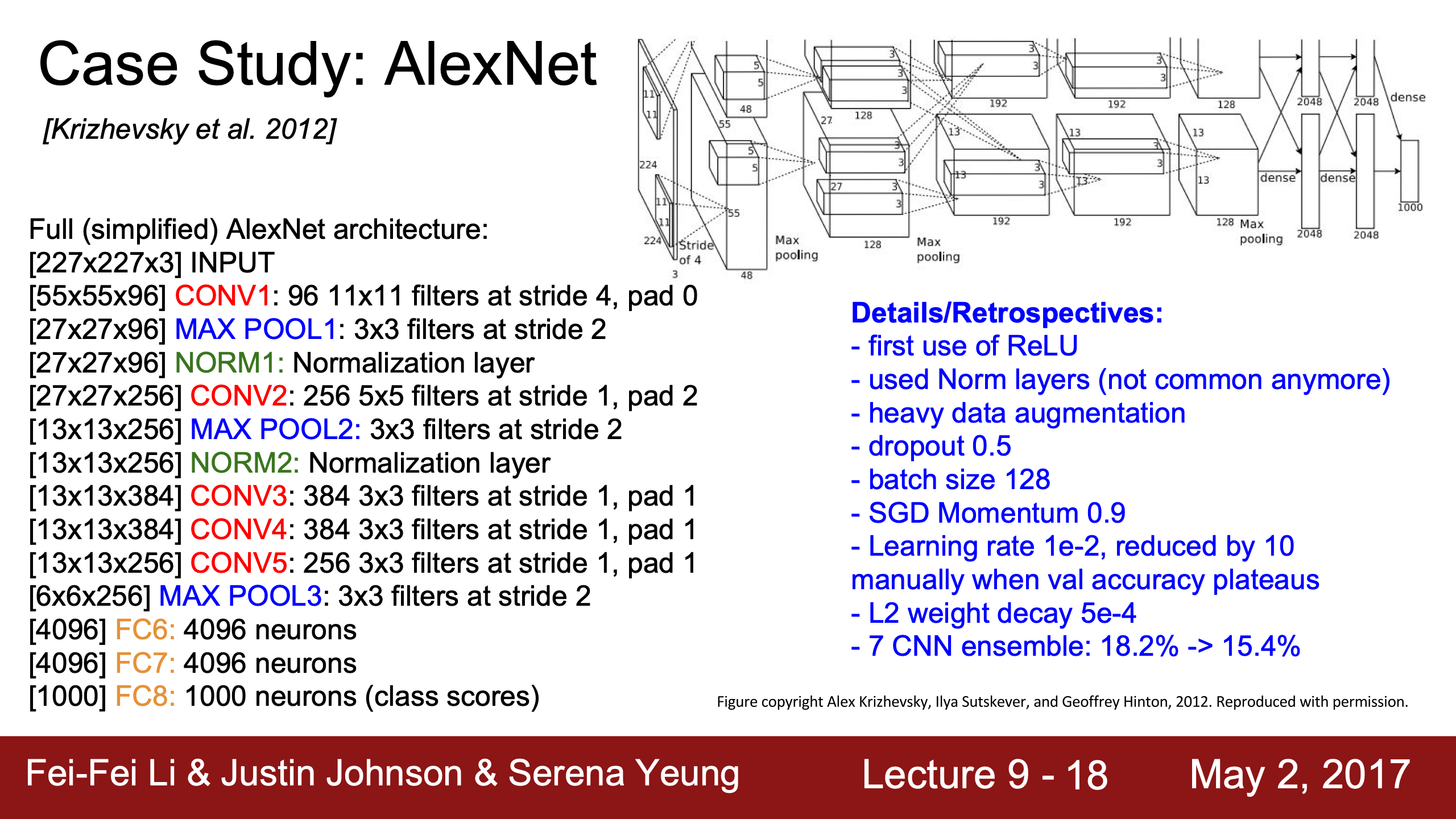

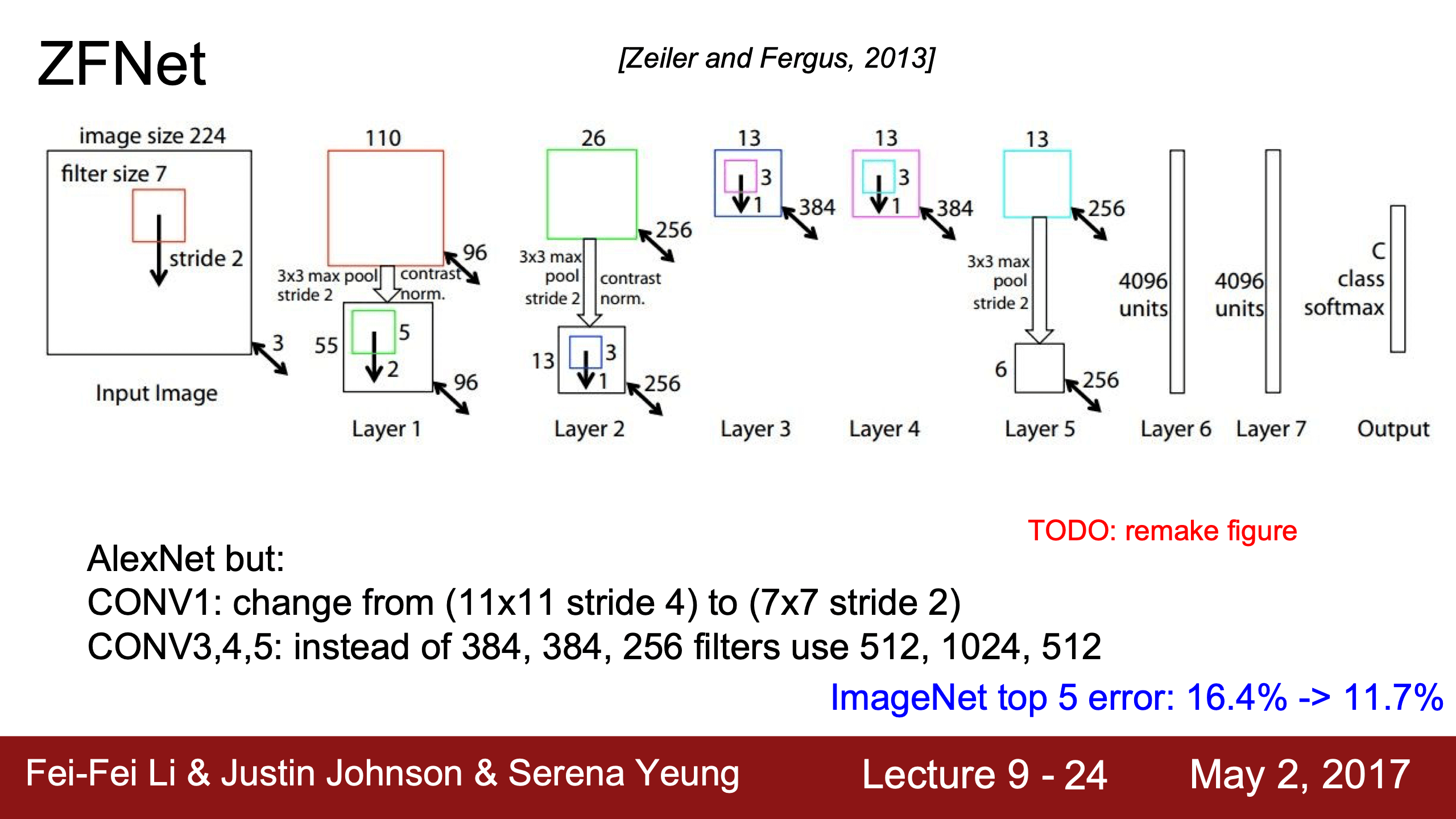

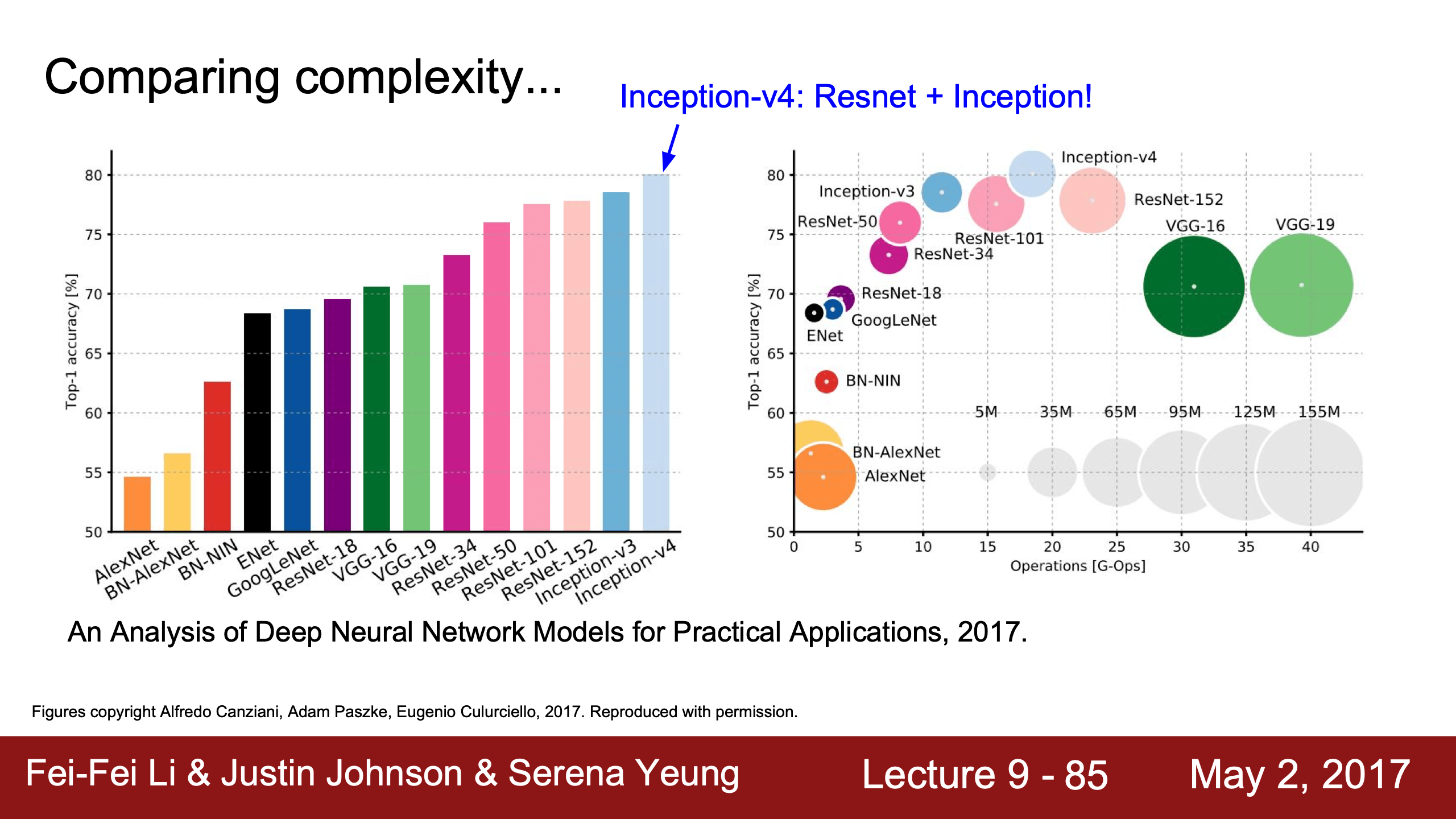

- Lecture 9

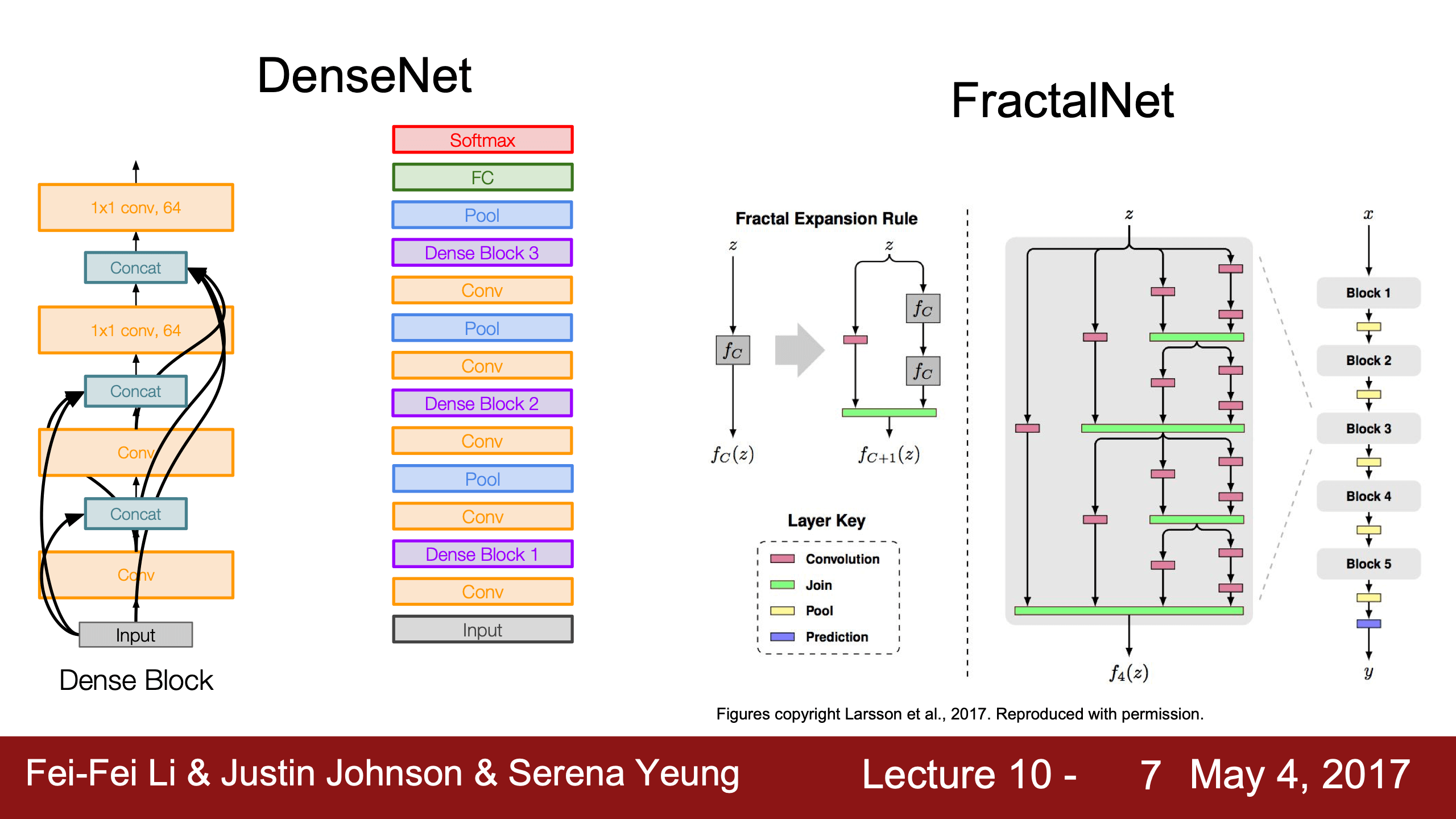

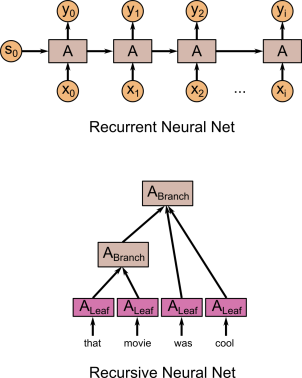

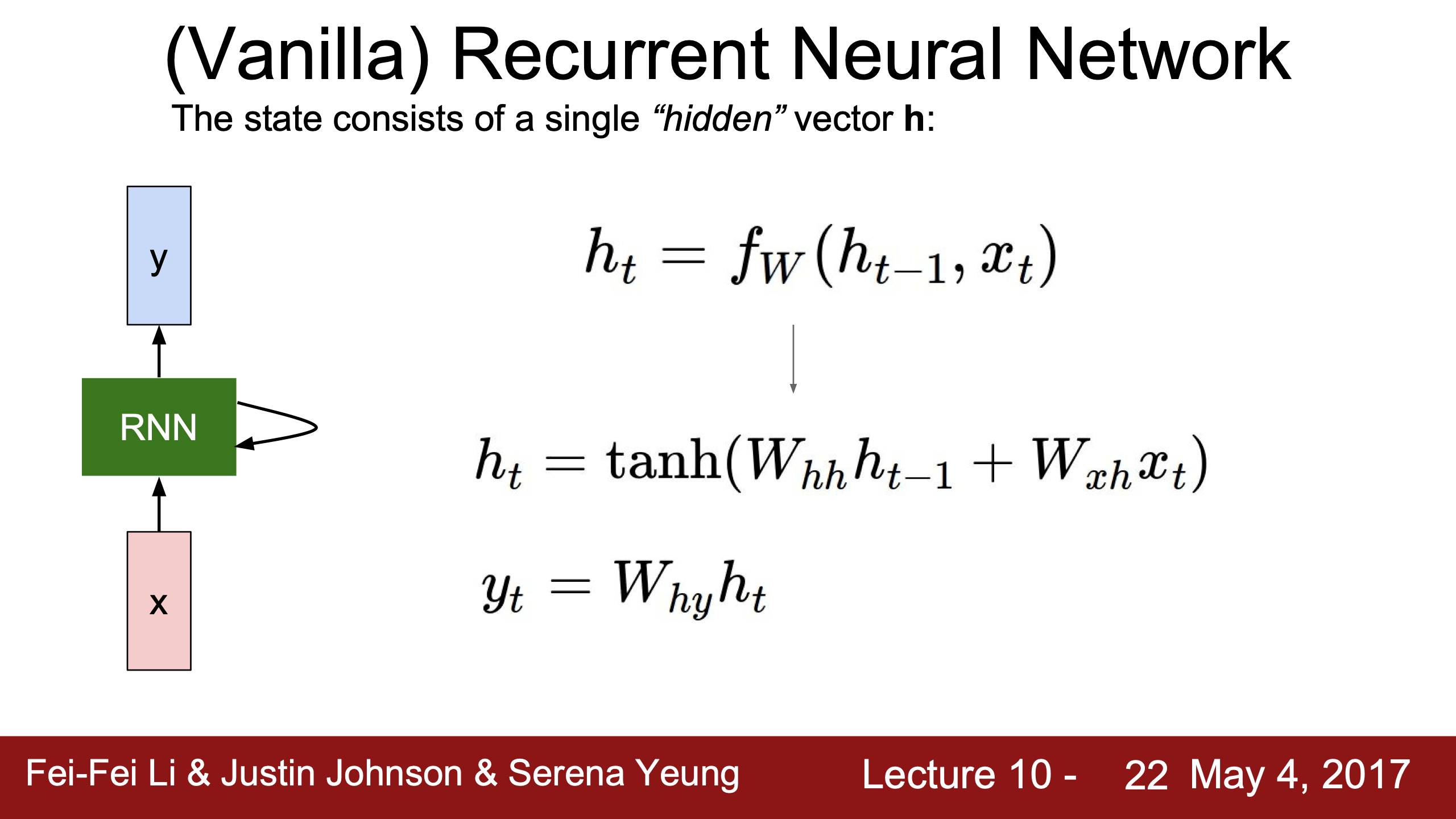

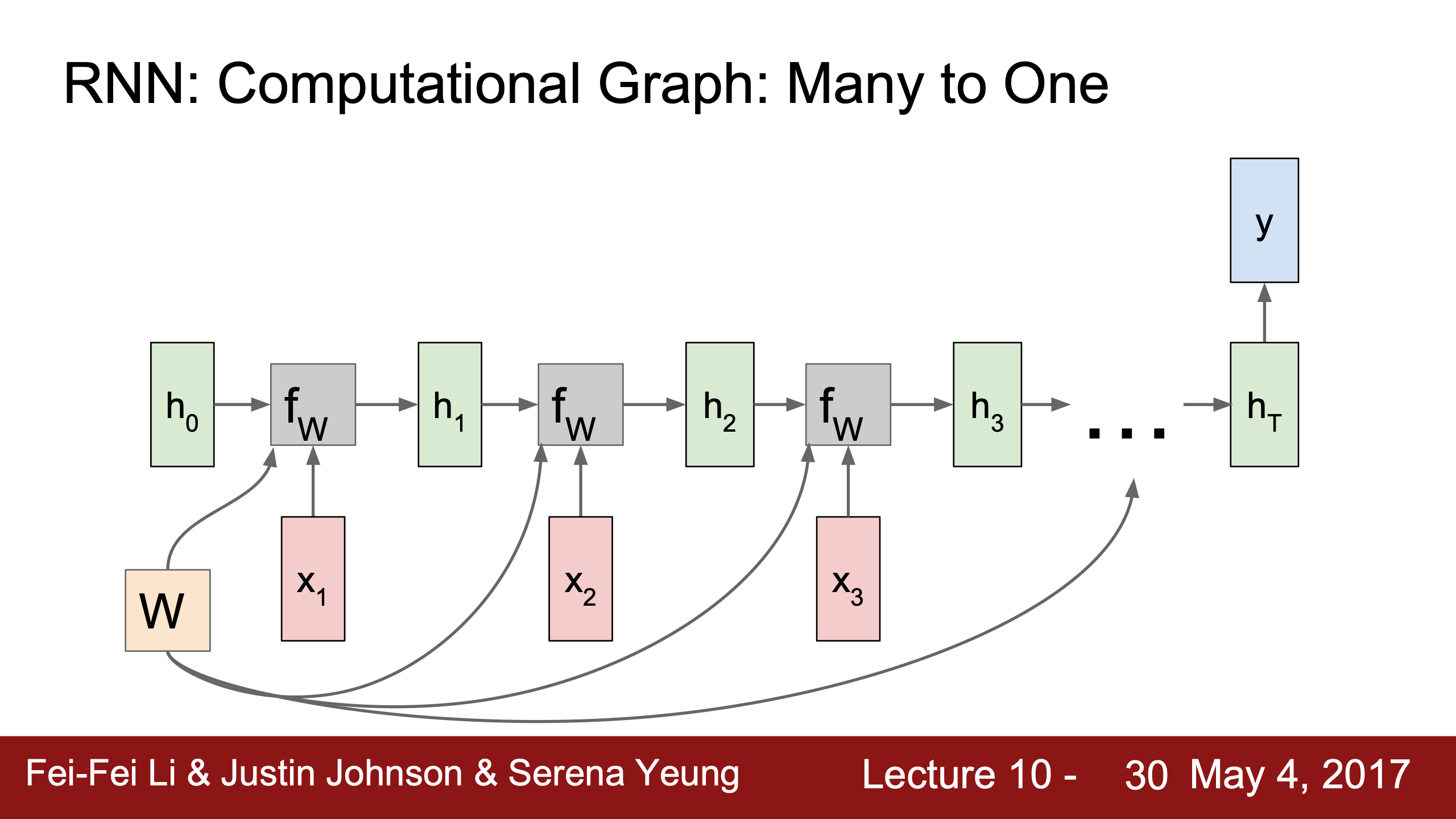

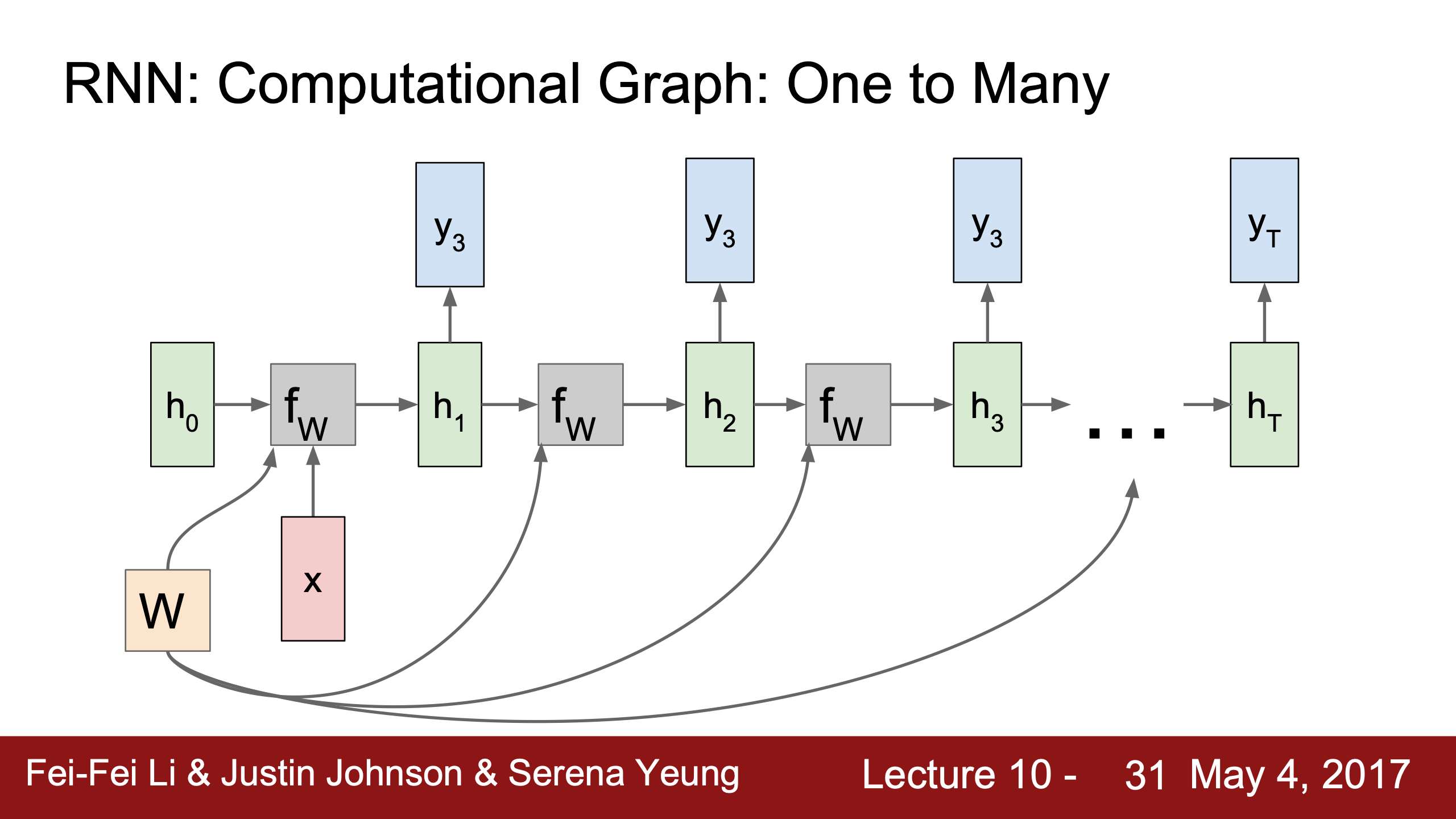

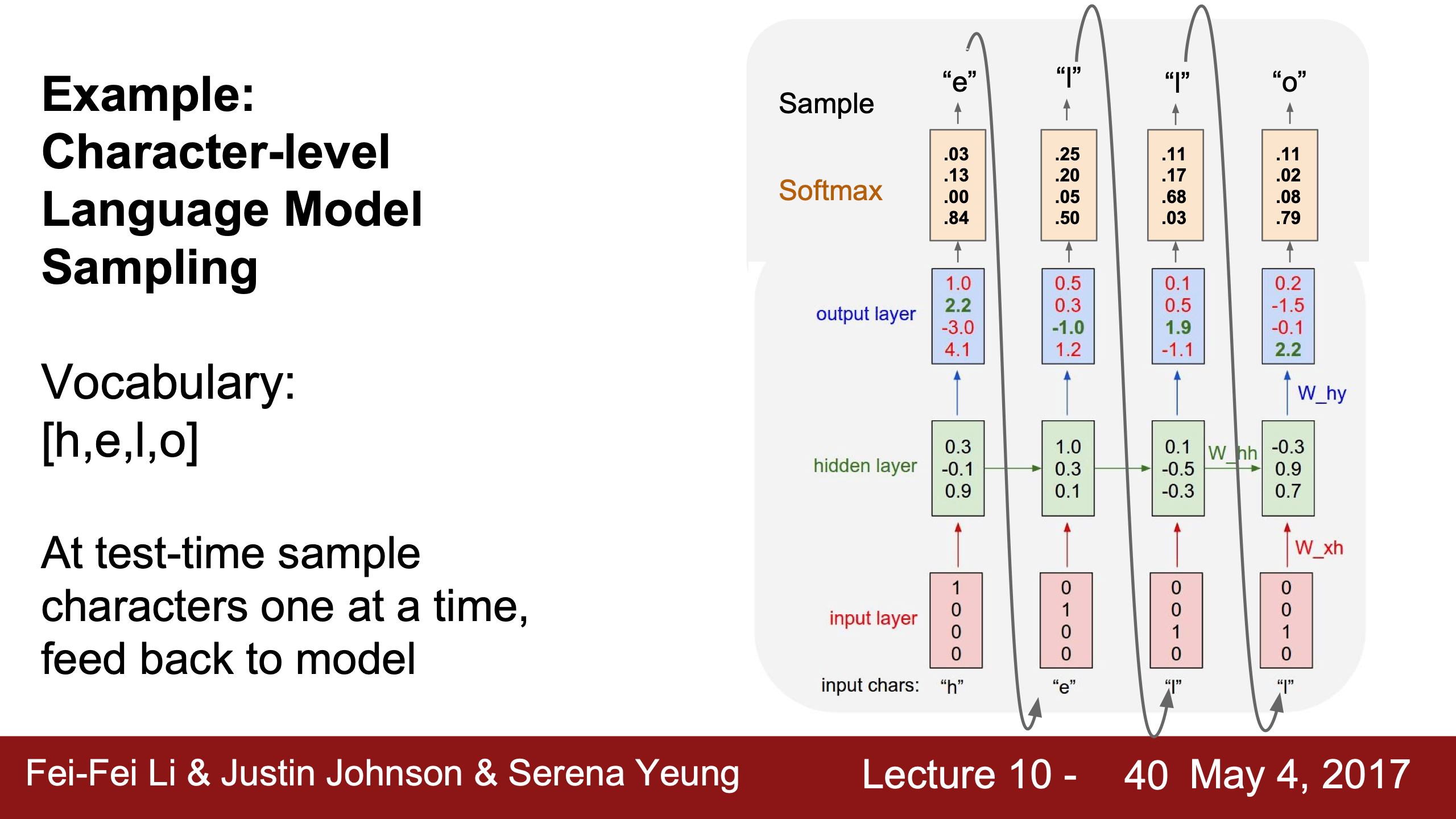

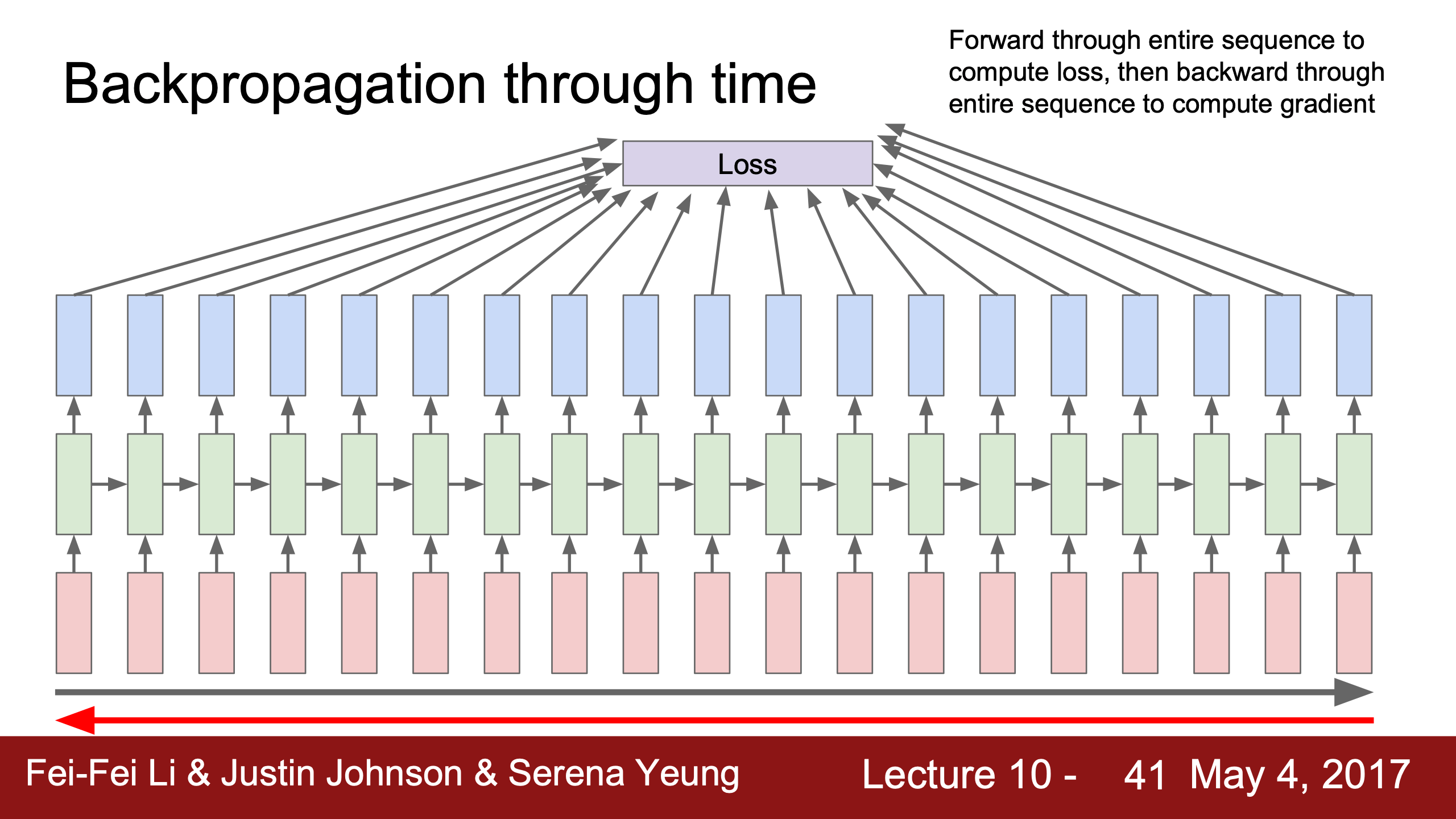

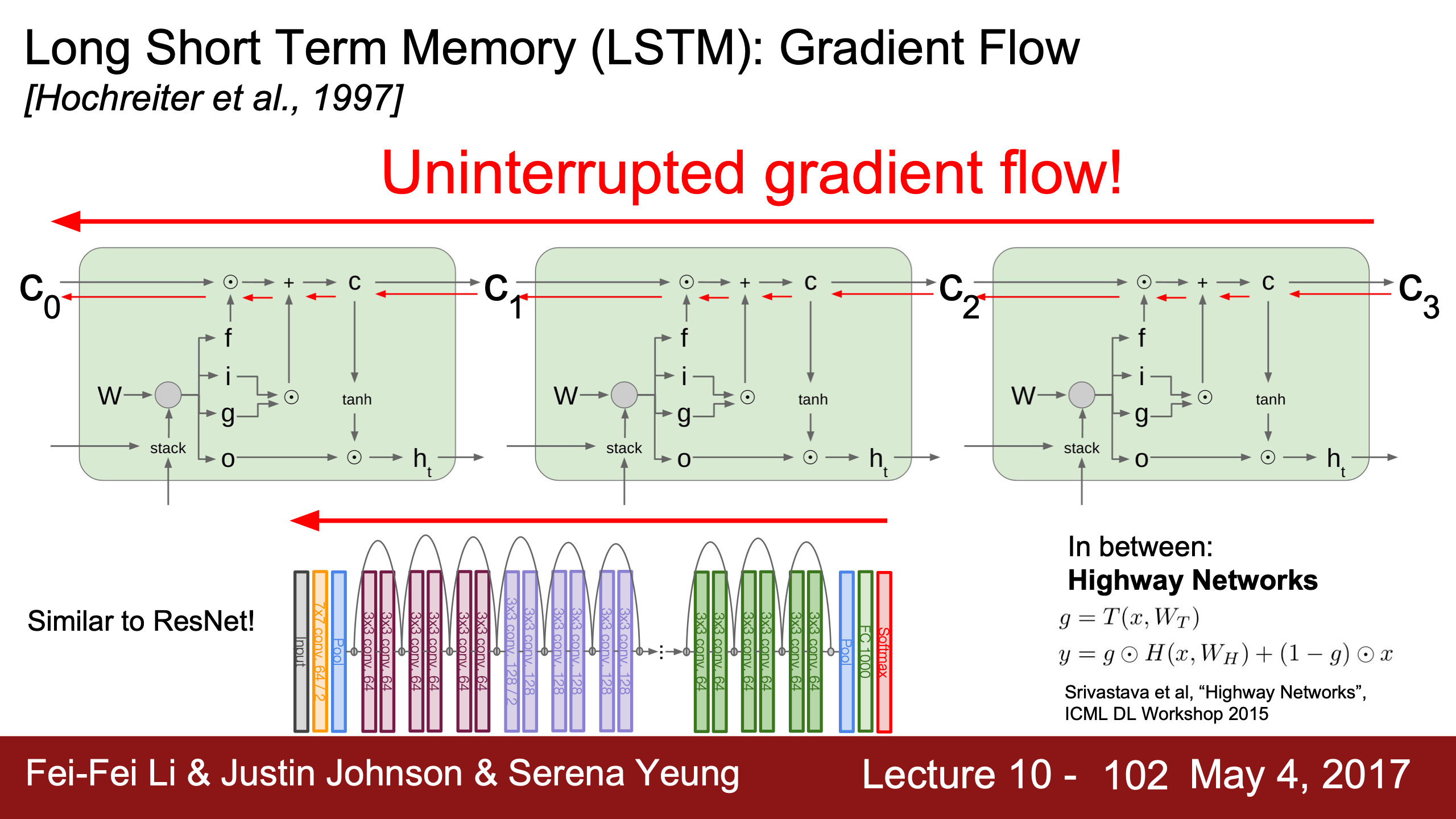

- Lecture 10

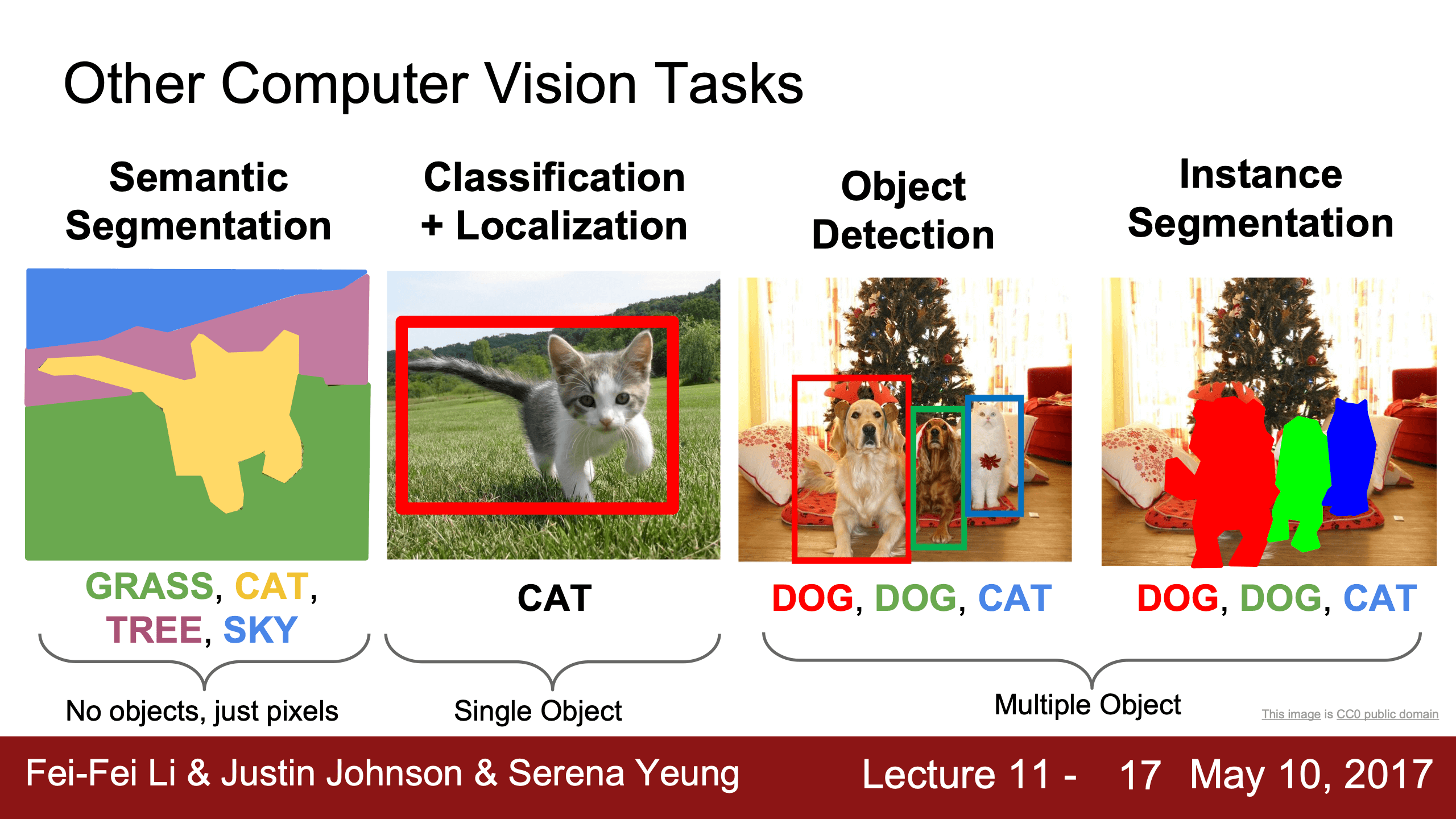

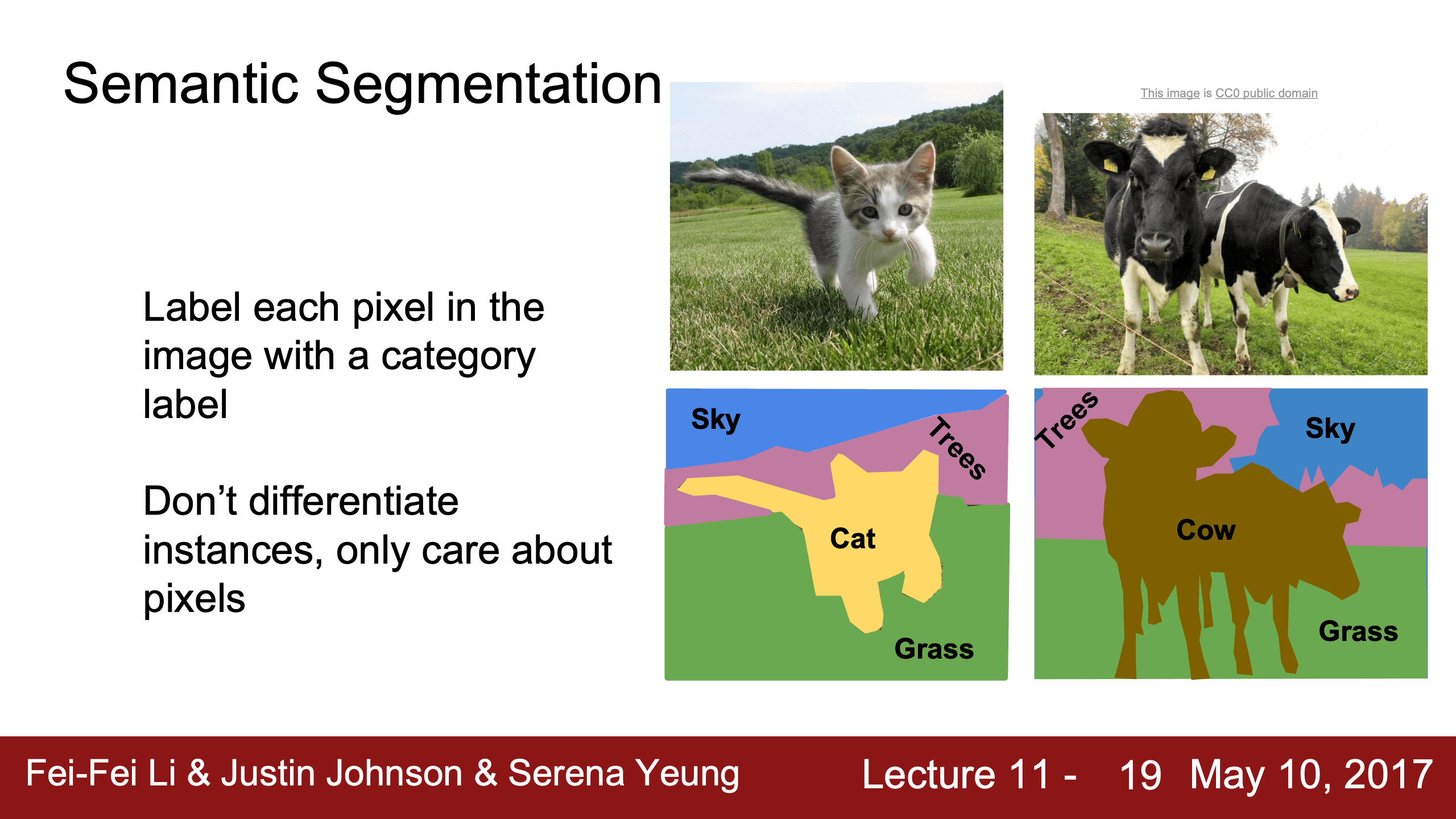

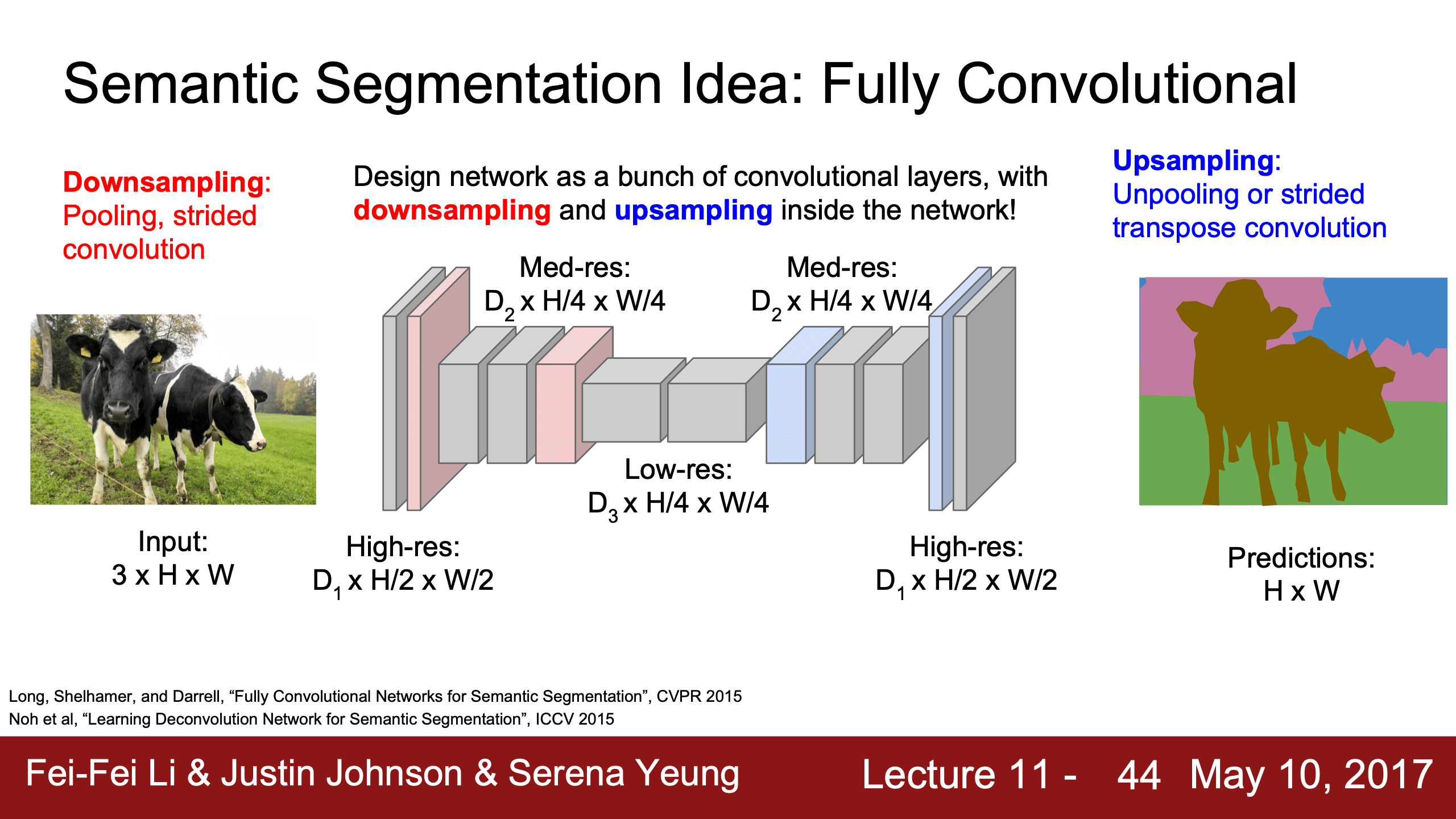

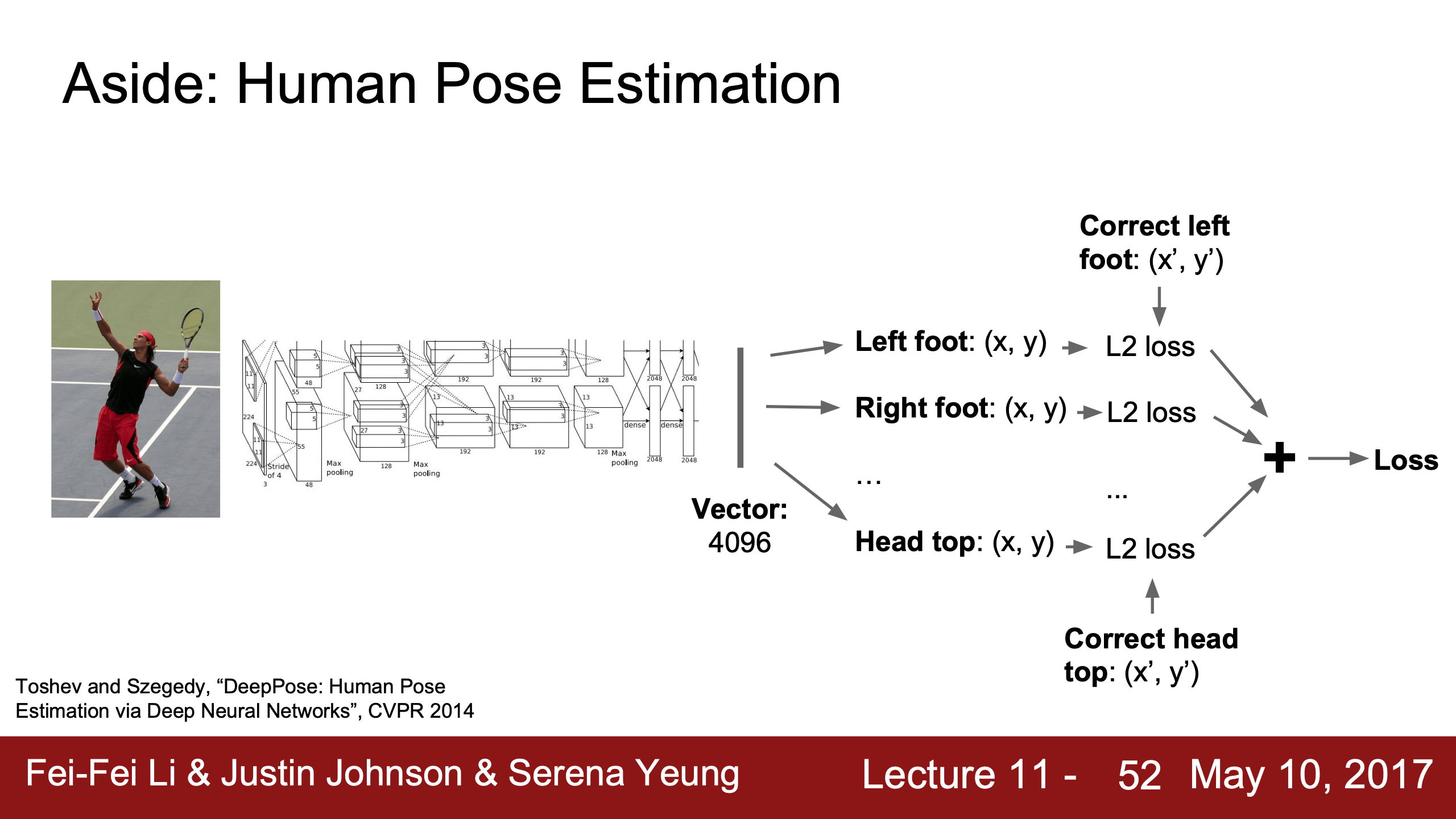

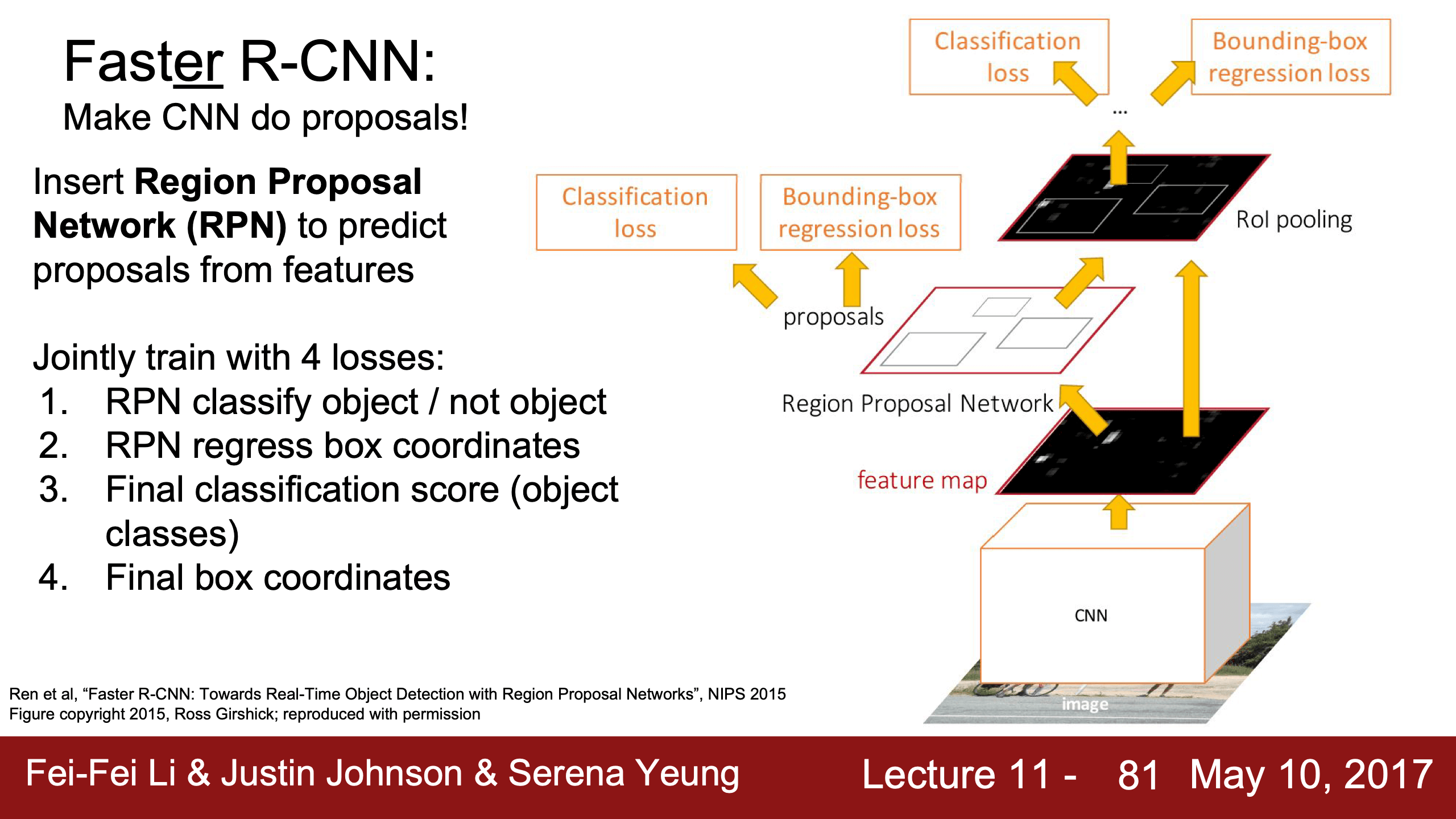

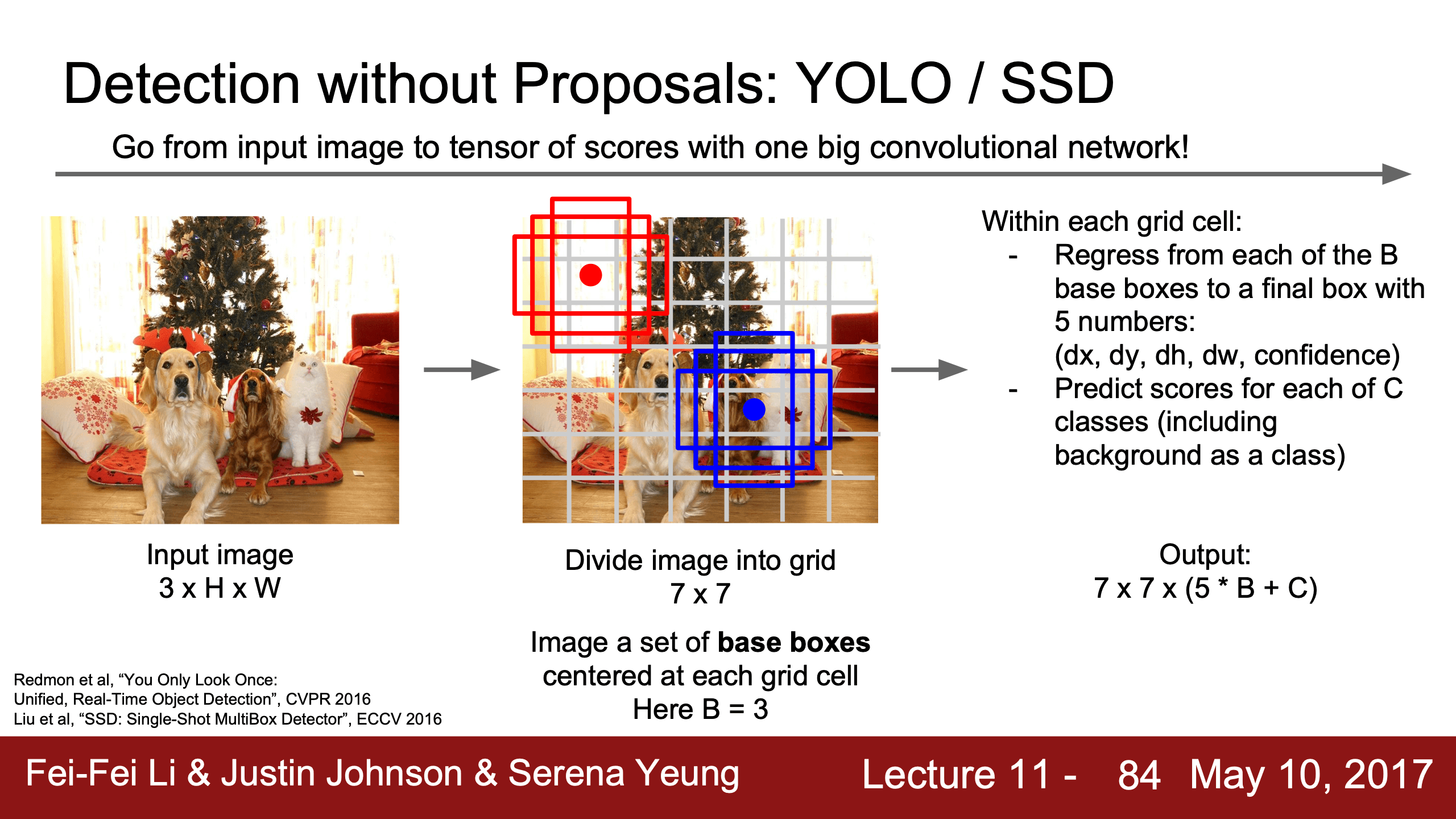

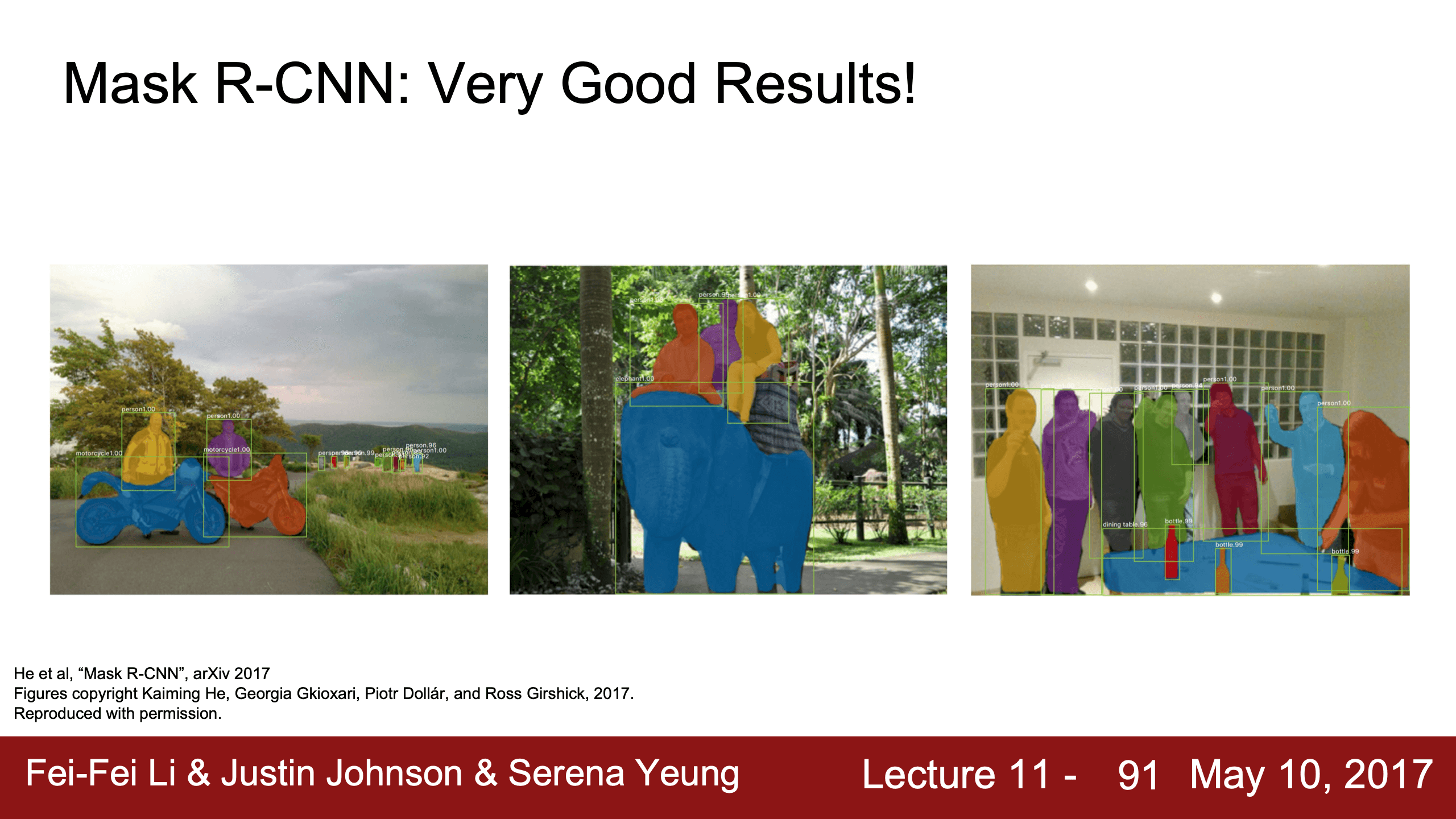

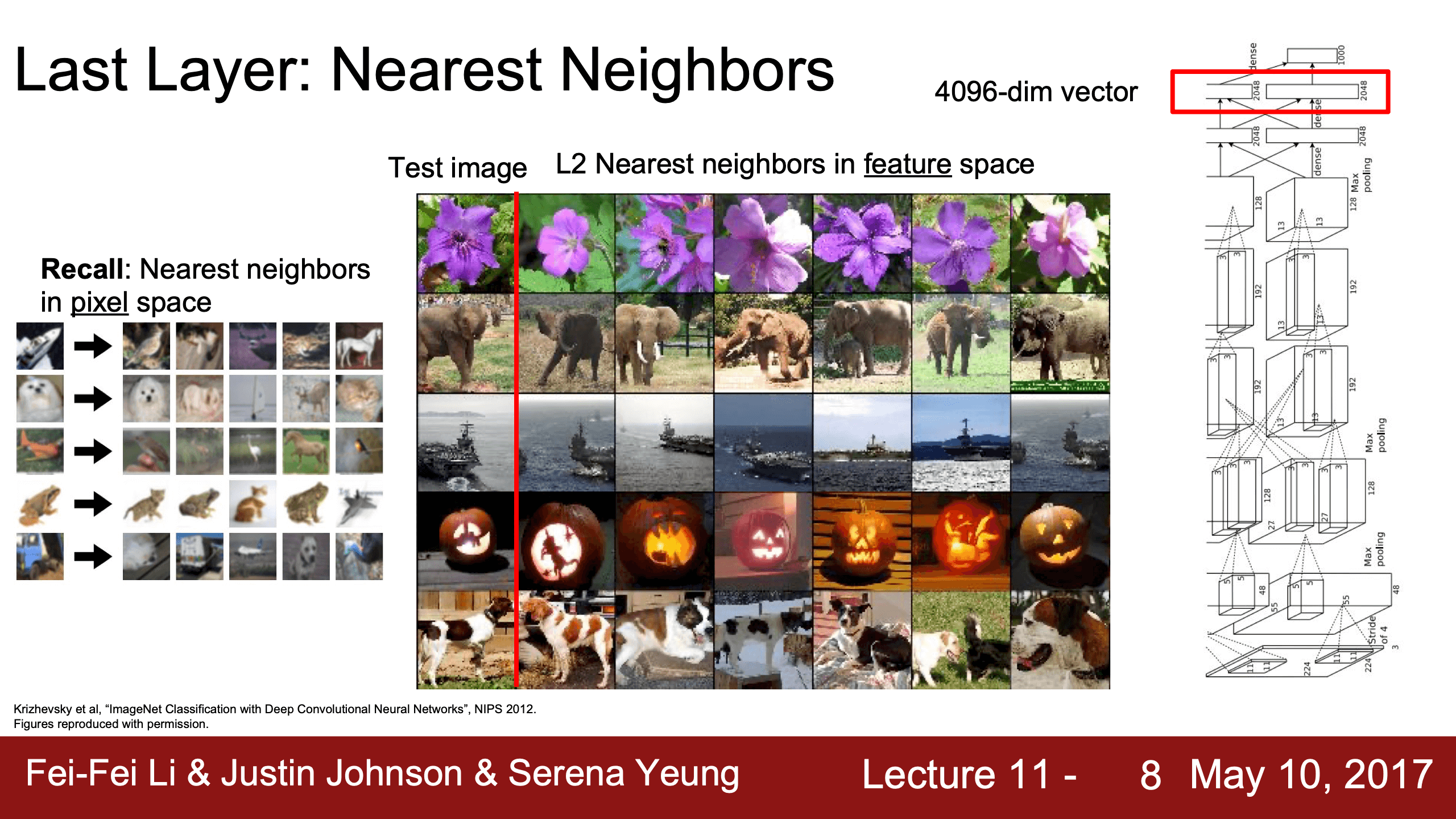

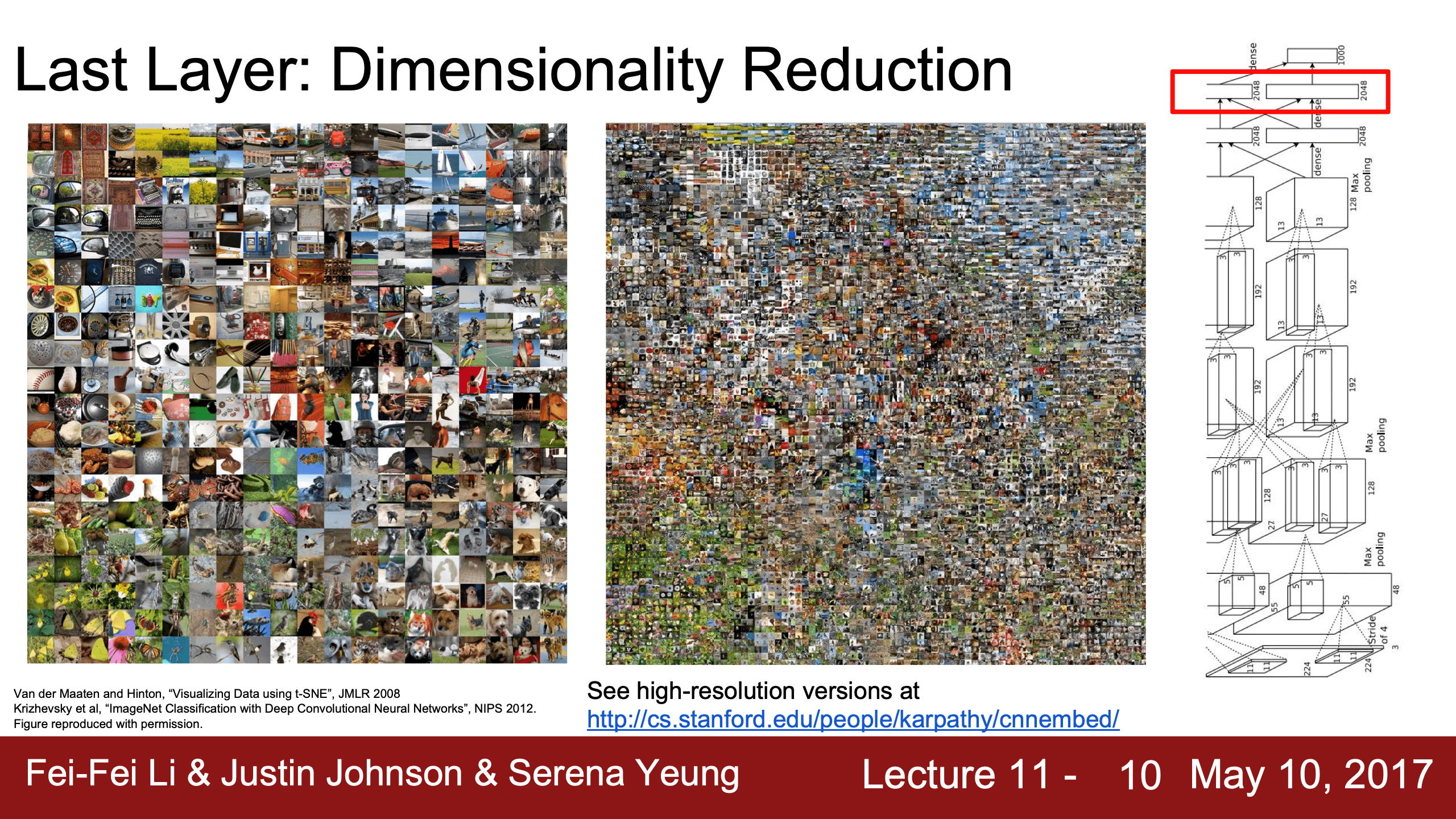

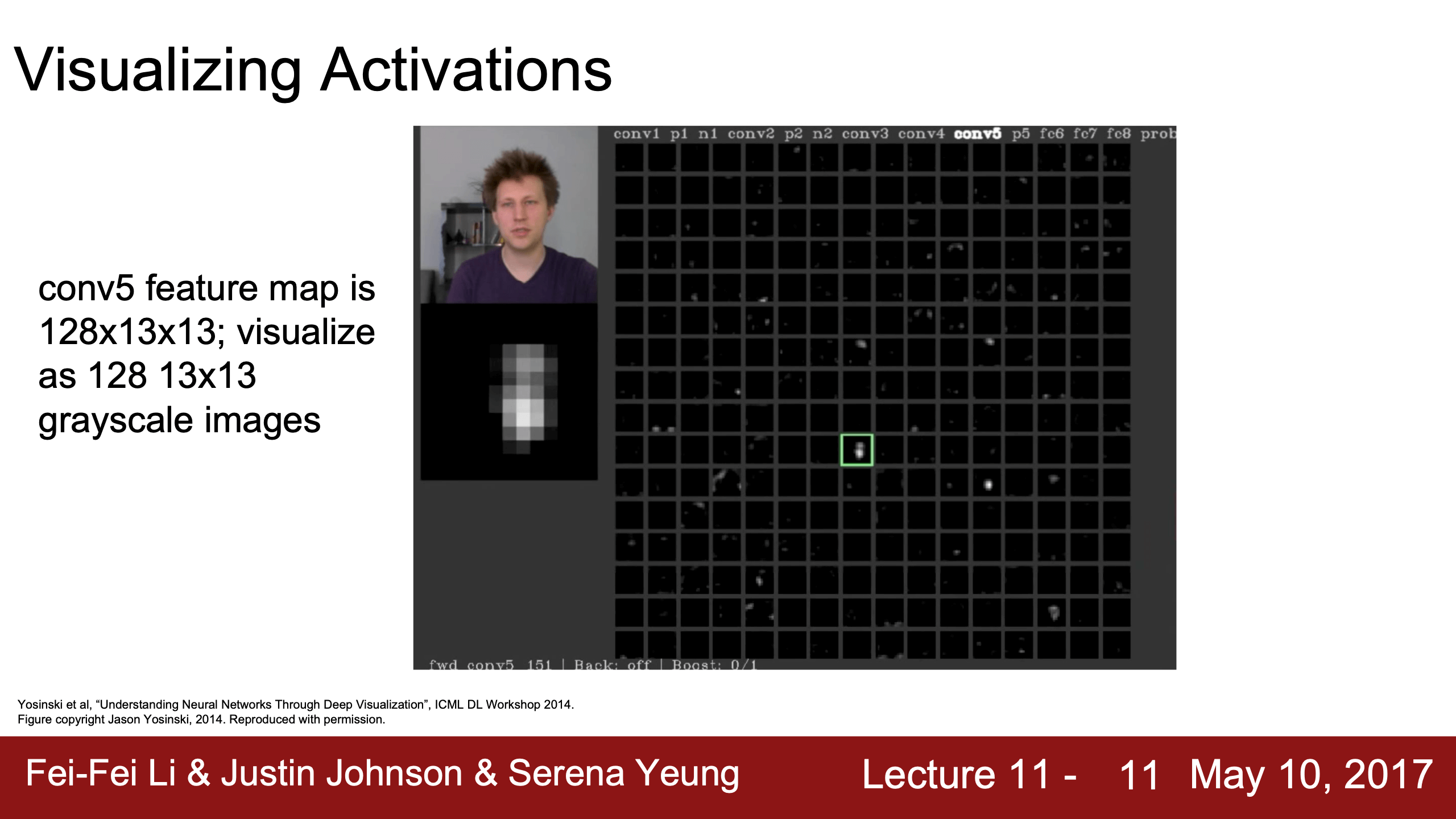

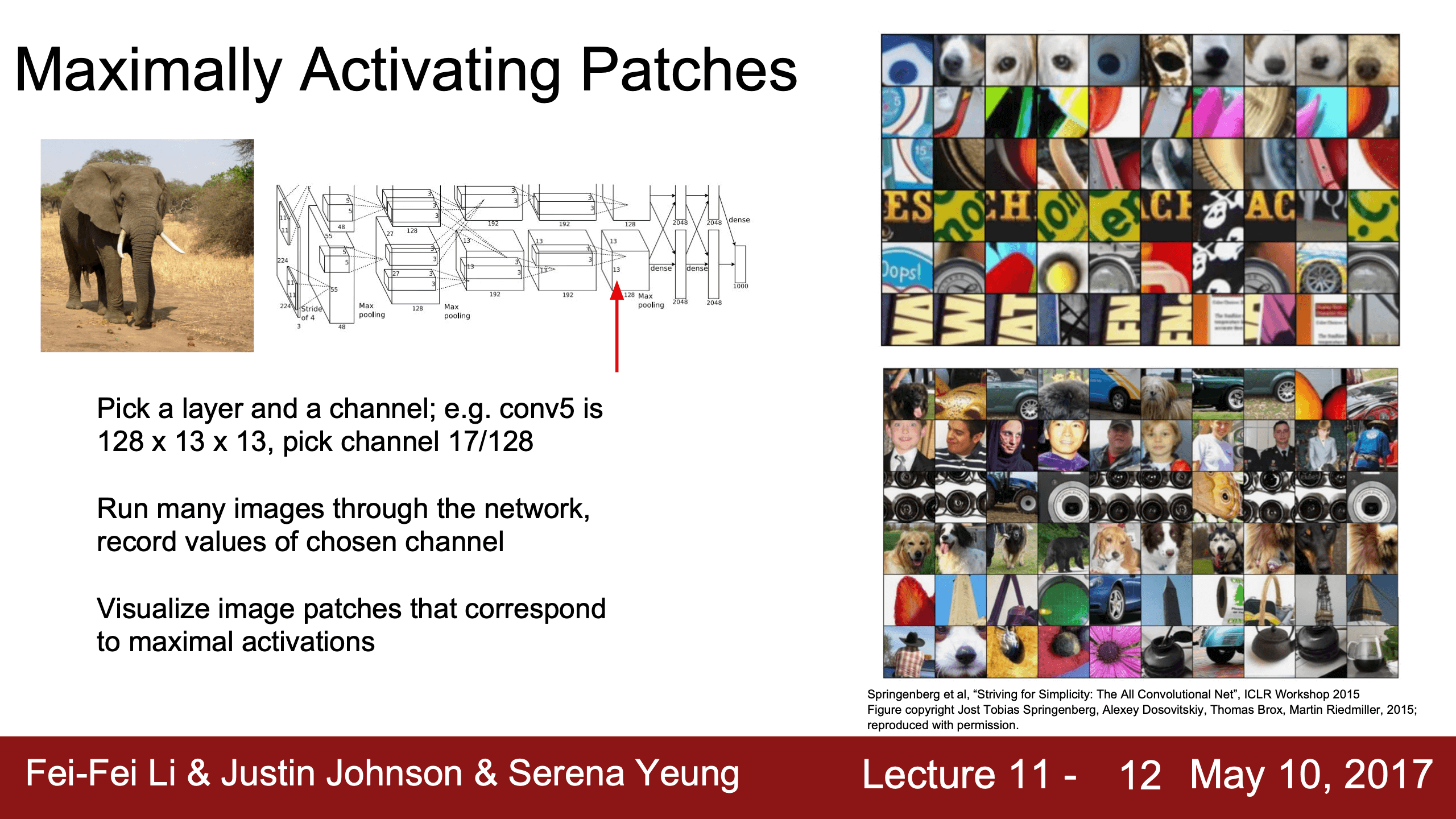

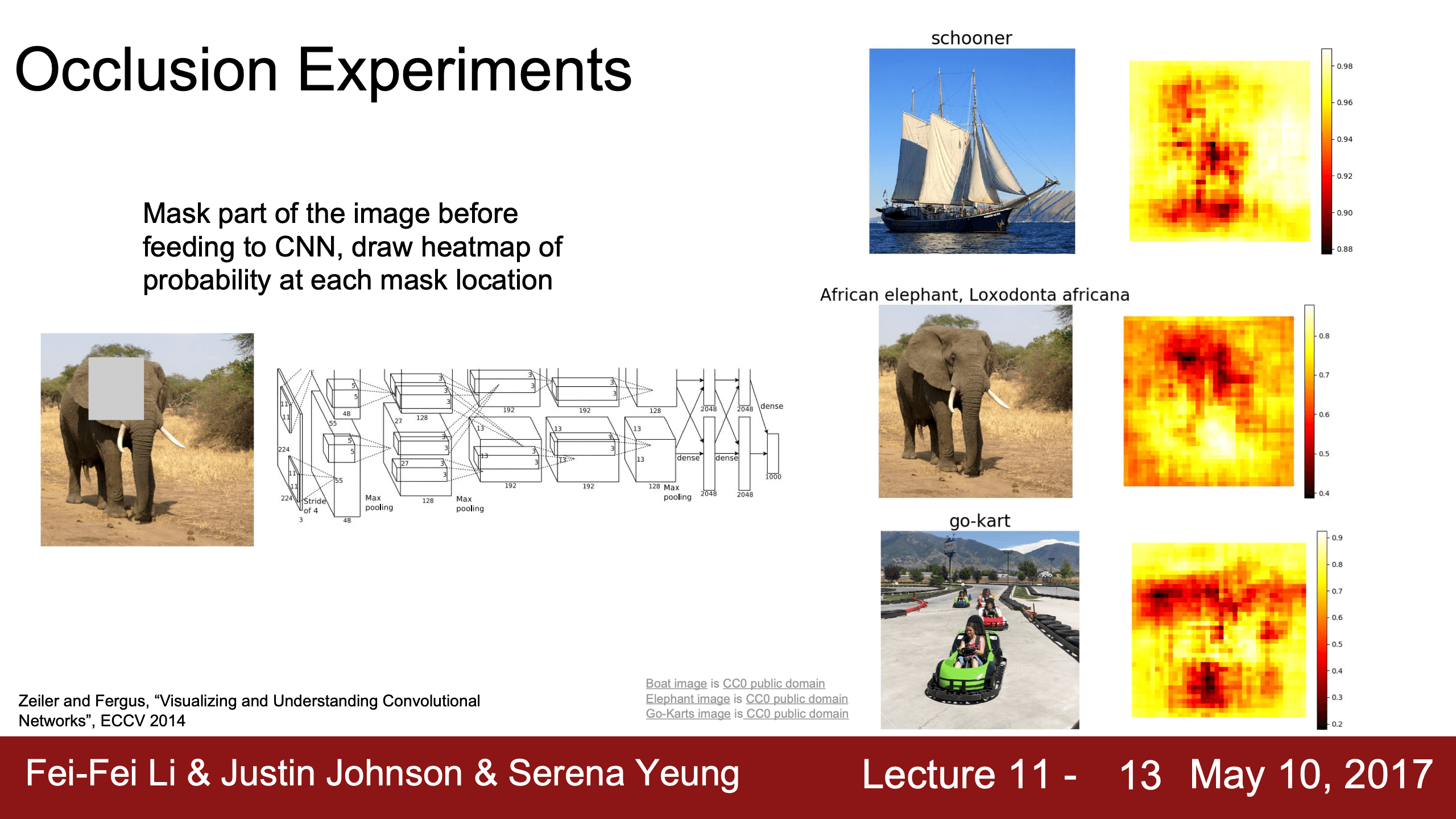

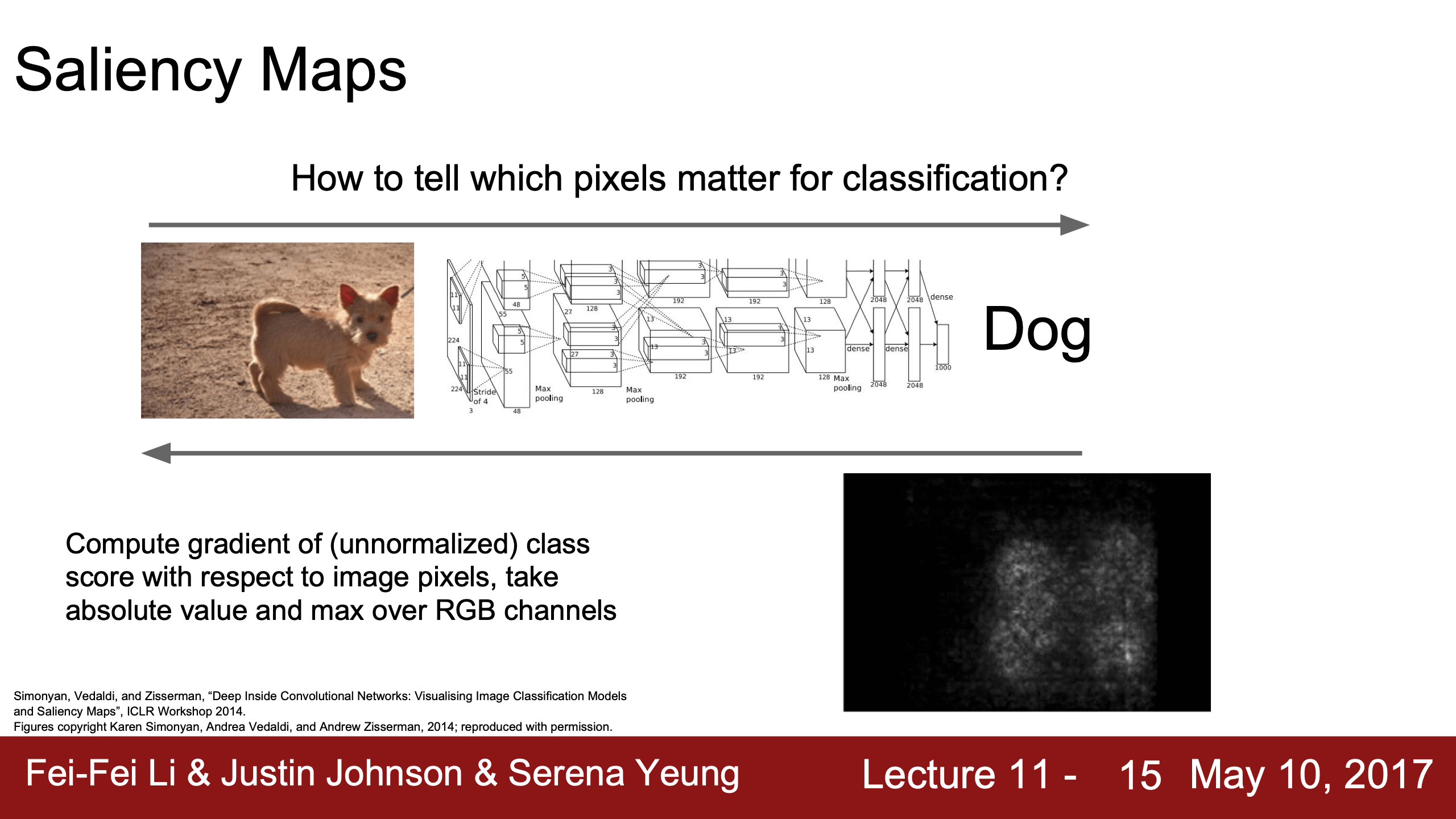

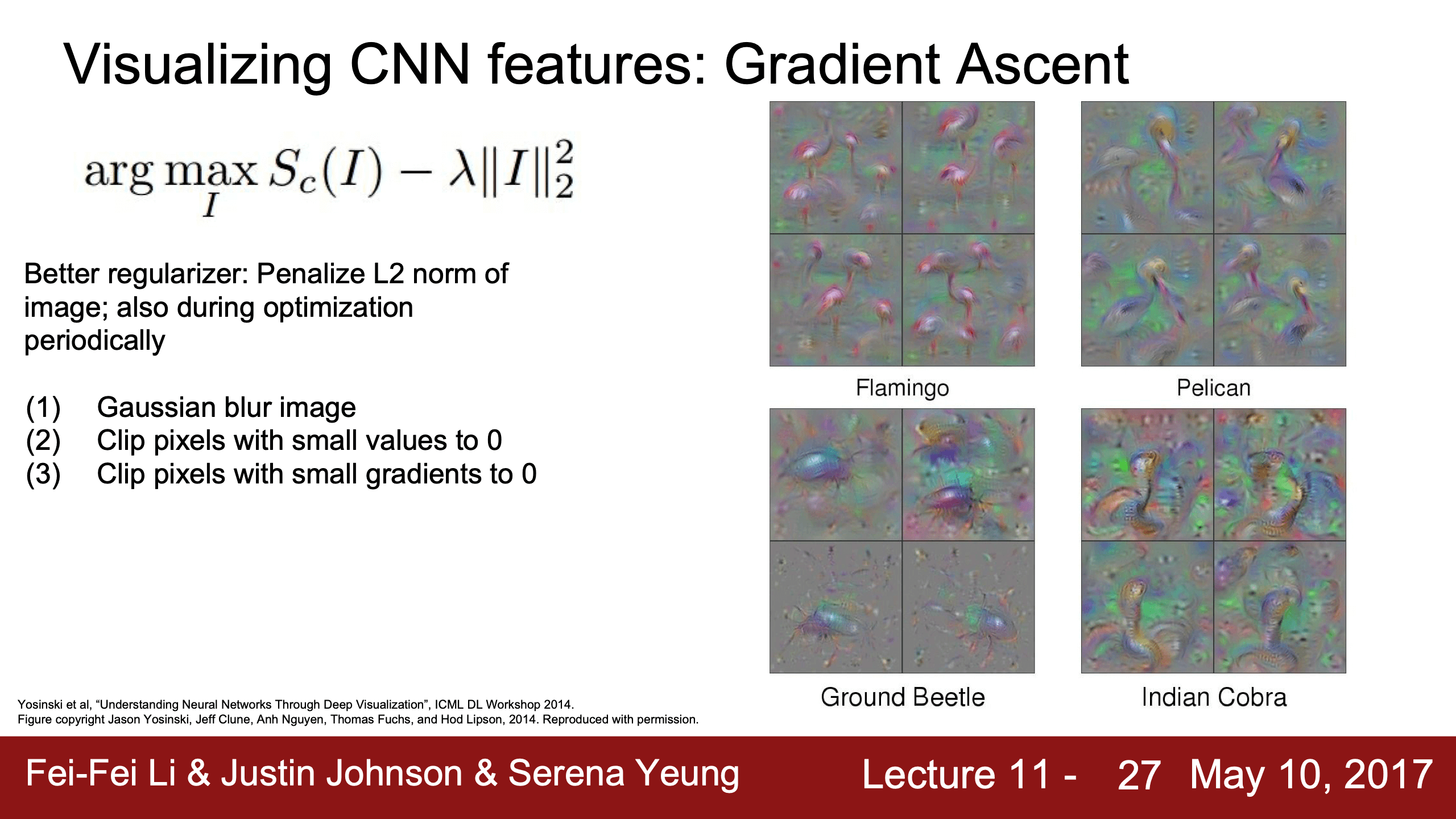

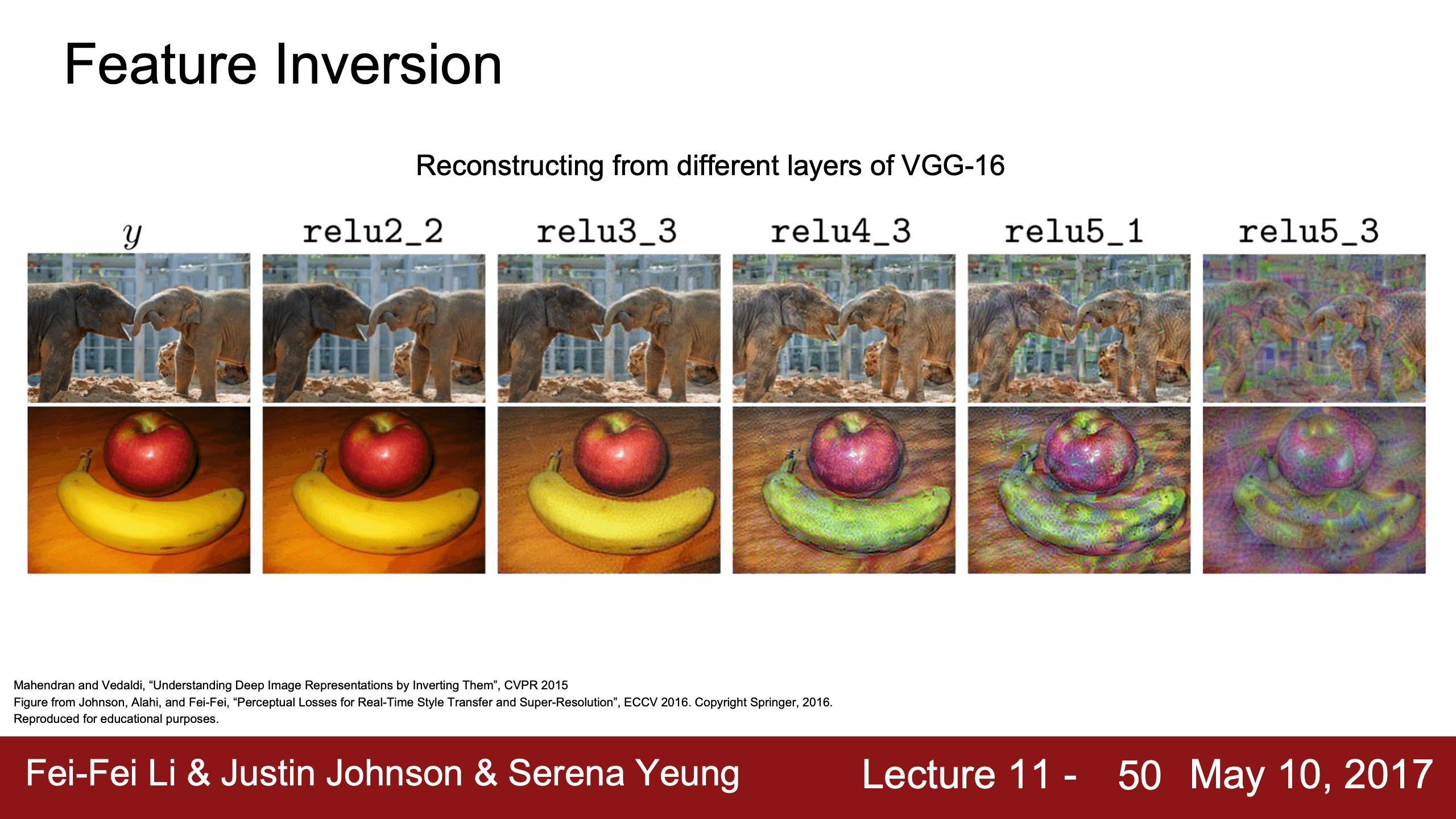

- Lecture 11

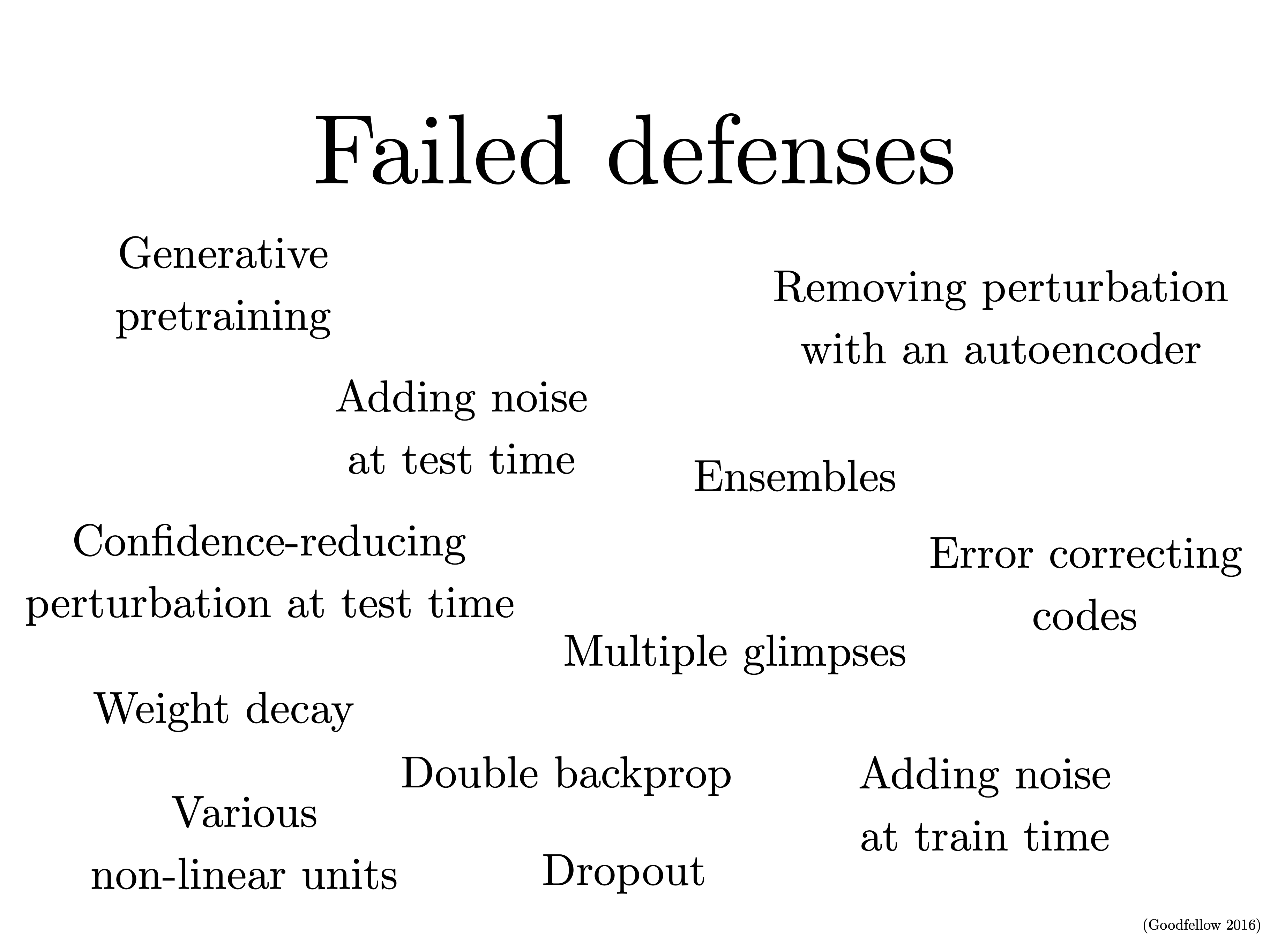

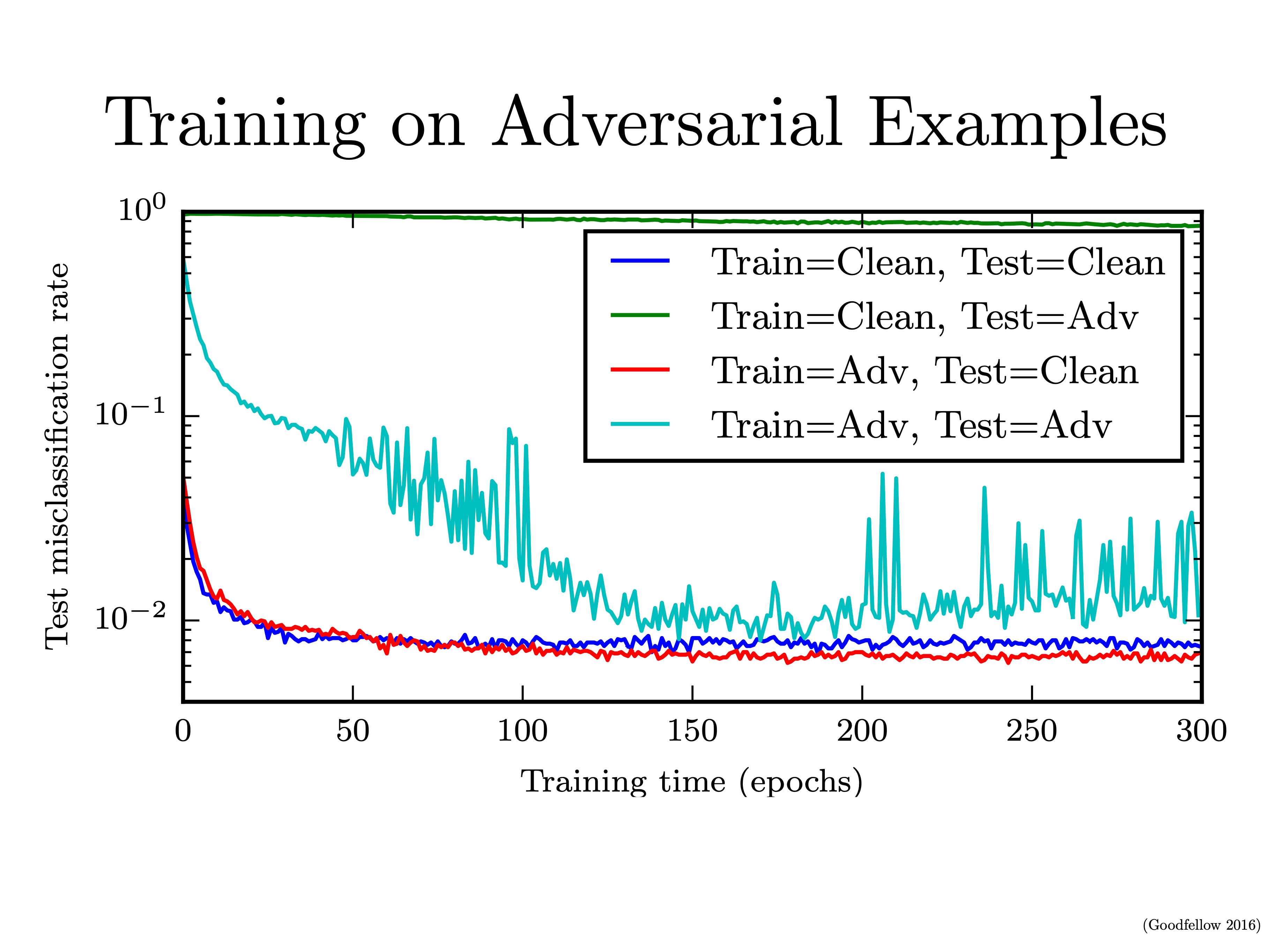

- Lecture 12

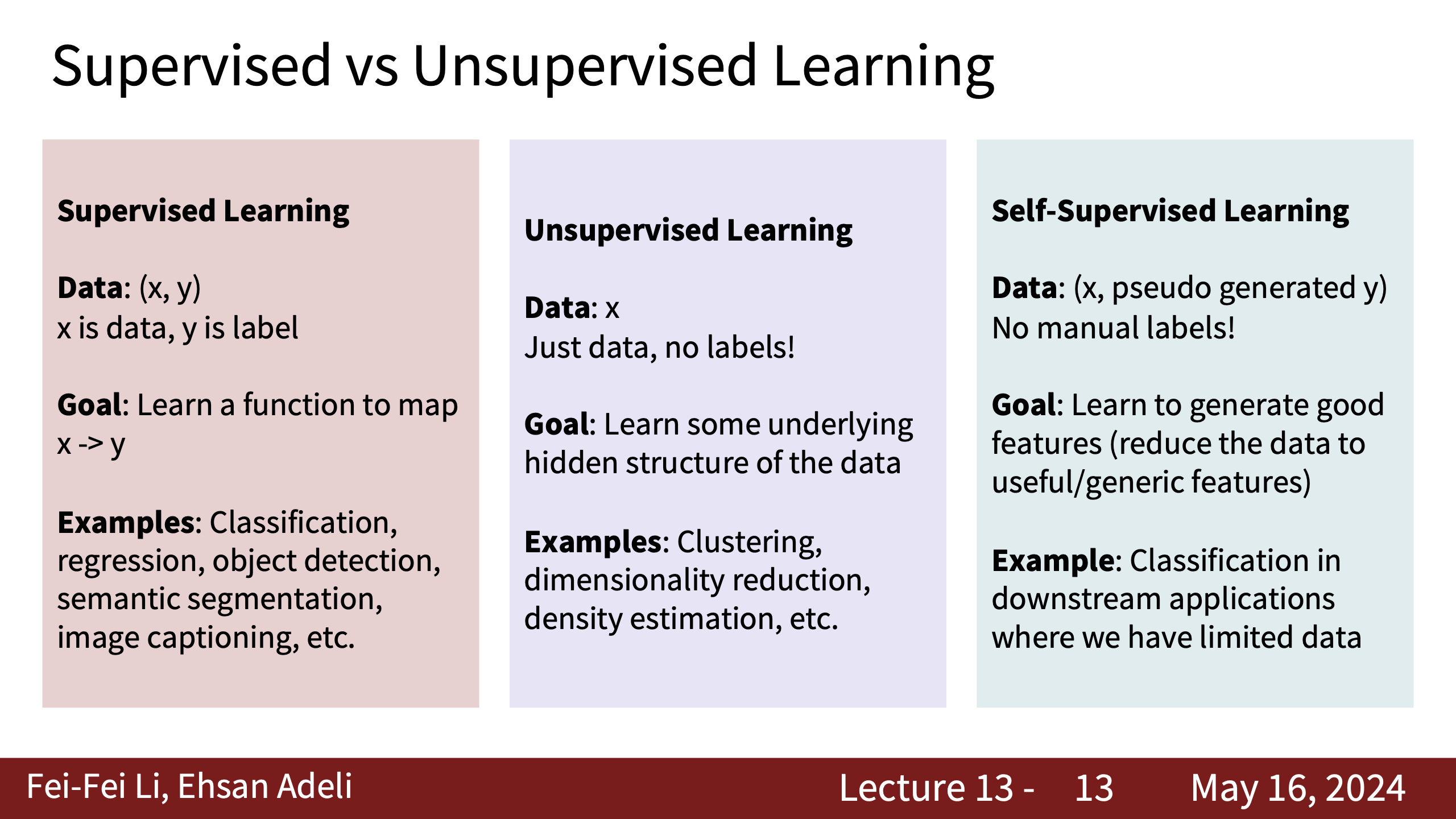

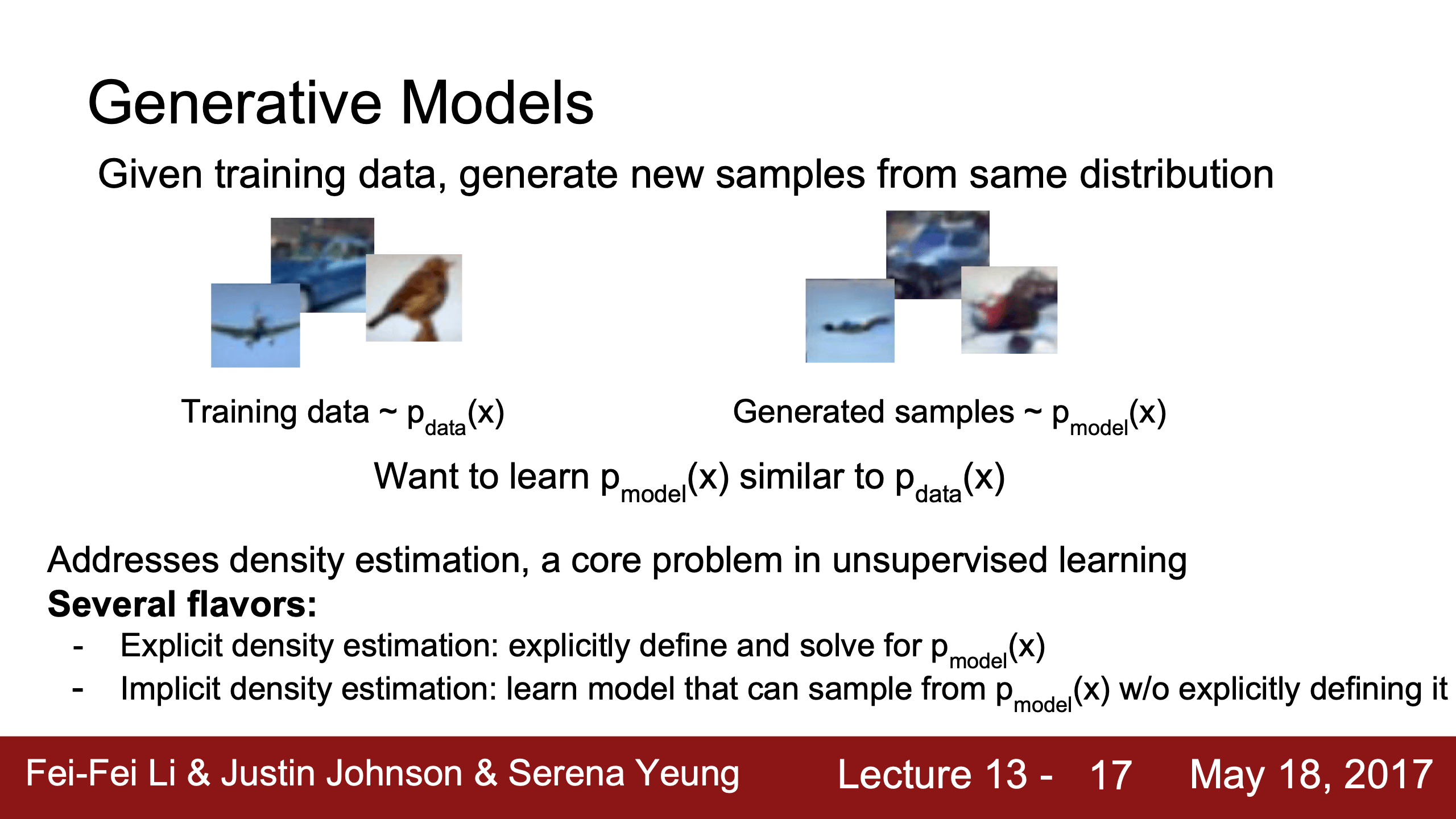

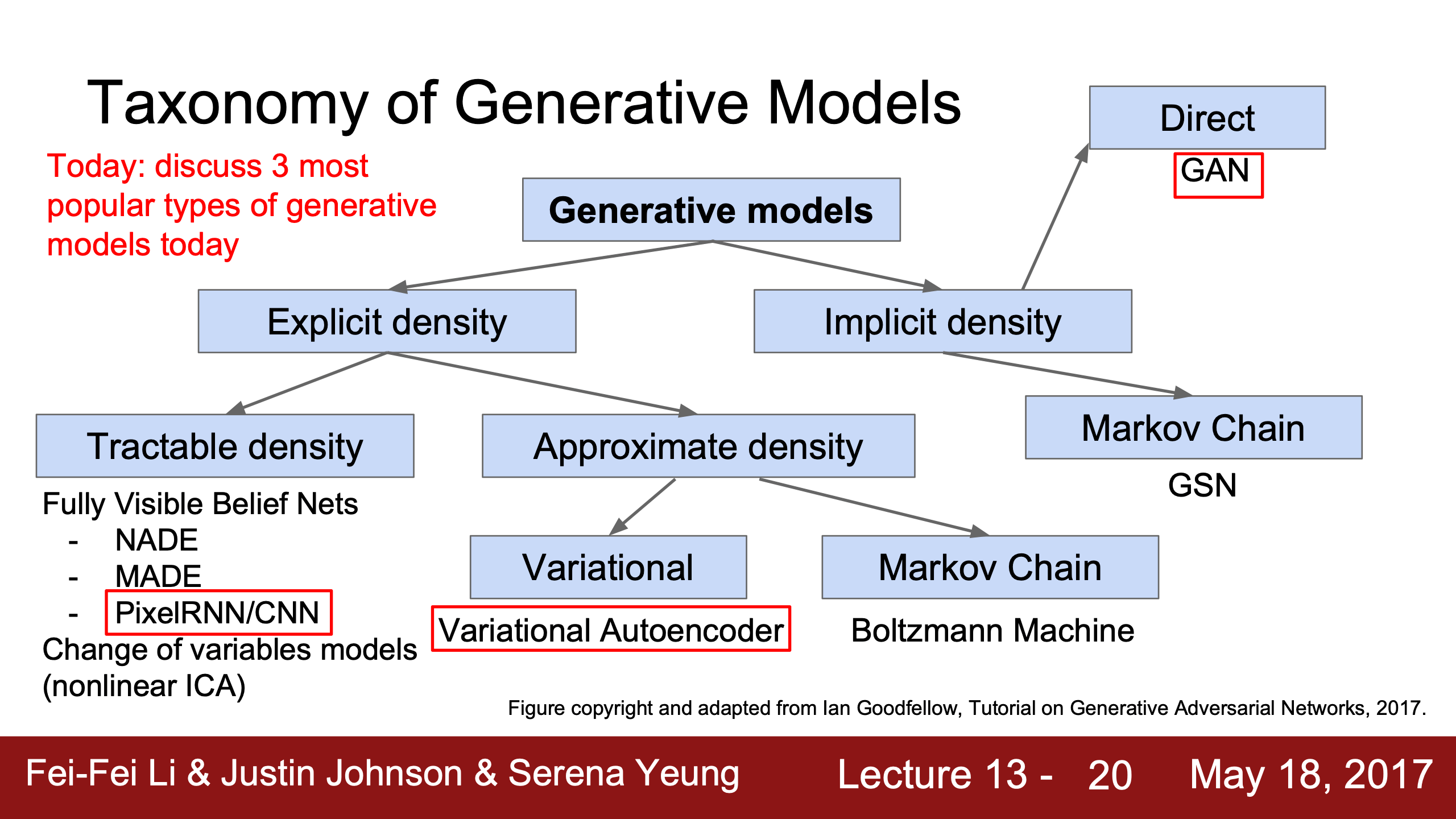

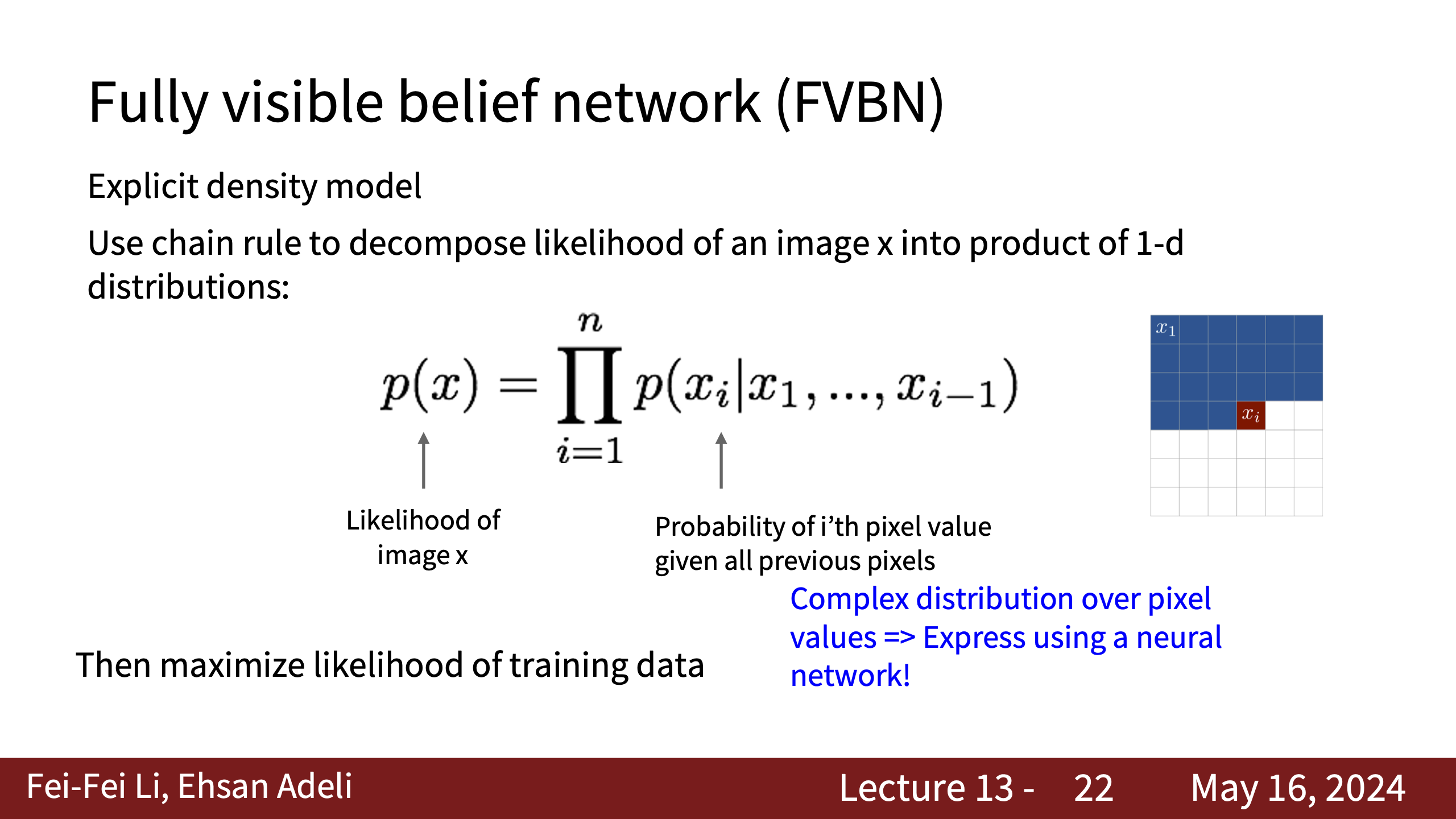

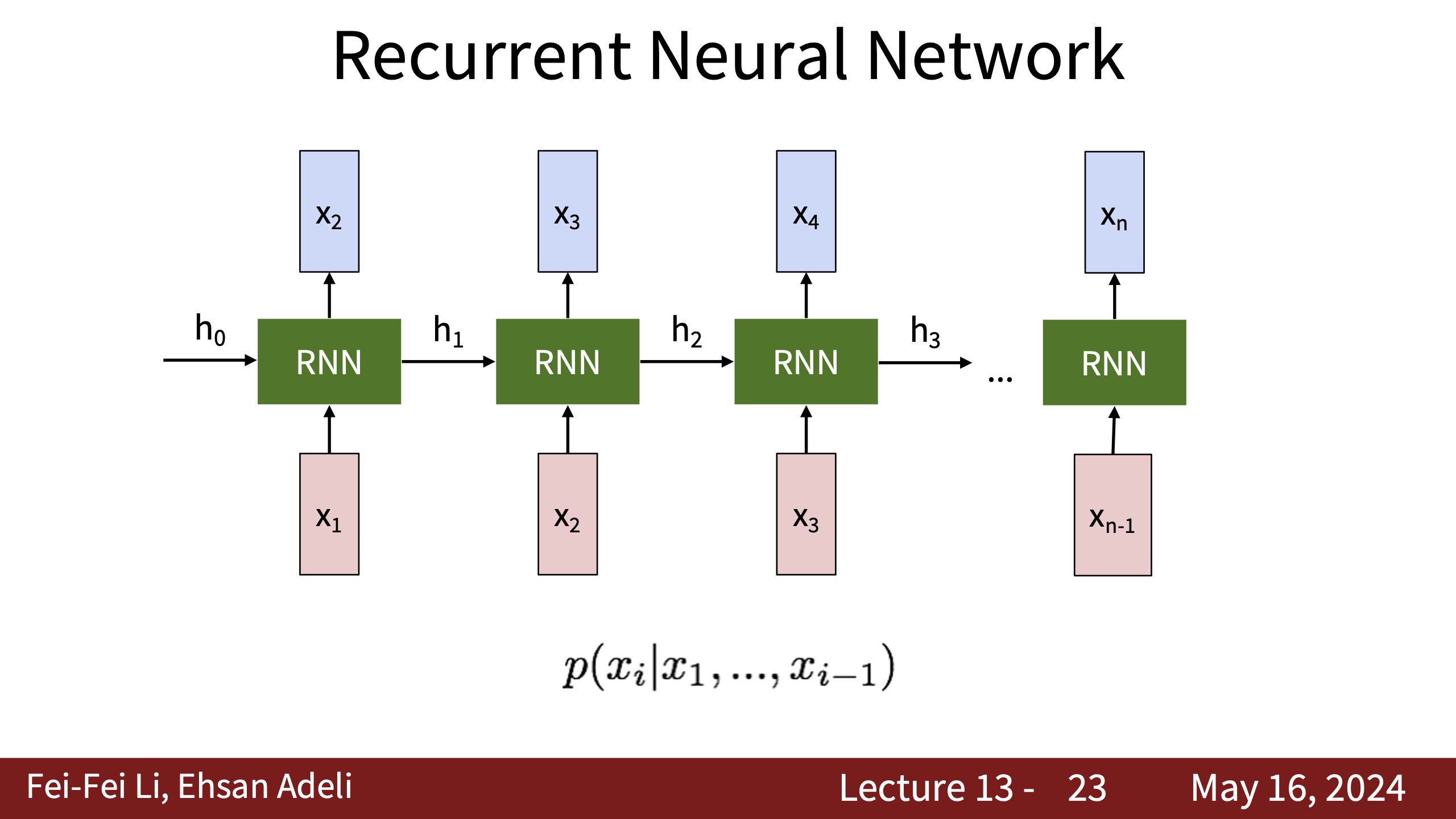

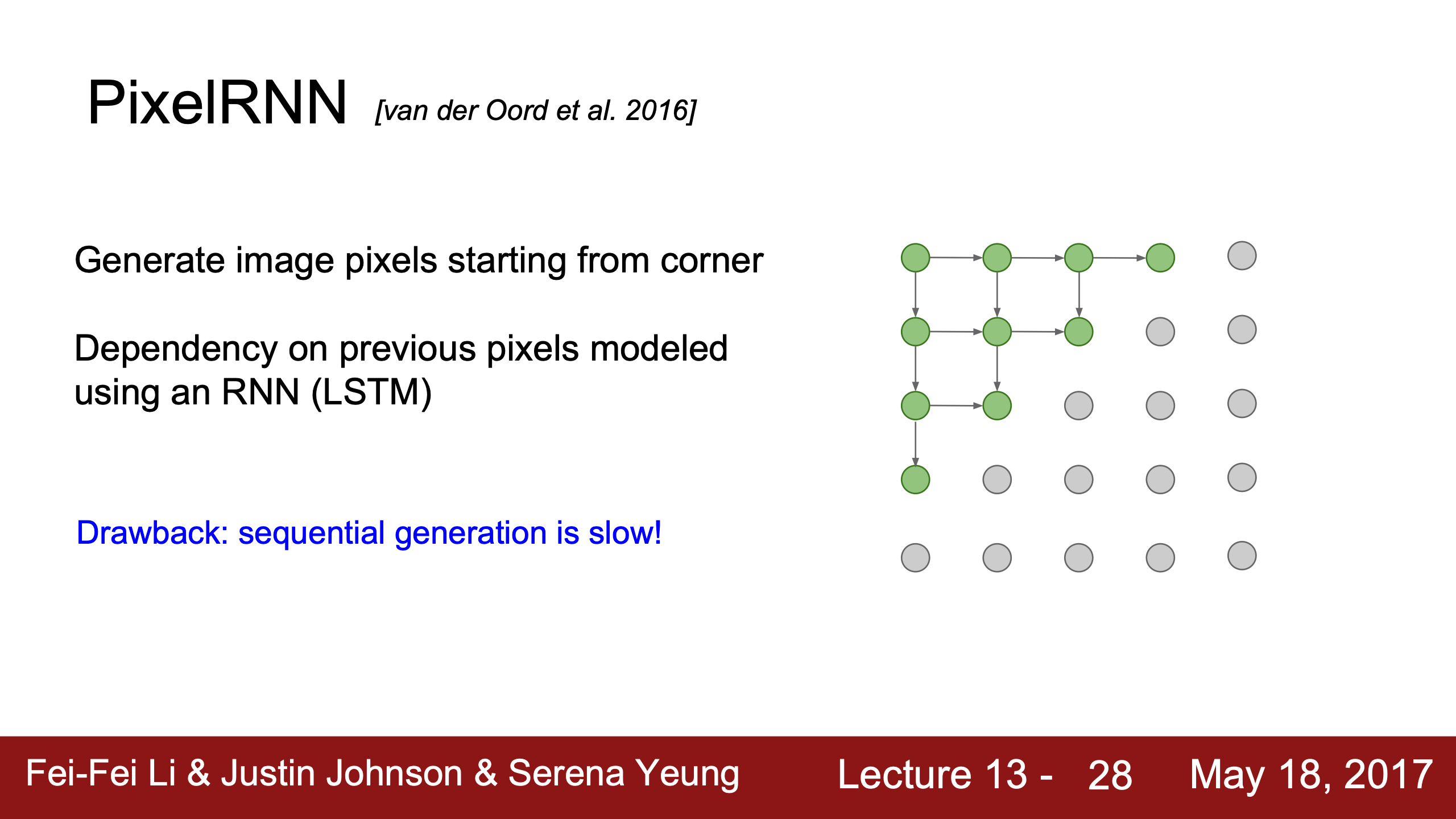

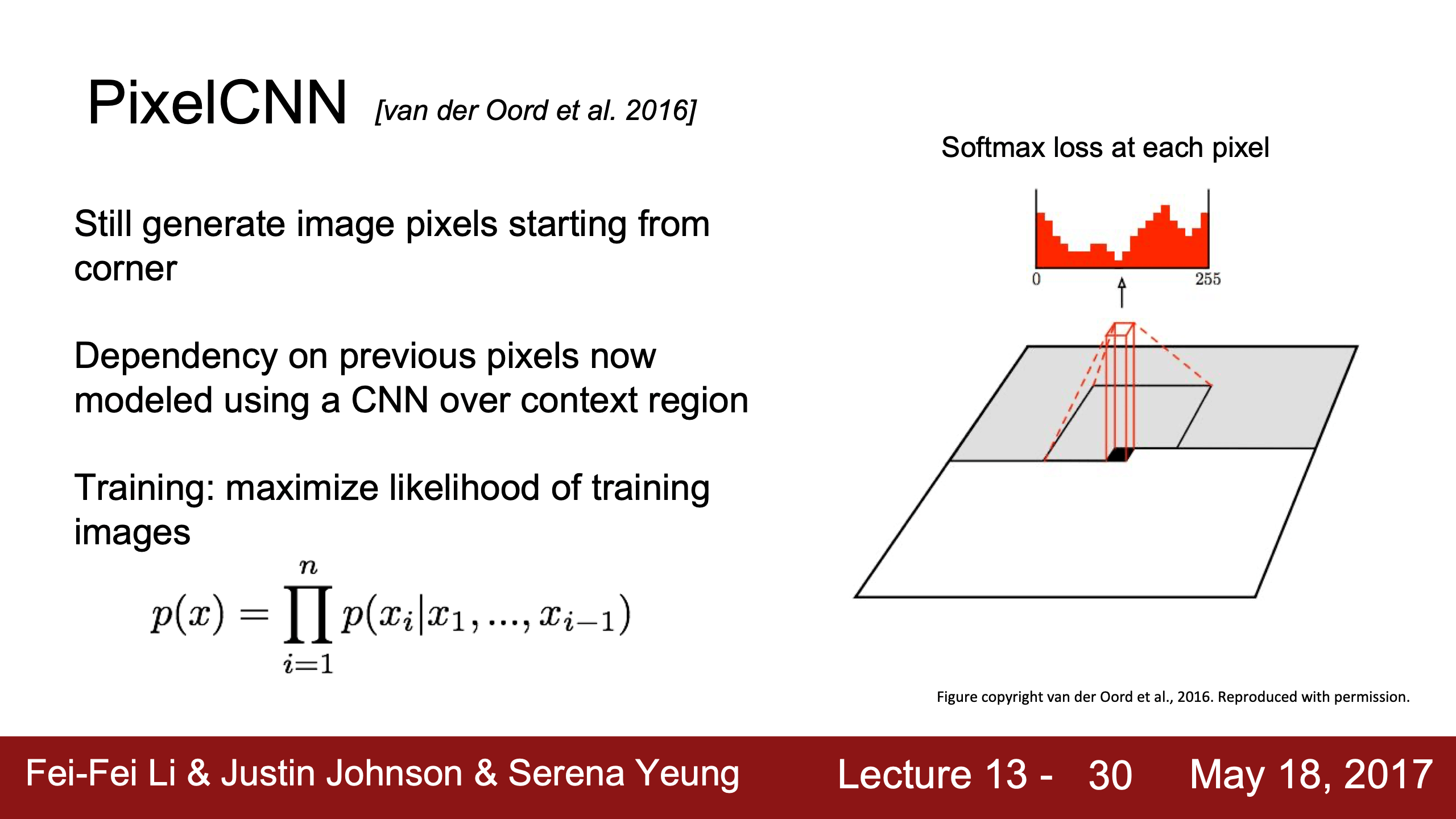

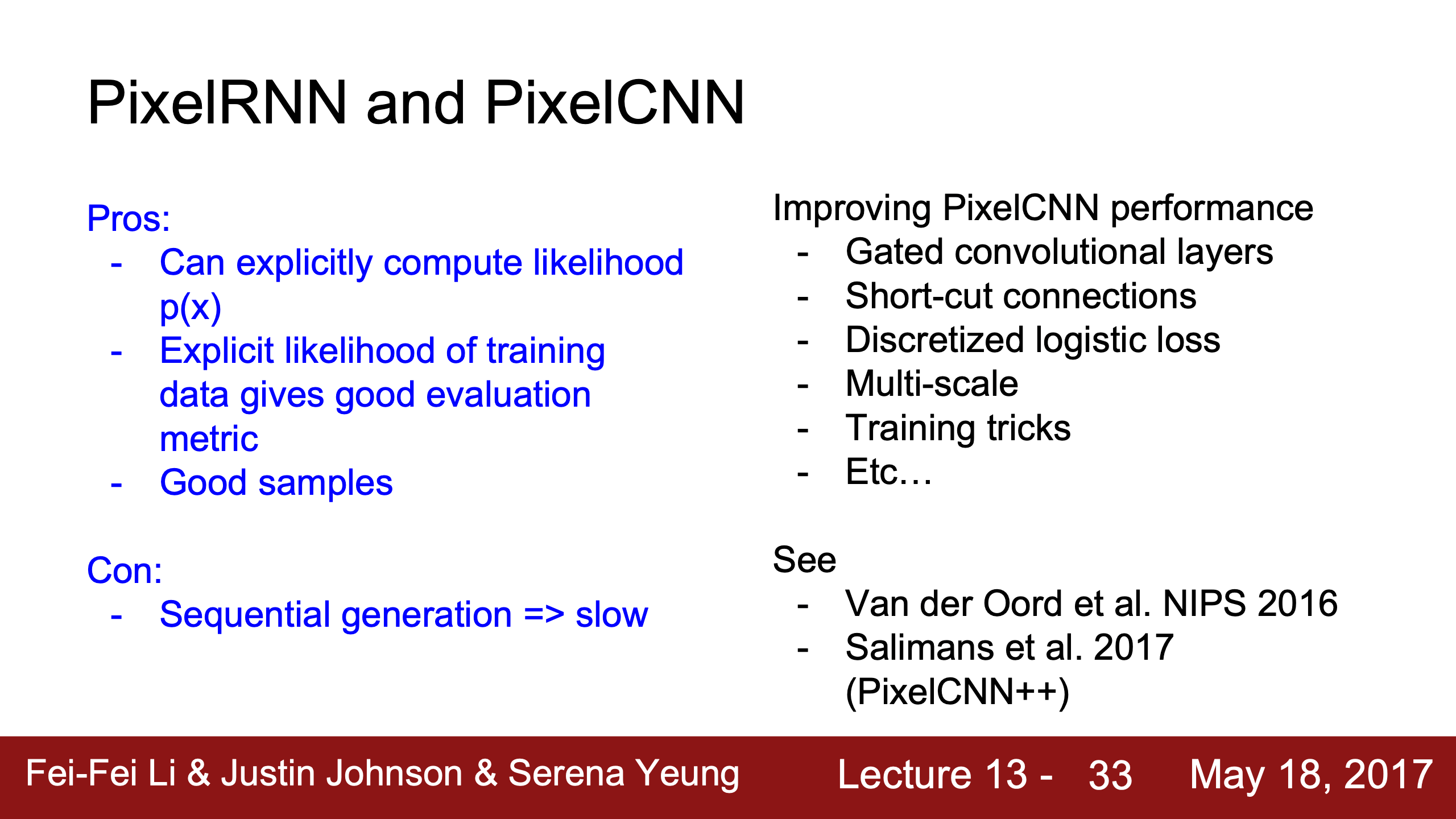

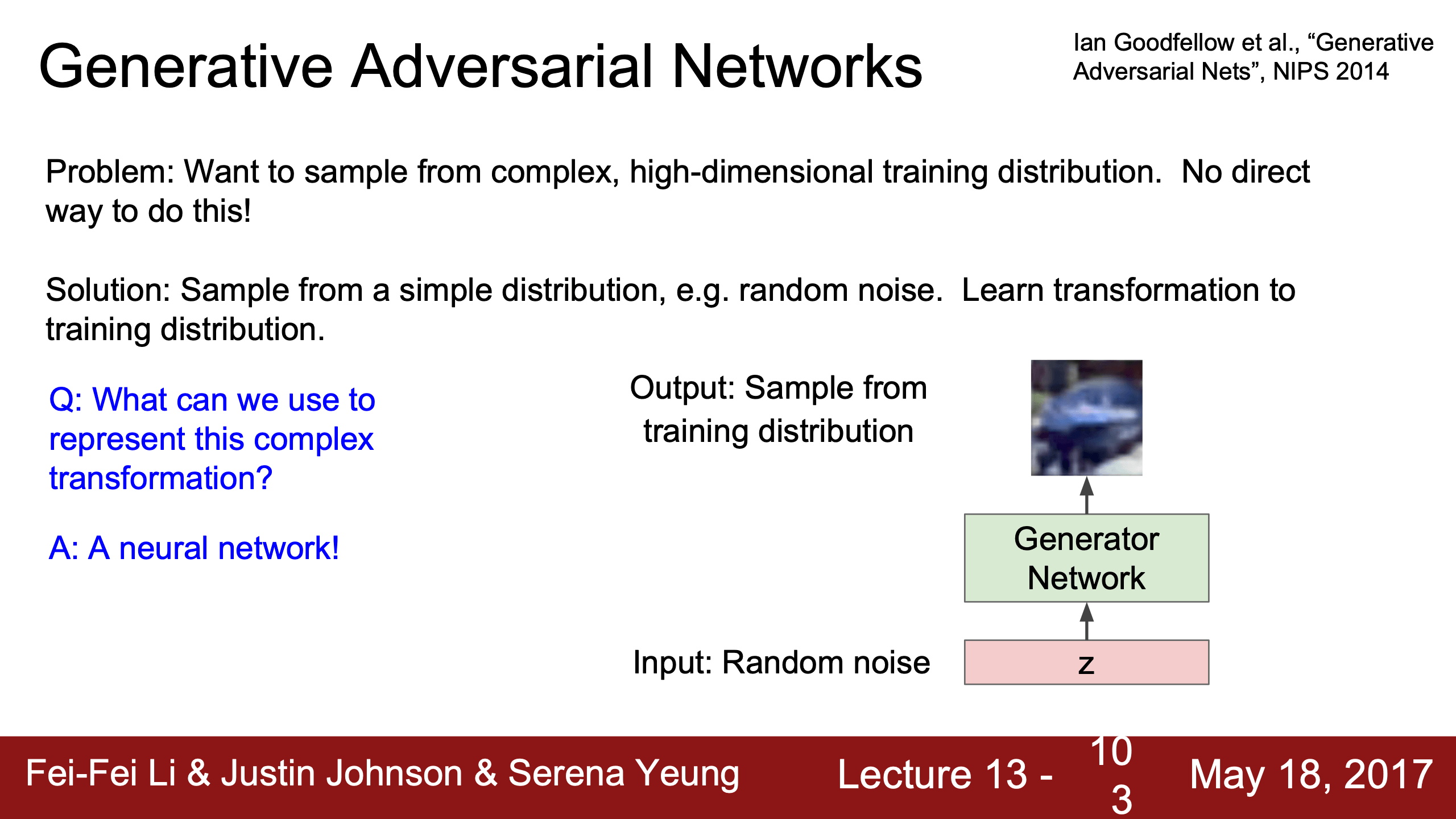

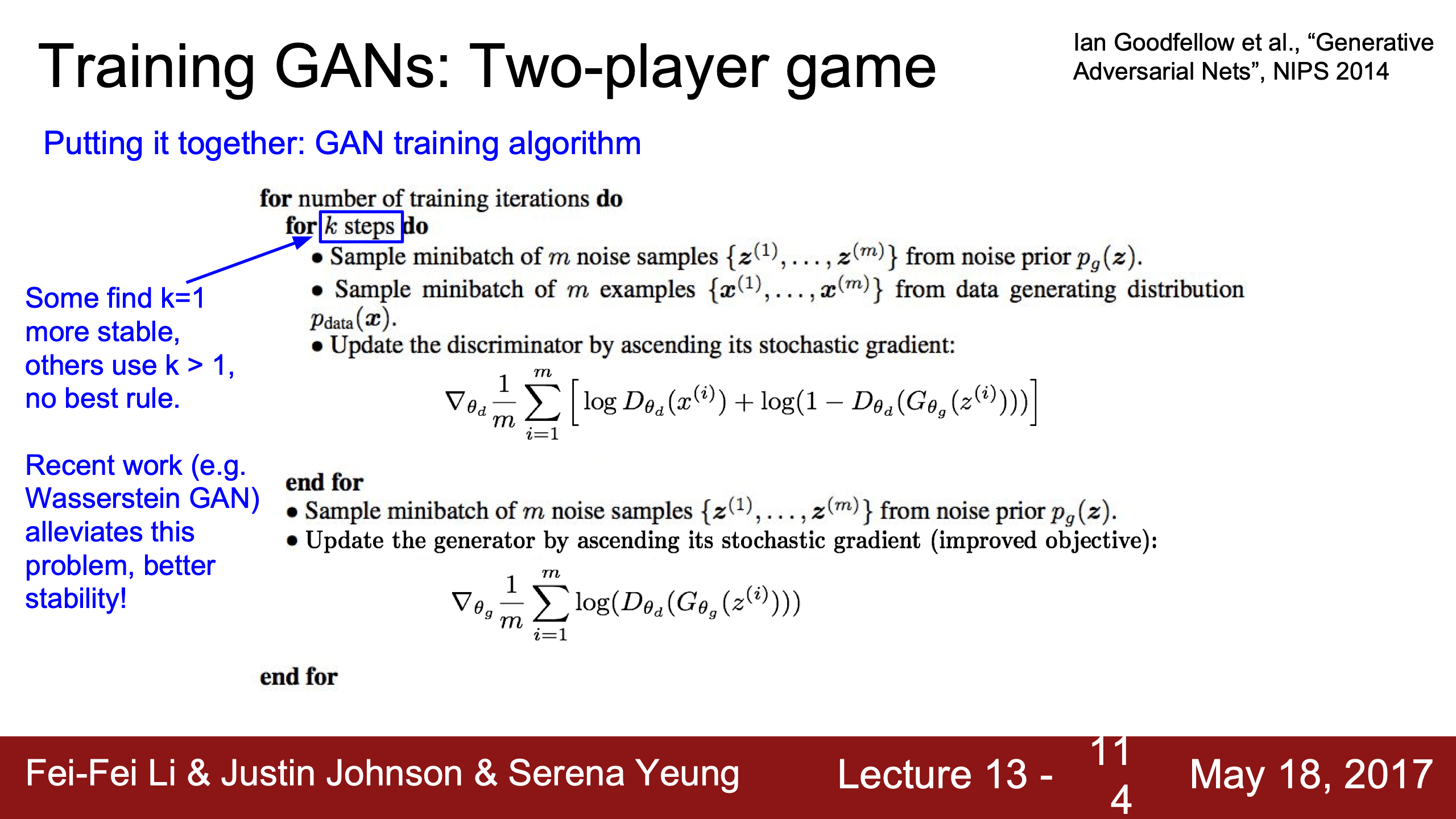

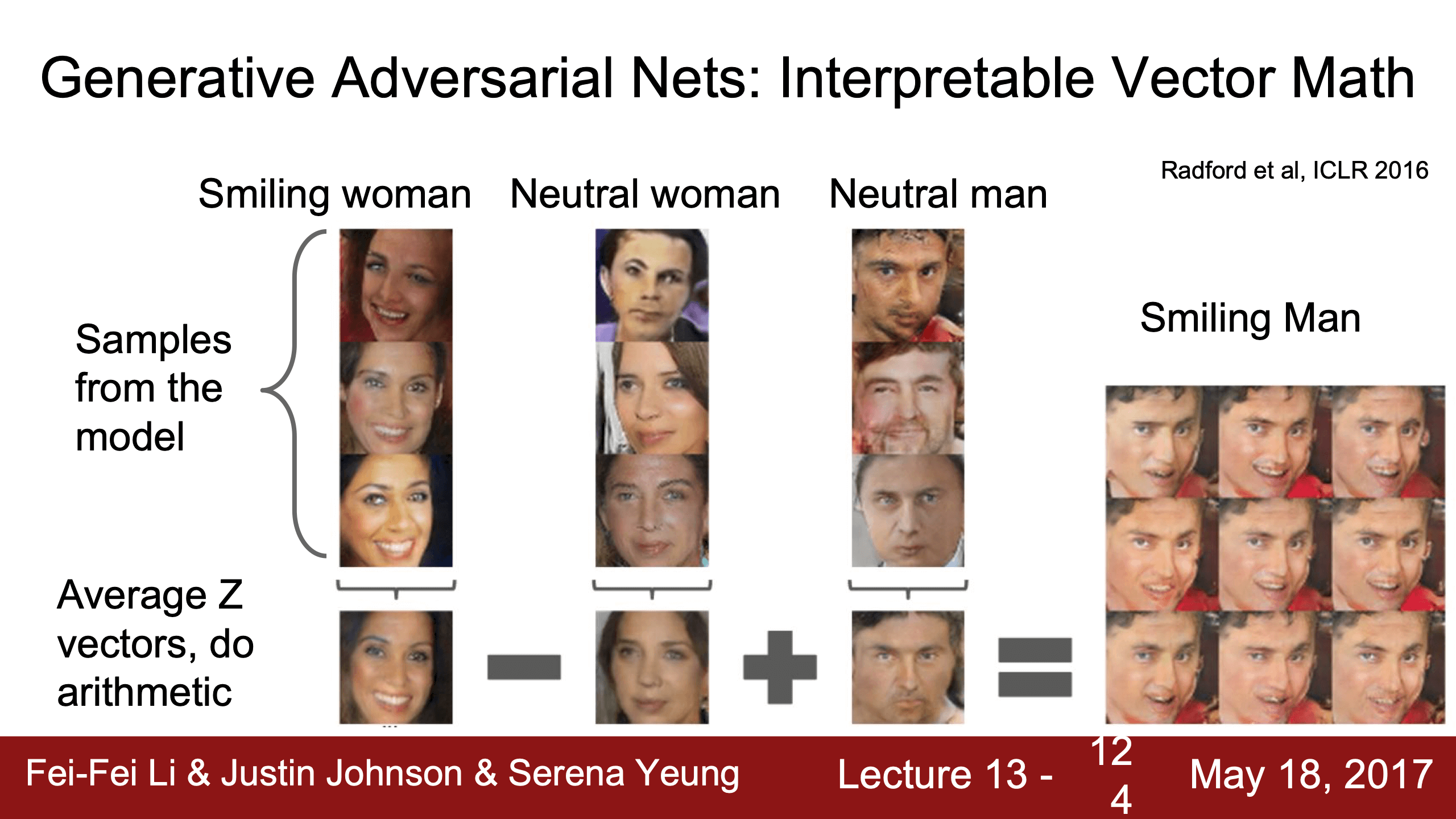

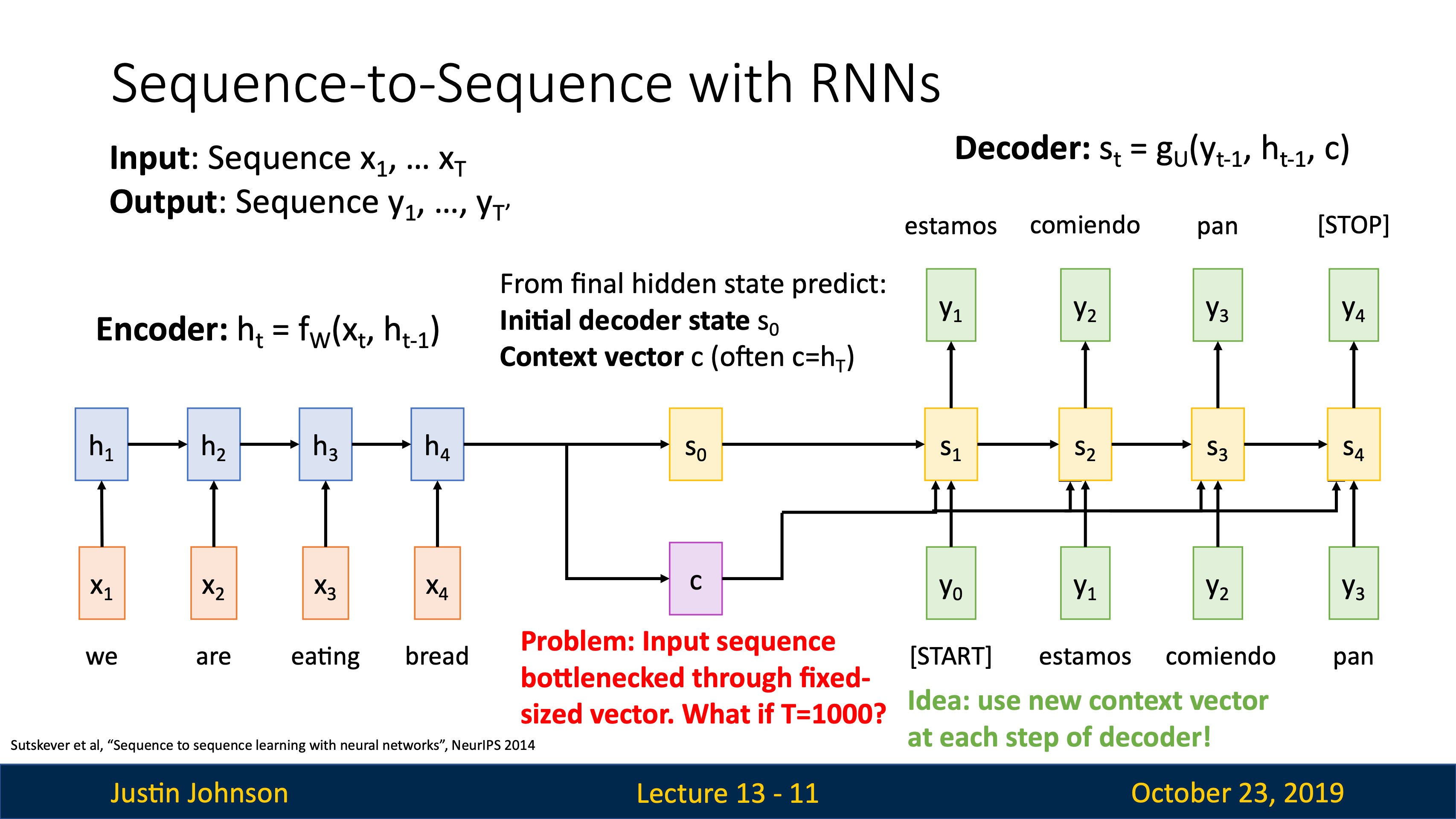

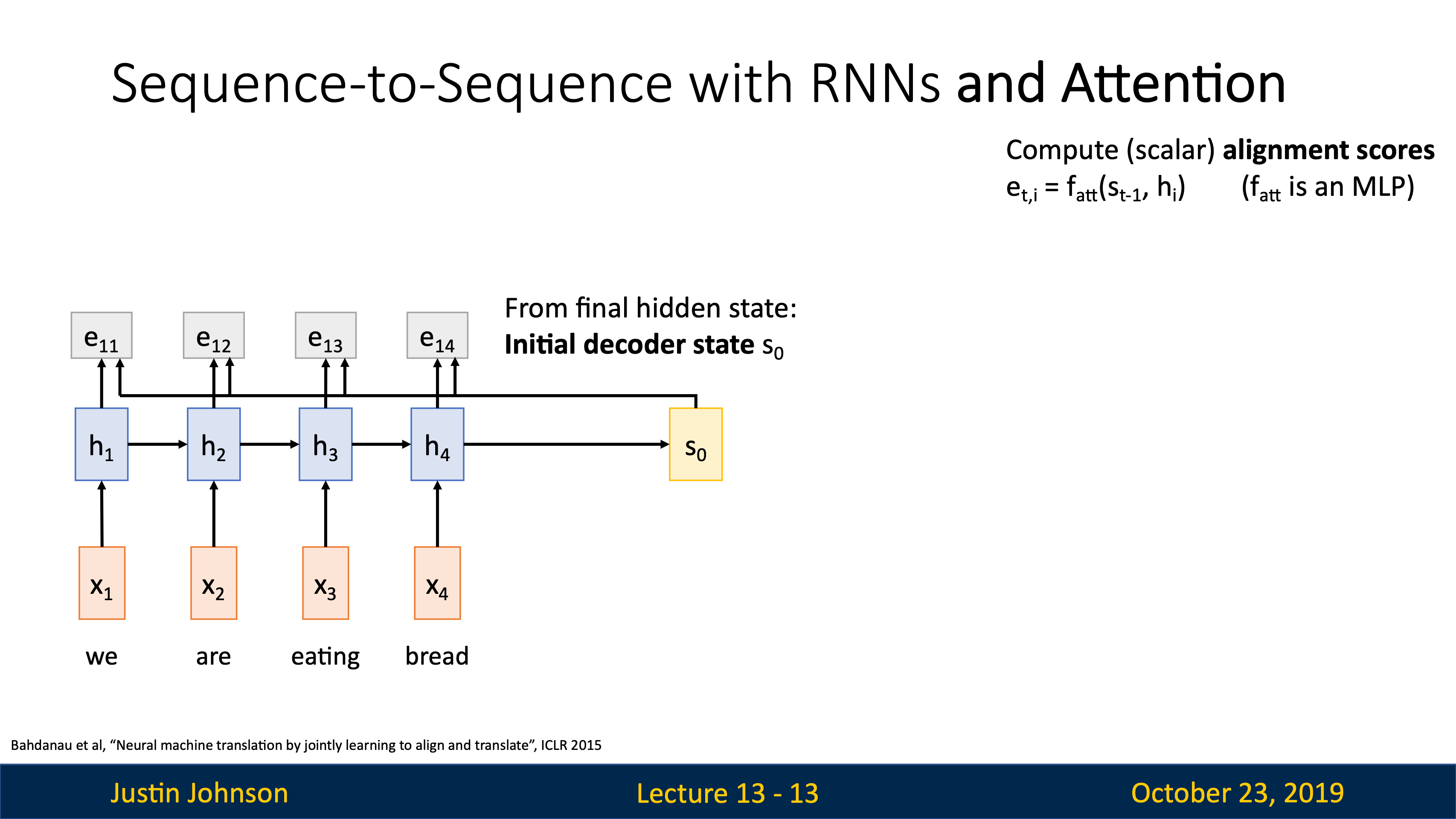

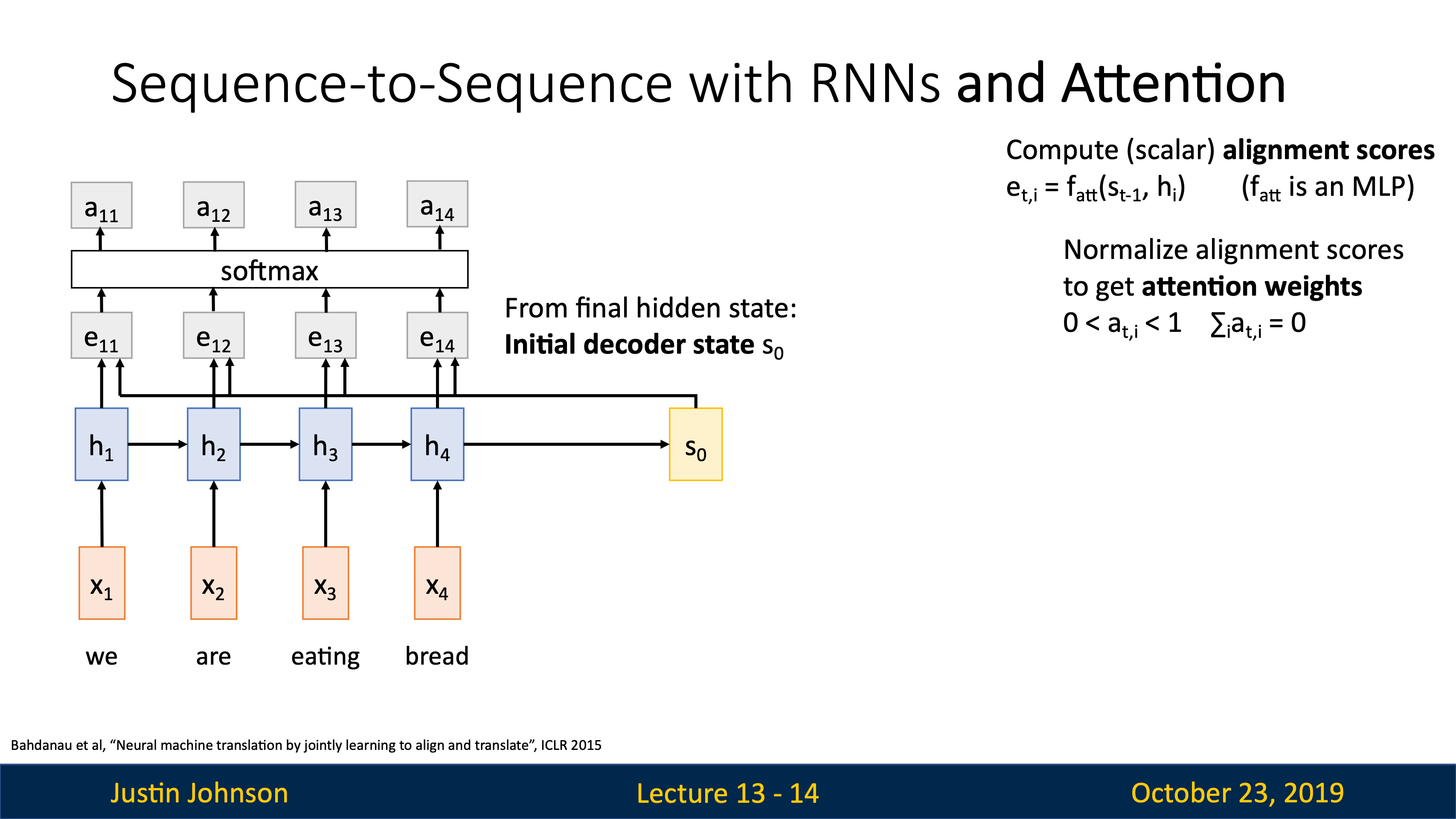

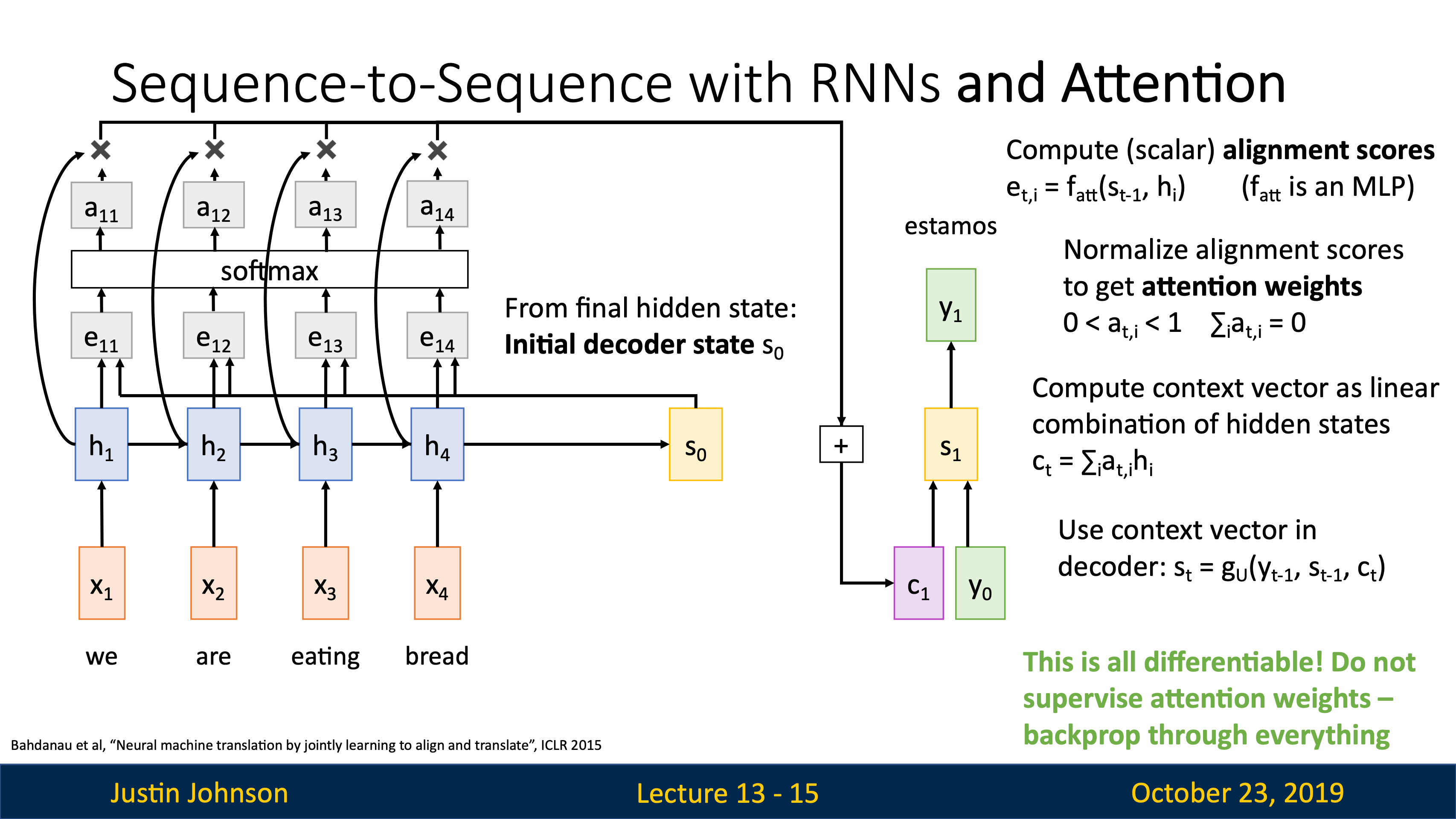

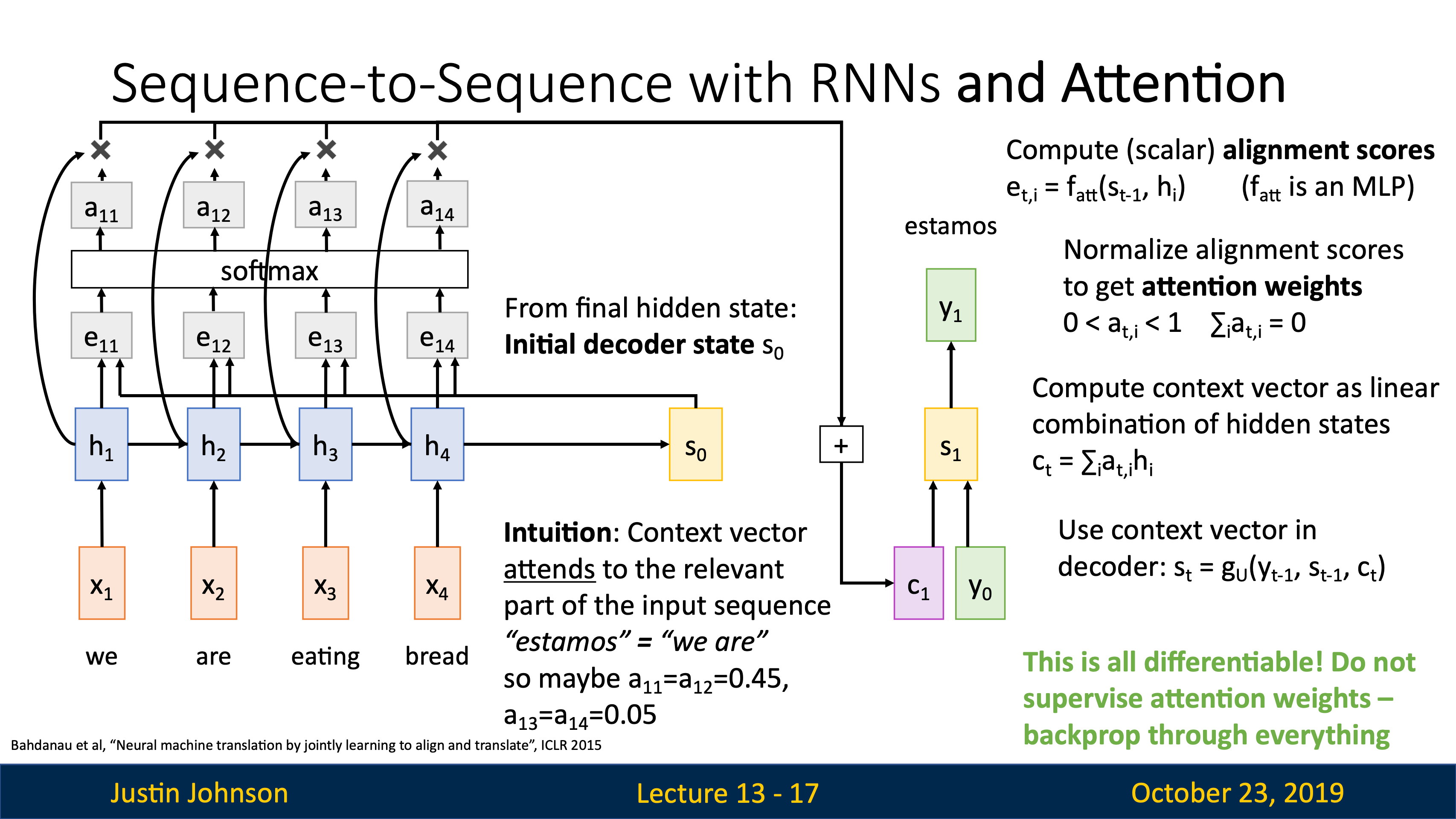

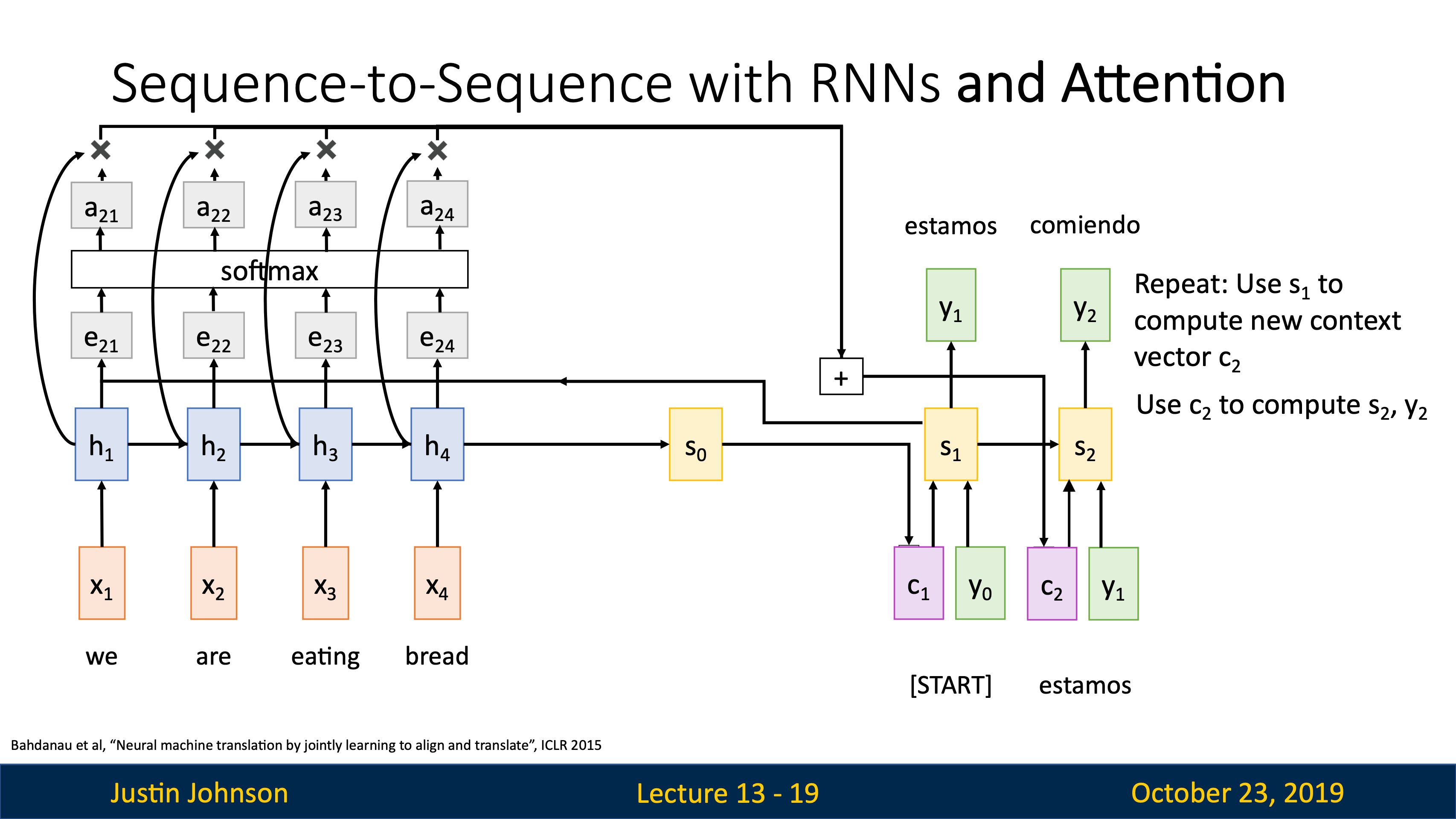

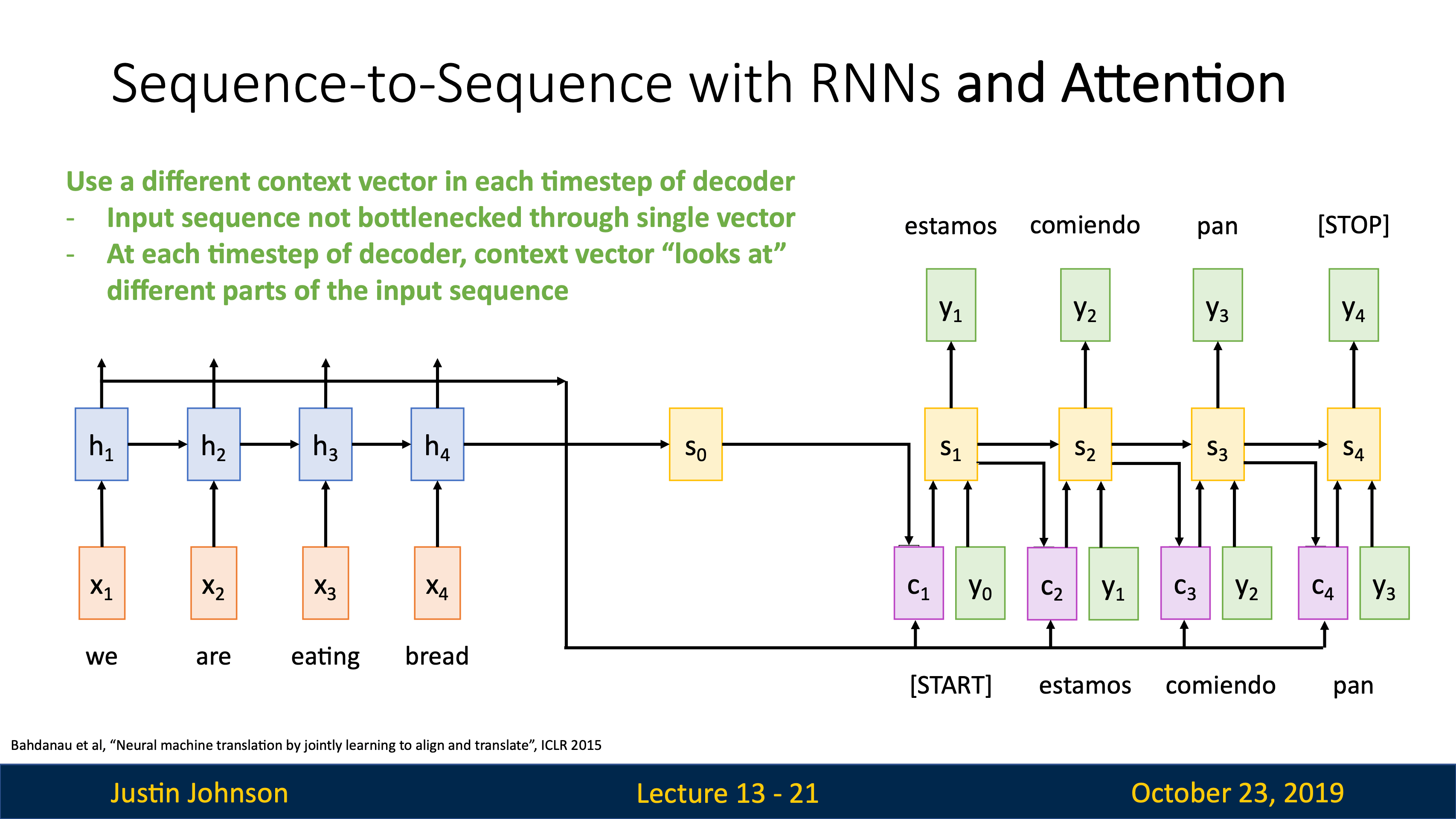

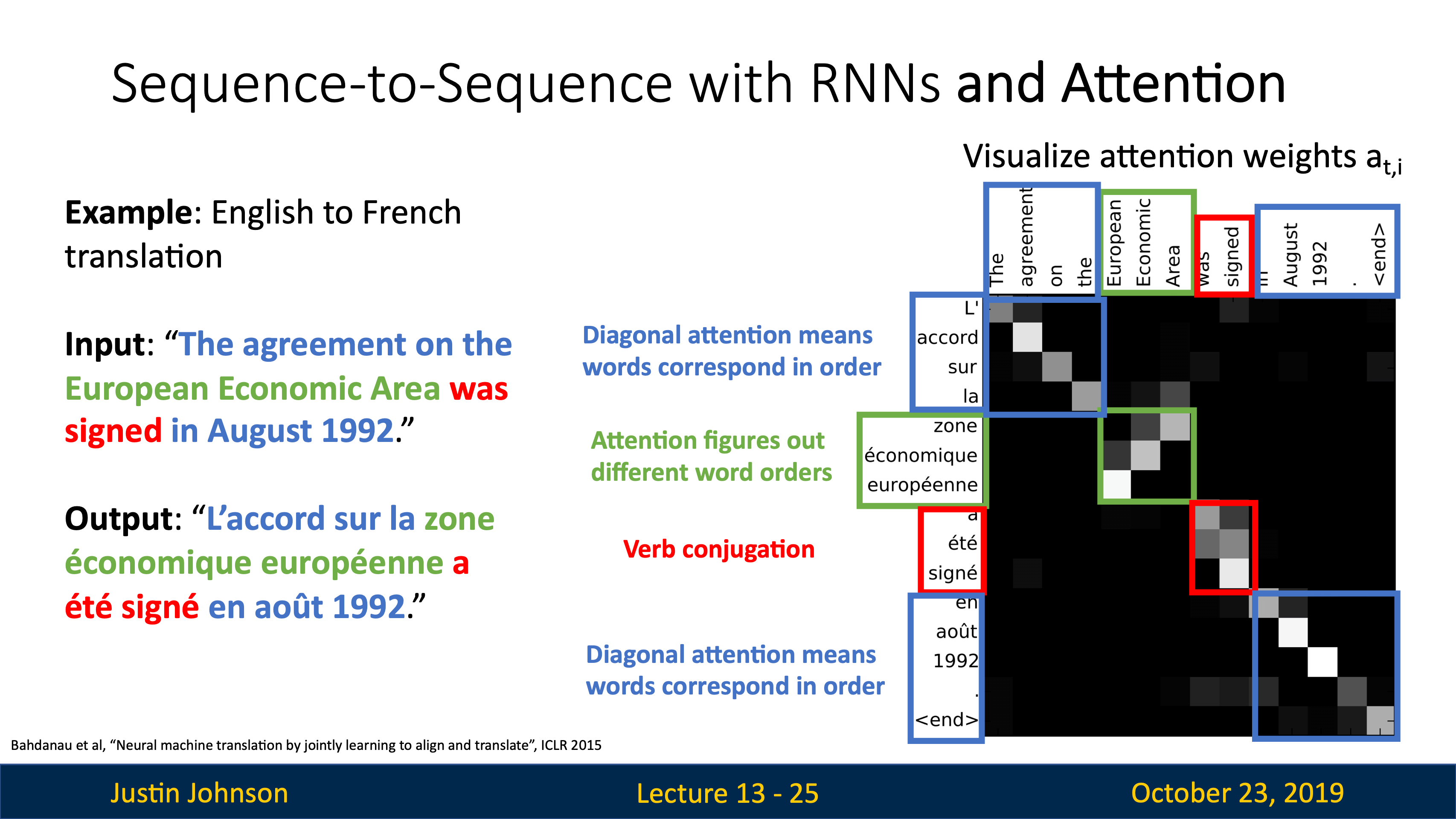

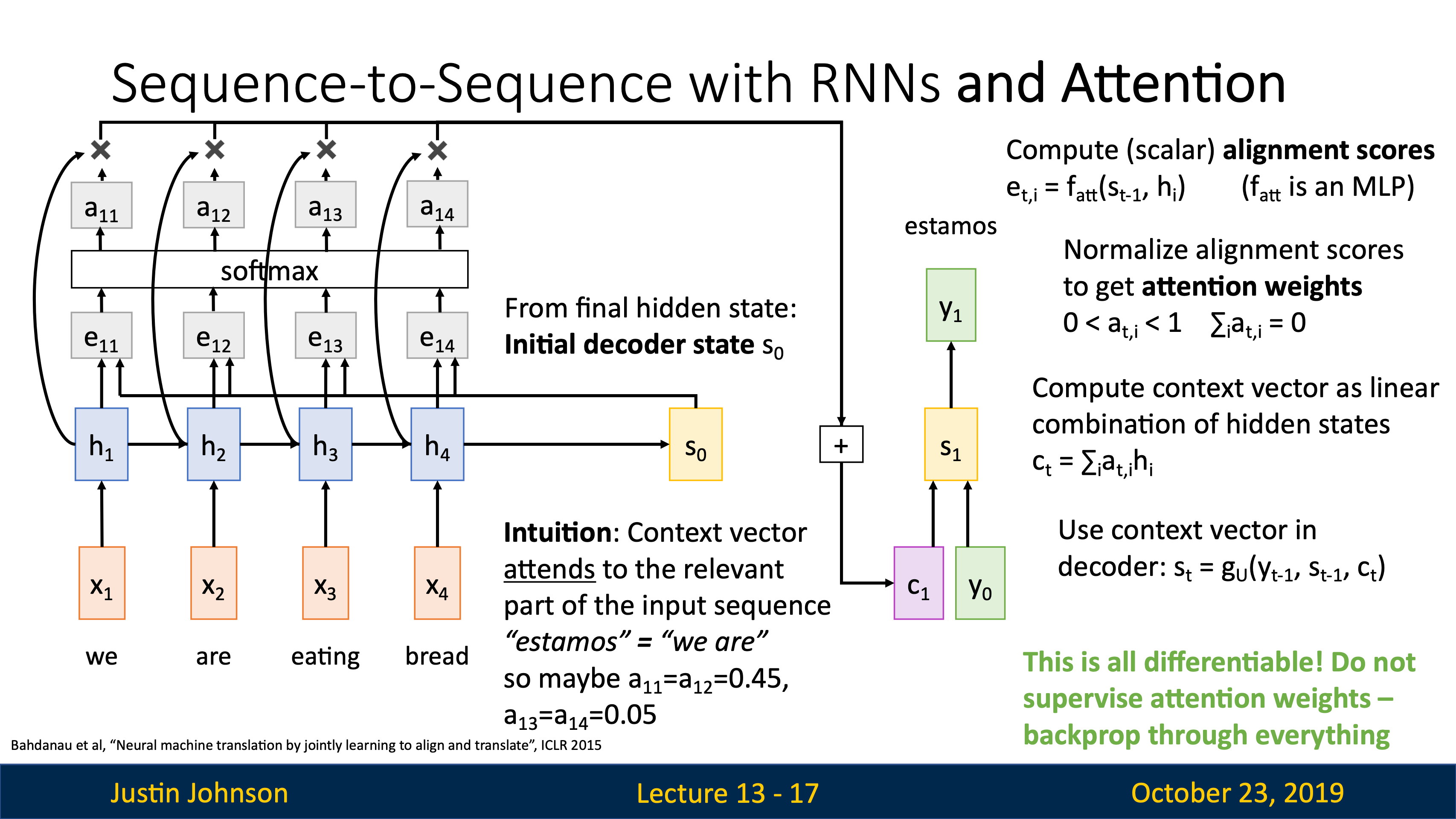

- Lecture 13

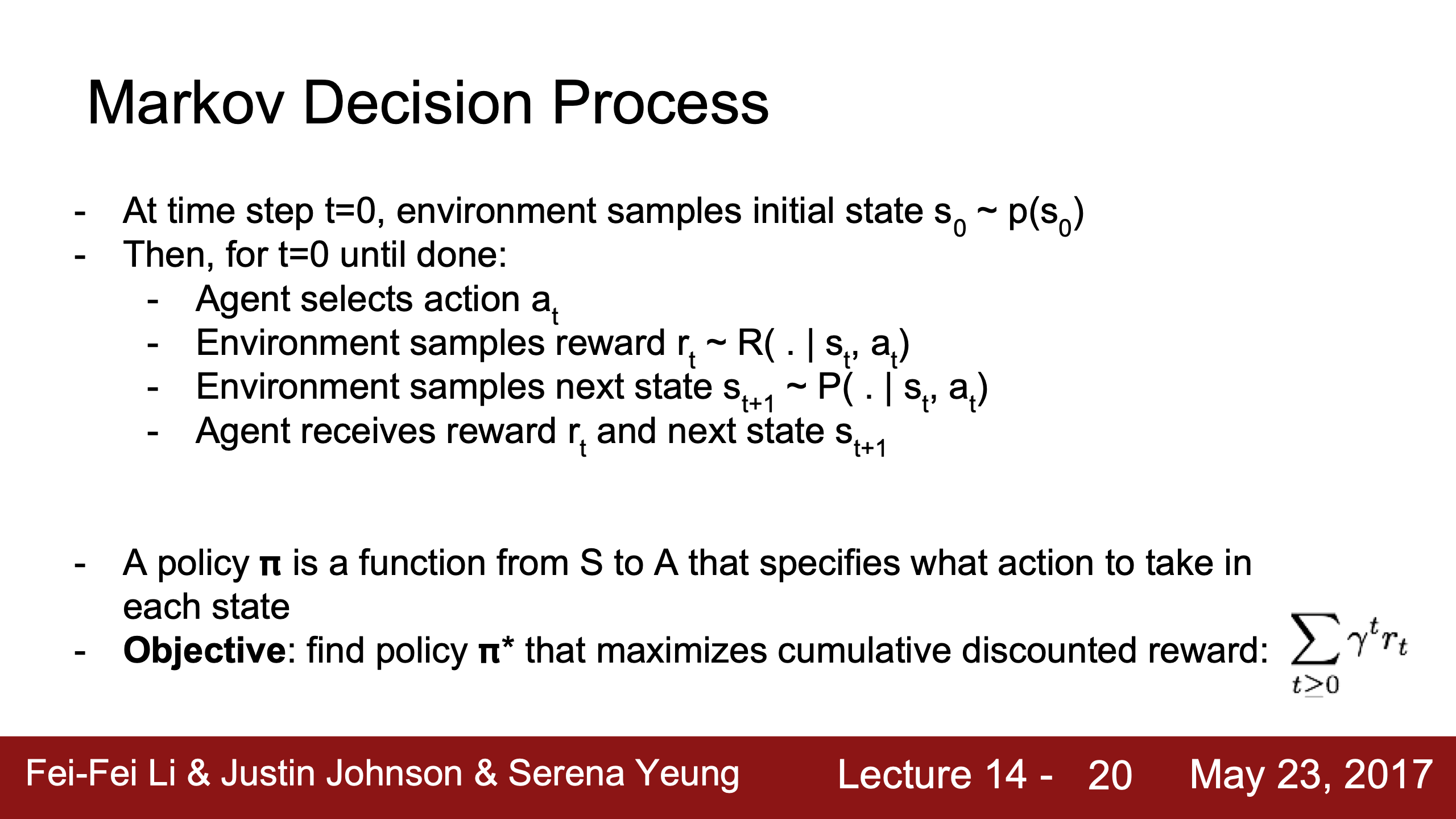

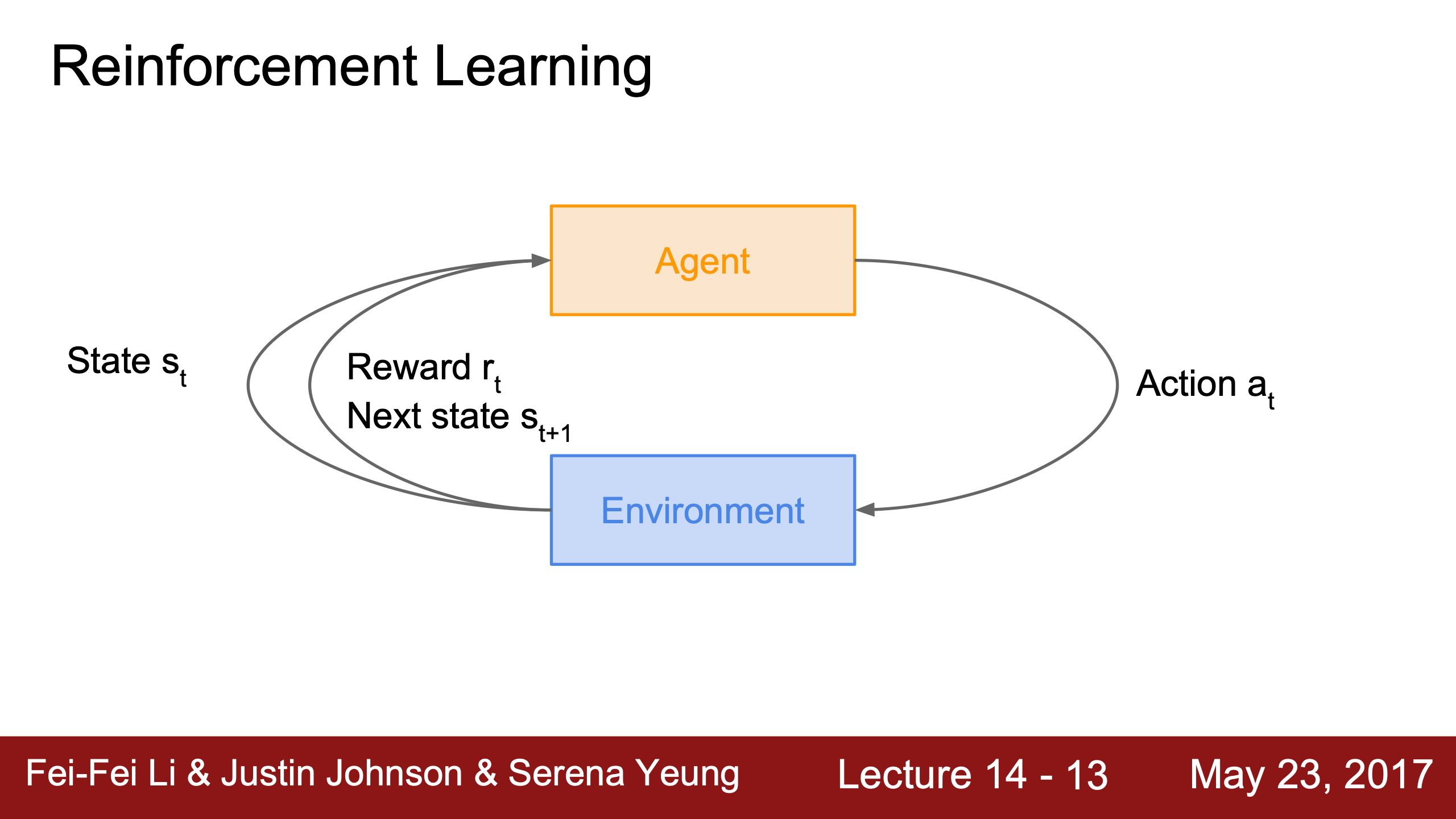

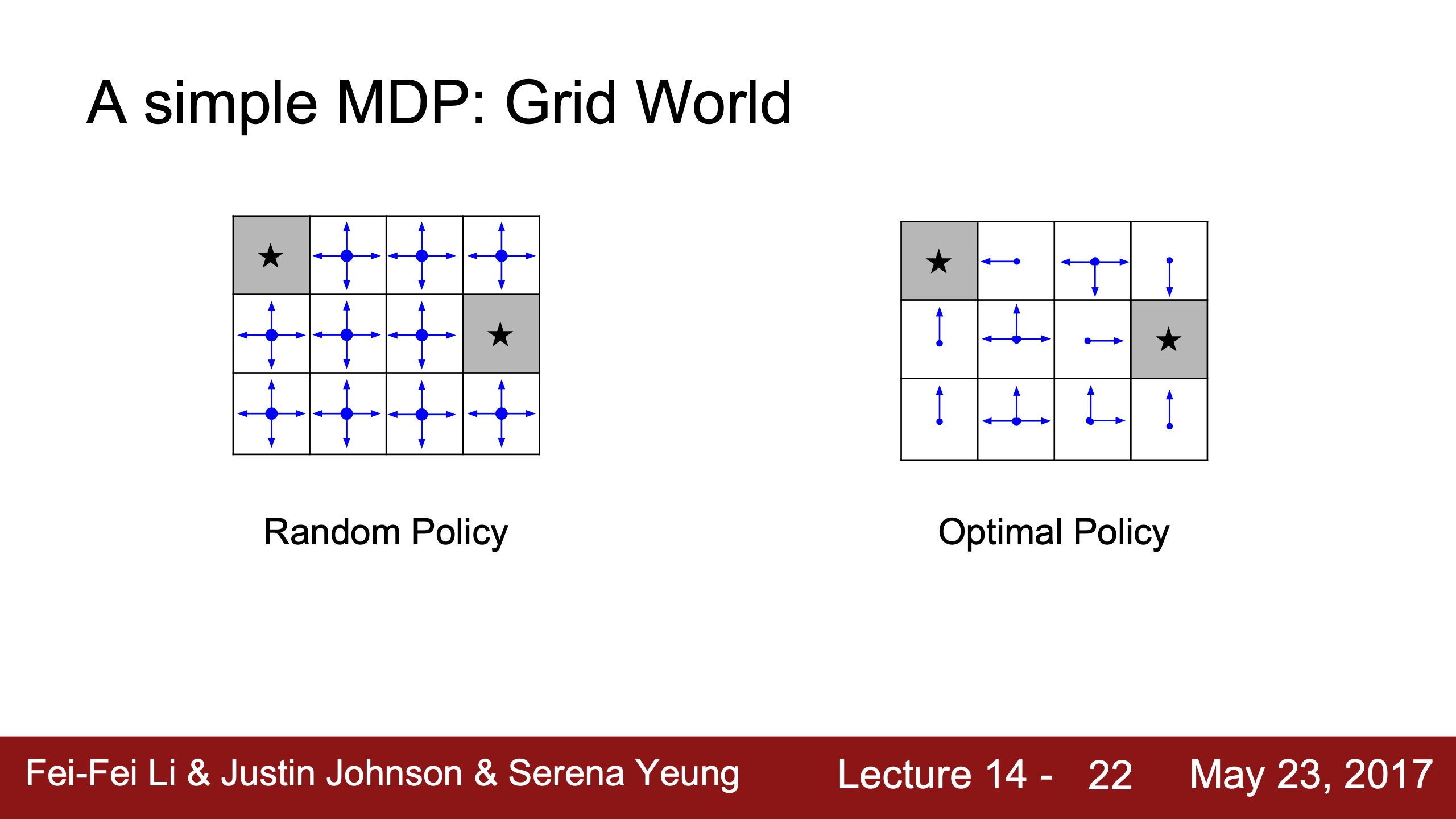

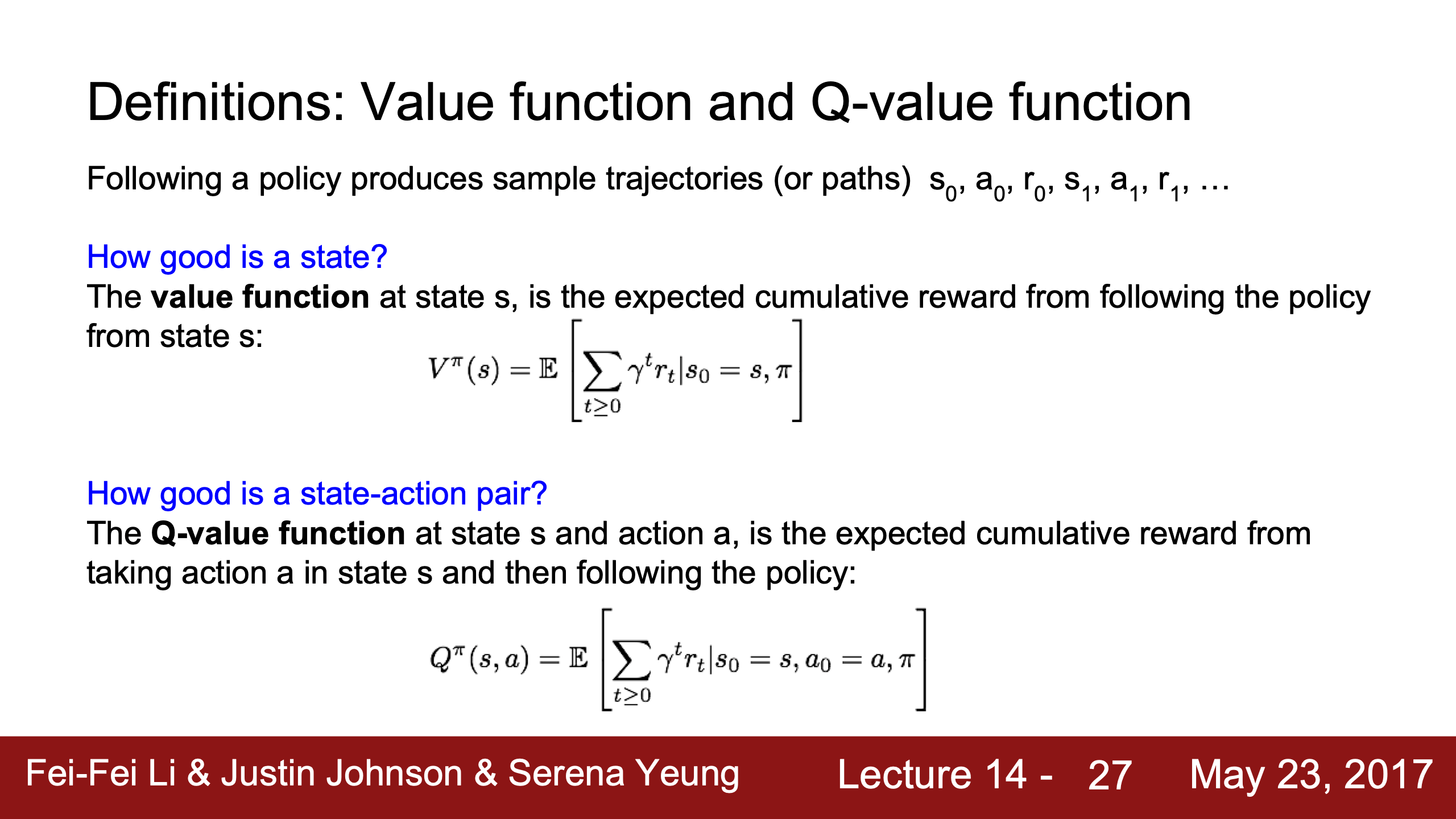

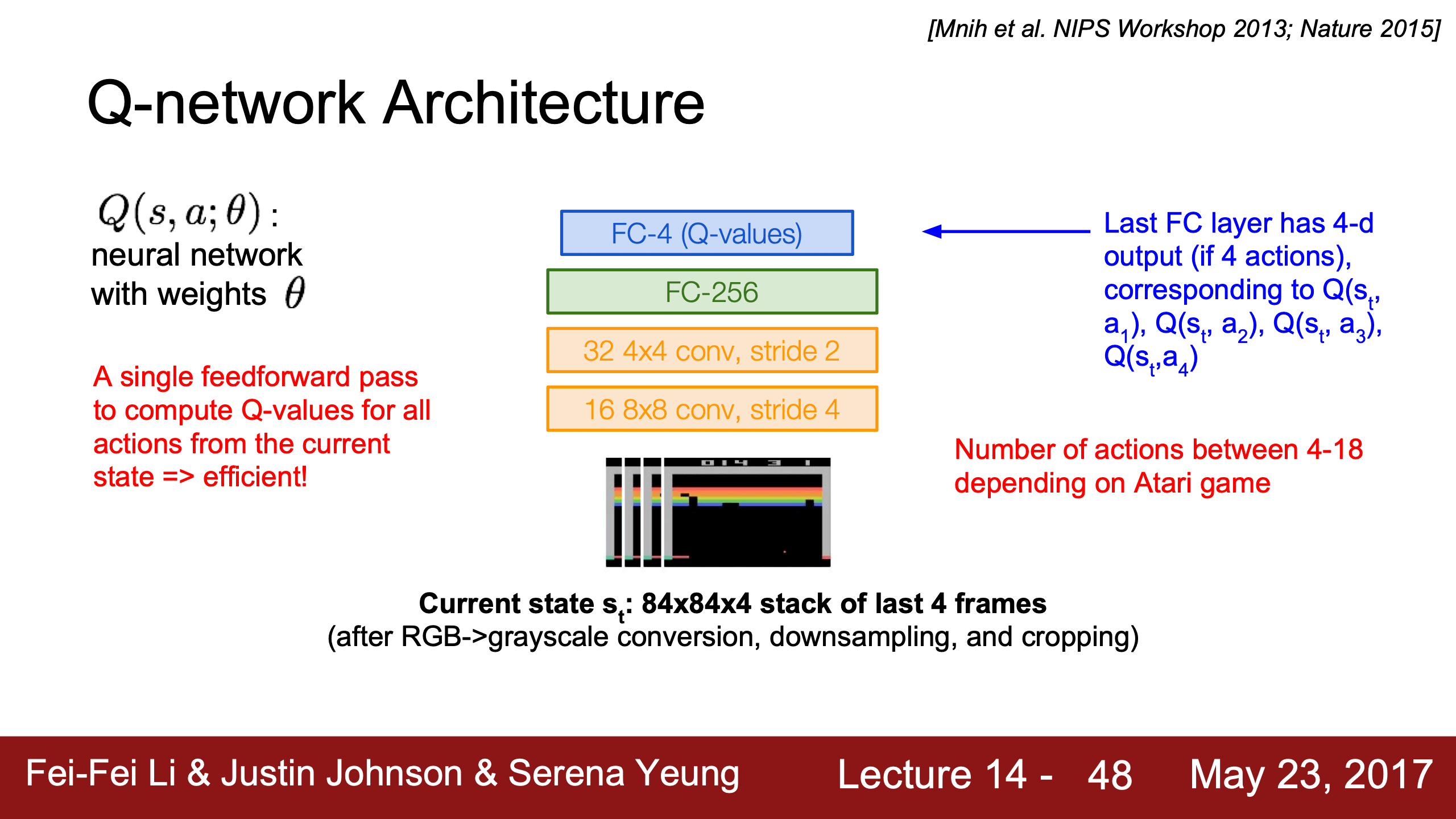

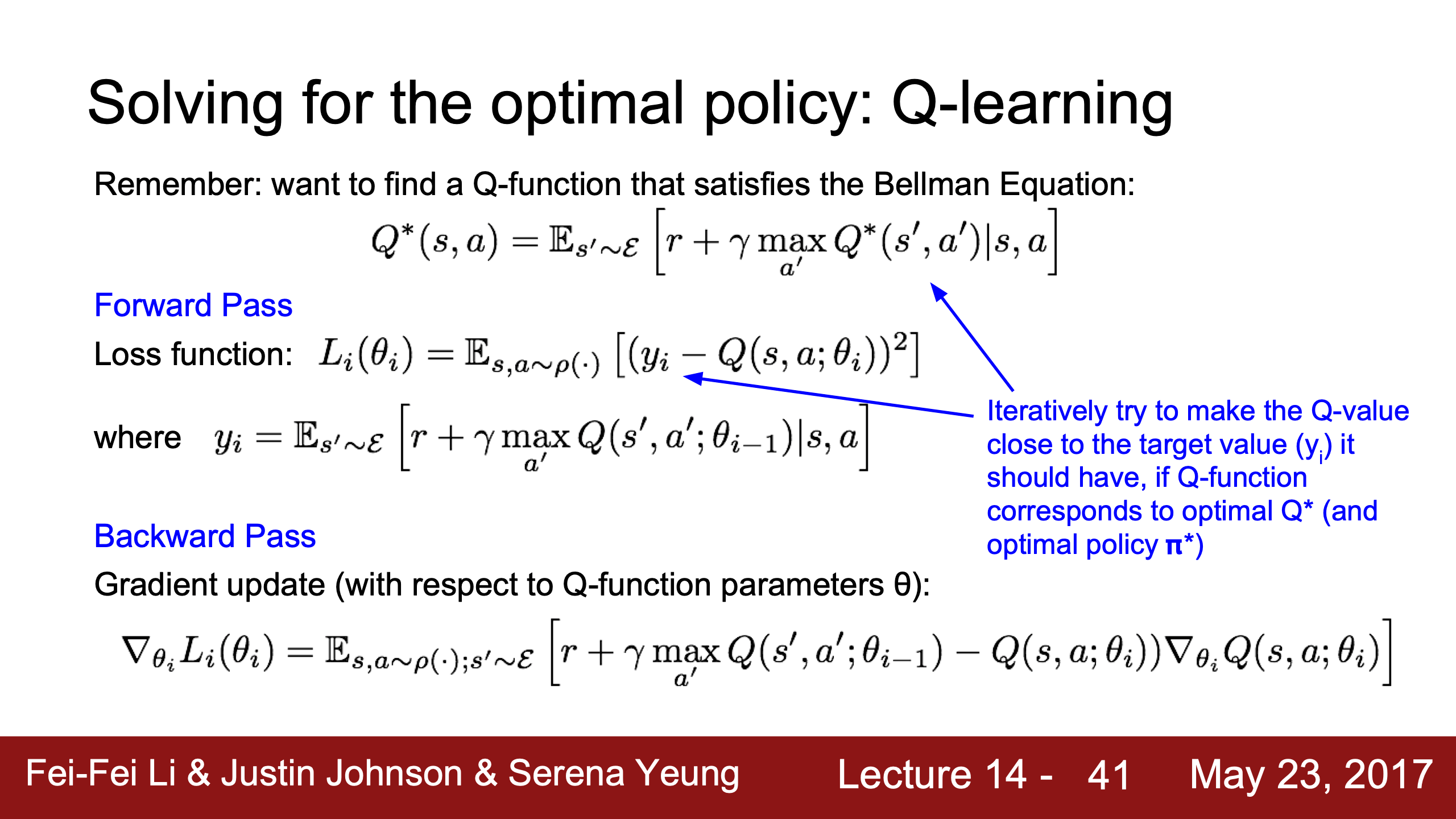

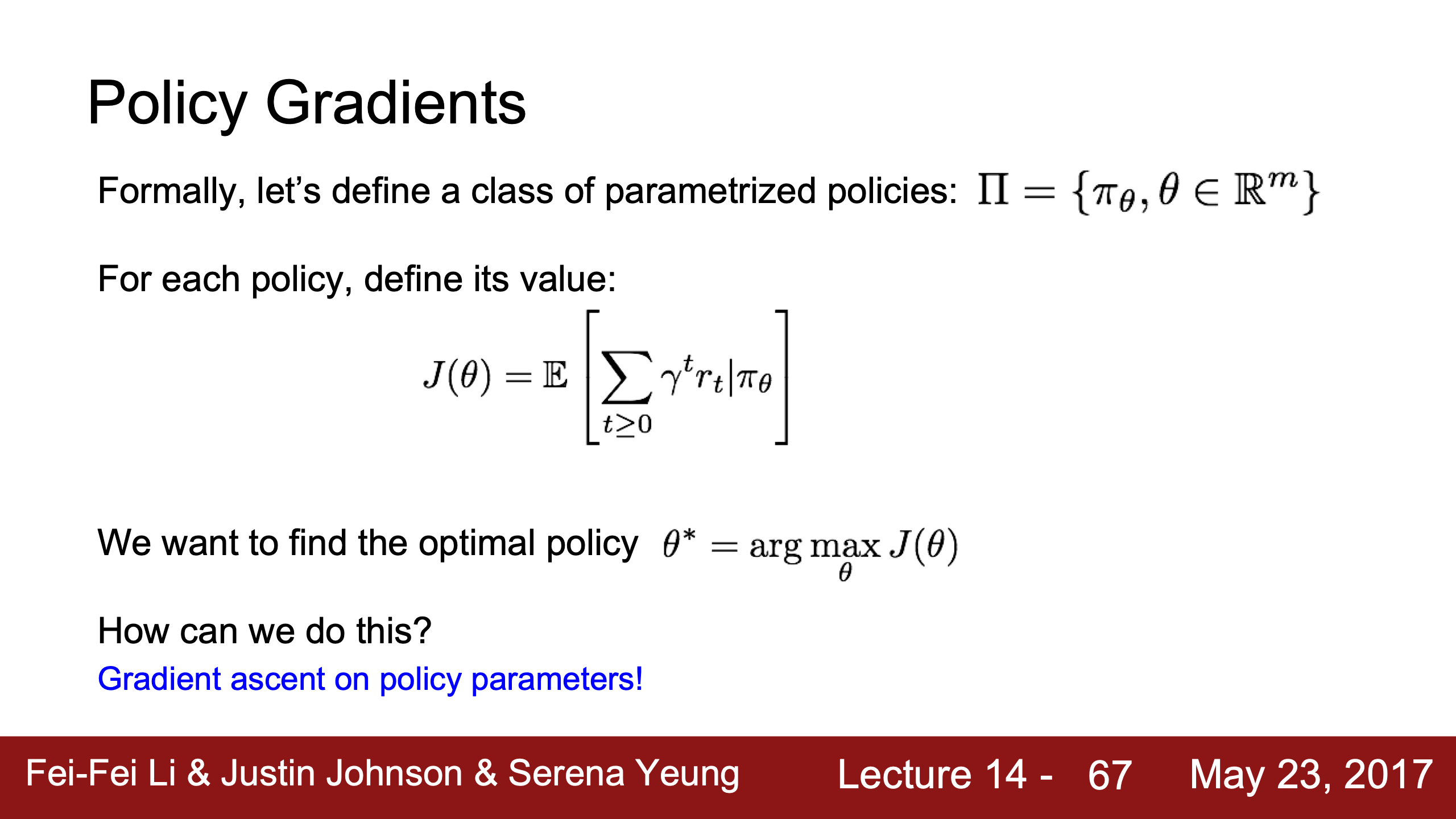

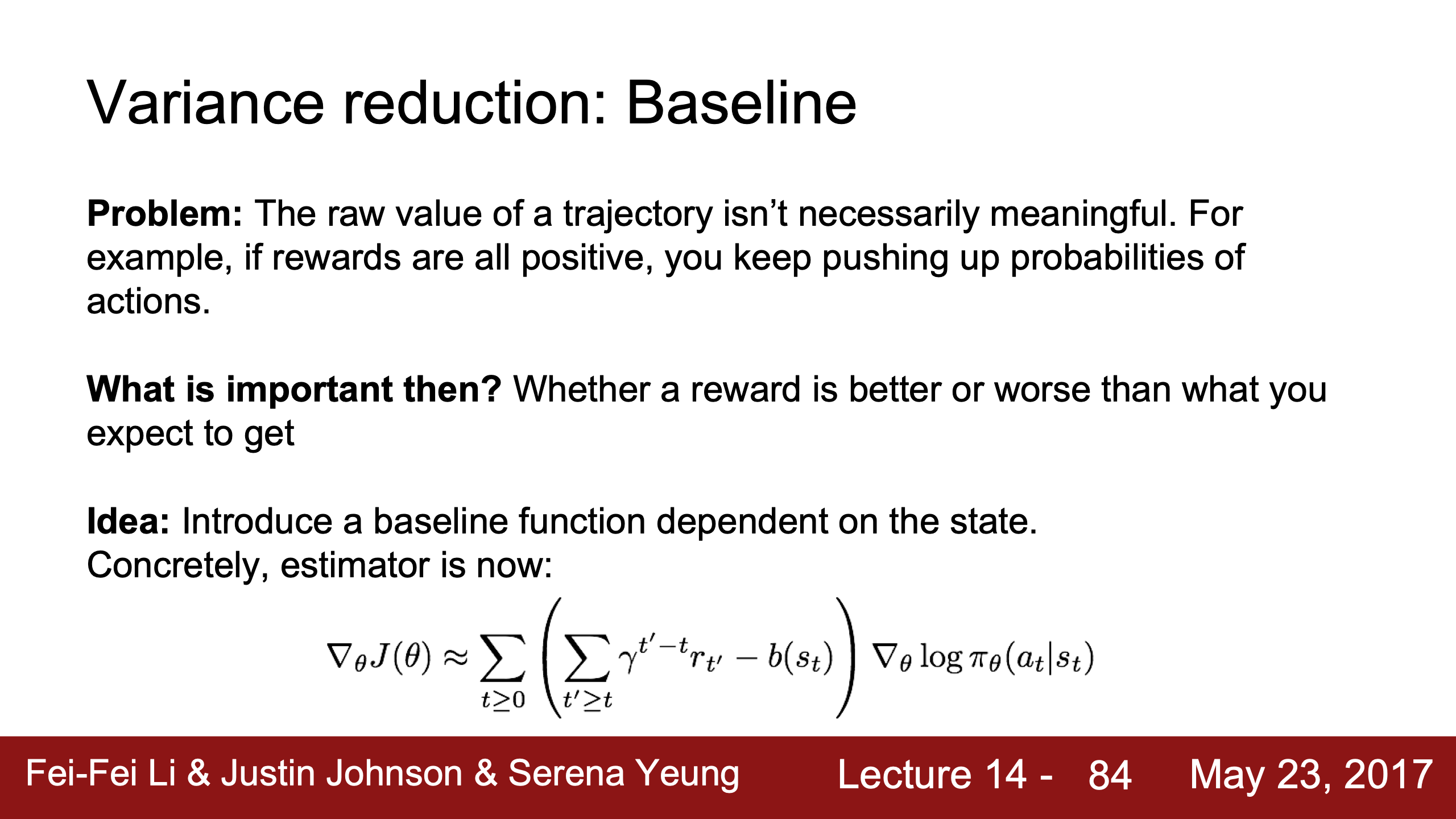

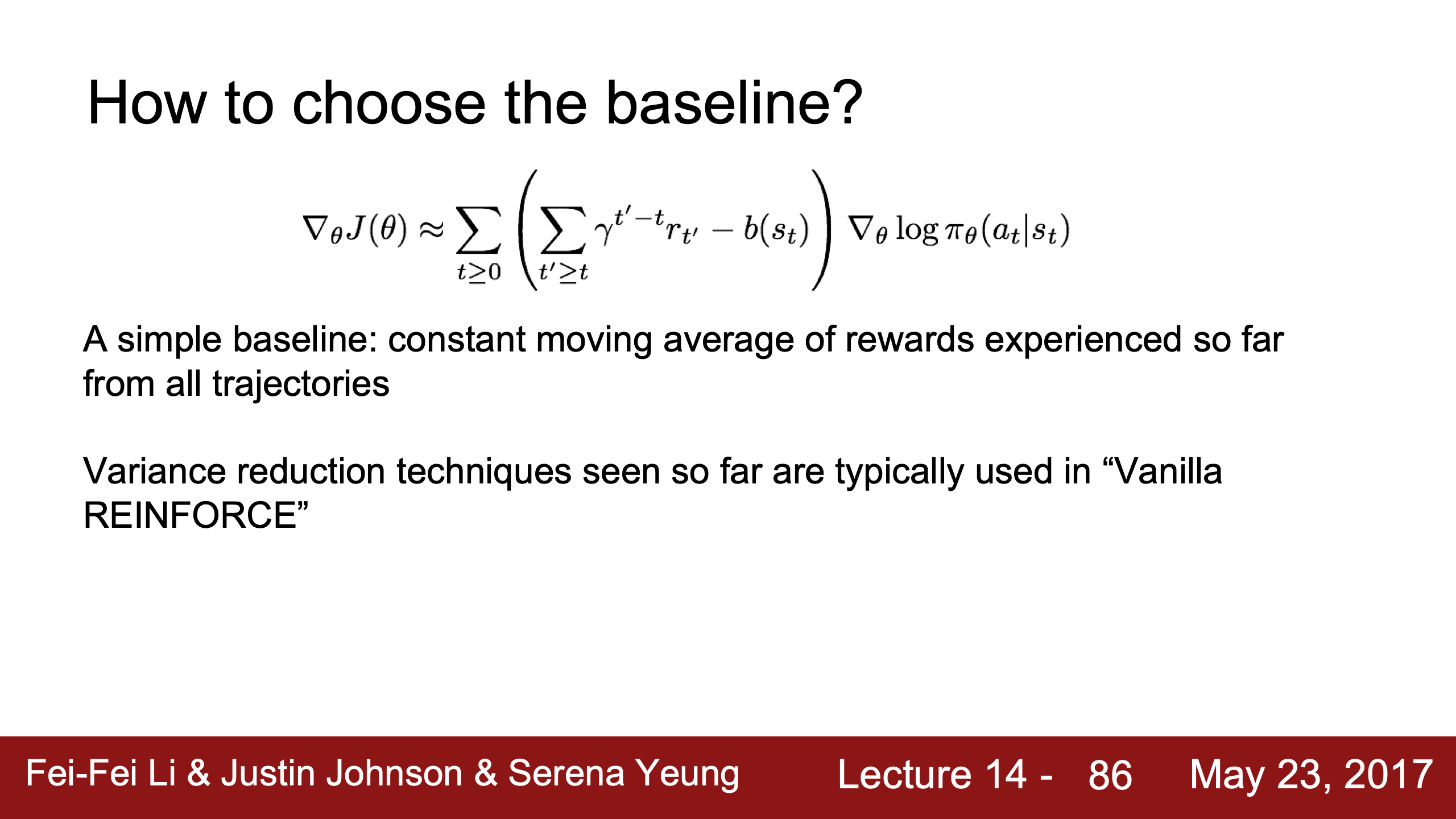

- Lecture 14

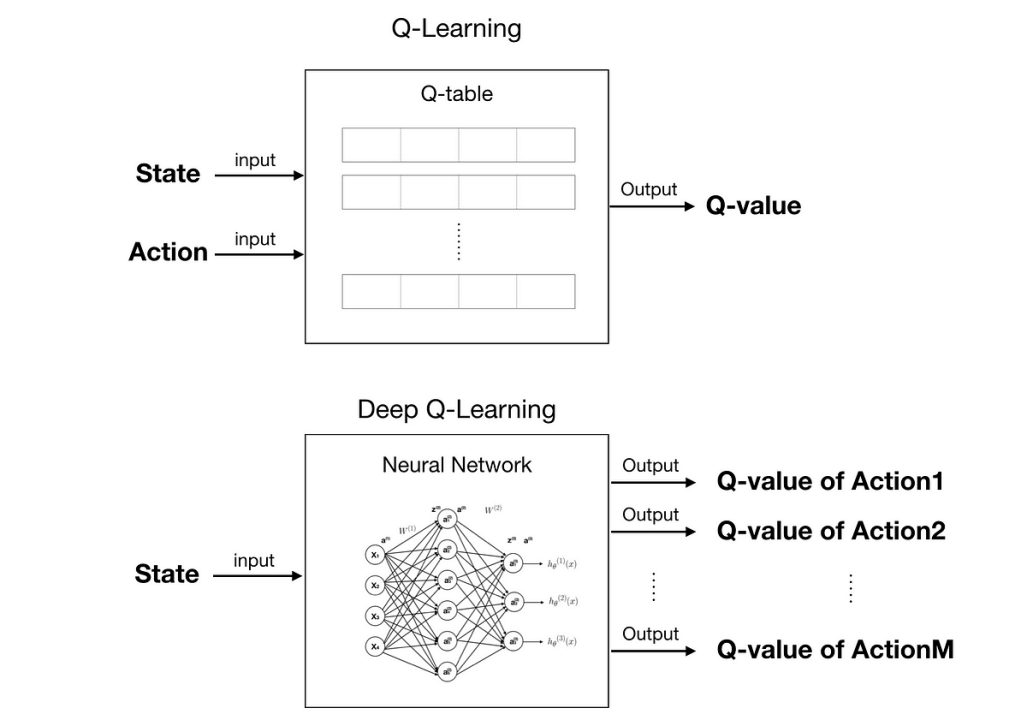

- 傳統 Q-learning

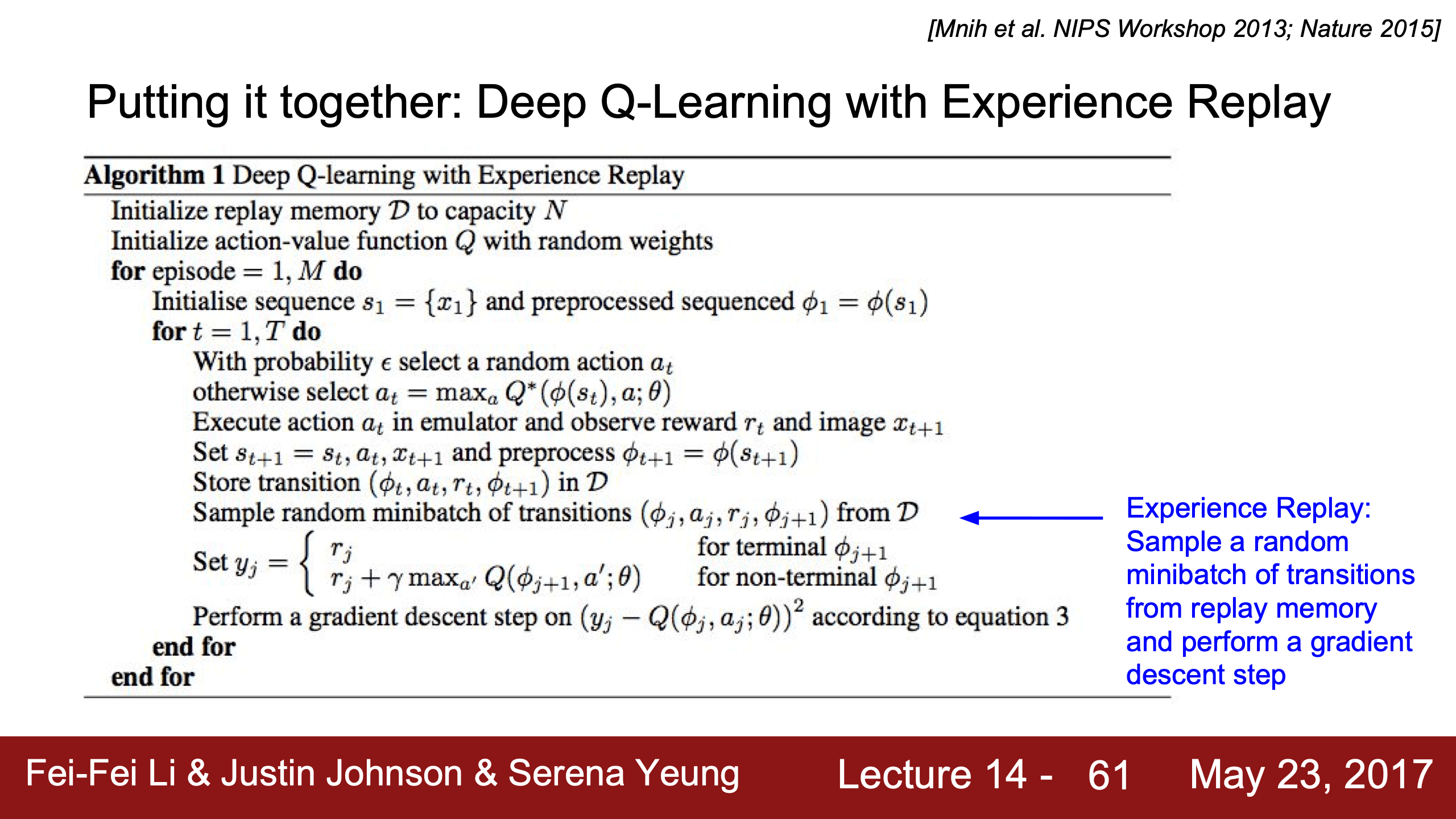

- DQN, Deep Q-Learning

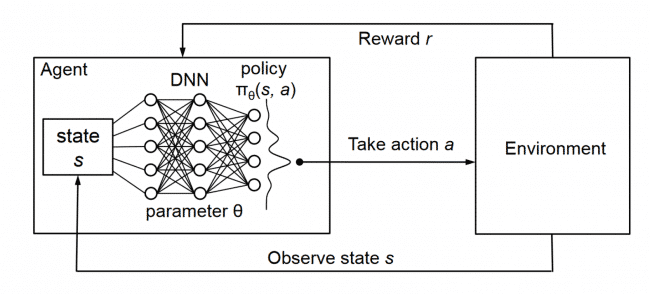

- Continue Lecture 14 Reinforcement Learning

- Lecture 15

- Lecture 16

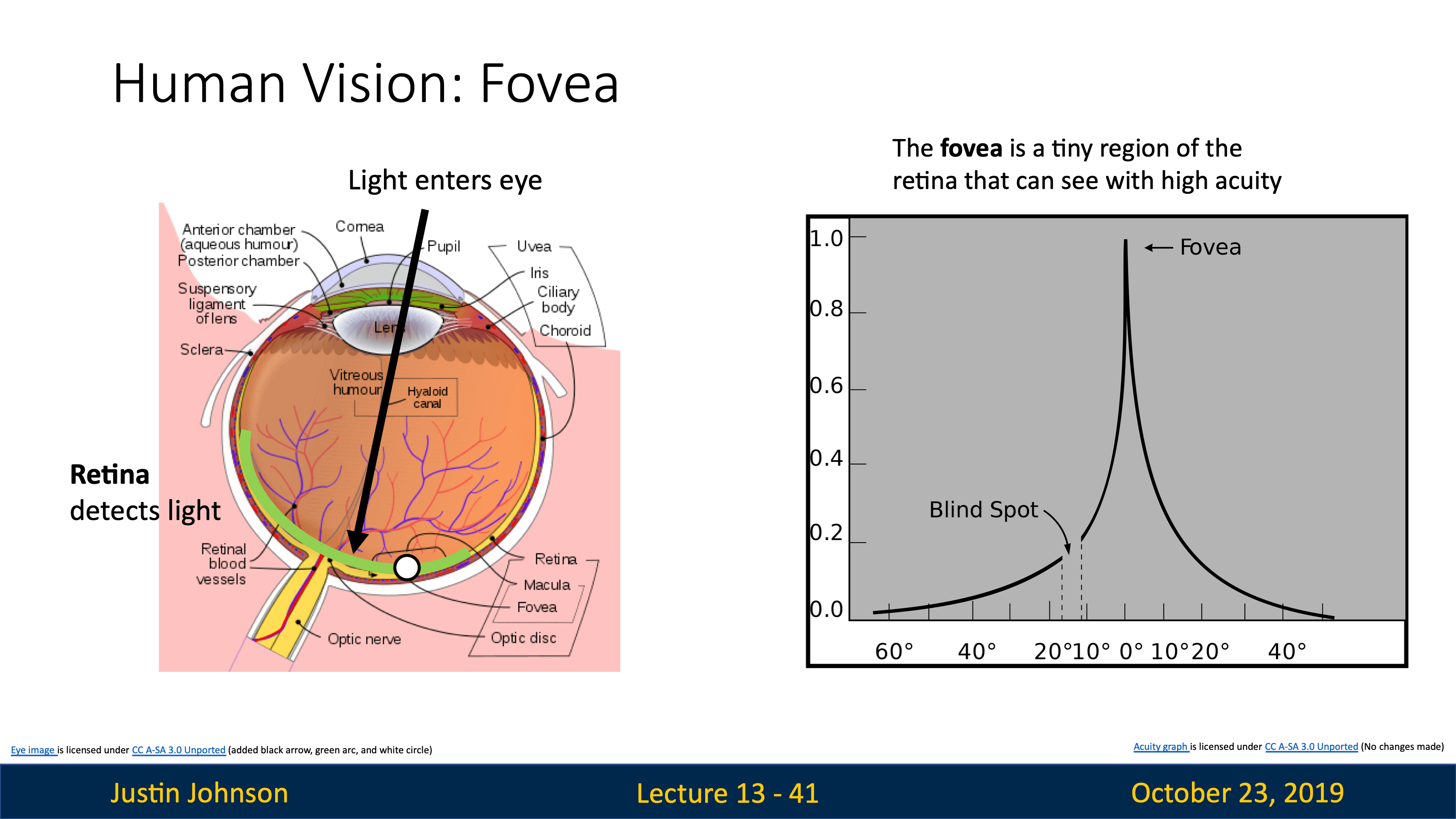

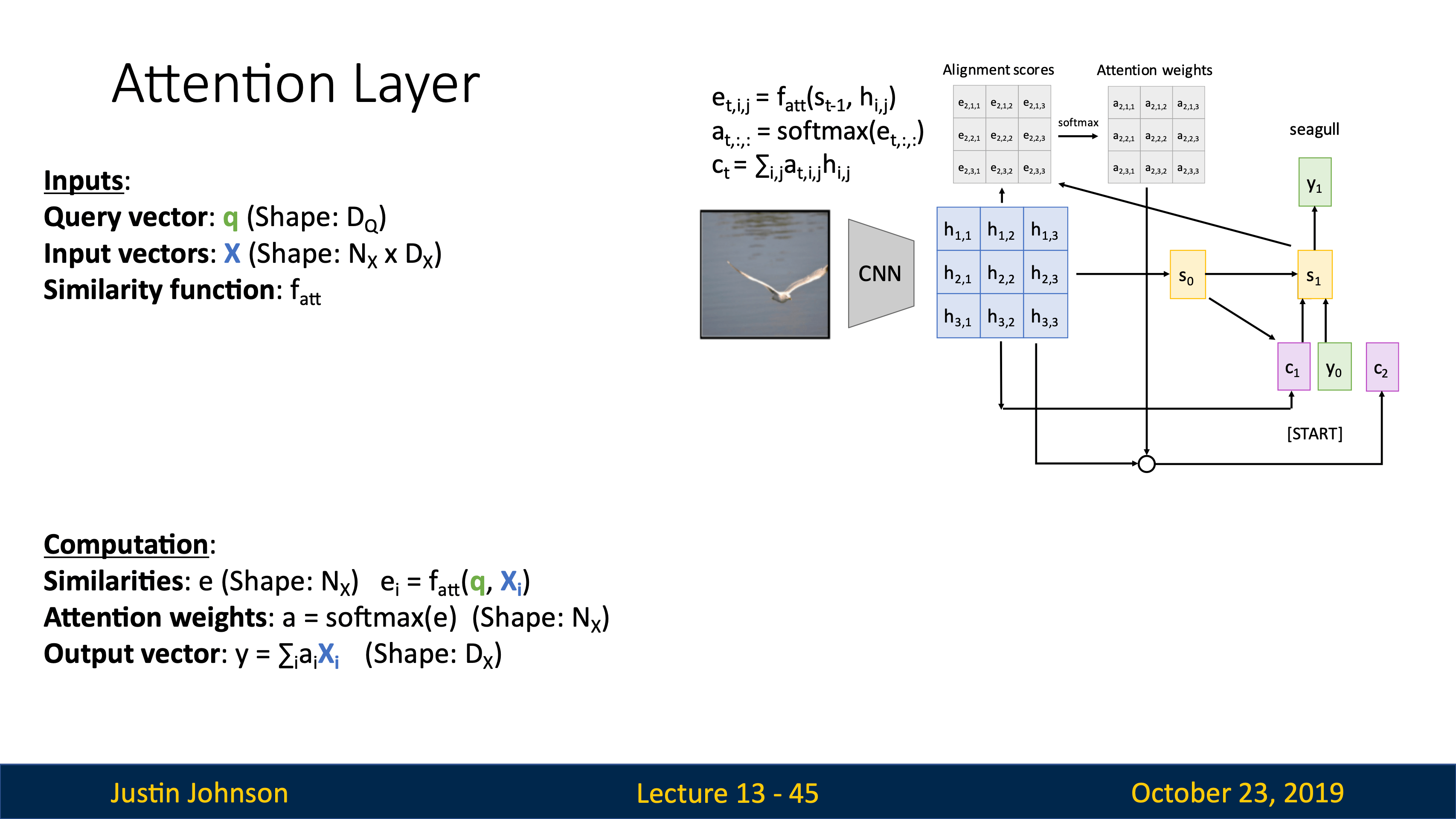

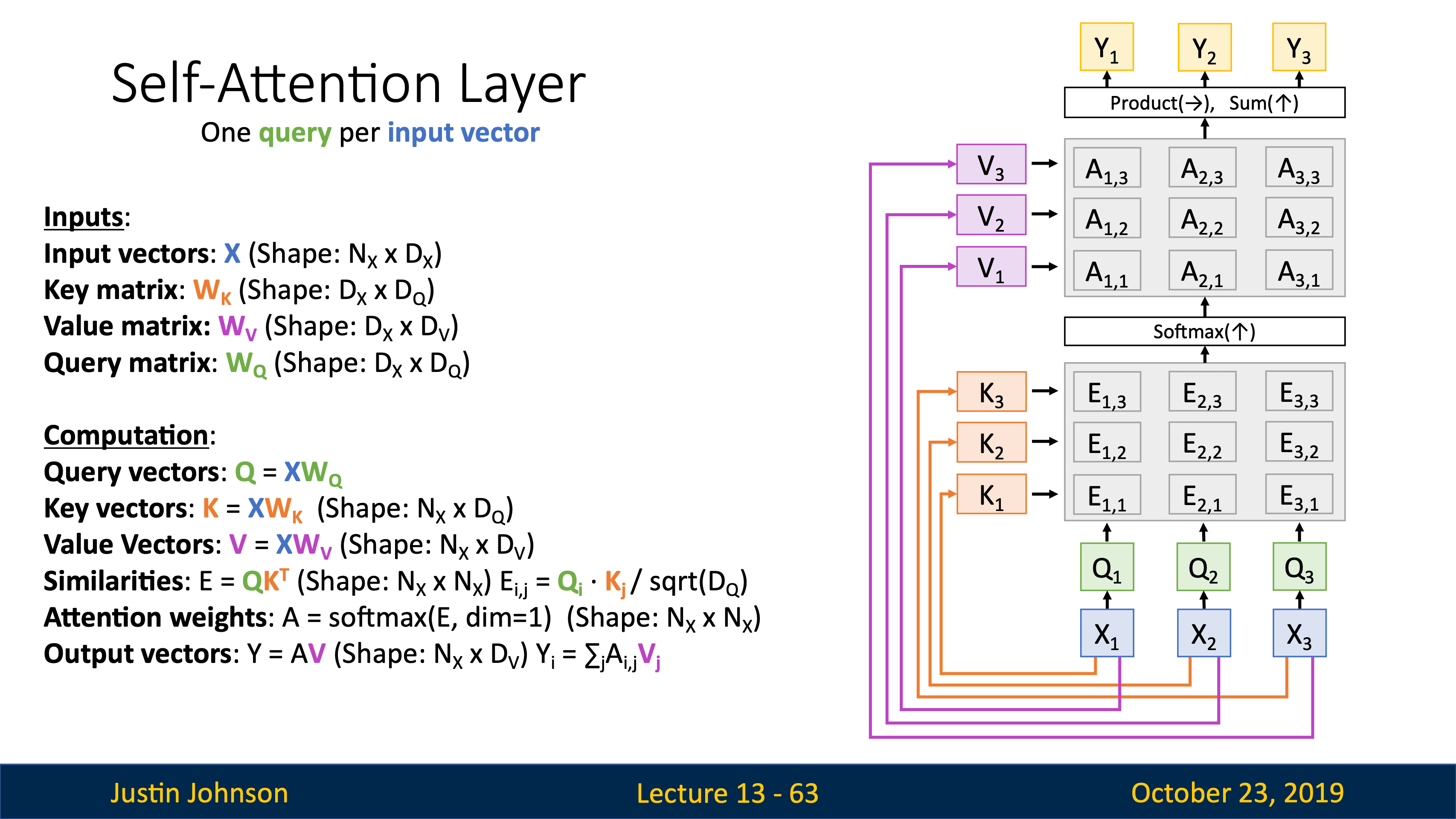

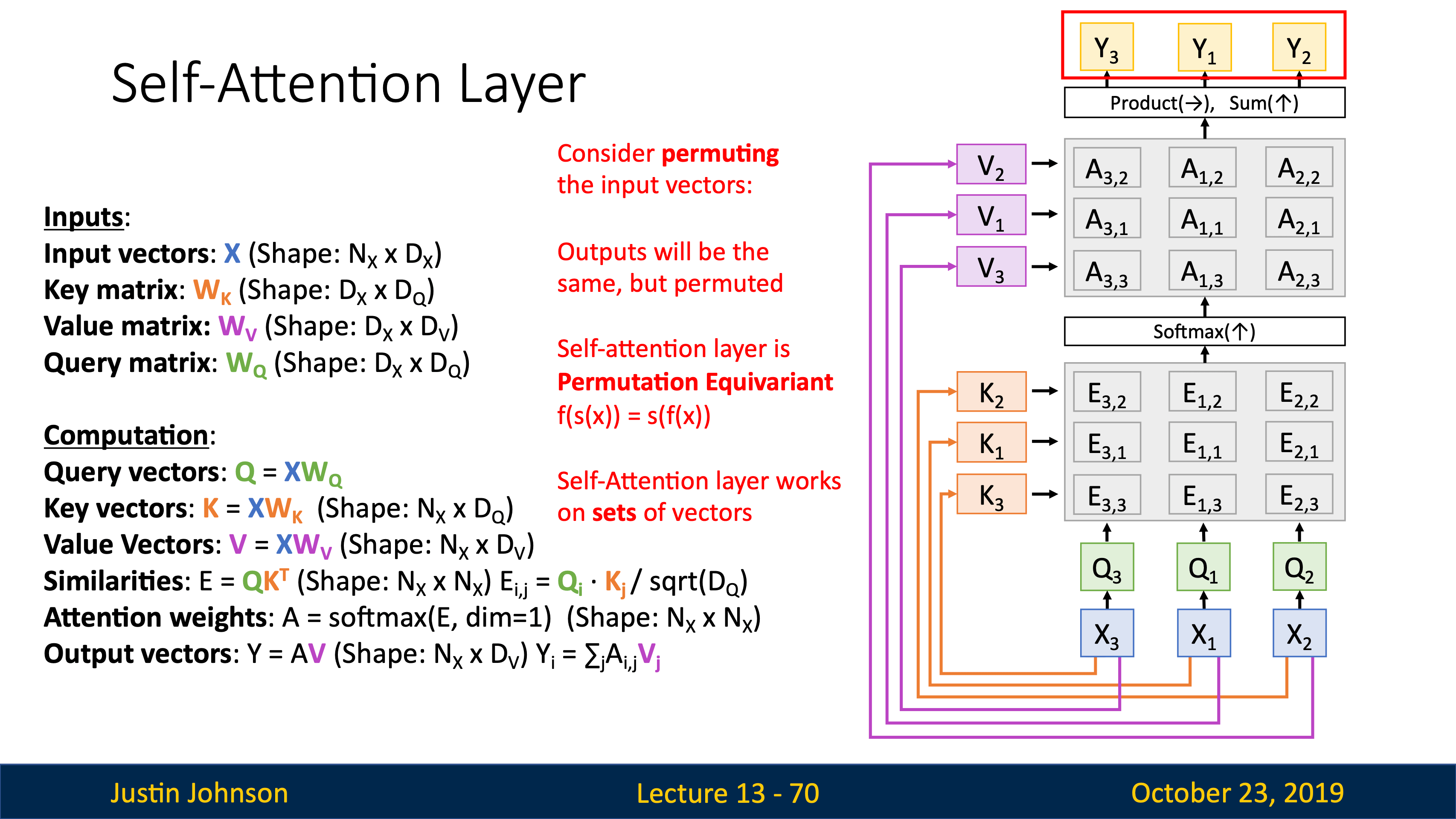

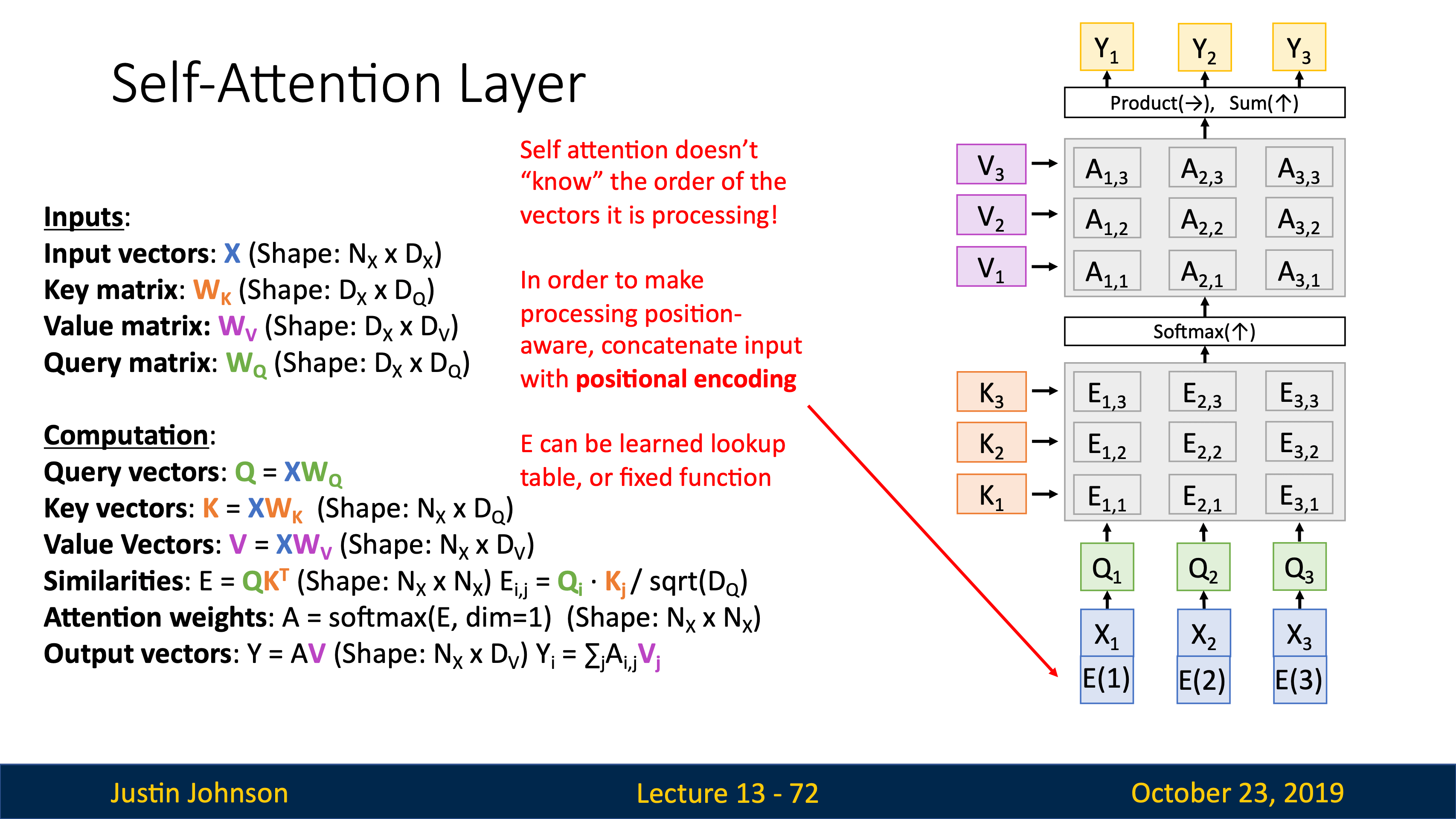

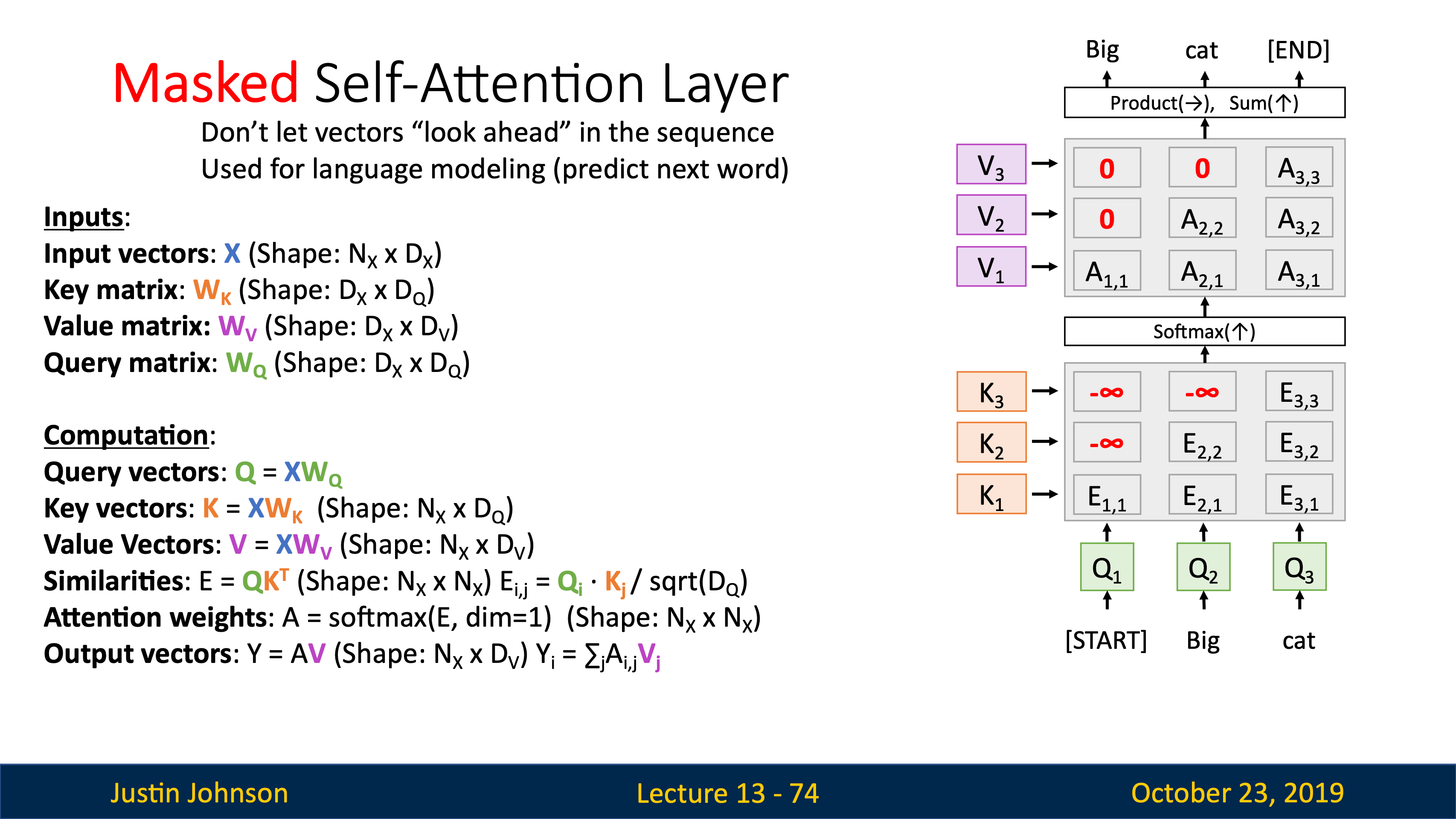

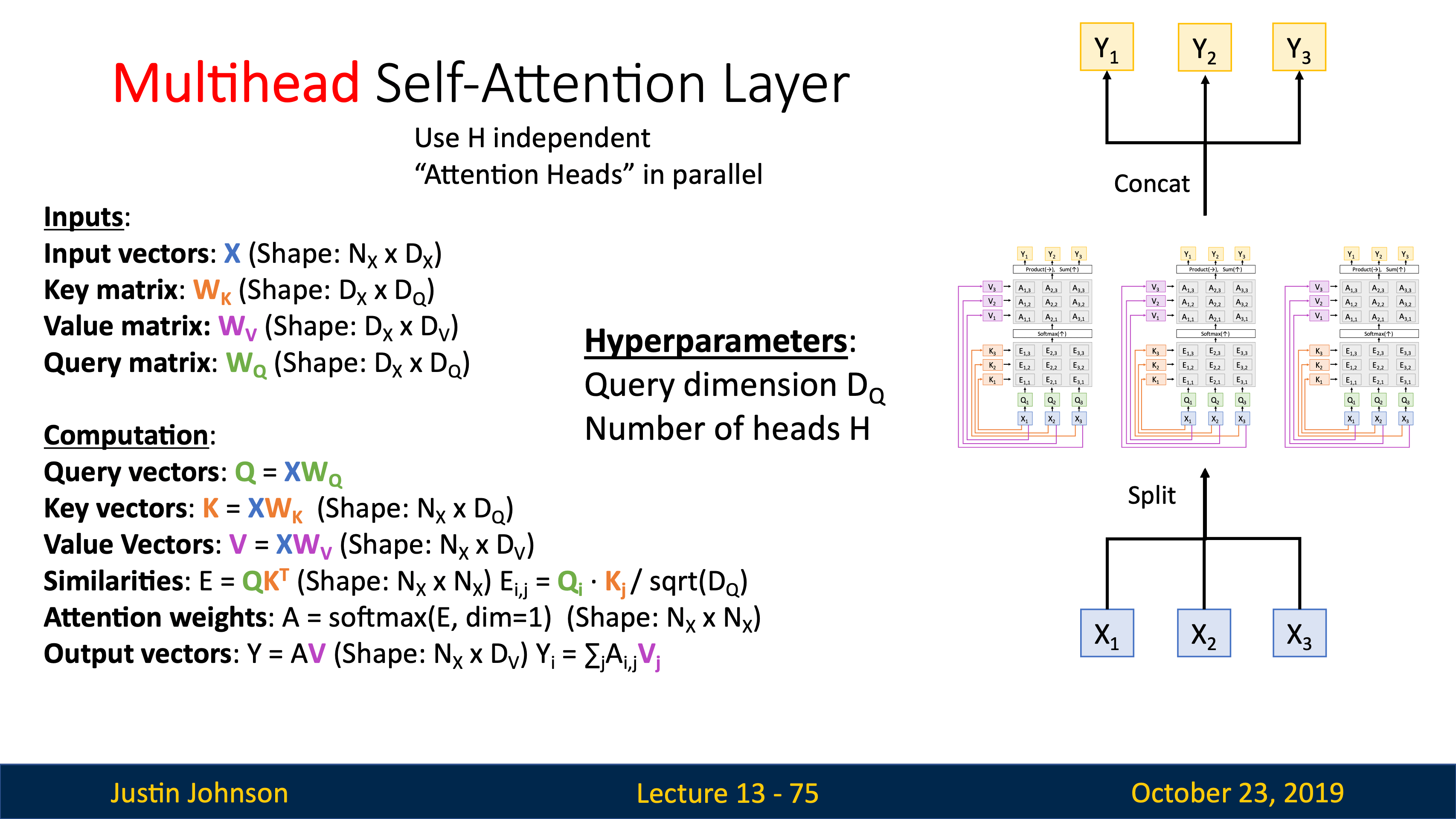

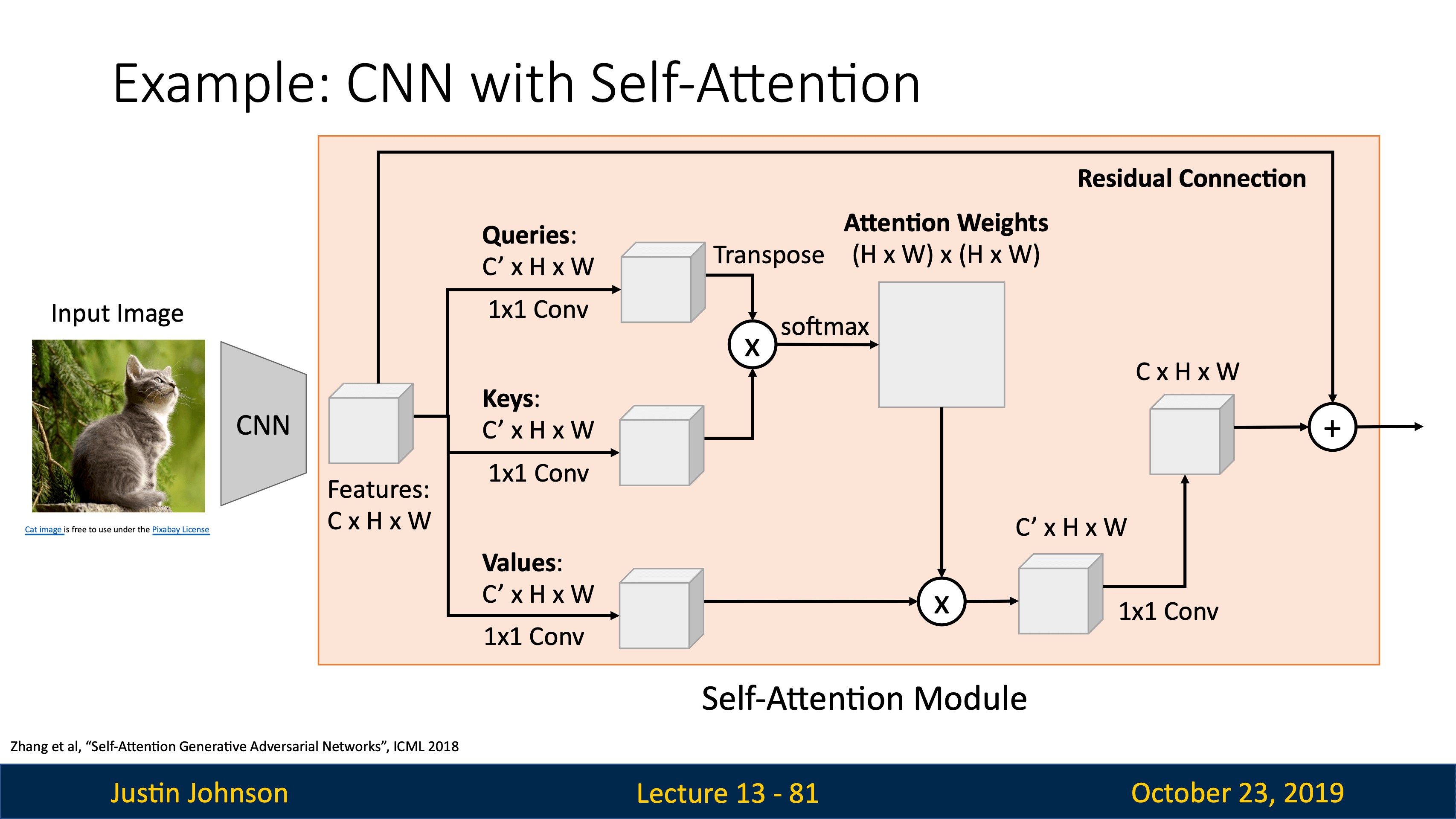

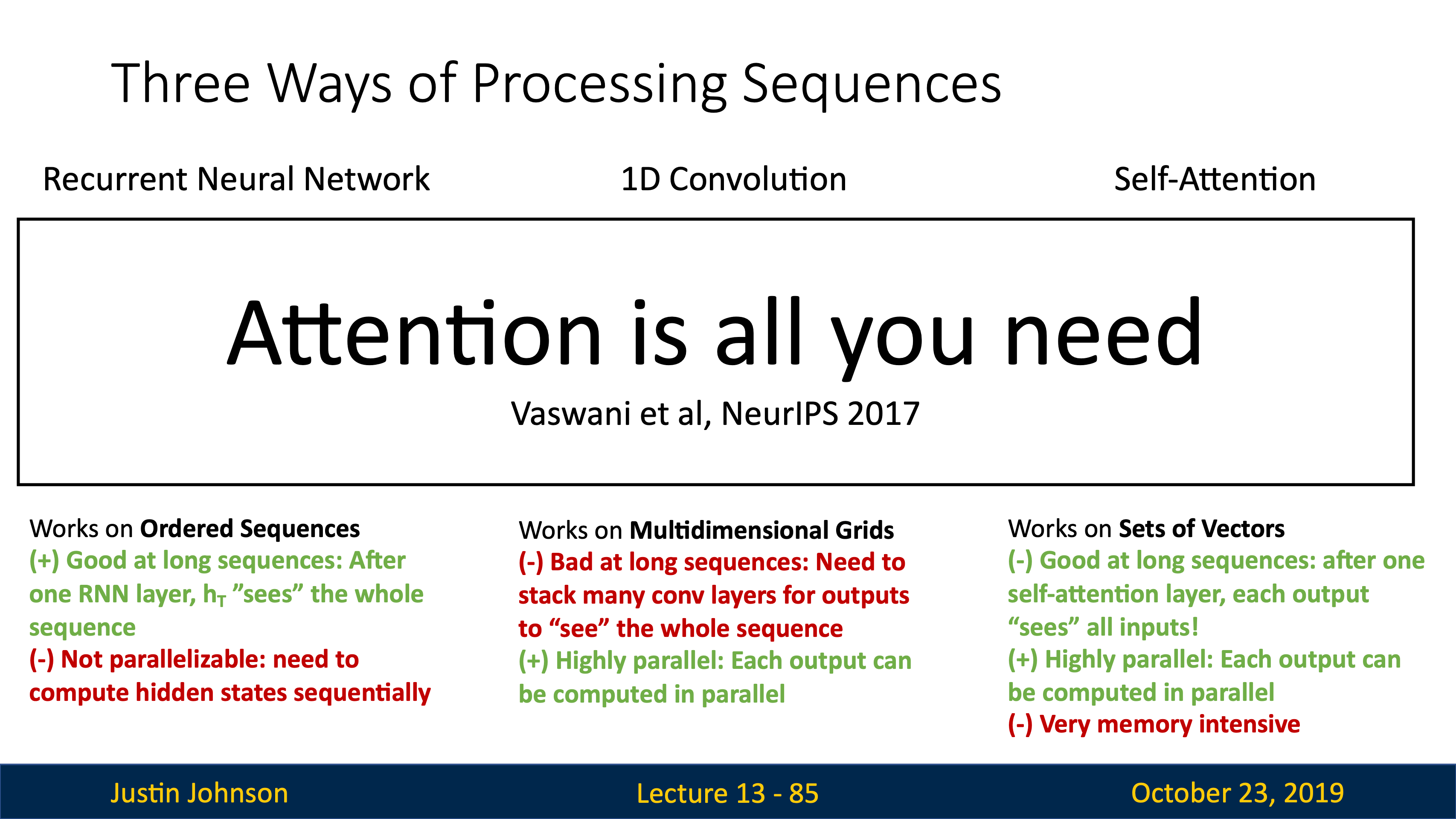

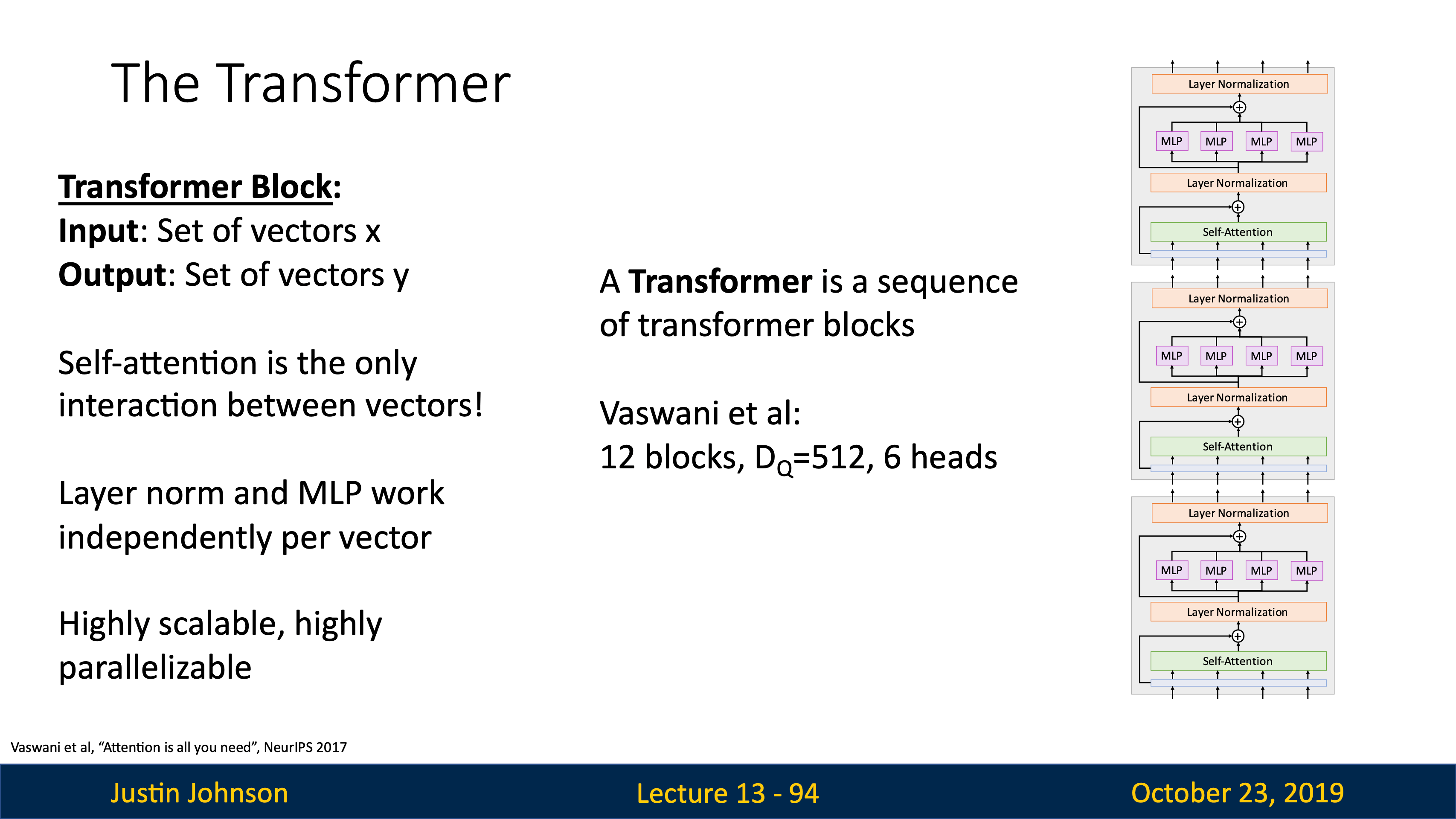

- Lecture 17 Attention and Transformers

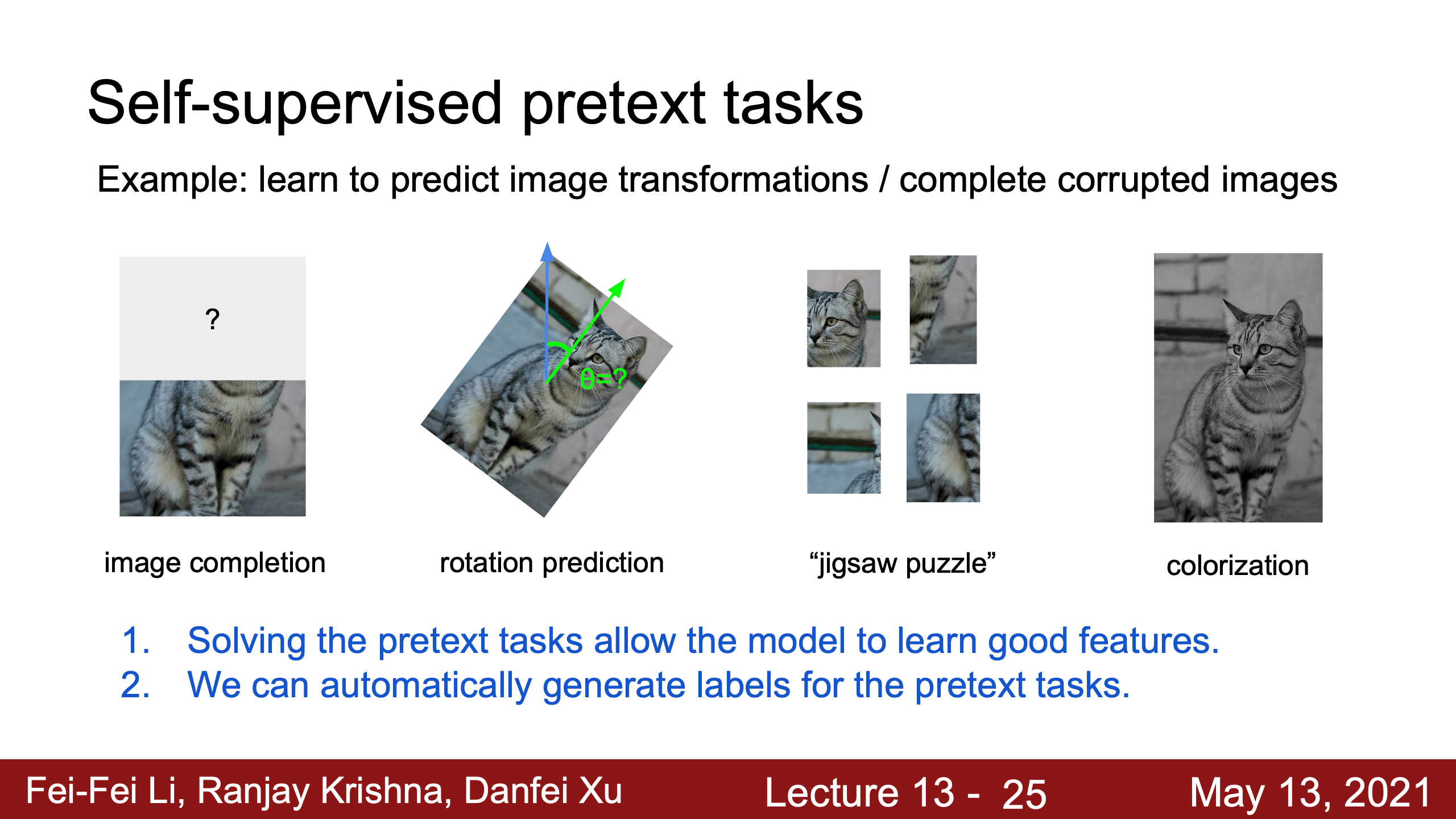

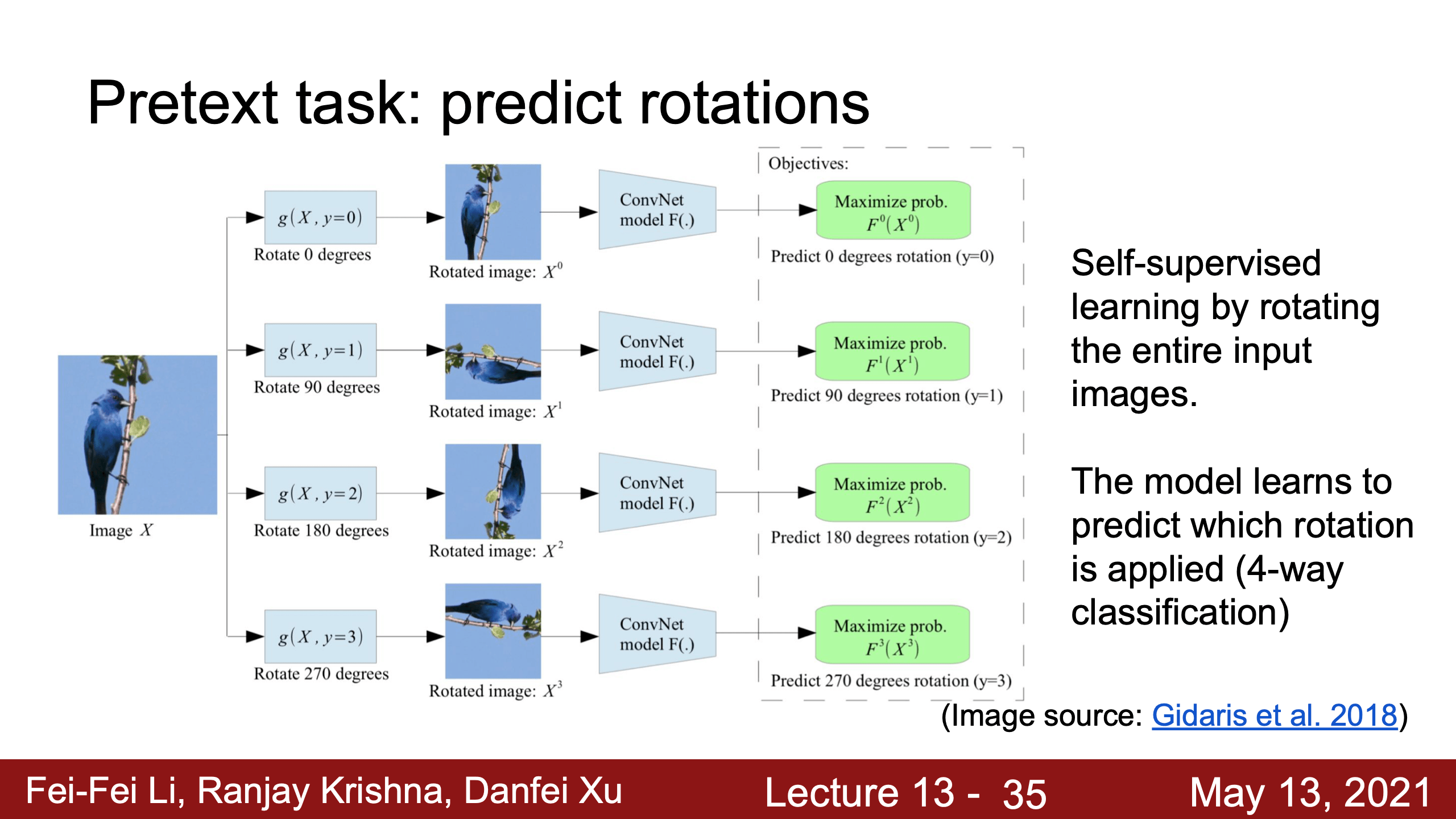

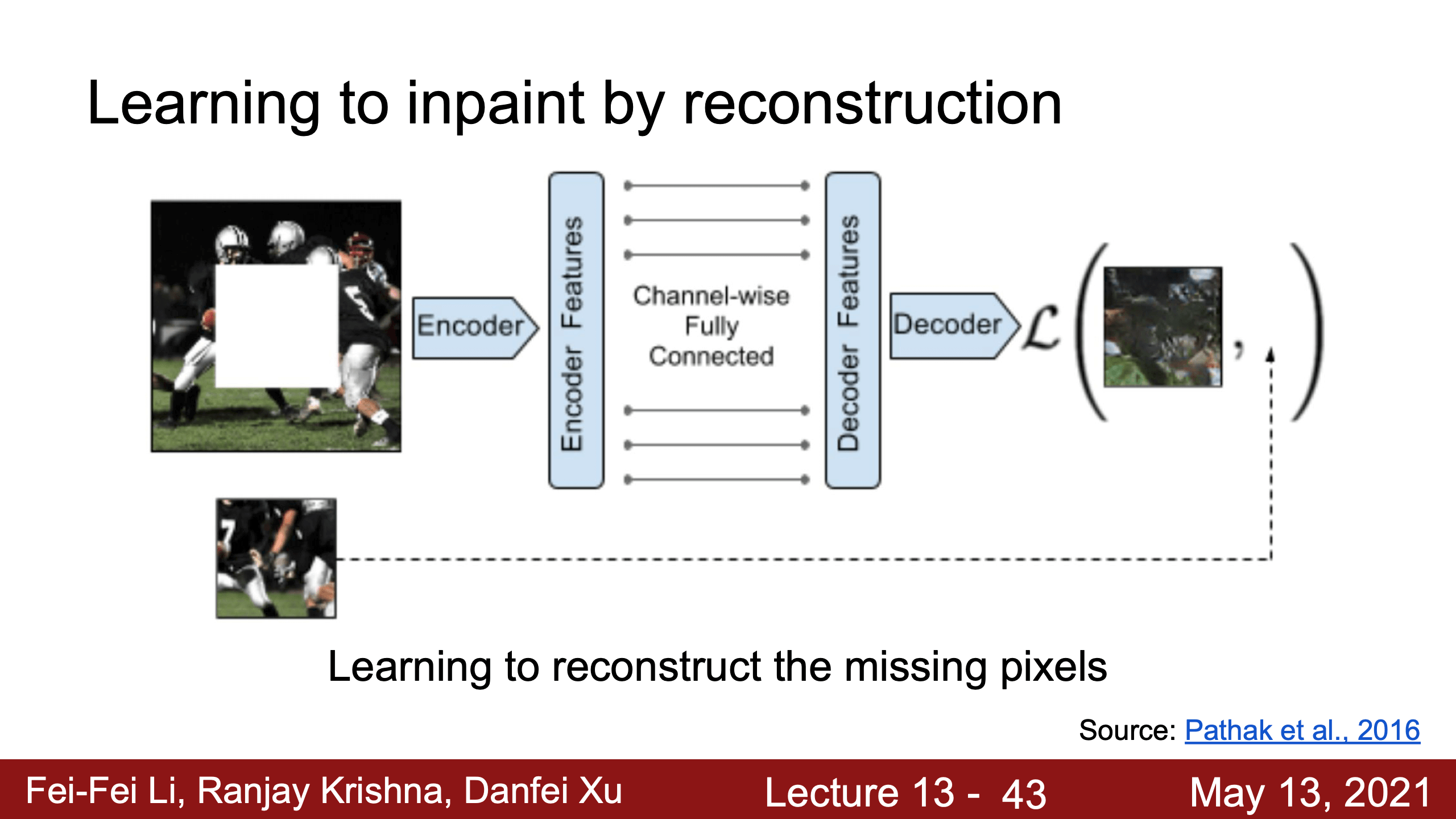

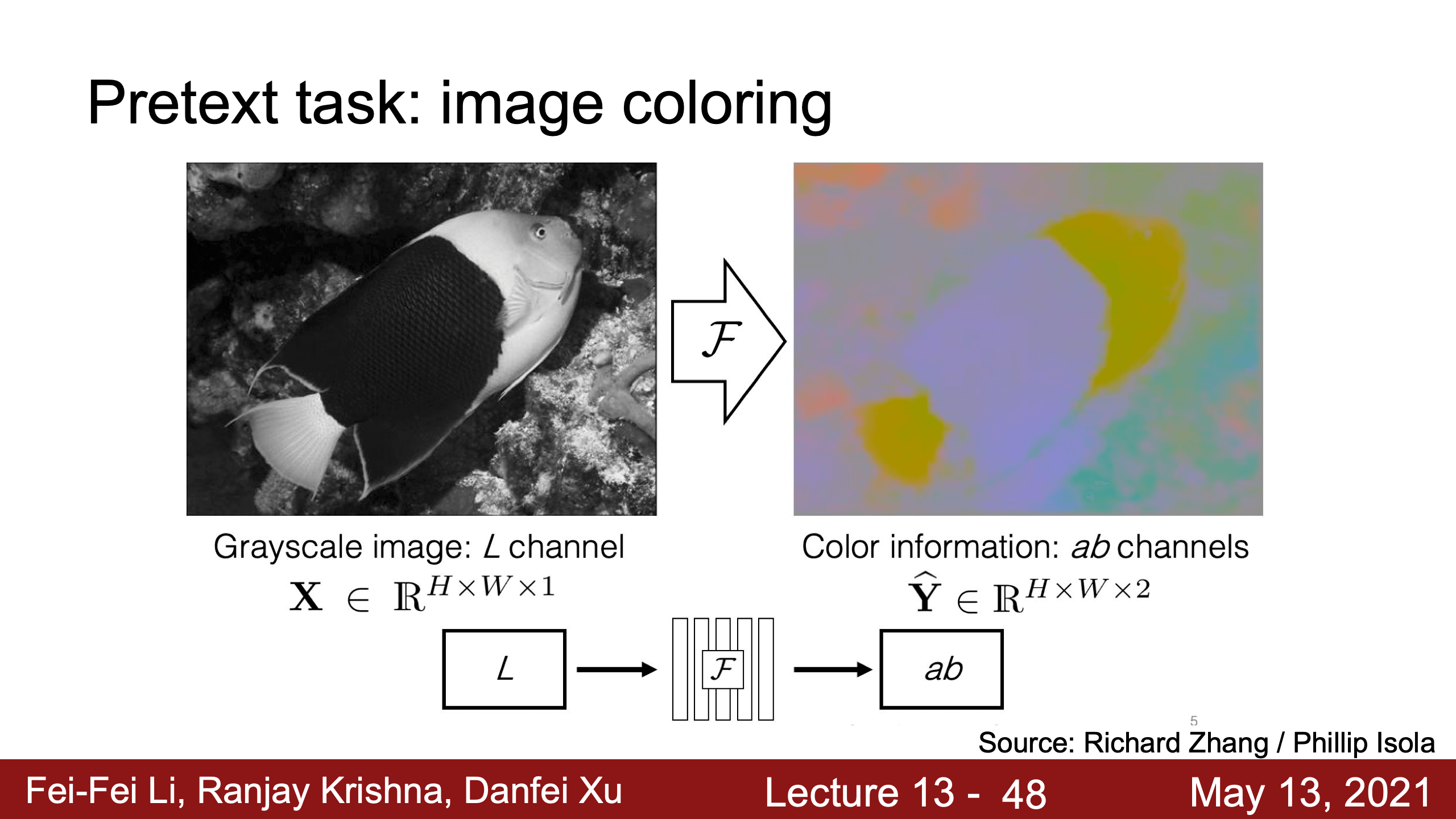

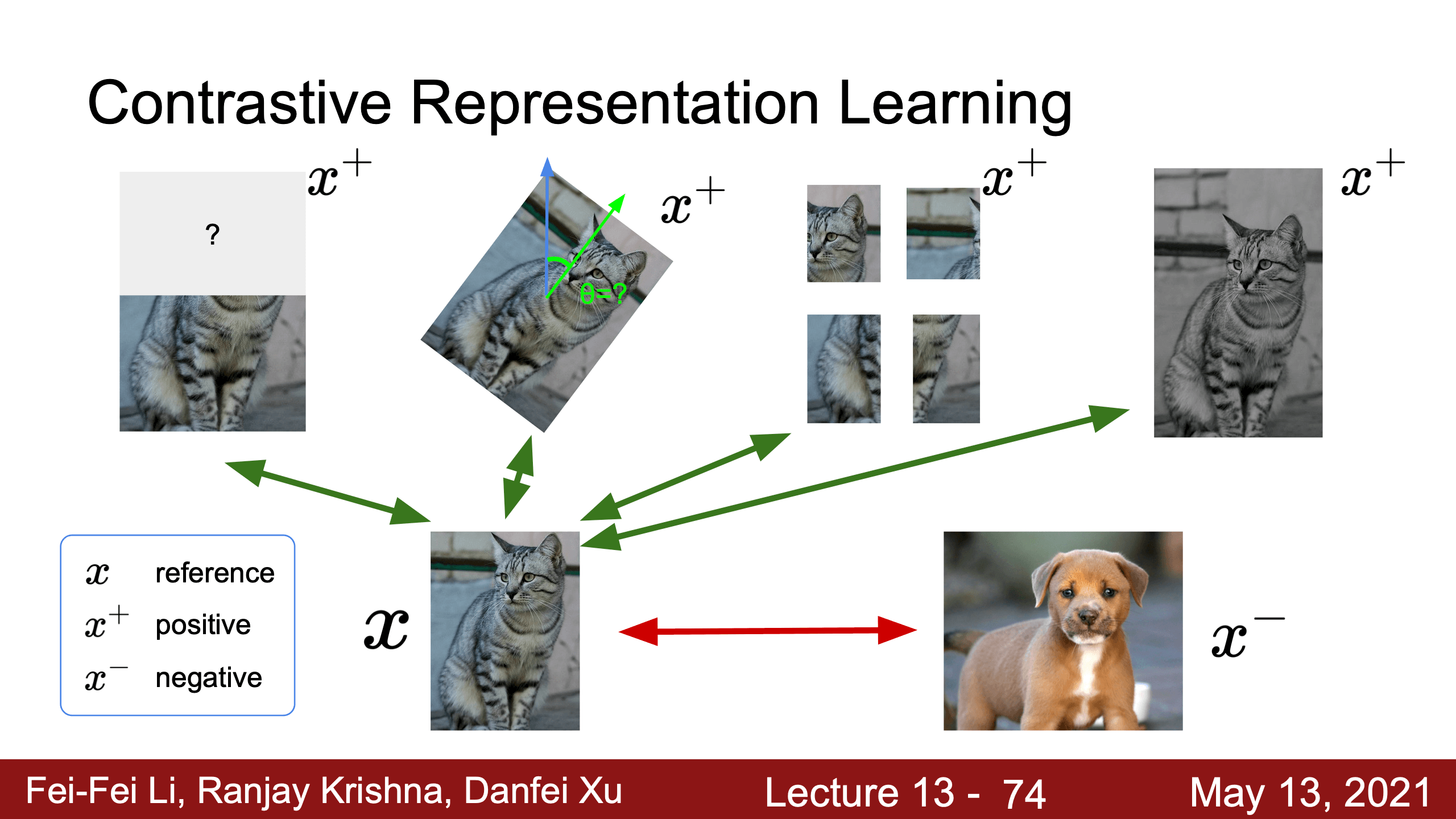

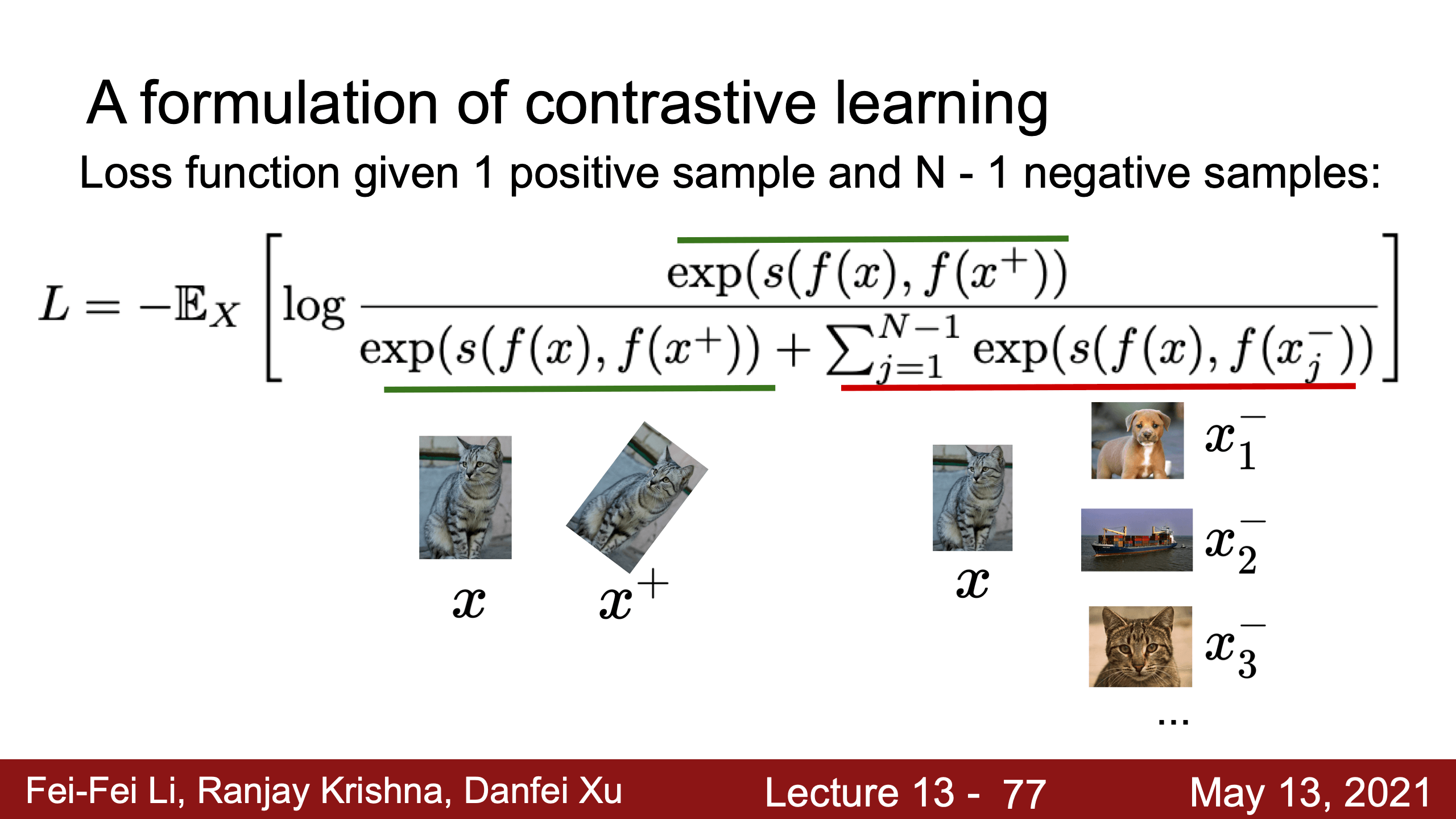

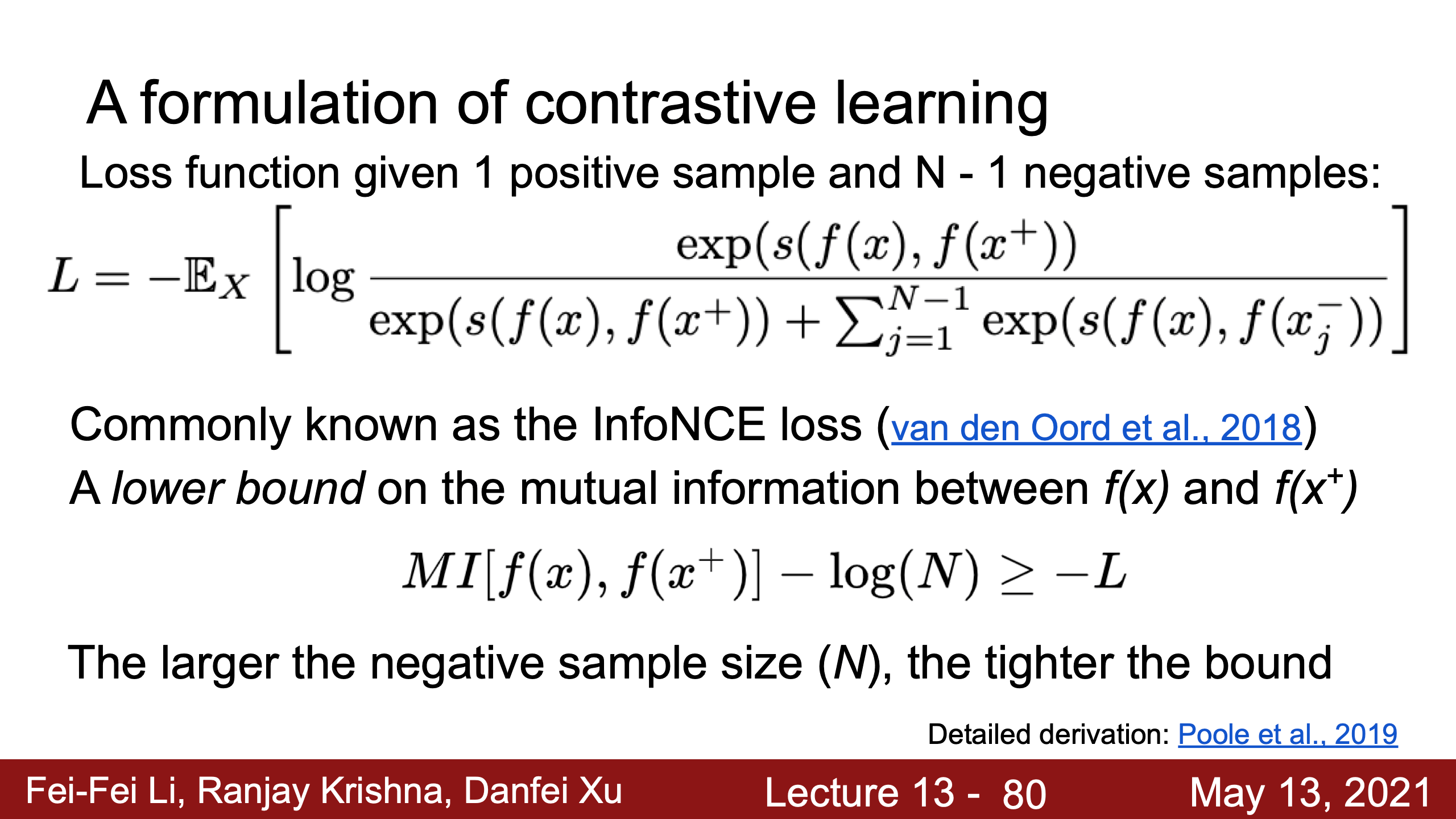

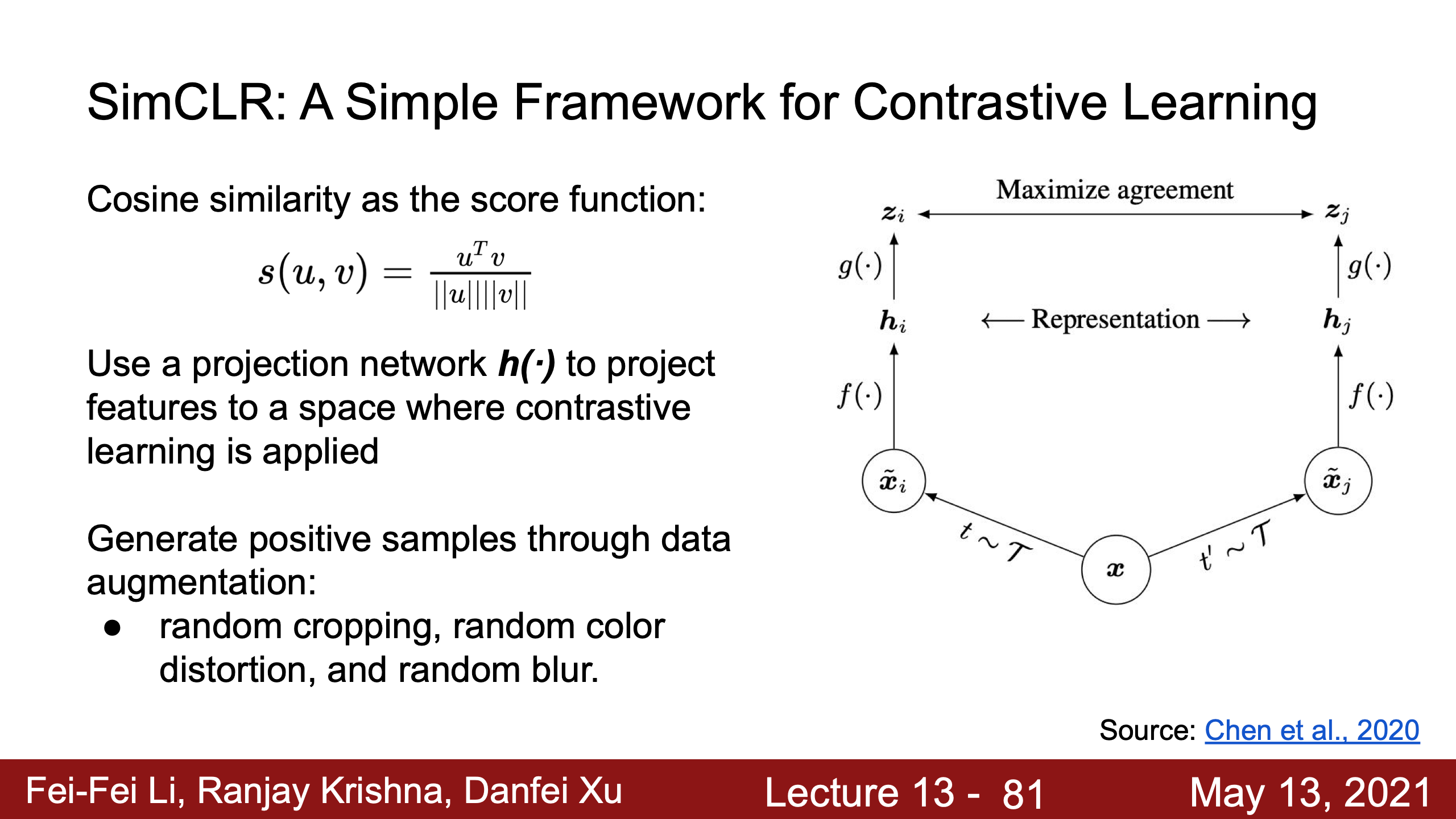

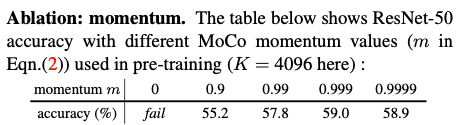

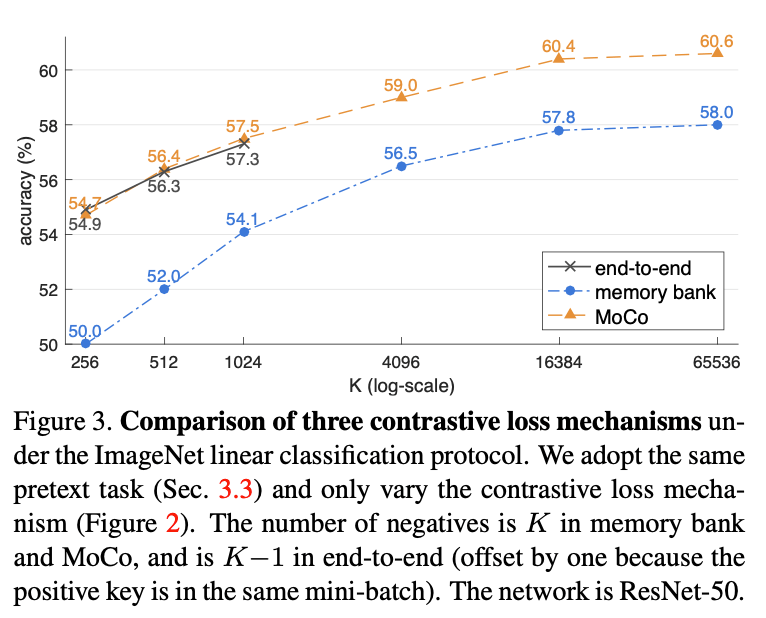

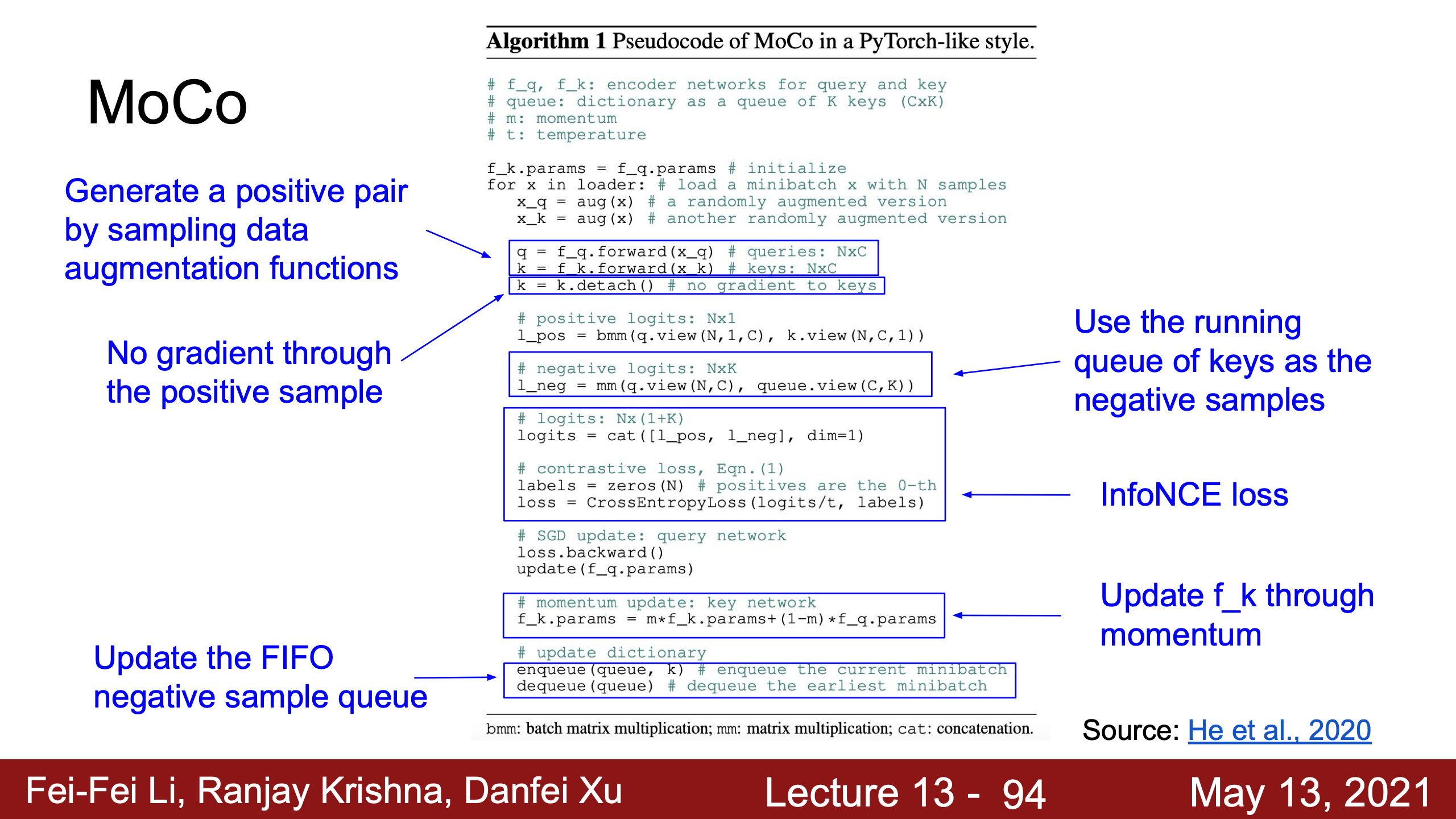

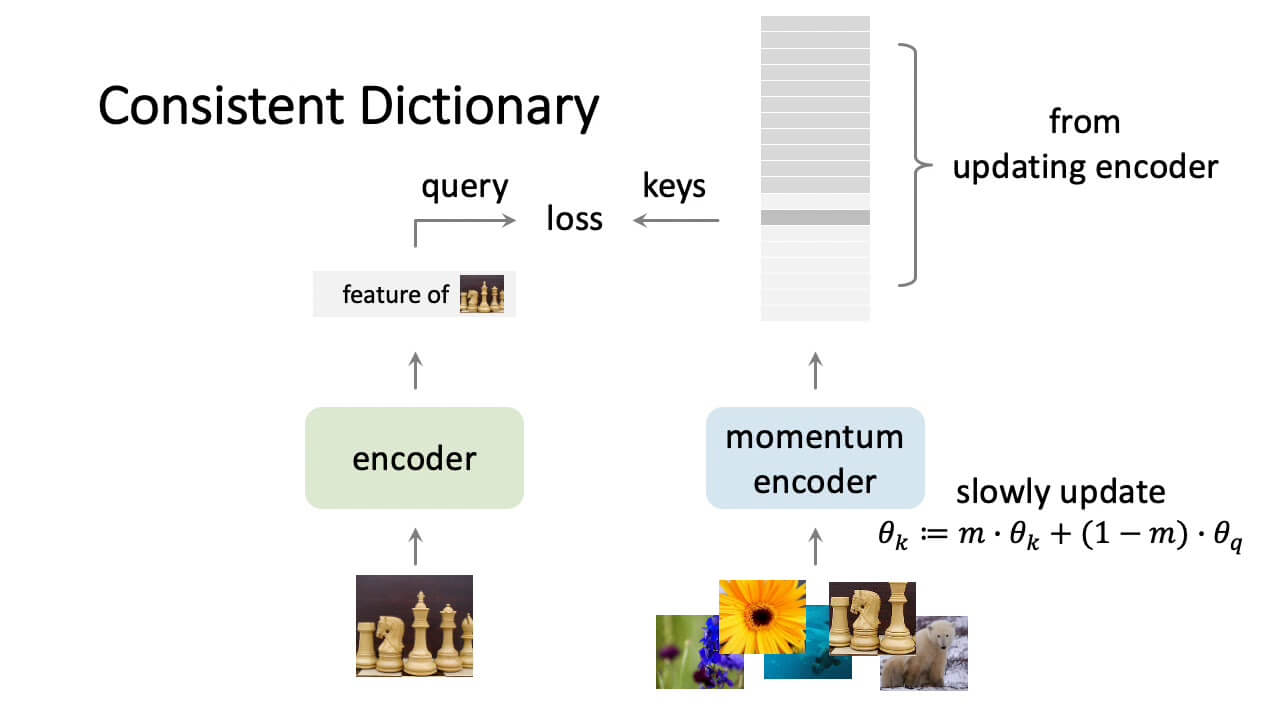

- Lecture 18 Self-Supervised Learning

- 降維

- Lecture 19 3D Vision

- Assignments

- Colab

- Regular Expression

- 小知识

- 常遇見bug一覽

Python Keywords

assert

in dictionary

verb

- to say that something is certainly true断言

- to do something to show that you have power主张

- assert your authority/right

in python

definition

The assert keyword is used when debugging code.

用于调试代码。

The assert keyword lets you test if a condition in your code returns True, if not, the program will raise an AssertionError.

如果assert后的条件判断为真,则无事发生继续运行;为假则报错AssertionError。

usage

x = 9527 |

yield

in dictionary

verb

- produce产生

- The process yields oil for industrial use.

- Early radio equipment yielded poor sound quality.

- The experiments yielded some surprising results.

- give up放弃

- Despite renewed pressure to give up the occupied territory, they will not yield.

- bend/break弯折

- His legs began to yield under the sheer weight of his body.

- stop让路

- If you’re going downhill, you need to yield to bikers going uphill.

- Phrasal verb: yield to something

- If you’re going downhill, you need to yield to bikers going uphill.

in python

definition

The yield keyword is used to return a list of values from a function.

用来返回函数值。

Unlike the return keyword which stops further execution of the function, the yield keyword continues to the end of the function.

跟return相比,yield返回值后,函数会继续运行。

When you call a function with yield keyword(s), the return value will be a list of values, one for each yield.

无论yield几次(哪怕只有一次),都会以generator的形式返回。

usage

def test1(): |

可以用for遍历,或以迭代器的方式遍历def test2():

yield 1

yield 2

yield 3

x = test2() #a generator object

print(next(x))

1

print(next(x))

2

print(next(x))

3

for i in test2():

print(i)

1

2

3

generator? what?

iterator first

https://docs.python.org/3/glossary.html#term-iterator

iterator is an object representing a stream of data.

迭代器是个数据流对象。

Repeated calls to the iterator’s __next__() method (or passing it to the built-in function next()) return successive items in the stream. When no more data are available a StopIteration exception is raised instead.

迭代器是這樣一種數據流對象:调用它的“__next__()”方法或用python内置函数“next(iterator)”可以得到它这个流的后继数据,没数据了就抛出StopIteration异常。

根据這裡迭代器的定义,我們就可以自造迭代器类。class MyNumbers:

def __iter__(self):

self.a = 1

return self

def __next__(self):

x = self.a

self.a += 1

return x

myclass = MyNumbers()

myiter = iter(myclass)

print(next(myiter))

1

print(next(myiter))

2

print(next(myiter))

3

这里的iter()也是个内置函数,iter(object)或iter(object, sentinel),接收一個對象返回一個iterator對象。

Without a second argument, object must be a collection object which supports the iterable protocol (the __iter__() method), or it must support the sequence protocol (the __getitem__() method with integer arguments starting at 0).

如果没有sentinel哨兵参数,這裡的object就必须实现__iter__或__getitem__方法。

now generator

https://docs.python.org/3/glossary.html#term-generator

A function which returns a generator iterator. It looks like a normal function except that it contains yield expressions for producing a series of values usable in a for-loop or that can be retrieved one at a time with the next() function.

“generator function”是个包含yield的函数,返回结果是个可以被for循环或python内置函数next()遍历的iterator。

Usually refers to a generator function, but may refer to a generator iterator in some contexts. In cases where the intended meaning isn’t clear, using the full terms avoids ambiguity.

“generator”可能指代函数或迭代器,所以最好说全“生成器函数”或“生成器迭代器”而不只是说“生成器”。

Generator iterator is an object created by a generator function.

Each yield temporarily suspends processing, remembering the location execution state (including local variables and pending try-statements). When the generator iterator resumes, it picks up where it left off (in contrast to functions which start fresh on every invocation).

每个yield都会暂时中止处理,记住位置执行状态(包括局部变量和待处理的try语句)。当生成器迭代器恢复时,它会从上次中断的地方继续执行(与每次调用时都从头开始的函数不同)。

即,调用包含yield的函数会返回一个iterator,每次调用next(iterator)的时候函数就会运行到下一个yield处,python会记录这个yield的位置状态,下次next(iterator)从这里开始运行函数

def test(): |

根据上述官方文档,这里的<class 'generator'>实际上是个”generator iterator”。这里的<class 'function'>实际上是个”generator function”。

generator expression

以前常用的下面这种写法也是个generator,()括号里面写一个循环(必须有括号)。x = (i*i for i in range(10))

print(type(x))

<class 'generator'>

>>> for i in x:

print(i)

0

1

4

9

16

25

36

49

64

81

实际上相当于下面这种写法。def genEx(num):

i = 0

while i < num:

yield i * i

i = i + 1

x = genEx(10)

for i in x:

print(i)

在上面这种只需要print结果的情况里,其实yield可以直接替换成print。

但很多时候不是需要打印而是需要取用这个值,如果把(i * i)存入其他容器也可实现相同功能。yield为这种情况提供了方便。

yield写斐波那契数列

The Fibonacci sequence is the series of numbers where each number is the sum of the two preceding numbers. For example, 0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144, 233, 377, 610, …def fib(limit): # a generator function

a, b = 0, 1

while (b < limit):

yield b

a, b = b, a + b

x = fib(200) # a generator iterator

for i in x:

print(i)

1

1

2

3

5

8

13

21

34

55

89

144

>>>

numpy dot

矩陣點乘,但向量其實是特殊處理的:

在數學上,點乘需要一個行向量和一個列向量:

但 NumPy 的 1D 陣列已隱含了這個行為。只要兩個 1D 陣列長度相等,它會自動將一個看作「行」,另一個看作「列」,執行點乘運算。因此,不需要手動轉置。

範例

import numpy as np |

如果明確定義行或列向量

如果需要明確區分行向量或列向量,可以使用 2D 陣列來表示:

列向量:v_col = np.array([[1], [2], [3]])(形狀是 3×1)

行向量:v_row = np.array([[1, 2, 3]])(形狀是 1×3)

這時候計算點乘就需要遵守矩陣乘法的規則。

範例:行與列向量操作v_row = np.array([[1, 2, 3]]) # 行向量

v_col = np.array([[4], [5], [6]]) # 列向量

# 行向量乘列向量 (結果是標量)

result = np.dot(v_row, v_col)

print("行向量 * 列向量的結果:")

print(result) # 結果是 [[32]]

# 列向量乘行向量 (結果是矩陣)

result2 = np.dot(v_col, v_row)

print("列向量 * 行向量的結果:")

print(result2) # 結果是 3x3 矩陣

輸出:行向量 * 列向量的結果:

[[32]]

列向量 * 行向量的結果:

[[ 4 8 12]

[ 5 10 15]

[ 6 12 18]]

numpy裡想取一行是array[i],想取一列是array[:,j]。

chatgpt輔助寫代碼實在是太好用了,語法這方面絕對的百科全書。

lambda

lambda 是 Python 中用来创建匿名函数(没有名字的函数)的一种表达式。它非常简洁,但功能强大,适合用在一些简单的场景。

基本语法

lambda 参数1, 参数2, ...: 表达式 |

- 参数:可以有多个参数,类似于常规函数定义。

- 表达式:只能包含一个表达式,表达式的计算结果即为返回值。

示例

- 简单的用法

# 普通函数定义

def add(x, y):

return x + y

# lambda表达式

add_lambda = lambda x, y: x + y

print(add(3, 5)) # 输出 8

print(add_lambda(3, 5)) # 输出 8 - 作为内联函数

常用在需要短小函数的场景,例如 map()、filter()、sorted() 等。- 跟map()配合

nums = [1, 2, 3, 4]

squared = map(lambda x: x ** 2, nums)

print(list(squared)) # 输出 [1, 4, 9, 16] - 与filter()配合

nums = [1, 2, 3, 4, 5]

even = filter(lambda x: x % 2 == 0, nums)

print(list(even)) # 输出 [2, 4] - 跟sorted()配合

words = ["apple", "banana", "cherry"]

sorted_words = sorted(words, key=lambda x: len(x))

print(sorted_words) # 输出 ['apple', 'cherry', 'banana']

- 跟map()配合

- 作为函数参数

可以直接将 lambda 函数传递给其他函数作为参数。def apply_function(func, value):

return func(value)

result = apply_function(lambda x: x * 2, 10)

print(result) # 输出 20

优缺点

优点:

- 简洁,适合定义简单逻辑。可以轻松传递小函数。

缺点:

- 只能写单一表达式,功能有限。

- 可读性较差,复杂逻辑建议使用 def 定义常规函数。

使用建议:

- 当逻辑非常简单且不会重复使用时,用 lambda。

- 复杂逻辑或需要调试时,使用 def 明确定义函数。

广播broadcast

| A.shape | B.shape | Resulting Shape | 说明 |

|---|---|---|---|

| (3, 4) | (3, 4) | (3, 4) | 相同形状,逐元素操作 |

| (3, 4) | (1, 4) | (3, 4) | B 的第 0 维度广播为 3,变成(3, 4) |

| (3, 4) | (4,) | (3, 4) | B 增加维度后广播为 (1, 4),再把第 0 维广播为(3, 4) |

| (3, 1, 4) | (1, 2, 4) | (3, 2, 4) | 高维度逐维广播 |

| (3, 4) | () | (3, 4) | 标量广播为 (3, 4) |

| (3, 4) | (2, 4) | Error | 形状不兼容,无法广播 |

广播其实就是把两个矩阵补成一样大小。

注意⚠️:

- 广播的结果只是虚拟扩展,并不真的复制数据,因此它的内存和计算效率都很高。

如果不确定广播的结果,可以使用 np.broadcast_shapes 或 np.broadcast_to 来检查或预览。

# 检查广播后形状

np.broadcast_shapes((3, 4), (1, 4)) # 输出 (3, 4)标量:

A = np.ones((3, 4))

B = 2 # 标量

C = A + B # B 会广播为 (3, 4) 进行相加- 高维度例如(3, 1, 4)和(1, 2, 4)

- 第 0 维:3 和 1 -> 广播为 3。

- 第 1 维:1 和 2 -> 广播为 2。

- 第 2 维:4 和 4 -> 保持不变。

- 最终广播结果为 (3, 2, 4)

A = np.ones((3, 1, 4))

B = np.ones((1, 2, 4))

C = A + B # 广播为 (3, 2, 4)

random

| 特性 | np.random.rand |

np.random.randn |

|---|---|---|

| 生成分布 | 均勻分布(Uniform distribution) | 標準正態分布(Standard normal distribution, 均值 0,方差 1) |

| 數值範圍 | $[0, 1)$ | 理論上為 $(-\infty, +\infty)$,但集中於約 $[-3, 3]$ |

| 輸出數值類型 | 浮點數(float) | 浮點數(float) |

| 用途 | 模擬隨機比例、概率等均勻分布的數據 | 模擬中心為 0 且有波動的隨機數據,適用於神經網絡初始化等場景 |

| 場景 | np.random.rand 用法 |

np.random.randn 用法 |

|---|---|---|

| 模擬隨機概率 | 用於生成隨機概率數據,例如蒙特卡洛模擬 | 不適用 |

| 數據增強 | 隨機調整數據(添加隨機偏差) | 添加噪聲,用於模型訓練的數據增強 |

| 神經網絡初始化 | 初始化介於 $[0, 1)$ 的權重 | 初始化符合正態分布的權重,中心為 0,標準差為 1 |

| 隨機測試 | 在 $[0, 1)$ 中隨機生成測試數據 | 模擬符合正態分布的隨機測試數據 |

numpy/

├── random/ # numpy.random 模組

│ ├── Generator # 現代化的隨機數生成器 (建議用)

│ ├── RandomState # 傳統的隨機數生成接口

│ ├── rand() # 均勻分布隨機數 (RandomState 方法)

│ ├── randn() # 標準正態分布隨機數 (RandomState 方法)

│ ├── randint() # 整數隨機數生成

│ ├── normal() # 通用正態分布隨機數生成

│ ├── uniform() # 通用均勻分布隨機數生成

│ ├── seed() # 設置隨機種子

│ ├── …

| 方法 | 功能 |

|---|---|

np.random.rand |

生成均勻分布的隨機數,範圍為 $[0, 1)$。 |

np.random.randn |

生成標準正態分布(均值為 0,標準差為 1)的隨機數。 |

np.random.randint |

生成隨機整數,可以指定範圍和大小。 |

np.random.uniform |

生成均勻分布的隨機數,可以指定範圍,例如 $[a, b)$。 |

np.random.normal |

生成正態分布的隨機數,可以指定均值和標準差。 |

np.random.choice |

從給定的序列中隨機選取元素,可以指定抽樣數量和是否放回。 |

np.random.shuffle |

就地打亂給定的數組(改變原數組順序)。 |

np.random.permutation |

返回給定數組的隨機排列(不改變原數組)。 |

np.random.seed |

設置隨機數生成器的種子,用於保證實驗的可重現性。 |

np.random.beta |

生成 Beta 分布隨機數。 |

np.random.binomial |

生成二項分布隨機數。 |

np.random.poisson |

生成泊松分布隨機數。 |

np.random.exponential |

生成指數分布隨機數。 |

seed = 231 # 如果不設定 seed,兩個 random 每次的值就都不一樣,設定了就永遠一樣 |

生成所需區間的隨機數,比如[a, b):$(b - a)random + a$(b - a) * np.random.rand() + a

(b - a) * torch.rand(1, 1) + a

double rand_range(double a, double b) { |

星號*

np.random.rand(x.shape)是不行的,np.random.rand(x.shape[0], x.shape[1], x.shape[2])這樣可以,或者用*。

np.random.rand(*x.shape),在這裡, 是一個*解包運算符(unpacking operator),它將 x.shape 元組的每個元素作為獨立參數傳入。

* 是 Python 的解包運算符,主要用來將 可迭代對象(如列表、元組)展開為單獨的元素。

在函數調用中,* 可以用來將列表或元組中的元素作為多個獨立的參數傳入函數。

torch.rand(*size, *, generator=None, out=None, dtype=None, layout=torch.strided, device=None, requires_grad=False, pin_memory=False) → Tensor

pad

numpy.pad(array, pad_width, mode='constant', **kwargs) |

| 参数 | 说明 | 示例 |

|---|---|---|

array |

要填充的数组,支持任意维度 | np.array([1, 2, 3]) |

pad_width |

填充宽度,可以是整数、元组或元组列表 | 2 (所有维度前后各填充 2 个);((1, 1), (2, 2))(每维单独指定) |

mode |

填充模式,常用模式如下: | |

'constant' |

填充固定值,默认值为 0,可通过 constant_values 指定 |

np.pad([1, 2], 2, mode='constant', constant_values=9) -> [9, 9, 1, 2, 9, 9] |

'edge' |

用边界值填充 | np.pad([1, 2], 2, mode='edge') -> [1, 1, 1, 2, 2, 2] |

'symmetric' |

对称填充(包括边界) | np.pad([1, 2], 2, mode='symmetric') -> [2, 1, 1, 2, 1, 1, 2] |

'reflect' |

镜像填充(不包括边界) | np.pad([1, 2], 2, mode='reflect') -> [2, 1, 2, 1, 2, 1] |

'wrap' |

环绕填充 | np.pad([1, 2, 3], 2, mode='wrap') -> [3, 1, 2, 3, 1, 2, 3, 1] |

| 其他参数 | 根据模式指定额外参数 | |

constant_values |

在 constant 模式下指定填充值 |

np.pad([1, 2], 2, mode='constant', constant_values=5) -> [5, 5, 1, 2, 5, 5] |

array改變形狀

transpose和moveaxis

N, C, H, W = 2, 3, 4, 5 |

本质上,moveaxis 是 transpose 的封装,简化了多维轴变换的操作,但效果和 transpose 相同。

reshape

np.array_equal(x.transpose(1, 0, 2, 3), x.reshape(C, N, H, W)) |

reshape:改变形状,不改变数据的顺序。它不能实现轴的重新排列效果。

transpose:调整轴的顺序,可能导致数据的逻辑顺序发生变化。

moveaxis:更灵活的轴变换,与 transpose 作用相同。

import numpy as np |

array擴展

np.tile(A, reps) 用于重复数组,将输入数组沿指定维度扩展成更大的数组。

- A:输入数组。

- reps:整数或元组,表示每个维度重复的次数。

import numpy as np

# 1維重複3次

print(np.tile([1, 2], 3)) # [1 2 1 2 1 2]

print(np.tile([[1, 2], [3, 4]], (2, 3))) # 1維(行)重複兩次,2維(列)重複三次

# [[1 2 1 2 1 2]

# [3 4 3 4 3 4]

# [1 2 1 2 1 2]

# [3 4 3 4 3 4]]

concatenation拼接

使用 + 操作符(對於列表)或 numpy.concatenate() 函數(對於數組)。

list直接相+。

torch裡跟numpy的操作是幾乎一樣的,所以很方便。

import numpy as np |

torchvision.transforms

One of our former instructors, Justin Johnson, made an excellent tutorial for PyTorch.

You can also find the detailed API doc here. If you have other questions that are not addressed by the API docs, the PyTorch forum is a much better place to ask than StackOverflow.

import torchvision.transforms as T |

Compose()

將多個圖像預處理操作組合成一個序列,就是打包預處理。

比如其中第一個T.ToTensor()就是把圖像轉成Tensor數據類型。另外還可以做Resize和CenterCrop之類的操作。查上面的libraries/torchvision文檔。

Normalize()

torchvision.transforms.Normalize(mean, std) |

- mean:是一个列表或元组,包含每个通道的均值(例如,对于 RGB 图像,可以是

[R_mean, G_mean, B_mean])。 - std:是一个列表或元组,包含每个通道的标准差(例如,对于 RGB 图像,可以是

[R_std, G_std, B_std])。

每個通道分別減去所有圖像的統計量。

torch.nn.Sequential()

跟上面的Compose()很像就一塊說了。

model = torch.nn.Sequential( |

這個是打包網絡層方便前後向計算。

DataLoader

from torch.utils.data import DataLoader |

torchvision.datasets.CIFAR10加載數據集:

- root時存儲路徑,如果沒有且download=True會自動下載,

- train=True加載訓練集(data_batch_1/2/3/4/5),False加載測試集(test_batch)

- transform就是預處理

這裡如果不 ToTensor() 返回的不是 Python 列表 (List) ,也不是numpy.ndarray,是 PIL.Image.Image 對象。

- 数据转换 是在 Dataset 对象创建时完成的(通过 transform)。

- 数据加载和批处理 是在 DataLoader 中进行的。

PIL/Pillow

from PIL import Image |

PIL 是 Python Imaging Library,Initial release 是1995年,Pillow 是 2010 年 forked 這個 PIL repository 並支持 Python 3.x 的繼任者。

為什麼需要DataLoader?

上面用 torchvision.datasets 用 PIL 讀取數據並轉為 Tensor之後,用DataLoader轉為torch.utils.data.dataloader.DataLoader。

這裡不用 sampler 用 shuffle=True 的話是打亂整個數據集,跟 SubsetRandomSampler 也差不多,都是不放回的隨機抽樣。全部輸入一遍就是一個epoch,一個minibatch是一個iteration。loader_train = DataLoader(cifar10_train, batch_size=64, sampler=sampler.SubsetRandomSampler(range(NUM_TRAIN)))

for data, target in loader_train:

print(data.device) # 检查每个批次数据的设备,返回“cpu”

break # 只查看第一个批次

其中,cifar10_train 是 Tensor 原數據集,batch_size 是每個 minibatch 的大小,sampler 是採樣 minibatch 的方法,這裡是從索引 0 到 49000 隨機取 64 個。

- 提前分好 minibatches 比較方便,assignment 1/2 裡的 /cs231n/solver 都是在

_step()裡用batch_mask = np.random.choice(num_train, self.batch_size)現取; - DataLoader 負責分批把數據加載到內存,節省 CPU Memory;

- 支持多線程並行加載數據,用

DataLoader(..., num_workers=4)可以加速讀數據;

PyTorch vs. Numpy

在Lecture 8討論過Pytorch相比Tensorflow除了一個Dynamic vs. Static的優勢之外,還有就是類似numpy所以上手快。

所以在這整理一點兒用到過的等價操作,以供查閱,以防混淆。

| Pytorch | Numpy | |

|---|---|---|

| torch.Tensor | numpy.ndarray | 相似數據類型 |

| Tensor.view() | ndarray.reshape() / numpy.reshape() | 數據結構內置 |

| torch.arange() | range() | 前者生成Tensor後者生成list |

| Tensor.matmul() | ndarray.dot() | 矩陣乘 Matrix Multiplication,python 3.5後可以用 @,相當於 matmul 和 dot 的語法糖。对于高维张量:执行广播规则,然后对最后两个维度进行矩阵乘法。 |

| Tensor.dot() | ndarray.dot() | 只能接受兩個一維向量計算內積 |

| Tensor.mm() | ndarray.dot() | 只能接受兩個二維矩陣算矩陣乘法,但因為底層實現比matmul()簡單所以大概更快 |

| * | * | 廣播逐元素乘 broadcast elementwise |

| torch.rand / torch.randn | numpy.random.rand / numpy.random.randn | 討論過numpy,torch用法跟numpy有點細微區別在下面補充一下吧 |

| s.gather(1, y.view(-1, 1)).squeeze() | s[np.arange(N), y] | Tensor[range(len(y)), y]也可以啊…好像不需要gather這個語法了 |

| torch.tensor(), torch.Tensor() | np.array() np.asarray() | 轉類型 |

| torch.cat((A,B),dim=0) | np.concatenate((A,B),axis=0) | 拼接 |

| Tensor.permute() | numpy.transpose() | 轉置,之前還總結過跟moveaxis的區別 |

這次能一個月做完也多虧了 chatgpt,2022 年末在商湯時 chatgpt 突然爆火,當時如果能用熟的話也不至於那麼菜。

seed = 231 # 如果不設定 seed,兩個 random 每次的值就都不一樣,設定了就永遠一樣 |

requires_grad和Pytorch裡的computational graph

w = torch.randn(shape, device=device, dtype=dtype) * np.sqrt(2. / fan_in) |

初始化 weights 的 requires_grad 應該用這種寫法,如果寫到torch.randn裡是錯誤的。w = torch.randn(shape, device=device, dtype=dtype, requires_grad=True) * np.sqrt(2. / fan_in)

# tensor([[0.6324]], device='cuda:0', grad_fn=<MulBackward0>)

當輸出顯示requires_grad=True的時候表示 w 在計算圖裡沒有反向傳播的 gradient function,grad_fn=<MulBackward0>表示一個計算圖的節點。

這裡的 grad_fn (gradient function) 是一個指向反向傳播函數的引用,MulBackward0 表示這個反向傳播的 node 用逐元素乘 gradient function,除此之外還有 MatMulBackward (矩陣乘) / AddBackward (加) / DivBackward (除) 等。(其中 0 不知道代表什麼,測試過重複乘並不會變成 1。)

* np.sqrt(2. / fan_in)這個操作相當於在 計算圖 裡加入了一個 乘法 節點(torch.autograd),反向傳播的時候會錯誤地給 dw 再乘上這個初始化操作* np.sqrt(2. / fan_in)。

關於torch.no_grad()

首先捋一遍pytorch梯度更新過程:

output = model(x)前向傳播,生成計算圖;loss = torch.nn.CrossEntropyLoss(output, label)計算損失;loss.backward計算所有requires_grad=True的節點構成的計算圖,用每一個node的grad_fn計算梯度,存到參數Tensor的.grad屬性(attribute)裡面;- 更新參數(nn.Module / nn.Sequential): 或者像assignment裡的barebone一樣手動操作:

optimizer = torch.optim.SGD(model.parameters(), lr=learning_rate) # 定義優化器

optimizer.step() # 用每個參數的.grad更新

optimizer.zero_grad() # 清空.grad梯度with torch.no_grad():

for w in params:

w -= learning_rate * w.grad

# Manually zero the gradients after running the backward pass

w.grad.zero_()

在不需要反向傳播的時候就需要 torch.no_grad() 阻止 output = model(x) 生成計算圖,以節省推理時的內存和時間。

| API | Flexibility | Convenience |

|---|---|---|

| Barebone | High | Low |

nn.Module |

High | Medium |

nn.Sequential |

Low | High |

Barebone:output = torch.nn.functional.conv2d(input, weight, bias=None, stride=1, padding=0, dilation=1, groups=1) → Tensor

nn.Module:conv = torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True, padding_mode='zeros', device=None, dtype=None)

output = conv(input)

除了 optimizer 有區別,用 nn.Module/nn.Sequential 這樣的寫法不用在外部定義繁瑣的 weights 再傳進去。

傳參:可變對象 vs. 不可變對象

不像 C 裡面傳參只能通過傳變量指針的方式 void fn(int *var) 在函數內部修改變量,python 有兩種對象:

- 可變對象 (Mutable objects): list, dict 或是被訓練的 torch.nn.Module 都是可變對象,在函數內修改後函數外也可以看到變化;

- 不可變對象 (Immutable objects): int, float, tuple, str 跟 C 裡一樣,函數裡使用的時候其實是創造了一個新對象,函數內修改不會影響到函數外的變量本身。

def fn(aaa):

aaa.append(1)

return

bbb = [0]

fn(bbb) # a list is a mutable object

print(bbb)

[0, 1]

def fn(ccc):

ccc += 1

return

ddd = 0

fn(ddd) # an integer is an immutable object

print(ddd)

0

所以訓練完 torch.nn.Module 子類 對象 model 之後是不需要返回的,函數內已經改變了 model 的 parameters 為優化後結果。

這裡的 Module 父類除了 forward() 之外還有 parameters() 可以返回模型中所有可學習的參數。

model.eval()

model.eval() 是为了将模型设置为评估模式,主要影响 Dropout 和 BatchNorm 层。

- 在评估模式下,Dropout 层不会丢弃神经元,而是使用所有神经元的输出;

- BatchNorm 层会使用训练时计算的全局均值和方差。

訓練時要調到 model.train() 模式。

零碎pytorch

torch.flip和transforms.RandomHorizontalFlip 和 transforms.RandomVerticalFlip有兩種flip。

transforms.RandomApply([operation], p=0.5)可以讓 torchvision.transforms 在某個概率下執行,不知道ToTensor()這種和nn.Linear()可不可以生效。

grayscale灰度圖像轉換公式:Y=0.2989×R+0.5870×G+0.1140×B,

transforms.Grayscale(num_output_channels=1),設置成 3 的話 3 個通道都是一樣的灰度值。ass裡是設成 3 了。

cosine similarity又叫 normalized dot product 歸一化點積。

torch.masked_select(input, mask, *, out=None) 應用mask後會把mask=True的元素平鋪成一個 1 維 tensor 返回。

torchvision.utils.make_grid(images) 把多張圖拼成一個大圖。

keepdim=True

- sum()

- mean()

- std()

- max()

- min()

- prod()

- argmax()

- argmin()

以上這些函數都可以 keepdim,比如對 N, D 維度的 tensor x 做 x.sum(dim=1) 結果是 torch.Size([10]) 而 x.sum(dim=1, keepdim=True) 結果是 torch.Size([10, 1]) 。

最好想清楚廣播或者後續計算需不需要保持維度一致,ass3的simclr的contrastive_loss.py裡面sim_positive_pairs就因為這個結果錯了。

使用預訓練resent

用simclr的代碼做例子。

import torch |

用 pytorch 真的很簡單。

數學

矩阵计算加速

反直觉的简化公式。

这些公式的反直觉点在于:

- 避免直接操作整个矩阵或高维数据,通过预处理(如点积、模长)简化计算。

- 利用代数性质减少重复计算,如平方展开、trace 操作。

- 通过广播机制和维度扩展,实现高效并行计算。

1. L2距离矩阵

L2 中的 “L” 是 “norm” 的缩写来源,表示范数(norm)的符号约定。“L” 最早来源于法语数学文献中用于 Lebesgue 空间($L^p$-spaces)的符号,它现在广泛用于表示函数和向量范数。

问题:给定两个矩阵 $A \in \mathbb{R}^{m \times n}$ 和 $B \in \mathbb{R}^{p \times n}$,计算两组向量之间的欧几里得距离矩阵 $D$,形状为 $(m, p)$。

公式:

简化:

解释:

- 利用 $A \cdot B^T$ 点积高效计算向量间的关系。

KNN计算(500,3072)和(5000,3072)得到(500,5000)的两两图片距离矩阵时,有两种做法:

第一种:

I. 直接通过广播计算一个 $(500, 3072) - (5000, 3072)$ 得到 $(500, 5000)$ 的矩阵?

我们需要计算一个矩阵 $\mathbf{C} \in \mathbb{R}^{500 \times 5000}$,其中每个元素为:

或展开为:

直接广播计算的步骤

输入矩阵形状

- $\mathbf{A} \in \mathbb{R}^{500 \times 3072}$

- $\mathbf{B} \in \mathbb{R}^{5000 \times 3072}$

扩展维度

- 将 $\mathbf{A}$ 扩展为 $(500, 1, 3072)$:

- 将 $\mathbf{B}$ 扩展为 $(1, 5000, 3072)$:

广播相减

- 利用广播机制直接相减,结果是形状为 $(500, 5000, 3072)$ 的 3D 矩阵:

计算平方差

- 对最后一个维度(即 3072)计算平方和,得到形状为 $(500, 5000)$ 的矩阵:

完整代码实现

import numpy as np |

问题

“直接广播可能导致内存不足”的原因是 广播机制会在内存中创建一个扩展后的高维临时数组。

对于形状为 $ (500, 3072) $ 的矩阵 $ A $ 和 $ (5000, 3072) $ 的矩阵 $ B $:

- 扩展后它们会形成 $ (500, 1, 3072) $ 和 $ (1, 5000, 3072) $。

- 相减后生成一个 $ (500, 5000, 3072) $ 的 3D 数组。

这个 3D 数组需要存储 $ 500 \times 5000 \times 3072 $ 个浮点数,占用约 76 GB(若每个浮点数占 8 字节)。

对于大规模数据,内存无法承受,因此直接广播操作会报错或导致性能问题。

使用范数分解公式避免构造高维中间数组,可以极大节省内存。

第二种:

II. 优化方法:使用范数分解公式

由于直接广播会创建一个巨大的 $(500, 5000, 3072)$ 的临时数组,可能导致内存不足,我们可以利用范数分解公式优化计算。

公式展开为:

优化后的步骤

预先计算每行向量的平方和:

- 对于 $\mathbf{A}$,计算 $|\mathbf{A}[i, :]|^2$:

- 对于 $\mathbf{B}$,计算 $|\mathbf{B}[j, :]|^2$:

计算点积:

合并结果:

优化代码实现

# 计算每行向量的平方和 |

两种方法对比

| 方法 | 内存占用 | 计算速度 | 适用场景 |

|---|---|---|---|

| 直接广播相减 | 高(需要创建 3D 数组) | 简单实现 | 小规模矩阵 |

| 范数分解公式 | 低(避免创建 3D 数组) | 更高效 | 大规模矩阵 |

2. 余弦相似度矩阵

问题:给定矩阵 $A$ 和 $B$,计算两组向量的余弦相似度矩阵:

简化:

解释:

- 先计算点积 $A \cdot B^T$。

- 再将每行的模长预计算为一个列向量,最后进行广播除法。

3. 矩阵 Frobenius 范数的平方

Frobenius 范数:

如果需要计算两个矩阵 $A$ 和 $B$ 之间的差的 Frobenius 范数:

解释:

- 通过展开 $| A - B |_F^2$,简化计算,避免构造 $A - B$。

4. 交叉熵损失的高效计算

交叉熵损失公式:

如果 $y$ 是 one-hot 编码的标签,交叉熵可以简化为直接取预测的正确类别的概率对数:

解释:

- 不需要计算 $y$ 和 $\hat{y}$ 的逐元素乘积,只需取索引值。

5. 矩阵的平方和(双循环的优化)

直接计算矩阵 $A \in \mathbb{R}^{m \times n}$ 中每对行向量的平方和:

可以化简为:

解释:

- 避免显式计算所有对的组合,通过提前计算模长和点积直接构造。

6. 矩阵乘法优化(维度分解)

如果需要计算 $C = A^T A$,其中 $A \in \mathbb{R}^{m \times n}$,可通过分块减少乘法次数:

- 普通算法时间复杂度为 $O(m^2 n)$。

- 利用分块或对称性质,可以优化为 $O(m^2)$。

矩陣求導,要轉置

矩阵C=AB那C对A的导数是B的转置,C对B的导数是A的转置。

假设 $C = A \cdot B$,则矩阵求导结果如下:

$C$ 对 $A$ 的导数:

因为 $A$ 的每个元素对 $C$ 的每个元素的贡献是通过 $B$ 的列影响的。

$C$ 对 $B$ 的导数:

因为 $B$ 的每个元素对 $C$ 的每个元素的贡献是通过 $A$ 的行影响的。

例子验证

假设:

计算 $C = A \cdot B$:

对 $A$ 求导(结果为 $B^T$):

对 $B$ 求导(结果为 $A^T$):(在矩陣乘法裡,A的1和2,只會受到B的5和7影響;對A的3和4來說只有B的6和8會影響結果,所以正好轉置過來)

商的求导法则

如果函数为 $\frac{u(x)}{v(x)}$,其导数公式是:

例子 1: $ \frac{x}{x+1} $ 的导数

设 $u = x$,$v = x+1$:

- $u’ = 1$,$v’ = 1$。

代入公式:

例子 2: $ \frac{x^2}{x+2} $ 的导数

设 $u = x^2$,$v = x+2$:

- $u’ = 2x$,$v’ = 1$。

代入公式:

化简:

幂函数的求导公式

如果 $f(x) = x^n$,对 $x$ 求导,我们直接应用幂函数的求导公式:

这是基本的导数公式,其中:

- $n$ 是常数,

- $x^{n-1}$ 是 $x$ 的幂次降低1后的表达式。

例如:

- 若 $f(x) = x^3$,则 $f’(x) = 3x^2$;

- 若 $f(x) = x^{-2}$,则 $f’(x) = -2x^{-3}$;

- 若 $f(x) = x^{1/2}$,则 $f’(x) = \frac{1}{2}x^{-1/2} = \frac{1}{2\sqrt{x}}$。

正則項的偏導

对于正则化项:

$

\text{Regularization} = \text{reg} \cdot \left(|W_1|_F^2 + |W_2|_F^2\right)

$

计算对各参数的偏导:

对 $W_2$:

$

\frac{\partial \text{Regularization}}{\partial W_2} = 2 \cdot \text{reg} \cdot W_2

$对 $b_2$:

$

\frac{\partial \text{Regularization}}{\partial b_2} = 0

$

因为正则化不包含偏置。对 $W_1$:

$

\frac{\partial \text{Regularization}}{\partial W_1} = 2 \cdot \text{reg} \cdot W_1

$对 $b_1$:

$

\frac{\partial \text{Regularization}}{\partial b_1} = 0

$

总结:

- 正则化项仅对权重 $W_1$ 和 $W_2$ 起作用,偏导为 $2 \cdot \text{reg} \cdot W$。

- 偏置 $b_1$ 和 $b_2$ 的偏导为零。

- 對 $dx$ 的偏導也是0,梯度往前傳遞是靠 $dx$ 。

b1不是input_dim,b2不是hidden_dim:

self.params['W1'] = np.random.normal(loc=0.0, scale=weight_scale, size=(input_dim, hidden_dim)) |

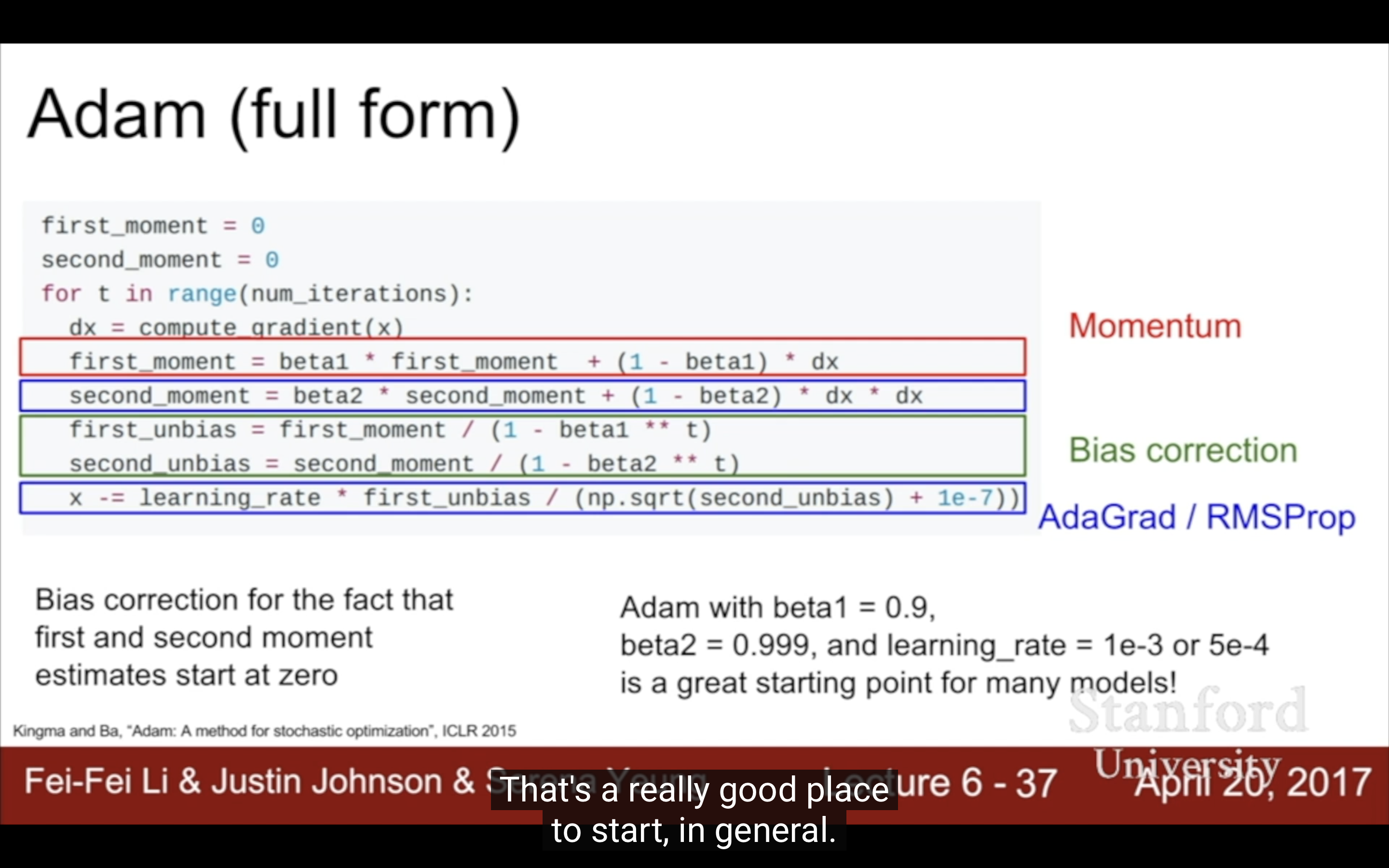

Adam優化版

如果你看到的 Adam 公式版本中没有显式的 $t$(时间步),那可能是省略了 $t$ 的具体表示形式。但实际上,Adam 的完整公式中 $t$ 隐含在动量更新和偏差校正因子中。以下是 Adam 优化器的完整公式:

一阶动量(梯度的指数加权平均):

二阶动量(梯度平方的指数加权平均):

偏差校正(修正初期估计的偏向零问题):

参数更新:

这里的 $t$ 是显式表示每个时间步的迭代次数,用于偏差校正因子的计算。在实际实现中,时间步通常由代码中的循环或计数器隐式管理,因此部分文档可能会省略 $t$ 的具体表示。

如果你看到的公式中没有偏差校正因子的部分,可能是简化版本,忽略了初期动量估计偏差的影响。这种版本常用于直观解释或早期实现中。

beta ** t,t越大m_hat就越大,防止一開始過小的問題。

对数的商的性质

其中 $a > 0, b > 0$,对数的底可以是任意正数(通常是 10 或 $e$,但不能是 1)。

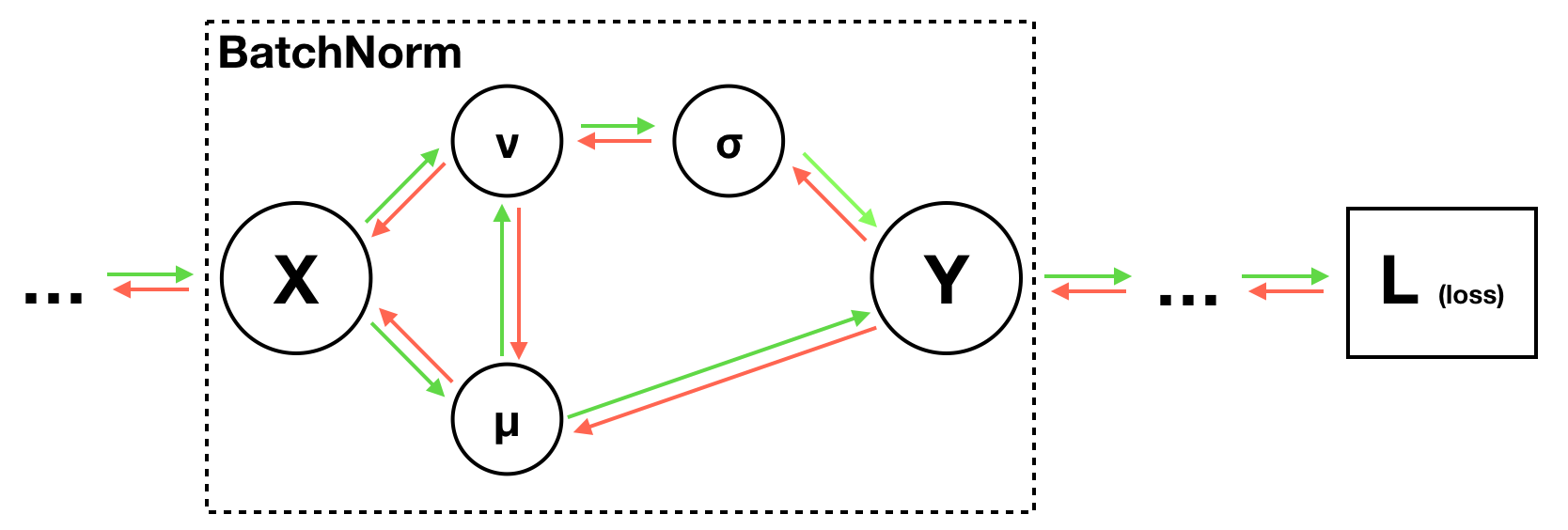

BN的梯度

1. Batch Normalization (BN) 层的梯度计算

Batch Normalization 的反向传播较为复杂,因为它涉及多个步骤的链式法则计算。下面是完整推导过程和实现思路:

BN 前向传播公式

给定输入 $x_i$:

- 计算均值和方差:

- 标准化:

- 应用缩放和平移(可学习参数 $\gamma$ 和 $\beta$):

BN 反向传播公式

1. 梯度传播关系

BN 的输出 $y_i$ 的梯度通过链式法则回传:

因此,关键在于计算 $\frac{\partial y_i}{\partial x_i}$。

2. 分步骤求解

对 $\gamma$ 和 $\beta$ 的梯度:

对 $\hat{x}_i$ 的梯度:

3. 對 $ x_i $ 的梯度需要$\frac{\partial \mu}{\partial x_i}, \frac{\partial v}{\partial x_i}, \frac{\partial \sigma}{\partial v}, \frac{\partial Y}{\partial \sigma}$, and $\frac{\partial Y}{\partial \mu}$

計算圖裡的var和mu那條關係可以忽略,可以不走那邊。

$\frac{\partial Y}{\partial \sigma}$, $\frac{\partial Y}{\partial \mu}$其實算的是$\gamma \cdot \frac{\partial \hat{x_i}}{\partial \sigma}$, $\gamma \cdot \frac{\partial \hat{x_i}}{\partial \mu}$。

公式提要:

mean對x的導數:

$\text{mean} = \frac{1}{n} \sum_{i=1}^n x_i$,对 $x_k$ 求导时:方差的導數$\frac{\partial v}{\partial x_i}$:

發現除了$\frac\partial{\partial x_i}, (x_i-\mu)^2=2(x_i - \mu)$都是0,所以

或者把mean也展開就是

standard deviation標準差對variance方差的導數很好求,就是幂函数的求导公式,$\sigma=\sqrt{v+\epsilon}$導數是$\sigma’=\frac{1}{2\sqrt{v+\epsilon}} = \frac{1}{2\sigma}$。

chatgpt說:計算$\frac{x-mean}{std}$對mean和std的偏導時,雖然mean和std都是依賴於x的統計特性,但算一個偏導可以把另一個看作常數:

- $\gamma \cdot (\frac{\partial \hat{x_i}}{\partial \sigma} = \frac{-1}{std})$

- $\gamma \cdot (\frac{\partial \hat{x_i}}{\partial \mu} = -\frac{x - mean}{std^2} = -\frac{x_i-\mu}{std^2})$ 他媽的發現錯誤原因是這倆求反了,下面也代入反了,一下午打水漂。chatgpt說的是對的,計算後證明這倆反過來算對了。但事實證明不對,而且沒理解好鏈式法則,沒有加上直接項。正確的理解在下面,按下面的公式,這裡其實改寫成$L = f(\Phi, \Psi, \Omega), \Phi = a(x) = x, \Psi = b(x) = mean, \Omega = c(x) = std, f(\Phi, \Psi, \Omega) = \frac{\Phi - \Psi}\Omega$。參考https://kevinzakka.github.io/2016/09/14/batch_normalization/ 1.沒有把另外一個統計量當作常數;2.對$\mu$和$\sigma$的任何求導,根據下文一個變量的導數和他本身維度通常一致,結果應該是個scalar或者vector,所以要求和,我的計算都漏了求和!重新算:

$\frac{\partial Y}{\partial x_i} = \frac{\partial Y}{\partial \hat{x_i}}\frac{\partial \hat{x_i}}{\partial x_i} + \frac{\partial Y}{\partial \sigma}\frac{\partial \sigma}{\partial v}\frac{\partial v}{\partial x_i} + \frac{\partial Y}{\partial \mu}\frac{\partial \mu}{\partial x_i}$ 還差標題的后倆:

- $\frac{\partial Y}{\partial \sigma} = \gamma \cdot \sum_{i=1}^N upstream \cdot \frac{\partial \hat{x_i}}{\partial \sigma}$ 中,

$\frac{\partial v}{\partial \mu}$:

方差公式:

对 $\mu$ 求导数:

将求导运算移入求和符号中:

求单项的导数:

注意到 $\frac{\partial}{\partial \mu} (x_i - \mu) = -1$,代入得:

将结果代入整体公式:

提取常数项 $-2$:

根据均值的定义,$\sum_{i=1}^N (x_i - \mu) = 0$,因为均值是数据的平衡点。

$\frac{\partial Y}{\partial \mu} = \gamma \cdot \sum_{i=1}^N upstream \cdot \frac{\partial \hat{x_i}}{\partial \mu}$ 中,方差和標準差sigma其實也是mean的函數$v=\frac{1}{N}\sum_{k=1}^N (x_k-\mu)^2$,所以根據復合函數鏈式法則:

最後,$\frac{\partial \hat{x_i}}{\partial x_i} = \frac{1}{\sigma}$。

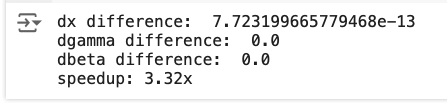

最終,

化簡:

其中的$\gamma \cdot upstream$其實可以合成為$\hat{upstream}$,測試的speedup是3.69x。另外layernorm就把所有的axis=0改成axis=1即可。

論文裡求過偏導了,但算起來比較慢。這樣用計算圖鏈式法則一步到位,雖然手算慢,但電腦運算快。

Note that the batch normalization paper suggests a different test-time behavior: they compute sample mean and variance for each feature using a large number of training images rather than using a running average. For this implementation we have chosen to use running averages instead since they do not require an additional estimation step; the torch7 implementation of batch normalization also uses running averages.

掙扎了大半天時間梯度終於算對了,感謝UCB哥的推導,最後發現了兩個問題,1.我居然忘記算upstream(dout)了,2.求和的對象太關鍵了,求和的範圍是$\mu$,$\sigma$的偏導範圍決定的。這種公式問chatgpt它還是算不明白的,雖然它的結果通常沒錯。

四年前倒在這,直到現在還是不能像他和他們一樣,推導不出來batchnorm_backward_alt就放棄跳過,死磕,不死磕心裡永遠有個結。

2. Dropout 层的梯度计算

Dropout 前向传播

在训练时,Dropout 随机将部分神经元的输出置为 0,以减少过拟合:

- 生成掩码(mask),通常是一个与输入相同形状的矩阵,元素是 0 或 1:其中 $p$ 是保留概率。

- 应用掩码:

在测试时,通常不使用 Dropout,但会将输出按比例缩放 $y = x \cdot p$。

Dropout 反向传播

Dropout 的反向传播非常简单,因为它的梯度只需考虑 mask 的影响:

chain rule 多元複合函數求導法則

我们需要计算 $ z = f(x, y) $ 对 $ t $ 的偏导数,其中 $ f(x, y) = \frac{x - y}{y} $,并且 $ x = g(t) = t^2 $,$ y = h(t) = 2t $。

z = f(x, y)其實就=t/2 - 1,導數是1/2,這個例子對理解BN的梯度computational graph非常有幫助。

因為上面的 $Y = \gamma \cdot \frac{x_i - \mu}{\sigma} + \beta$ 就可以改寫成$L = f(\Phi, \Psi, \Omega), \Phi = a(x) = x, \Psi = b(x) = mean, \Omega = c(x) = std, f(\Phi, \Psi, \Omega) = \frac{\Phi - \Psi}\Omega$。

步骤 1:应用链式法则

根据链式法则:

首先,我们需要计算各个部分的偏导数和导数。

步骤 2:计算 $ f(x, y) = \frac{x - y}{y} $ 对 $ x $ 和 $ y $ 的偏导数

对 $ x $ 的偏导数:

对 $ x $ 求偏导数,视 $ y $ 为常数:

对 $ y $ 的偏导数:

可以用商法则(商的求导法则)来求导:

所以我们得到了:

步骤 3:计算 $ x = g(t) = t^2 $ 和 $ y = h(t) = 2t $ 对 $ t $ 的导数

$ x = t^2 $ 对 $ t $ 的导数:

$ y = 2t $ 对 $ t $ 的导数:

步骤 4:将各部分代入链式法则

将以上结果代入链式法则公式中:

代入具体的表达式:

将 $ x = t^2 $ 和 $ y = 2t $ 代入:

简化:

最终答案:

总结:

通过链式法则,我们计算得到了 $ z $ 对 $ t $ 的偏导数为 $ \frac{1}{2} $。

一個變量的導數和他本身維度通常一致

1. 标量对矩阵的导数

如果标量 $f$ 是矩阵 $\mathbf{X}$ 的函数,那么 $\frac{\partial f}{\partial \mathbf{X}}$ 的结果是一个与 $\mathbf{X}$ 维度相同的矩阵。例如:

其中 $\mathbf{X}$ 是 $n \times m$ 的矩阵,$\mathbf{a}$ 是 $n$-维向量,$\mathbf{b}$ 是 $m$-维向量。那么:

它与 $\mathbf{X}$ 的维度 $n \times m$ 相同。

2. 矩阵对标量的导数

如果矩阵 $\mathbf{X}$ 是标量 $f$ 的导函数(例如梯度),我们也可以得到一个与 $\mathbf{X}$ 维度相同的矩阵:

3. 矩阵对矩阵的导数

如果需要计算一个矩阵对另一个矩阵的导数,例如 $\frac{\partial \mathbf{A}}{\partial \mathbf{B}}$,那么结果通常是一个四维张量。这是因为:

如果 $\mathbf{A}$ 和 $\mathbf{B}$ 的维度分别是 $n \times m$ 和 $p \times q$,则结果是一个 $n \times m \times p \times q$ 的张量。

例如,对于 $\mathbf{A} = \mathbf{B}^2$,结果张量会考虑所有元素的依赖关系。

总结

- 标量对矩阵的导数,结果与矩阵维度相同。

- 矩阵对标量的导数,结果也与矩阵维度相同。

- 矩阵对矩阵的导数,结果通常是一个四维张量,与原矩阵的维度不同。

Notes

https://cs231n.stanford.edu/slides/2017/

https://cs231n.stanford.edu/slides/2024/ 今年的也大差不差,lecture6都是講Batch Normalization,甚至很多圖都一樣。

https://cs231n.github.io notes在這(其實用slides裡的圖片這篇筆記的圖片會很小,但懶得挨個扒,截圖堆成超大圖片屎山了。)

2018,2019 年也都是 Justin Johnson 和 Serena Yeung,slides 完全沒變,不知為啥 Justin Johnson 從 2016 上這門課四年不說, 2019 年又去 Michigan 講了一遍;2020,2021 年是 Ranjay Krishna, Danfei Xu ,2021年有了 Self-Supervised Learning Lecture 13,而且雖然 2019 年就講了 self-attention 和 transformer,2021 年才加入了 assignment;2022 年是 Jiajun Wu, Ruohan Gao;2023 年是 Yunzhu Li, Ruohan Gao,Google Deepmind 去做了 Guest Lecture,講了 VAE 和 2022 年我上班時火遍地球的 Diffusion Models;2024 年是 Ehsan Adeli, Zane Durante,內容幾乎沒變。

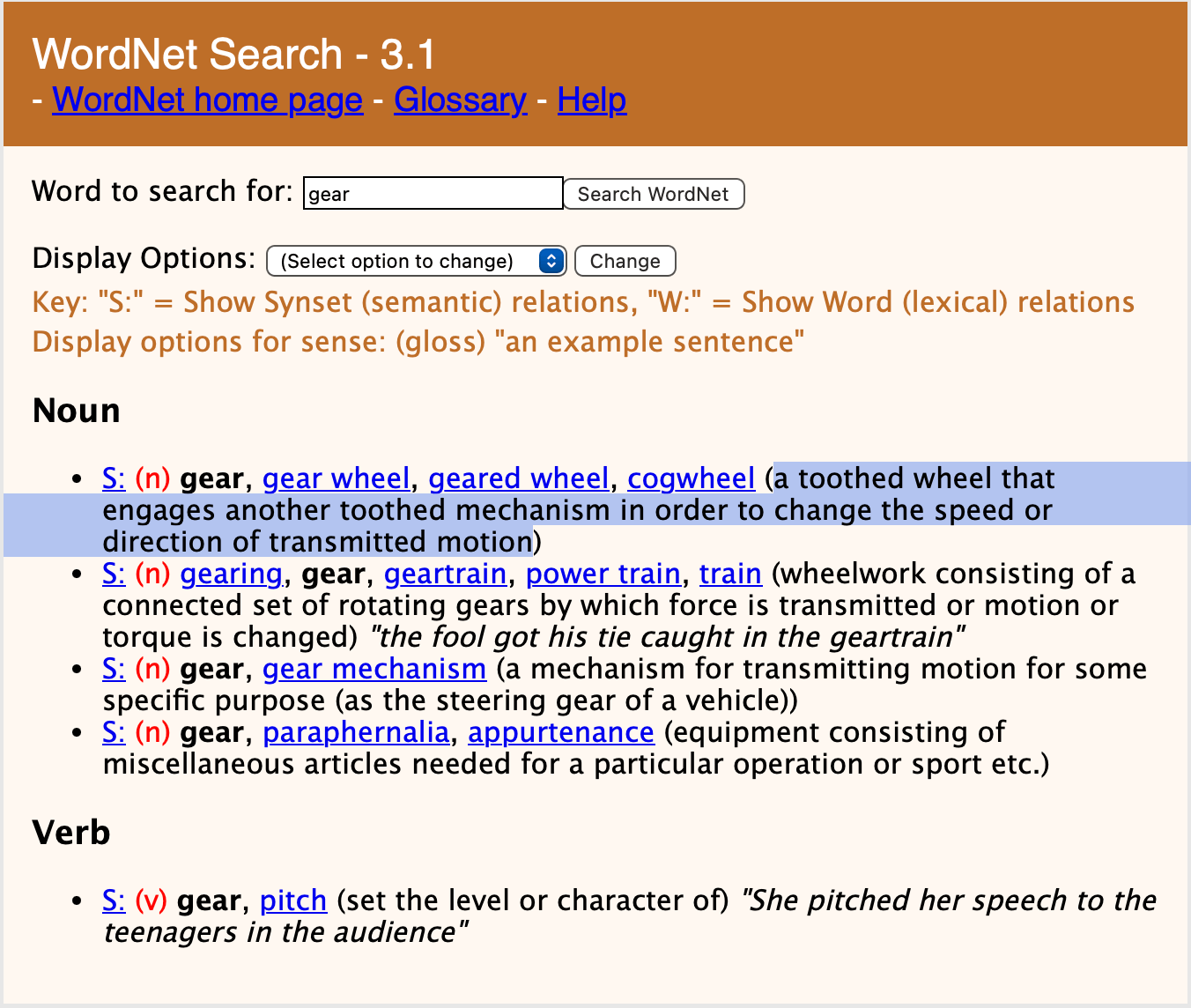

Lecture 1

From PASCAL Visual Object Challenge(20 object categories) to ImageNet (Deng, Dong, Socher, Li, Li, & Fei-Fei 2009). 李飞飞他们花了3年, 从互联网上下billions of images,然后用WorldNet这个词典把图像组织起来(which has tens of thousands of classes),然后用Amazon Mechanical Turk平台排序、清洗、标注图像。然后开放了Large Scale Visual Recognition Challenge,“输入是image,输出是label,用前五个labels是否正确来作为指标”作为benchmark评价进展。2012年CNN(from 1998 LeCun to recognize handwriting digits and addresses for the post office)把error rate从26降到了16,从此一发不可收。

WordNet是一个由普林斯顿大学认识科学实验室在心理学教授乔治·A·米勒的指导下建立和维护的英语字典。开发工作从1985年开始,从此以后该项目接受了超过300万美元的资助(主要来源于对机器翻译有兴趣的政府机构)。

WordNet根据词条的意义将它们分组,每一个具有相同意义的字条组称为一个synset(同义词集合)。WordNet为每一个synset提供了简短,概要的定义,并记录不同synset之间的语义关系。

http://wordnetweb.princeton.edu/perl/webwn

The primary focus of this class is Image Classification (A core task in Computer Vision ), the setup is that your algorithm looks at an image, and then picks from among some fixed set of categories to classify that image. This might seem like somewhat of restrictive or artificial setup, but it’s actually quite general. This problem can be applied in many different settings both in industry and academia and many different places. But in this course we are also gonna talk about several other visual recognition problems that build upon many of the tools that we develop for the purpose of image classification, such as, object detection and image captioning.

这也是我后来一直存在的疑问,当时没仔细看错过了这个关键问题。AI的最终目标比如图像分类这个任务从来不是能识别一切图像,因为视觉信息这个二维量本身就是局限的,通用AI(AGI)的目标是能做出人类所有智能行为的AI,所以超越人类水平已经足够了。

这个技术的价值是能应用到所有场景里,比如在饭店判断菜品的任务里,能超过人的准确率就已经可以接受了。

回顾在商汤做的visual grounding任务,输入“这个垃圾桶是满的”,视觉定位模型找到图像中的垃圾桶并输出“是”“否”满。其实完全能分割成目标检测+图像分类任务,只是因为对这些基础技术太不熟练导致思路模糊,只能跟着团队用OFA人云亦云亦步亦趋。随便搭一个两步的模型对从事这项工作的人来说应该是最基础的事,基础不牢地动山摇。(不过当时团队是侧重于做一个能快速适应新场景的模型,经过几十张甚至0张图片的训练就能检测新任务比如“电动车有没有超载”,但一样也该入职时迅速搭一个两步模型上手任务。)

(关于Justin Johnson这句话的语法,from among的among强调范围,是对的;some set的some表示不确定,set是对的,sets大概也可以)

另外,AI的飞速发展一直让过去的我焦虑,这种焦虑让我不愿意学习当前的sota技术,因为未来某一天就突然会被革新。可现在回头看,雖然沒有新的課堂錄像,但通過課程官網可以看出stanford的cs231n内容几乎从未改变,这足以说明这些老玩意还是新积木的基石。

Lecture 2

Numpy efficiently implements vectorized operations. It’s should be practiced a lot in assignment 1.

就识别猫这个问题来说,通过找到所有edges然后根据猫的特征逐一匹配(耳朵眼睛尾巴,大致间距和位置)大概也可以做到,而且这样的代码完全可解释。而现在neural nets的data driven,根本不可能讲清楚哪个部分识别了哪个特征,能把握的只有梯度变化规律。

knn也是data-driven的,只不过不从training data里获得知识,只是简单记住train set,来一个新数据就跟所有train set数据比较,跟哪个类别的某k个图最相似那就属于哪个类别。如何计算两个图(向量)的距离(Distance Metric)四年前已经总结过了,可以用L1曼哈顿也可以用L2欧式,对于新问题用什么距离试试哪个好就行了。训练O(1),推理O(N),正好反了。

只要记住KNN的full form——K Nearest Neighbors就能想起来这个dumb算法了。

metric不是metrix,metric is a system for measuring something是指标的意思;metrix才是矩阵。

模型在train set上训练完后,在validation set上找最优hyperparameters(不靠训练得到的都算,包括距离计算L1还是L2),最后临论文deadline,只在test set上跑一次only once,得到的数就是最终写在报告、论文里的数据,以保证没有作弊。严格分离验证集和测试集对确保做研究没有不诚实、不公平很重要。

| validation set for tuning hyperparameters | |

|---|---|

|

|

另外idea4是交叉验证,神经网络实验的验证集validation set一般不用cross validation,在不同分割的训练集上训练好几遍开销太大了,只适用于较小的数据集。

linear classification是最簡單的parametric model(即上面的f(x,W)也有時weights/paramters會寫成theta θ而不是W),用Xtrain训练出W参数,inference过程就可以抛弃训练数据只用x和W计算结果。

最简单的x和W组合方式就是二者相乘。

其中對bias的簡單理解是,数据集里的猫比狗多,那猫类别的bias值可能就比狗高。可以通过增加一个常数项1特征,把b算作W的一部分。

模型做的通常是在给定幾個类别里打分的工作,而不是凭空产生一个相关类别,人脑大概也是这么工作的——看到一张猫的图片,在语言系统的无数个词条里关联到“猫”。

在很多模型裡linear classification就作為最後一層,承擔把所有的計算匯總到一起給上面10個類別打分的工作。

可以把linear classification的Wx这个計算过程看成是template matching,這在我之前的筆記也寫過一次,weights的每一行可以看作是一個被strech成一維的模板,圖片跟模板越像的話,在這一類的分數就會越高。

這是因為這兩個vector的點積就是點積相似度,點積越大可以認為就越相似,因為圖片的每個像素都是個xyz-axis都在0~255內的向量,所以可以把這個點積相似度放在r=255的球裡來想,或許有幫助。

在neural network等其他複雜模型裡,不會只限制模型每個類別只學一個模板,可能因此才變得更準確。

这种可视化方式可以学来,用在神经网络里可视化一下参数。不过我之前也可視化過比如capsule,能看出參數對應圖像的一些特徵,但不像linear这么明显。

| 站在比數據高一點兒維度的角度看問題 | 單純linear decision boundaries顯然解決不了的問題 |

|---|---|

|

|

之後的內容可以理解成:

- Loss function (quantifying what it means to have a “good” W)

- Optimization (start with random W and find a W that minimizes the loss)

- ConvNets! (tweak the functional form of f)

Problems:

- KNN:(never used)

- Very slow at test time.

- Distance metrics on pixels are not informative.

- Curse of dimensionality.

Lecture 3

想一些相關問題有助於理解:

- 選margin為1還是其他數字無所謂,只是一個arbitrary choice;

- 車的分數稍微改變一下不影響loss仍然為0;

- 就像hinge曲線一樣,loss最小值為1,最大值為infinity;

- 讓W為全0,即s≈0,那麼loss應該是num of classes - 1,這個可以用於debug;

- 讓j可以=y_i的話,結果是loss-1,其實都一樣但是讓loss最小值為0而不是“1”比較make sense;

- 計算loss不用sum,用mean也沒區別,因為不關心loss絕對值;

- 如果用上式loss的平方,可以代表我們更不能容忍大的錯誤,因為錯誤較大的類別會直接指數倍放大;

- 如果loss=0,這時的W是唯一的嗎?當然不是,2W的loss也是0。

def L_i_vectorized(x, y, W) : |

相比想矩陣,用一條數據vector的例子分析example code比較簡單。

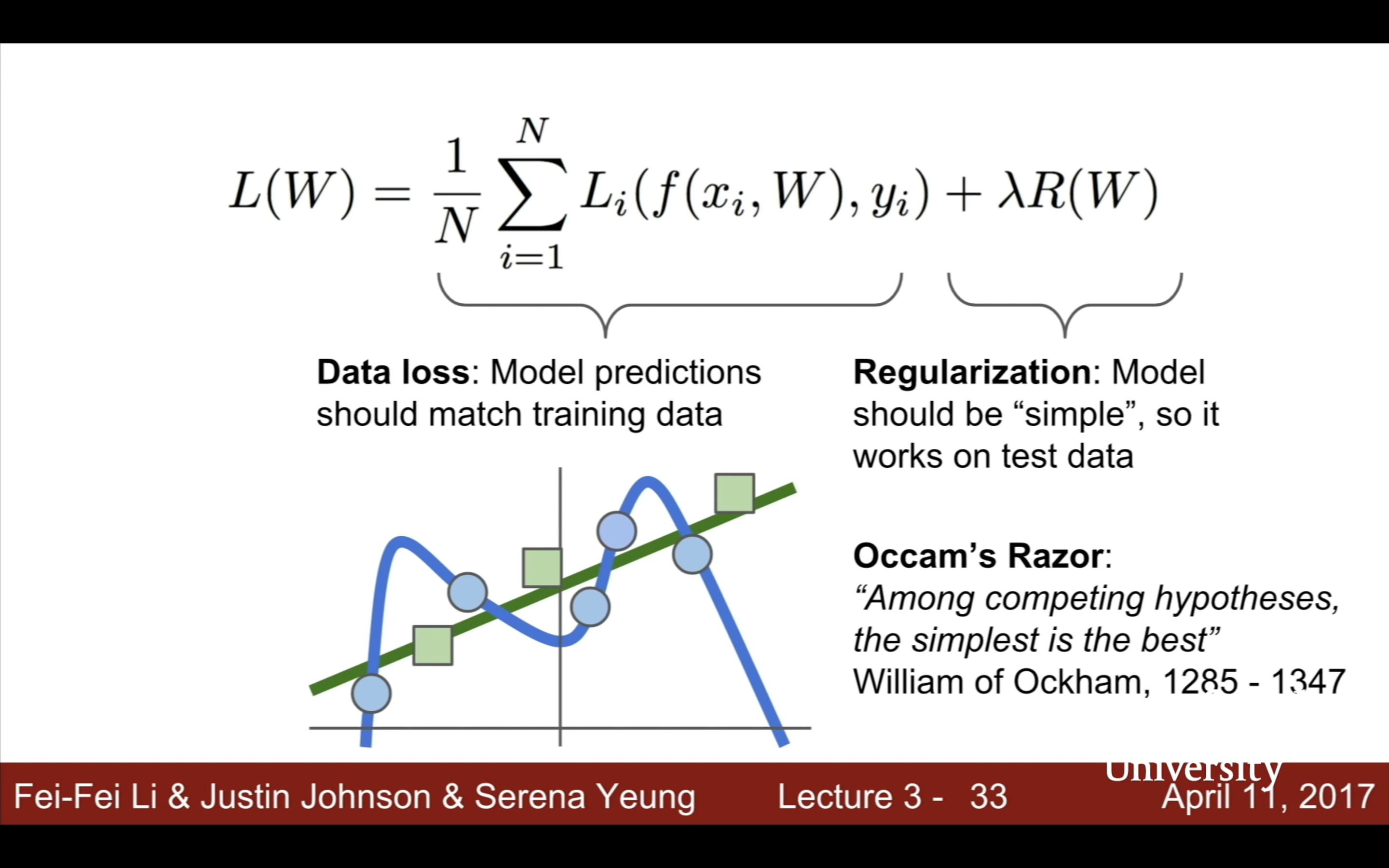

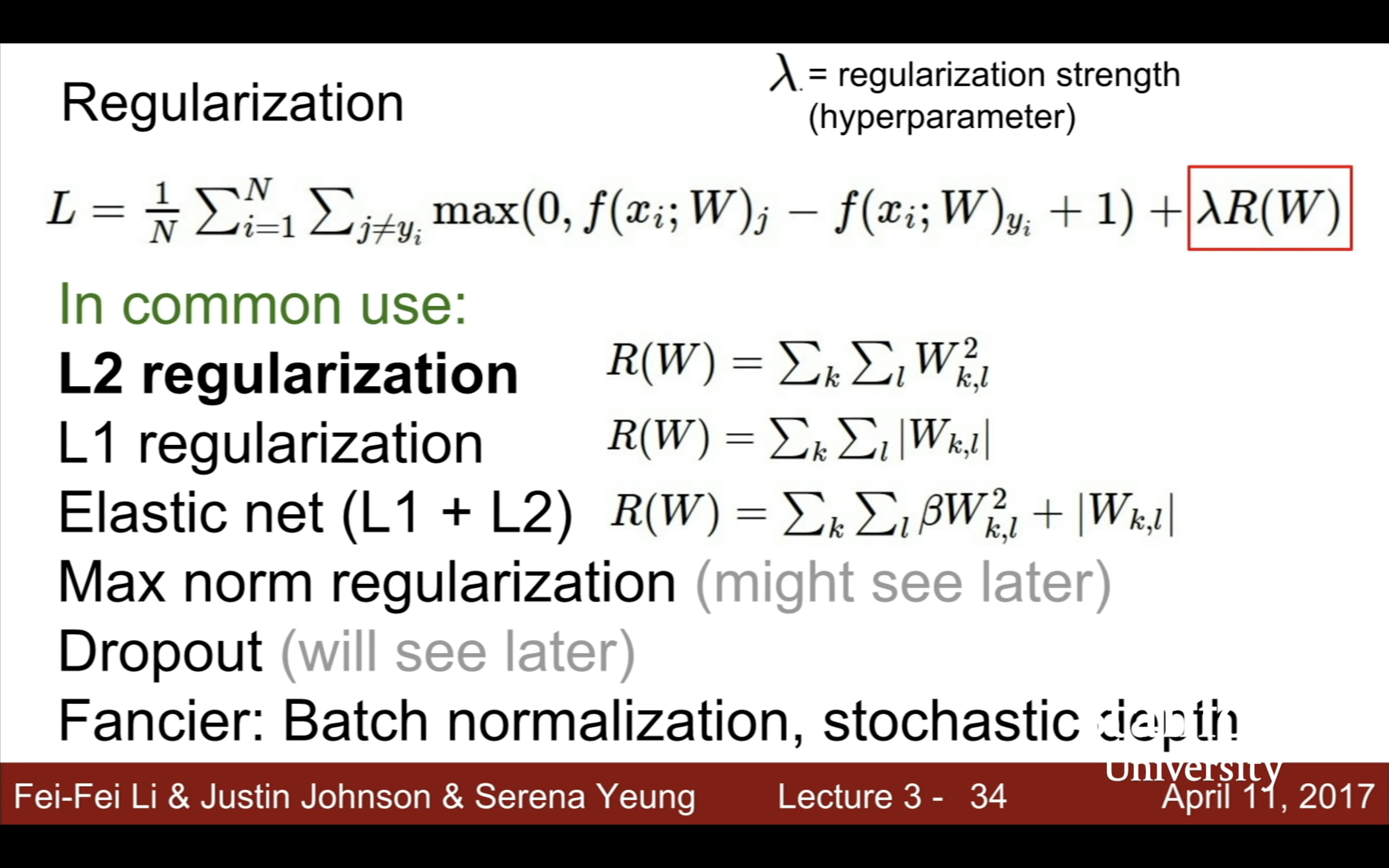

| Occam’s Razor: “Among competing hypotheses, the simplest is the best” William of Ockham, 1285 - 1347 | 發現regularization是“W”的函數,是讓W越簡單越好,比如讓高次冪特徵係數為0 |

|---|---|

|

|

之前學cs231n就是卡在batch normalization附近了,這一曠就是四年。總之還是沒理解清防止過擬合加的正則項到底是個什麼。需要找點最簡單的例子,具體分析。

|

|

想一些相關問題有助於理解:

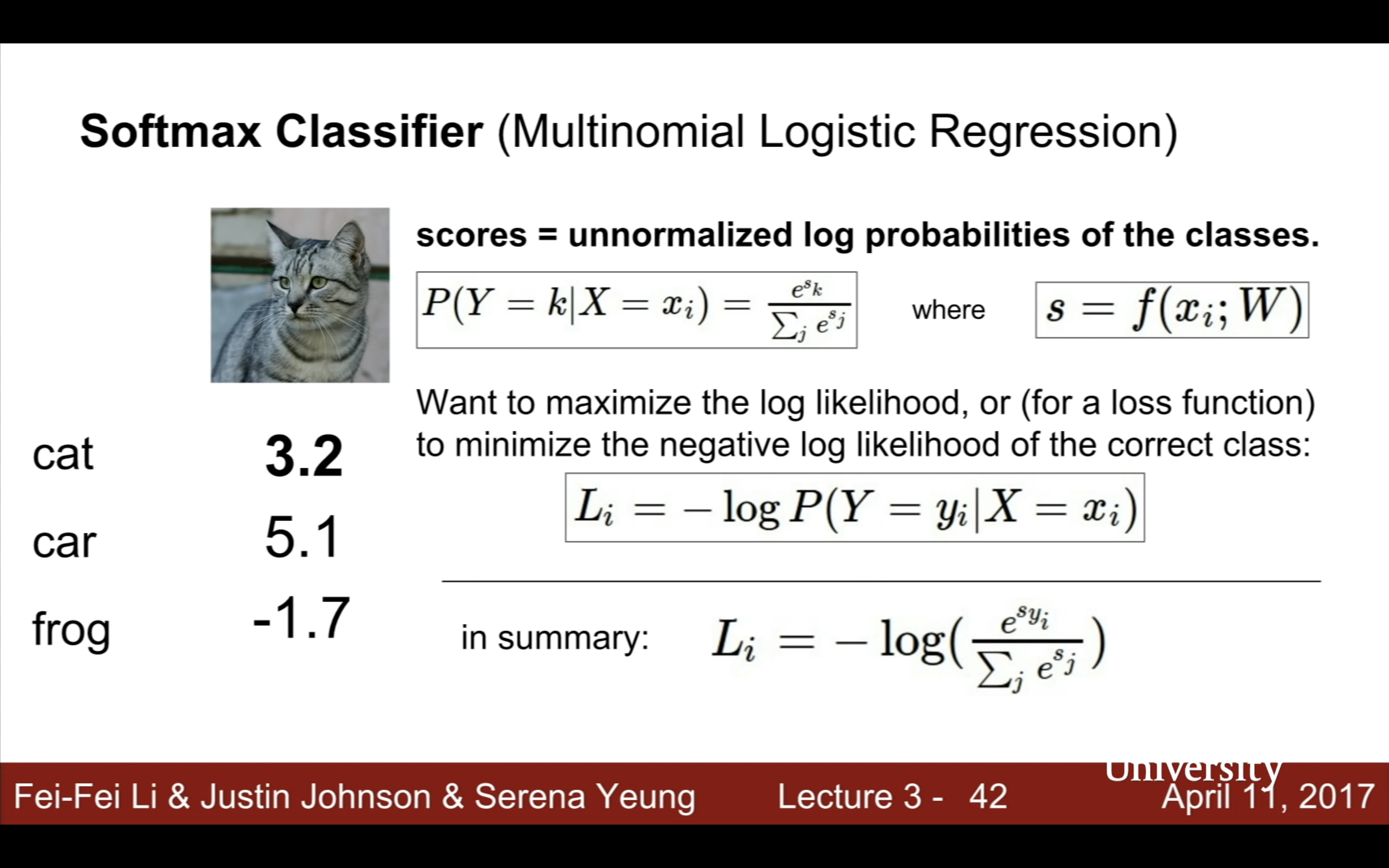

- min:-log(1)=0 max:-log(0)=infinity,但這兩個值都是取不到的,因為如果softmax函數=1,錯誤類別都需要是負無窮才能e^sj為0,如果softmax=0,正確類別分數需要是負無窮e^sy才能為0;

- 如果W=0,s全≈0,L_i就=-log(1/C(num of classes))=log(C);這個也可以用來debug,跟上面SVM一樣!

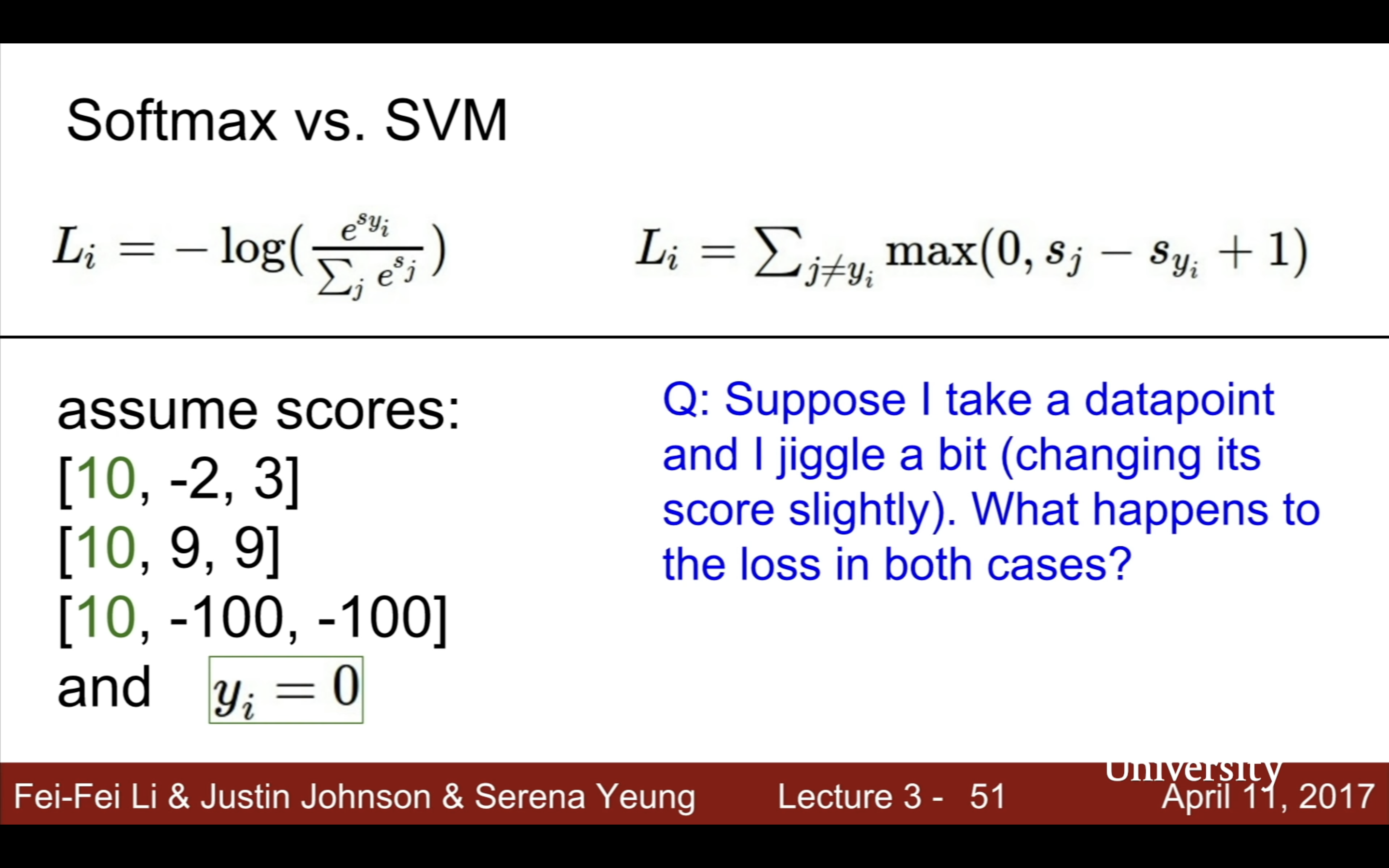

- 對比一下再來想問題3:

|

|

如果是右圖這種情況,修改一點已經分類正確的分數,svm loss仍然是0不會變,而softmax會改變,因為svm的目標是只要正確分類的score跟錯誤分類差距大過margin就可以了,而softmax會盡可能地把錯誤分數拉向-inf,把正確分數拉向inf。

- svm和softmax都只是為了最優化f(x)=Wx+b的損失函數而已,他們的函數形狀不重要,f(x)=Wx+B仍是線性函數

關於optimizer他的解釋很有意思,解析解analytic solution像是你在山頂(高度就是loss值)magically teleport到了最低點,但當prediction function f,loss function包括regularizer都很複雜就只能尋求數值解(iterative methods that start some solution and gradually imporve by time,梯度下降,即求導按負導數方向找低點,高中數學,pretty easy actually)。

- Strategy #1: A first very bad idea solution: Random search

Strategy #2: Follow the slope

一種計算gradient的想法是——,但是這方法太蠢太慢了,Numerical gradient: approximate :(, slow :(, easy to write :)

Analytic gradient: exact :), fast :), error-prone :(,直接用微積分得到dW迭代loss

In practice: Always use analytic gradient, but check implementation with numerical gradient. This is called a gradient check.(finding derivative is error-prone求導是容易出錯的)

chatgpt給的一個計算梯度的例子

示例函数

假设我们有一个二维函数:

这个函数是一个标准的二次函数,描述的是一个圆形等高线的抛物面。我们的目标是计算其梯度,并理解梯度的含义。

1. 计算梯度

首先,梯度是指函数在不同方向上变化的速率,它由偏导数组成。在二维情况下,梯度可以写成一个向量:

求偏导数:

计算 $f(x, y) = x^2 + y^2$ 对 $x$ 和 $y$ 的偏导数:

对 $x$ 的偏导数:

对 $y$ 的偏导数:

因此,梯度 $\nabla f(x, y)$ 为:

2. 梯度的意义

在几何上,梯度是函数在该点变化最快的方向。具体来说,梯度的方向就是函数值增长最快的方向,而梯度的负方向(即 $-\nabla f$)则是函数值下降最快的方向。

示例:在点 $(1, 1)$ 处的梯度

假设我们在点 $(1, 1)$ 计算梯度:

这表明,在点 $(1, 1)$ 处,函数 $f(x, y)$ 增长最快的方向是向量 $(2, 2)$ 的方向。这个方向对应于45度方向,即沿着 $x$ 轴和 $y$ 轴方向各增加1的方向。

3. 如何找到梯度最大的方向

梯度本身就表示函数变化最快的方向。它的方向指向函数值增长最快的方向,而它的大小(即梯度的模)则表示变化的速率。

在我们的例子中,点 $(1, 1)$ 的梯度是 $(2, 2)$,它的模为:

总结:

- 在任意点 $(x, y)$ 处,函数 $f(x, y) = x^2 + y^2$ 增长最快的方向是沿着梯度方向 $(2x, 2y)$。

- 梯度的大小表示函数在该方向上增长的速率。

- 如果我们想沿着函数值降低的方向移动,那么应当沿着梯度的负方向移动。

所以gradient descent的代碼也很簡單:# **Vanilla Gradient Descent**

while True:

weights_grad = evaluate_gradient(loss_fun, data, weights)

weights += - step_size * weights_grad # perform parameter update

其中loss_fun就可以想像成上面的f(x,y,z)=x^2+y^2+z^2,data就是x,y,weights就是z。

learning rate(step size)是最先要確定的超參數,model size和regularization strength都是其次的。

fancier update rules than gradient descent:

momentum, adam,就是不同的利用梯度信息的方式。

比如稍微改進vanilla為stochastic(SGD隨機梯度下降是隨機選一個,這裡是變種Mini-batch Gradient Descent):

| features | color histogram | edge histogram | like codebook(OFA啥的也有這個概念來著?) | 現在跟以前先提取特徵的兩步法也沒什麼區別,包括cnn,包括transformer,只是變成隱性地提取這些特徵,做成end to end端到端的黑箱 |

|---|---|---|---|---|

|

|

|

|

|

Lecture 4 計算圖(local gradient and chain rule)

| computational graph chain rule | 每個node只需要關注它周圍的nodes |

|---|---|

|

|

|

|

| 把幾個基本二元運算合成一個計算模塊,比如sigmoid,和它的導數 | 這裡算導數用的不是x,是f(x),由此可知backprop時node的forward pass的前後值都可能用到 |

|---|---|

|

|

任何時候比如做assignments時,如果求梯度遇到困難,畫一個計算圖用chain rule就都可以迎刃而解。

| patterns | pattern |

|---|---|

|

|

$\frac{df}{dx} = \sum_i \frac{df}{dq_i} \cdot \frac{dq_i}{dx}.$

懶得畫圖了,如果x給多個q當了自變量,多個q又給同一個f當了自變量,那就得把導數加起來,隨便想個computational graph的例子就不抽象了。

Jacobian矩陣很簡單,就是每個輸出對應每個輸入的偏導——

Jacobian 矩阵计算示例

Jacobian 矩阵在多元函数中用于描述一个向量值函数的偏导数。假设我们有一个向量值函数 $ \mathbf{F}(\mathbf{x}) $,其中 $ \mathbf{F} : \mathbb{R}^n \to \mathbb{R}^m $,输入向量 $ \mathbf{x} \in \mathbb{R}^n $,输出向量 $ \mathbf{F}(\mathbf{x}) \in \mathbb{R}^m $。

对于每一个 $ x_i $ 和 $ F_j $,Jacobian 矩阵的元素是 $ \frac{\partial F_j}{\partial x_i} $。整个矩阵的形式是:

示例

假设我们有函数(這裡的x和y當然可以改成x1和x2):

我们希望计算 $ F(x, y) = \begin{bmatrix} F_1(x, y) \\ F_2(x, y) \end{bmatrix} $ 的 Jacobian 矩阵。

第一步:计算偏导数

对 $ F_1(x, y) = x^2 + y^2 $:

- $ \frac{\partial F_1}{\partial x} = 2x $

- $ \frac{\partial F_1}{\partial y} = 2y $

对 $ F_2(x, y) = e^x + \sin(y) $:

- $ \frac{\partial F_2}{\partial x} = e^x $

- $ \frac{\partial F_2}{\partial y} = \cos(y) $

第二步:构造 Jacobian 矩阵

将上述结果代入矩阵中:

第三步:在特定点的 Jacobian 矩阵

如果我们希望在特定点,比如 $ (x, y) = (1, 0) $ 处求得 Jacobian 矩阵,则代入此点的值:

结果

因此,函数 $ F(x, y) $ 在点 $ (1, 0) $ 处的 Jacobian 矩阵为:

这个矩阵描述了函数 $ F(x, y) $ 在点 $ (1, 0) $ 处的变化率和方向。

| because each element of your gradient is quntifying how much element is contributing/affecting your final output | 下面偽代碼的forward和backward | |

|---|---|---|

|

|

|

關於這個1(indicator function):

这个符号 $1_{k=i}$ 表示一个指示函数(或称为指示符号),其作用是判断条件 $k = i$ 是否成立:

- 当 $k = i$ 时,$1_{k=i} = 1$

- 当 $k \neq i$ 时,$1_{k=i} = 0$

因此,如果写成 $1_{k=i} x_j$,则表示仅当 $k = i$ 时,值为 $x_j$;如果 $k \neq i$,则值为 0。

所以就可以簡單寫一下計算圖的rough pseudo code:class ComputationalGraph(object):

#...

def forward(inputs) :

# 1. [pass inputs to input gates...]

# 2. forward the computational graph:

for gate in self.graph.nodes_topologically_sorted():

gate.forward()

return loss # the final gate in the graph outputs the loss

def backward():

for gate in reversed(self.graph.nodes_topologically_sorted()):

gate.backward() # little piece of backprop (chain rule applied)

return inputs_gradients

class MultiplyGate(object):

def forward (x,y) :

z = x*y

self.x = x # must keep these around!

self.y = y

return z

def backward(dz):

dx = self.y * dz # [dz/dx * dL/dz]

dy = self.x * dz # [dz/dy * dL/dz]

return [dx, dy]

caffe layers的代碼在這節課之後就沒變過。比如下圖這個sigmoid_layer。

| topdiff是上游梯度 | 寫之前先畫computational graph |

|---|---|

|

|

| if you just stack linear layers on top of each other, they’re just gonna collapse to a single linear function (w/o max here) | 這裡其實我一直有個疑問,如果X裡有x1 x1x2 x1x2x3這種高階特徵,那豈不是不再線性了?這個問題其實有點蠢,因為線性關係是指x1和f(x1)、x1x2和f(x1x2)、x1x2x3和f(x1x2x3)之間是線性/直線,而不是x1x2/x1x2x3跟f(x1) | 用之前template matching的觀點可以認為W1學到了更多templates(維度變大了),而W2是模板的weights,h是tempaltes得分,h之前會做non-linear(這裡是max),最後得分就是templates的weighted sum | 3層3-layer就是再套一次f = Wз max(0, W2 max(0, W1x)),代碼在下面 |

|---|---|---|---|

|

|

|

|

上面這個3-layer的代碼就像這樣:# **forward-pass of a 3-layer neural network:**

f = lambda x: 1.0/(1.0 + np.exp(-x)) # activation function (use sigmoid)

x = np. random. randn(3, 1) # random input vector of three numbers (3x1)

h1 = f(np.dot(Wl, x) + bl) # calculate first hidden layer activations (4x1)

h2 = f(np.dot(W2, h1) + b2) # calculate second hidden layer activations (4x1)

out = np.dot(W3, h2) + b3 # output neuron (1x1)

關於polynomial regression,

多项式回归模型本身是非线性的,因为它涉及到自变量的高次方,能够拟合非线性数据关系。然而,多项式回归模型仍然可以被视为线性模型的一种,原因在于模型参数的估计和模型预测都可以通过线性回归的方法实现。

具体来说,在多项式回归模型中,自变量的高次方可以视为新的特征,将其添加到原始特征中,从而将非线性问题转化为线性问题。然后,使用线性回归模型估计模型参数(即新特征的系数),并使用线性回归模型进行预测。

因此,多项式回归模型被称为线性模型的扩展,它可以用于拟合非线性数据关系,并且可以使用线性回归的方法进行参数估计和预测。

| Serena說relu是最接近實際神經的activation function | |

|---|---|

|

|

Lecture 5

| 1986 backprop | 1998 first example backprop/gradient based cnn | 2012 Alex Krizhevsky |

|---|---|---|

|

|

|

CNN的卷積

each filter is looking for a specific type of template or concept of the input volume.

有個問題問得很好,what’s the intuition for increasing the depth each time. 每一層讓filter更多activation map更深(3、6、…)是實踐裡大家發現的更好的設定而已,cnn有很多design choice,比如filter size啥的。

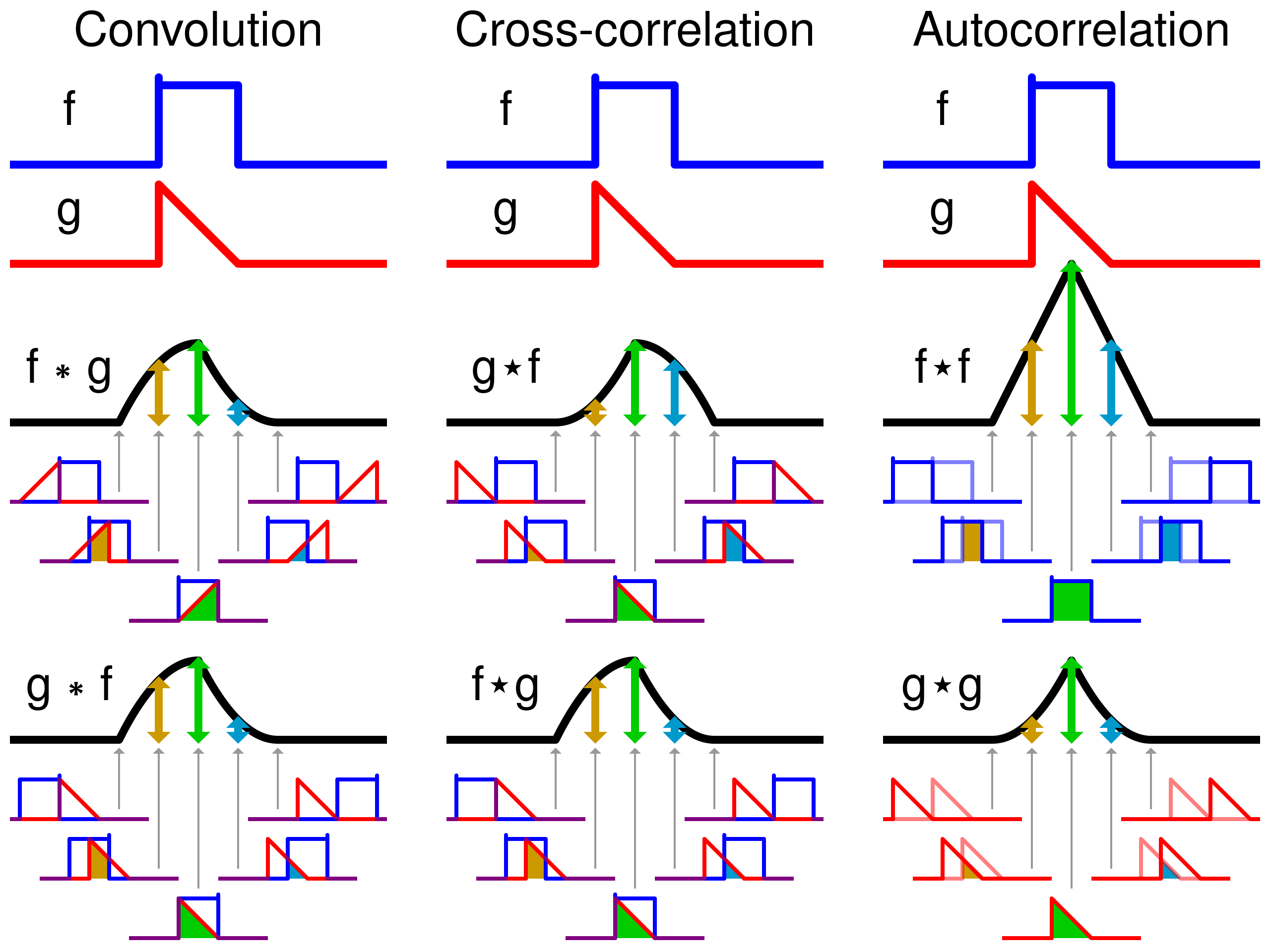

信號處理的卷積計算signal processing convolution

假设两个简单的离散信号 $f(t)$ 和 $g(t)$,它们的取值如下:

步骤 1:反转信号 $g(t)$

首先将 $g(t)$ 反转,得到 $g(-t)$:

然後就可以想像是這個反轉的 g 在 f 上滑動了。

步骤 2:滑动并计算乘积

当 t = 0 时:

当 t = 1 时:

当 t = 2 时:

由于 $g(t)$ 在 $t = 2$ 时没有定义,所以 $g(2) = 0$,于是:

当 t = 3 时:

同样,$g(2) = 0$,因此:

当 t = 4 时:

最终卷积结果

因此,卷积的结果 $(f * g)(t)$ 为:

其中卷积结果的最大时间点是由 $f(t)$ 和 $g(t)$ 的最远时间点组合而成。具体来说,卷积的结果最大会到达:

例如,假设 $f(t)$ 的最后一个有效时间点是 $t = 2$,而 $g(t)$ 的最后一个有效时间点是 $t = 1$,则:

这样,卷积的最大时间点 $t_{\text{max}}$ 为 3。

- 跟cnn的卷積一樣的是:都要想像成滑動操作,信號卷積是二維的兩條線滑動;

- 不一樣的是:cnn不需要反轉,而(f *g)(t)裡後面這個函數要先在時間軸上反轉。

deconvolution反卷積

上面的 $f(t) = [1, 2, 3]$ 是原始信號(可能是圖像像素值、音頻信號幅度),$g(t) = [4, 5]$ 叫做模糊核(比如是一個濾波器、噪聲源),得到的線性無填充的卷積結果 $y(t) = [4, 13, 22, 15, 0]$ 。

反卷積就是通過模糊核 $g(t)$ 和卷積結果 $y(t)$ 恢復原始信號 $f(t)$ 的過程,可以用傅里叶变换或卷积定理,在实际应用中,反卷积操作通常需要一些数值优化算法来求解,因为恢复信号可能涉及更复杂的卷积核和信号。

- 卷积:信号与某个模糊核进行卷积,导致信号被模糊处理。

- 反卷积:给定模糊后的信号和模糊核,通过数学方法恢复出原始信号。

用這個網站可以在線算信號卷積。

這節課原來後面講了如何可視化模型學到的特徵。(basically each element of these grids is showing what in the input would look like that basically maximizes the activation of the neuron. So in a sense, what is the neuron looking for?)

| 不這樣設置stride | formula,但其實豎直方向上也可以有stride,ouput size又是另外的formula | padding(zero,mirror,and so on)能保持activation size,input和ouput一樣size,但是stride>1的作用呢?是避免边缘信息丢失 |

|---|---|---|

|

|

|

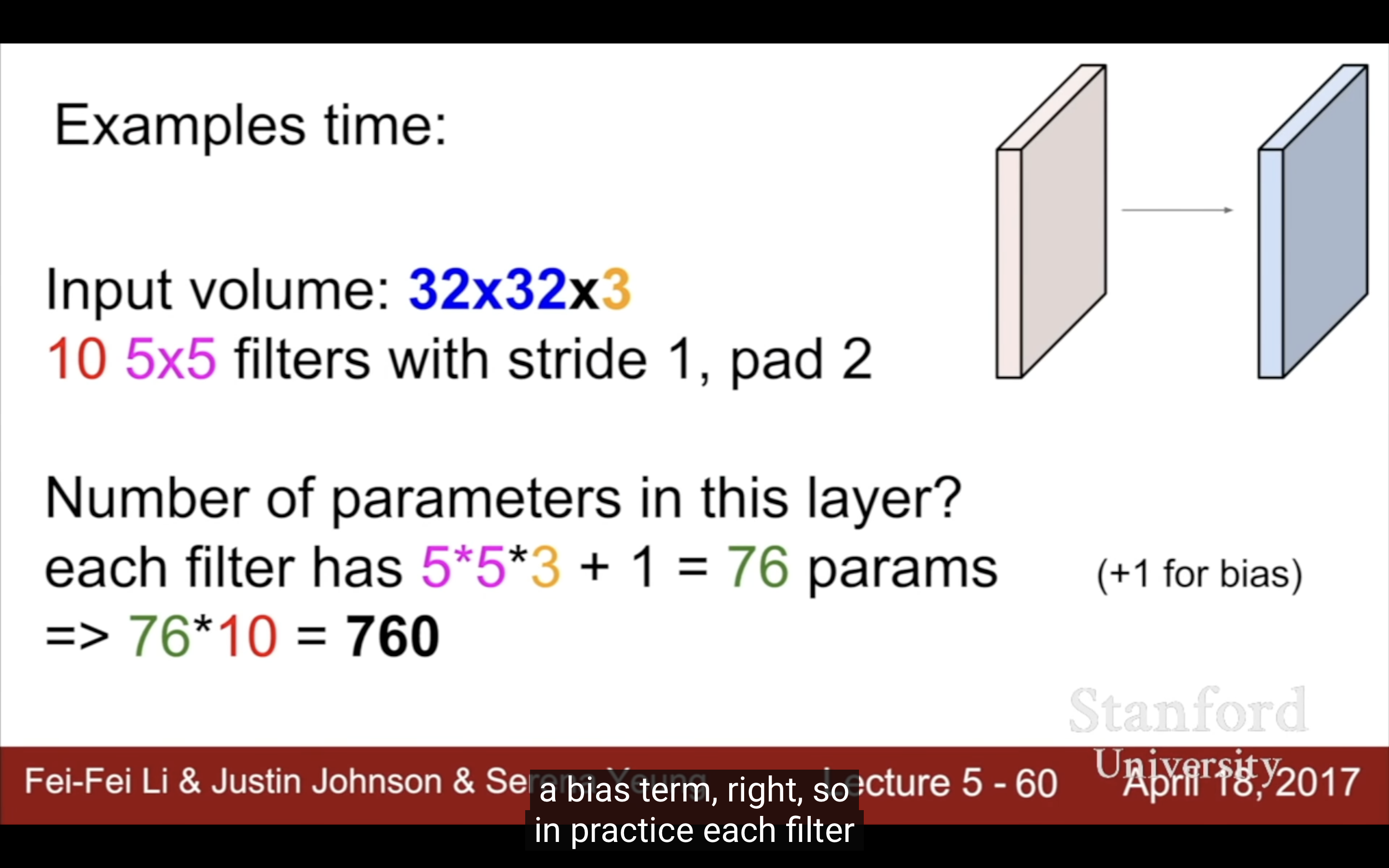

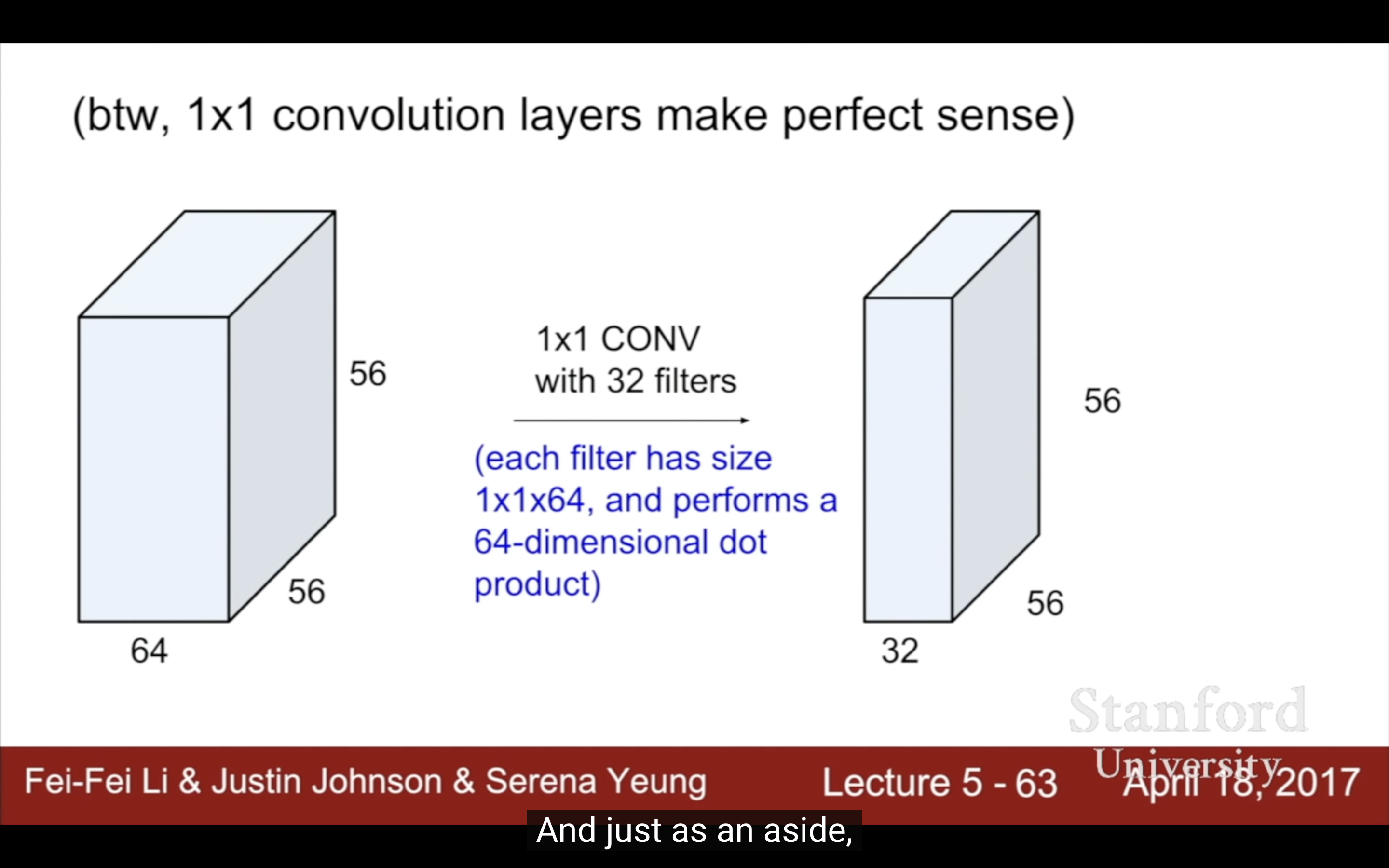

| example2 | 1x1 conv filter是可行的 | torch的一個conv |

|---|---|---|

|

|

|

stride越大downsampling就越多,參數越少模型越小,包括所有參數一直到FC連接的值也會變少。(tradeoff)

| pooling,不影響depth | stride設大就是downsampling,跟pooling效果是一樣的 |

|---|---|

|

|

右圖為什麼downsample太快不好?那為什麼還要pooling?現在不缺算力追求越多參數越好是不是不再需要太多downsample了?

這個問題可以再問chatgpt,回答得挺好,1.前幾層下採樣太快會丟失很多信息;2.pooling減少計算量即使現在不缺算力還是需要,否則計算量迅速膨脹徒增開銷,用結果導向的思路來說不影響效果的情況下downsampling總是好的;3.pooling或者說設置較大stride、現代架構其他捕捉全局關係的方式,除了减少特征图尺寸減少參數量外,也能抑制過擬合。是一種regularization。

Pooling 层的 stride 是否一般设置为没有 overlap?

在卷积神经网络(CNN)中,Pooling 层的 stride 是否设置为没有 overlap(即步长等于池化窗口大小)通常取决于网络设计的需求。一般来说,Pooling 层的 stride 通常设置为没有 overlap,即步长与池化窗口大小相同。具体解释如下:

没有重叠(No Overlap):

- Stride = Pooling窗口大小:这是最常见的设置,意味着池化操作的步长与池化窗口的大小相同,从而池化窗口之间没有重叠。

- 例如,在 2x2 的池化窗口下,stride = 2 会导致每次池化窗口滑动两个像素,池化窗口之间没有任何重叠区域。

优点:

- 计算效率更高:没有重叠的池化可以减少特征图的尺寸,降低计算复杂度。

- 避免冗余计算:每次池化操作处理的区域都是唯一的,因此没有重复计算的部分。

有重叠(Overlap):

- Stride < Pooling窗口大小:在某些情况下,池化窗口之间会有重叠。例如,使用 2x2 的池化窗口和 stride = 1,池化窗口会覆盖有重叠的区域。

优点:

- 保留更多细节:有重叠的池化可能会保留更多的特征,尤其是在需要更精细特征提取时。

缺点:

- 计算量更大:重叠池化会增加计算开销,导致计算效率较低。

结论:

- 在大多数情况下,Pooling 层的 stride 被设置为没有重叠,尤其是在经典的卷积神经网络(如 LeNet、VGG)中。这样可以高效地减少特征图的尺寸,并降低计算量。

- 在某些特殊任务中(例如,需要更细致特征提取的任务),也可以选择有重叠的池化。

為什麼max pooling比average pooling更commonly used?

- 实践效果更好。在大量的实际实验中,使用 Max Pooling 的 CNN 通常比使用 Average Pooling 的 CNN 效果更好,尤其是在分类和目标检测任务中。这也是 Max Pooling 被更广泛应用的原因之一。

- 更好地保留关键信息。Max Pooling 选择每个池化窗口中的最大值,从而保留了特征图中的最显著特征。这种方式在提取边缘、纹理等重要特征时非常有效。相比之下,Average Pooling 是取平均值,可能会平滑掉重要的边缘信息,导致信息丢失。

- 具有更强的平移不变性。Max Pooling 能更好地处理位置的微小变化(平移不变性),因为它仅保留每个窗口的最大值,对其他不显著的特征不敏感。这在处理图像时有利于使网络对物体位置的微小变动更加鲁棒。

訓練例子:https://cs.stanford.edu/people/karpathy/convnetjs/demo/cifar10.html

通常只有第一層activation maps能被解釋,越高層越難解釋。

- There is a trend towards smaller filters and deeper architectures

- There is a trend towards getting rid of POOL/FC layers (just CONV)

- Typical architectures look like:

[(CONV-RELU)*N-POOL?]*M-(FC-RELU)*K,SOFTMAX

where N is usually up to ~5, M is large, 0 <= K <= 2. - but recent(2017) advances such as ResNet/GoogLeNet challenge this paradigm

Lecture 6

- Activation Functions(non-linearity)

- Data Preprocessing

- Weight Initialization

- Batch Normalization

- Babysitting the Learning Process

- Hyperparameter Optimization

Activation Functions(non-linearity) 为什么输入要正负样本均衡?

gradient on w這個說法指的是$\frac{\partial L}{\partial w}\ or\ \nabla_w L$。(或者df/dw)

| backprop反向傳播回來的value可以光看曲線不用公式,平緩的地方導數為0(forward pass就看函數曲線本身,backward就看曲線變化,高中數學),(sigmoid gate, a node in computational graph) | 講得太好了這裡 |

|---|---|

|

|

- sigmoid

- 3 problems:

- Saturated neurons “kill” the gradients:(注意這裡說的是激活函數這個node的gradient,只有一個自變量)

- x = -10, sigmoid(x) = 0, sigmoid’(x) = (1-0)0 = 0

- x = 0, sigmoid(x) = 1/2, sigmoid’(x) = (1-1/2)1/2 = 1/4

- x = 10, sigmoid(x) = 1, sigmoid’(x) = (1-1)1 = 0

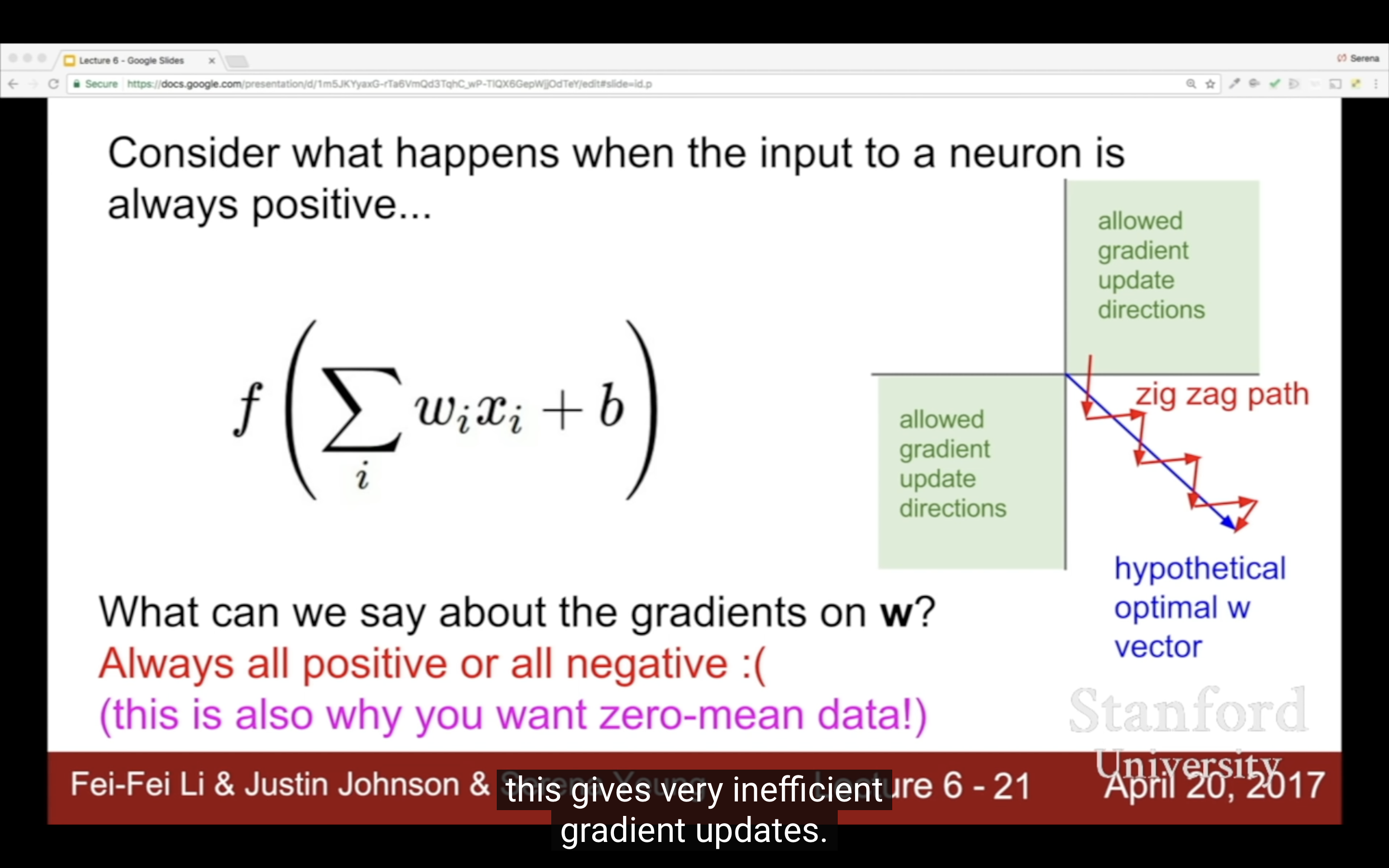

- Sigmoid outputs are not zero-centered: 如下图(這裡說的是激活函數之前score function node,有W和X倆自變量)

- 如果一个神经元的输入X全是正的,gradients on w即dL/dw = dL/df * df/dw(其中df/dw=x)就全是正的或者负的,就会导致graident只向全正和全负更新,最优化W的过程就会很低效。

- 这也是为什么x最好positive和negative均衡,因为如果输入数据X本身就是全正的,那不需要sigmoid激活函数压缩就已经会导致图里的zig zag path问题了。

- 而sigmoid激活函数就是这样一个会把输入全部拉到0~1的玩意。

- exp() is a bit computationally expensive

- Saturated neurons “kill” the gradients:(注意這裡說的是激活函數這個node的gradient,只有一個自變量)

- 3 problems:

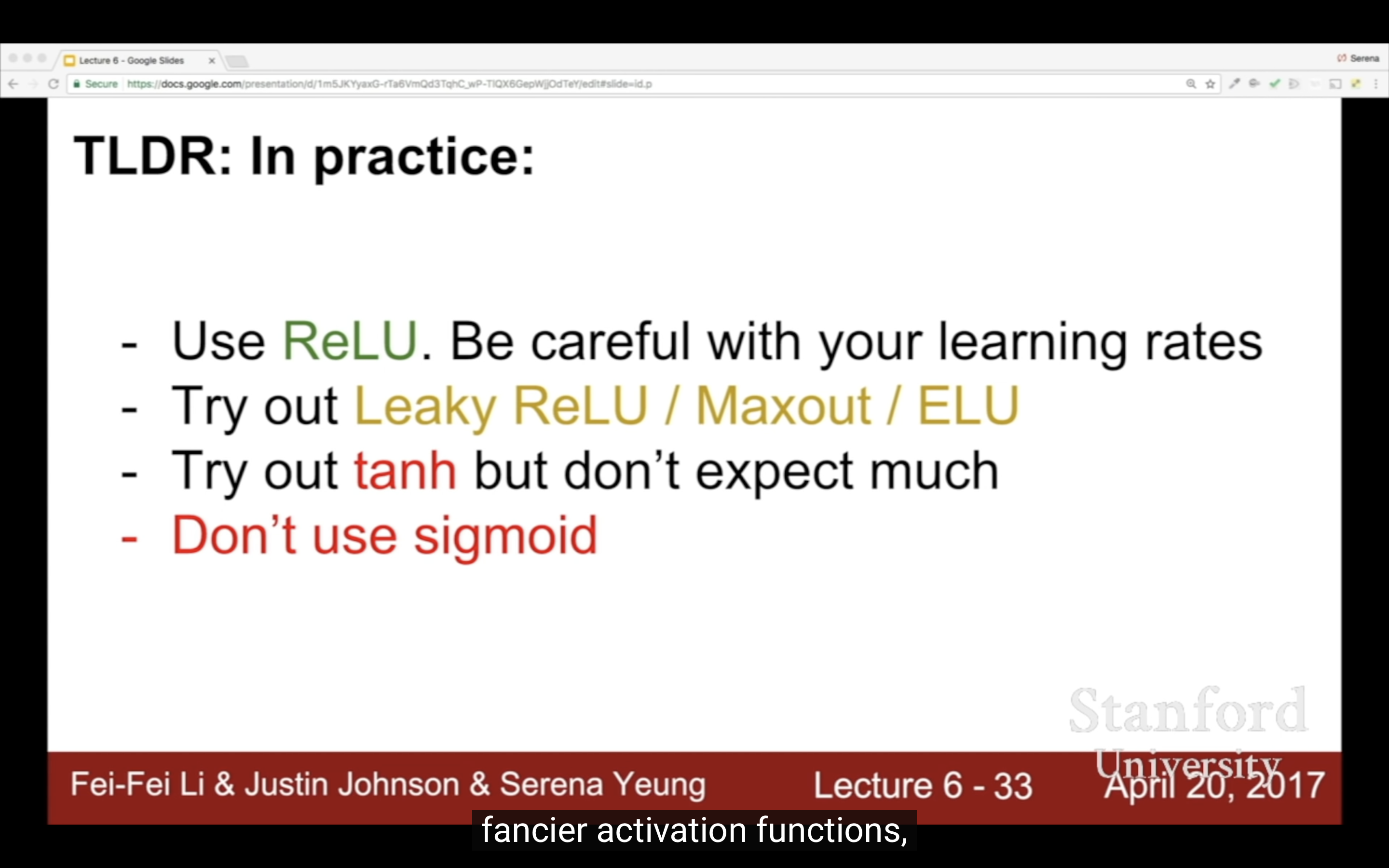

- tanh(x)解决了zero-centered的问题,但还是存在梯度消失问题,而且计算开销比sigmoid更大因为有更多exp运算。$\tanh(x) = \frac{e^x - e^{-x}}{e^x + e^{-x}}$

- ReLU(Rectified Linear Unit), f(x) = max(0, x)

- pros:(上面的饱和函数、计算开销問題都解決了)

- Does not saturate (in region).

- Very computationally efficient

- Converges much faster than sigmoid/tanh in practice (e.g. 6x faster) 收斂更快

- Actually more biologically plausible than sigmoid

- 2012 Alex Krizhevsky第一次使用

- cons:

- zero-centered問題還是存在

- dead relu

- Dead ReLU 问题是指在使用 ReLU (Rectified Linear Unit) 激活函数时,某些神经元可能在训练过程中始终输出零,这些神经元被称为“死神经元”。这种情况通常发生在 ReLU 的输入为负值时,ReLU 会将其输出设置为零。长期处于这种状态的神经元无法进行有效的训练或更新,从而导致 死 ReLU 问题。

- 虽然 Dead ReLU 问题是存在的,但它在实际应用中通常并不严重,

- 神经网络中往往有足够的神经元来弥补死神经元的影响。

- 死神经元不会影响其他神经元的梯度传播。

- 使用 改进版 ReLU 激活函数(如 Leaky ReLU 或 PReLU)可以有效避免死神经元问题。

- pros:(上面的饱和函数、计算开销問題都解決了)

- Leaky ReLU / PReLU

- Leaky ReLU

- f(x) = max(0.01x, x)通常是0.01

- will not “die”.

- PReLU(Parametric ReLU)

- f(x) = max(αx, x)

- α是通過backprop/gradient descent訓練得到的,可是α如果學成負數,包括下面的ELU激活函數,都可能讓輸出全部變成正數,跟sigmoid一樣的問題

- α是不是每個neuron都不一樣?Serena也記不清了。chatgpt說是每個都獨立,沒有全局alpha,那這樣的話α學成負數就不是什麼問題了,大概會是偶然現象

- ELU(Exponential Linear Units)

- pros

- All benefits of RelU

- Closer to zero mean outputs

- Negative saturation regime compared with Leaky ReLU adds some robustness to noise

- cons

- exp() computation

- pros

- maxout neuron

- $f(x) = \max \left( W_1^T x + b_1, W_2^T x + b_2, \dots, W_k^T x + b_k \right)$

- Does not have the basic form of dot product -> nonlinearity

- pros:

- Generalizes ReLU and Leaky ReLU

- Linear Regime!(線性狀態(線性區間)) Does not saturate! Does not die!

- cons:

- doubles the number of parameters/neuron

怎麼理解“activate”激活?這節課原來後面講了如何可視化模型學到的特徵。(basically each element of these grids is showing what in the input would look like that basically maximizes the activation of the neuron. So in a sense, what is the neuron looking for?上面這段看看

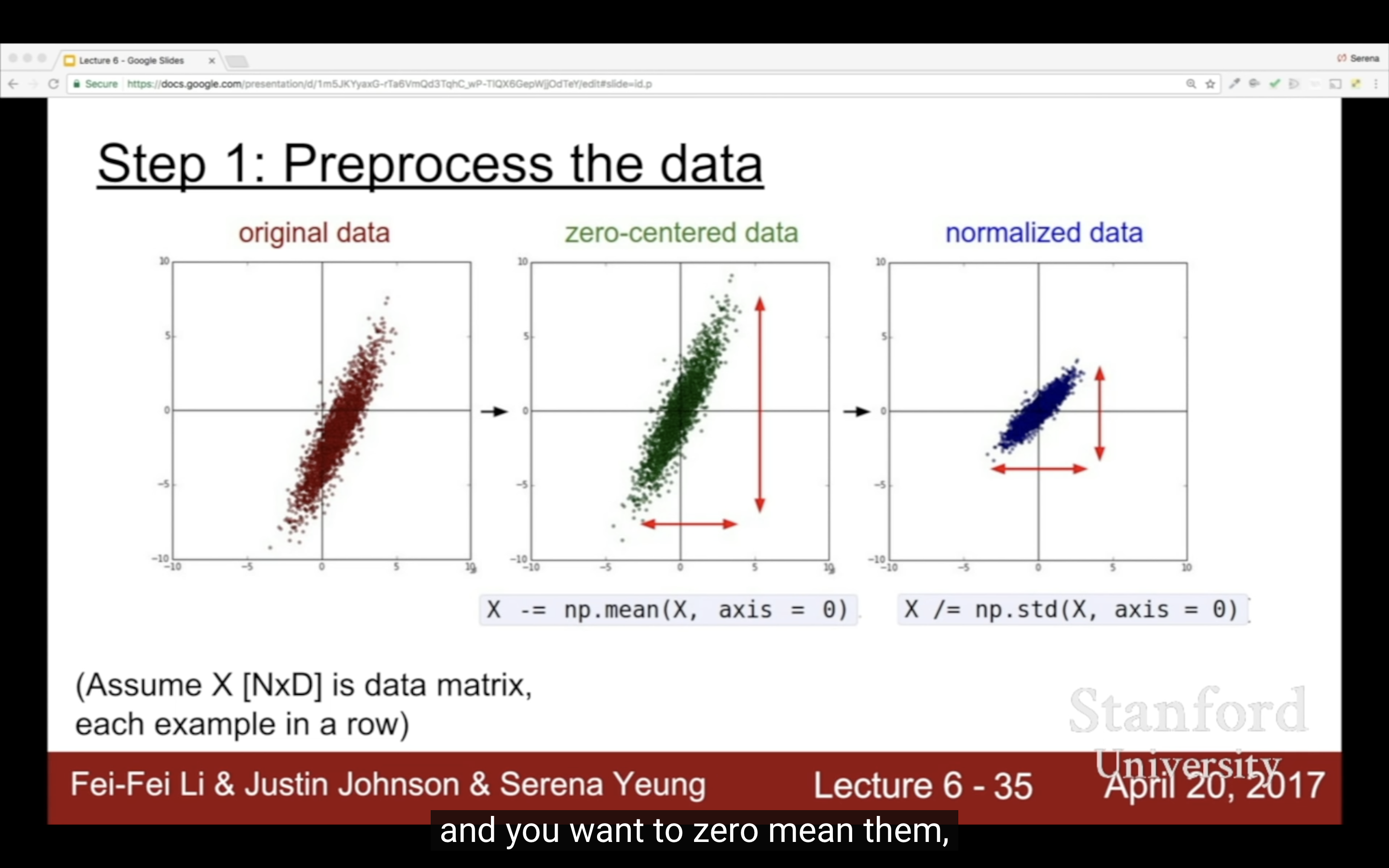

Data Preprocessing

| zero-mean就是因為上面的原因,也有別的PCA(decorrelate)和Whitening | 圖片說是一般不用normalize,只減去均值,減所有channels和per-channel結果上沒區別 |

|---|---|

|

|

注意,trainning set上做的preprocess,test set也要做。注意是訓練階段得到的均值,而不是测试数据本身的均值。

上面的兩種方法:

- 计算训练集中的所有图像的像素值的均值,得到一个 全局均值图像,然後所有图像的每个像素都减去训练集中的所有图像在该像素位置的均值;

- RGB三個通道分別算均值,這倆方法可以取足夠量的數據算一個值,只要能代表總體分布就行不用完全全部數據。

Weight Initialization

- First idea: Small random numbers (gaussian with zero mean and 1e-2 standard deviation)

- W = 0.01 * np. random. rand (D,H)

- Works ~okay for small networks, but problems with deeper networks.

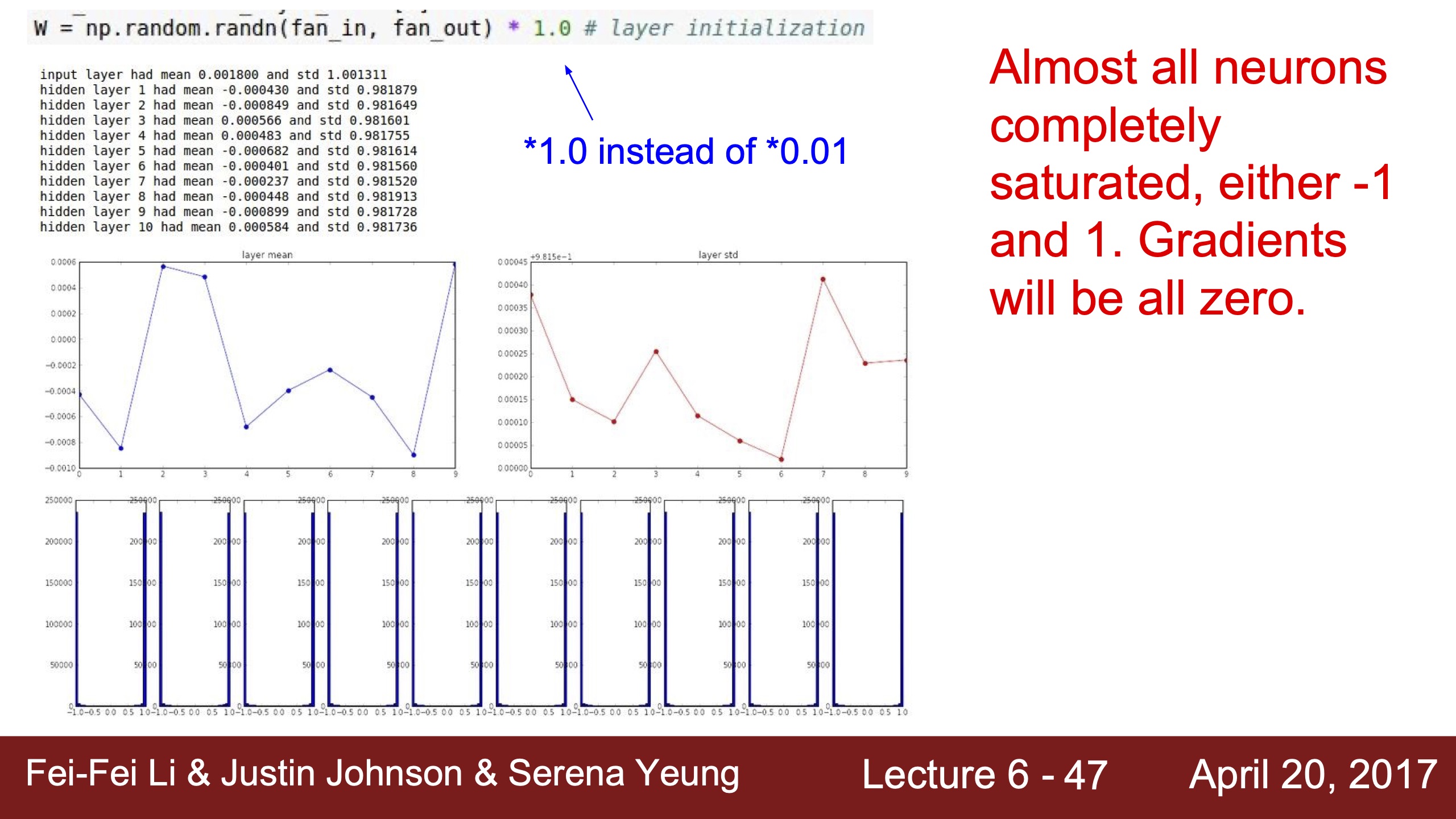

| First Idea activation layer visualization, 結果為右 | 這裡的gradients跟前面一樣也是dLoss/dW=X,這裡的激活層值全為0,所以梯度完全沒有更新 | 不用0.01而x100倍用1.0的初始化W的話,因為用的是tanh,到了激活函數的飽和區間,tanh飽和區間斜率幾乎是0,所以梯度也會消失 |

|---|---|---|

|

|

|

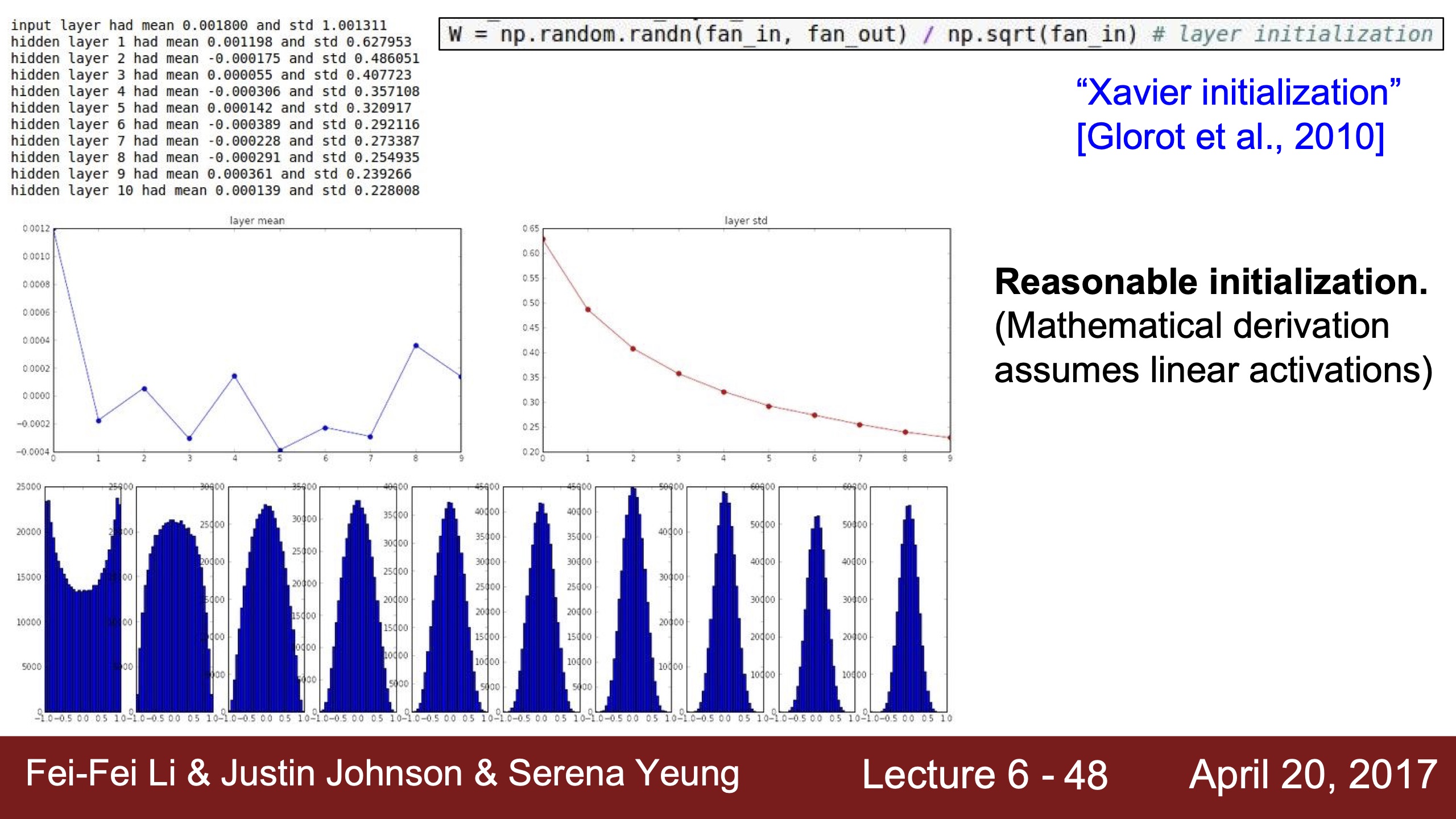

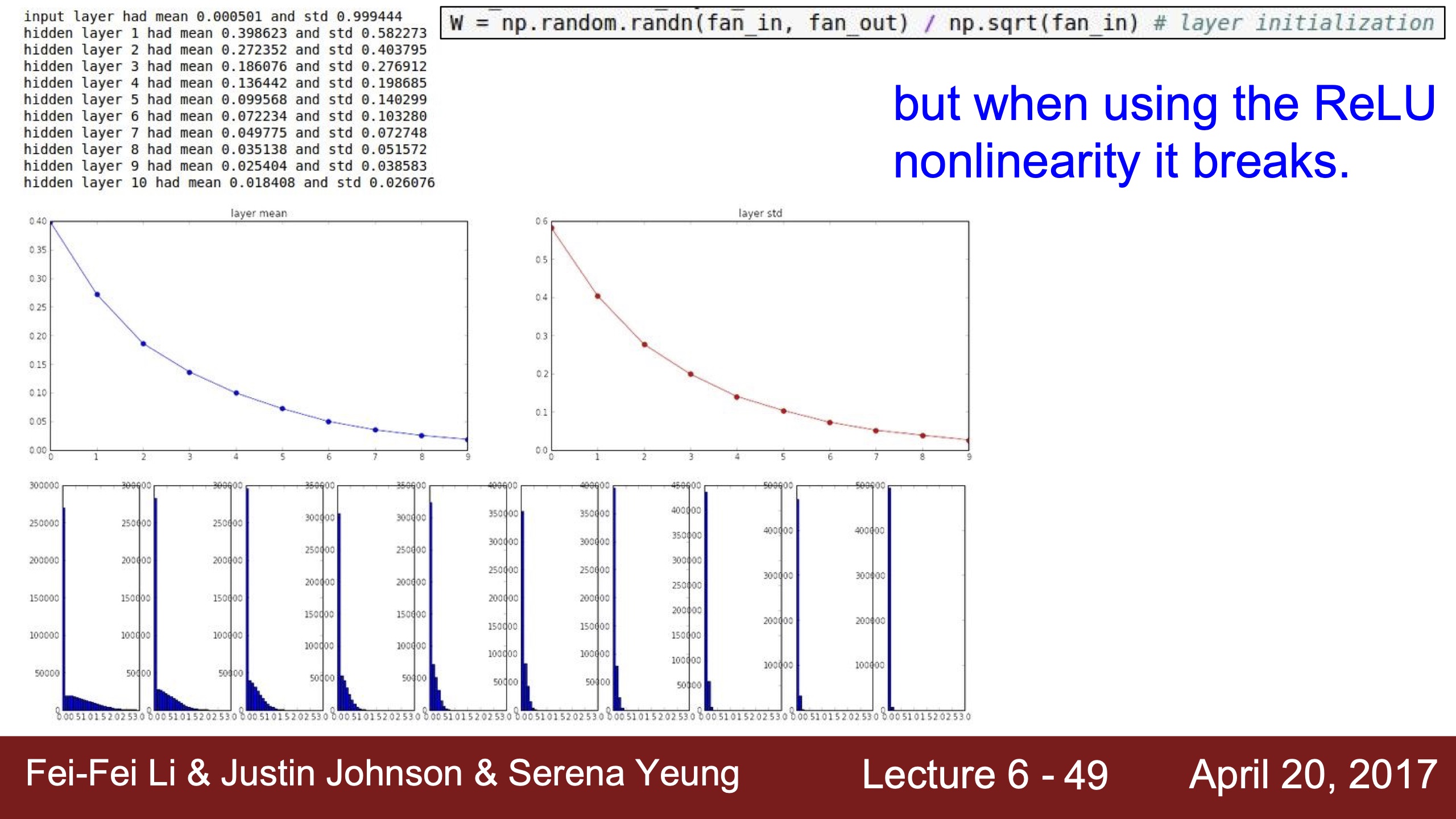

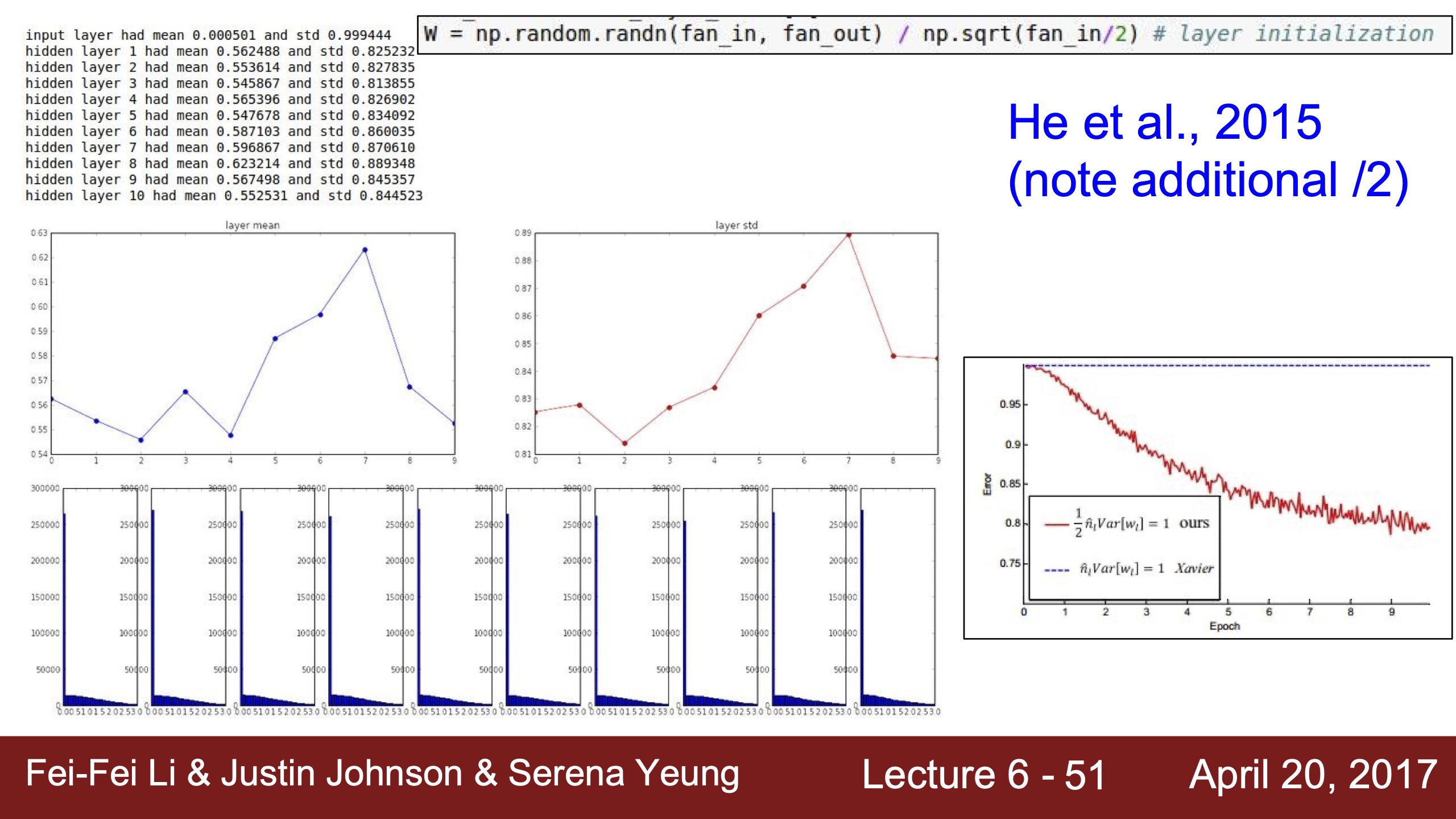

| xavier initialization用tanh,因為tanh在0處斜率很大,所以是梯度很有效的區域 | 用relu就梯度消失了,這裡雖然上面的mean也是0,但是relu在0處沒有斜率,沒有梯度,所以神經元也是deactivated | 用He初始化就變成我們想看到的分布,下面分布圖一樣是因為x拉太長了,上面的mean均值在0.5,是relu很有效的斜率gradient為1的線性區域 | 2017年仍是個活躍研究領域,不知道現在如何? |

|---|---|---|---|

|

|

|

|

Batch Normalization

We wants to keep activations in a gaussian range, like above, so use BN.

關於BN我的思考:

四年前就assginment卡在这没继续了,这次可好好搞明白。其实这部分跟上面找比较好的初始化W,以使每一层输入的分布都在神经元的有效区间内是一样的道理,有效区间就是tanh的0附近,relu的正数线性区间,斜率=1,即能让梯度反向传递回去。

BN有幾個核心目的,(去他媽媽的减小内部协变量偏移(Internal Covariate Shift))i.加速训练过程;ii.正则化作用(因為引入了小噪聲,噪聲指讓數據分布改變了?Serena的說法是,之前activation neuron只會考慮一個input但現在的input都是被整個batch的其他特徵影響過的,但總之增強泛化不是BN的主要目的);iii.通過下面的#3.可以缓解梯度消失和梯度爆炸。

那麼只要搞懂為什麼normalization能加快收斂,就可以了——

- https://stats.stackexchange.com/a/437848 In Machine learning, how does normalization help in convergence of gradient descent?

- 考慮$f(w)=w_1^2 + 25w_2^2$,通過觀察可以發現有global minimum $w=[0,0]^\top$。這個函數的梯度是,假如learning rate 𝛼=0.035,$w^{(0)}=[0.5, 0.5]^\top,$ 梯度更新公式是$w^{(1)} =w^{(0)}-\alpha \nabla f\left(w^{(0)}\right),$

,df/dw永遠會朝向w2的方向,可以想像w^2和25w^2這兩個曲線,變化速率相差太大(係數就是X),但經過normalization後,減去mean(12)除以σ = √Σ(x-x̄)2 / N = √144 = 12,可以標準化為$f(w)=-w_1^2 + w_2^2$,大概這麼理解下(這個分布只有兩個數據x1=1,x2=25所以感覺很怪),normalize後梯度變化會更朝向global minimum而不再zig zag。

,df/dw永遠會朝向w2的方向,可以想像w^2和25w^2這兩個曲線,變化速率相差太大(係數就是X),但經過normalization後,減去mean(12)除以σ = √Σ(x-x̄)2 / N = √144 = 12,可以標準化為$f(w)=-w_1^2 + w_2^2$,大概這麼理解下(這個分布只有兩個數據x1=1,x2=25所以感覺很怪),normalize後梯度變化會更朝向global minimum而不再zig zag。

batch normalization會根據不同的激活函數學習不同的參數嗎?比如對relu來說,希望輸入都在正數區間避免dead relu,比如tanh希望輸入不要到飽和區間。還是說batch normalization總是盡可能接近mean=0,deviation=1的標準正態分佈?

- 不一定?

- chatgpt說BN總是希望輸入/特徵的分布盡可能接近標準正態,只不過normalization之後,1.可以避免太多負值導致太多dead relu;2.可以避免太多值在tanh的-1和1飽和區間裡。這樣來看也還是很好的。

- 但Serena說通過學習γ和β參數,雖然BN本身是想讓分布變成標準正態分佈,但也給模型靈活度,可以主動不讓tanh飽和,或者搞出全正數分布不讓dead relu出現。

激活層/隱藏層的歸一化是輸入的歸一化,不是輸出的。

數據的歸一跟激活函數的歸一化/標準化是一樣的目的和道理,實際上就是因為數據normalization/standardization效果很好,那麼為什麼不把每一層的輸入值都歸一化/標準化?

BN 允许激活值的分布在训练过程中变化,并不强制要求它们是标准正态分布。尽管初始阶段会做标准化处理,但在学习过程中,BN 可以调整输出的均值和方差,导致输出分布变得更加灵活。

- 通过学习 γ 和 β 参数,BN 可能会产生一些不完全符合标准正态分布的分布,包括可能的偏移或变化,如全正分布等。

課程進行到1小時時同學問了我想問的問題,強迫features變成gaussian分布不會丟失信息讓數據失真嗎?CNN裡希望保持空間信息所以預處理不用normalization,對特徵圖activation maps其實不會失真,說只是shifting(- mean)和scaling(/ standard deviation)。

在测试时(Testing Phase):

- 在测试阶段,BN不再使用测试数据来计算均值和方差。相反,它会使用训练过程中通过各个mini-batch累计的全局均值和方差,每一层使用单独的全局均值和方差。

- 这样做是因为测试集的batch大小通常较小,直接计算时可能不稳定,且我们希望测试时模型的行为尽可能和训练时一致。

Babysitting the Learning Process

| 增強正則的時候,期望是loss變大(加了一項),debugging策略get✔。 | take the first 20 examples from CIFAR-10;turn off regularization (reg = 0.0);use simple vanilla ‘sgd’,用最簡單的設定確保模型能過擬合很少的樣本,讓loss趨近於0,debugging strategy get✔ | |

|---|---|---|

|

|

|

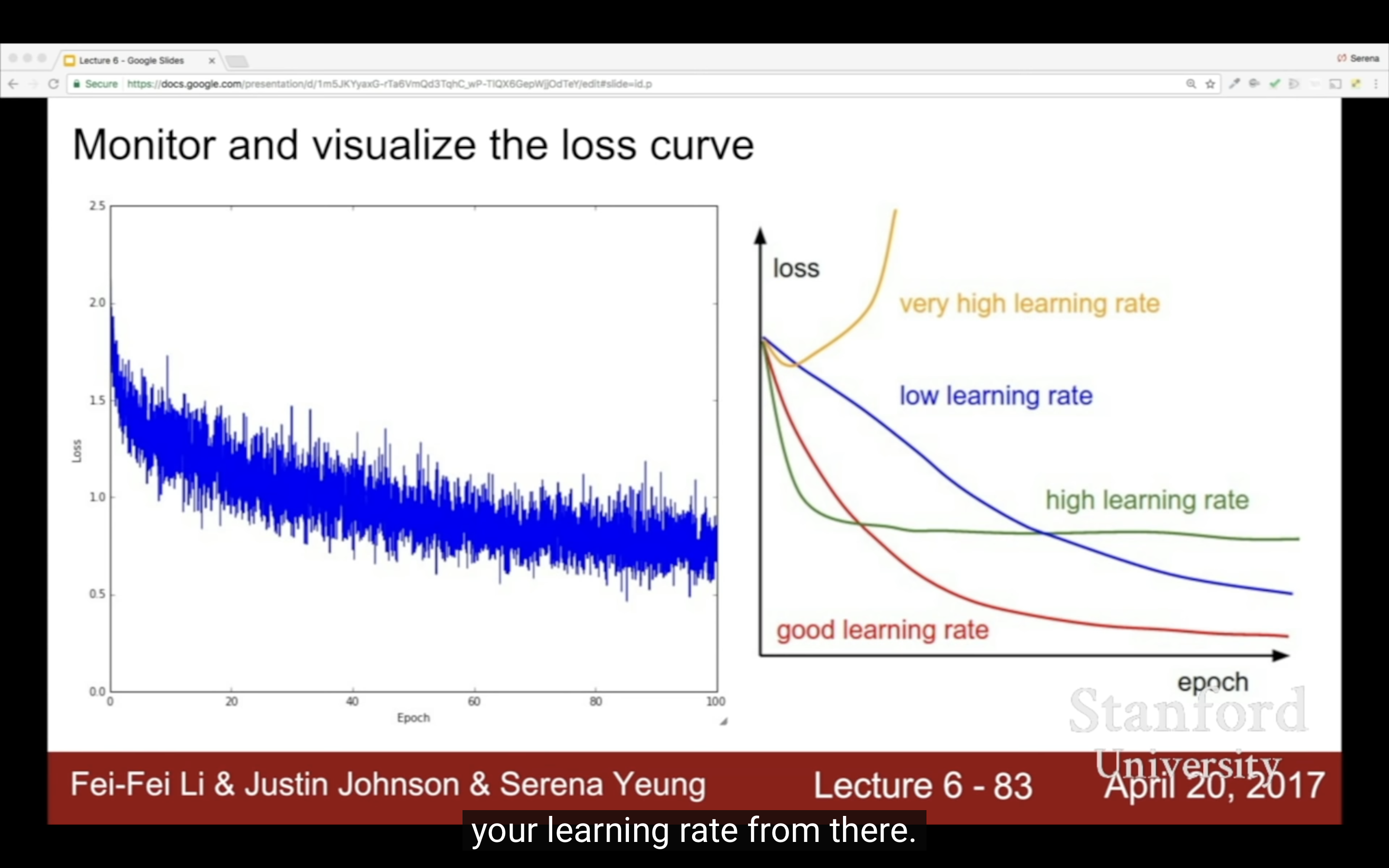

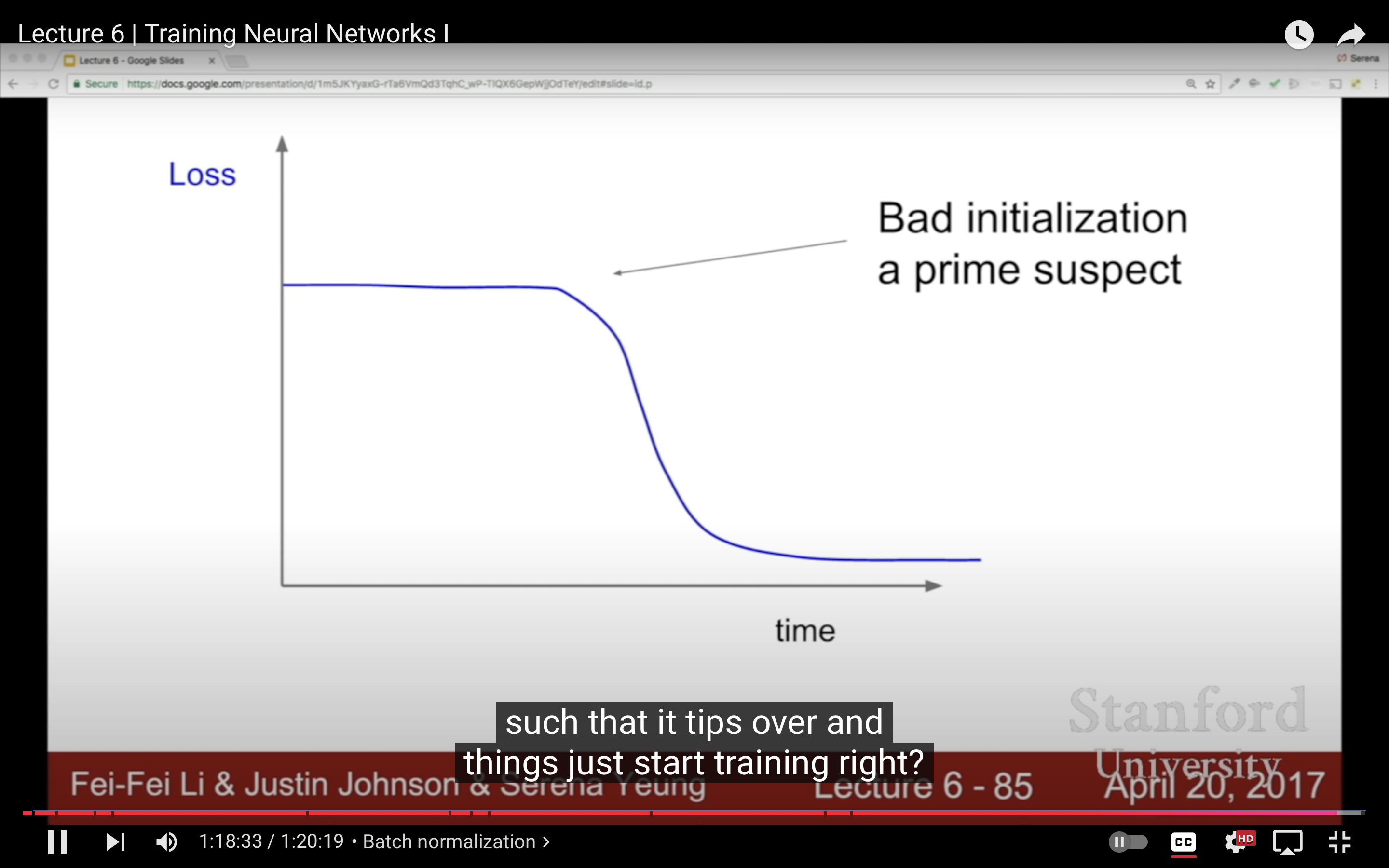

然後用小的正則來找合適的learning rate,最重要的超參,如果loss/cost變化太慢一般來說是learning rate太小了;loss變成nan就是越界了,learning rate太大,loss變成inf?

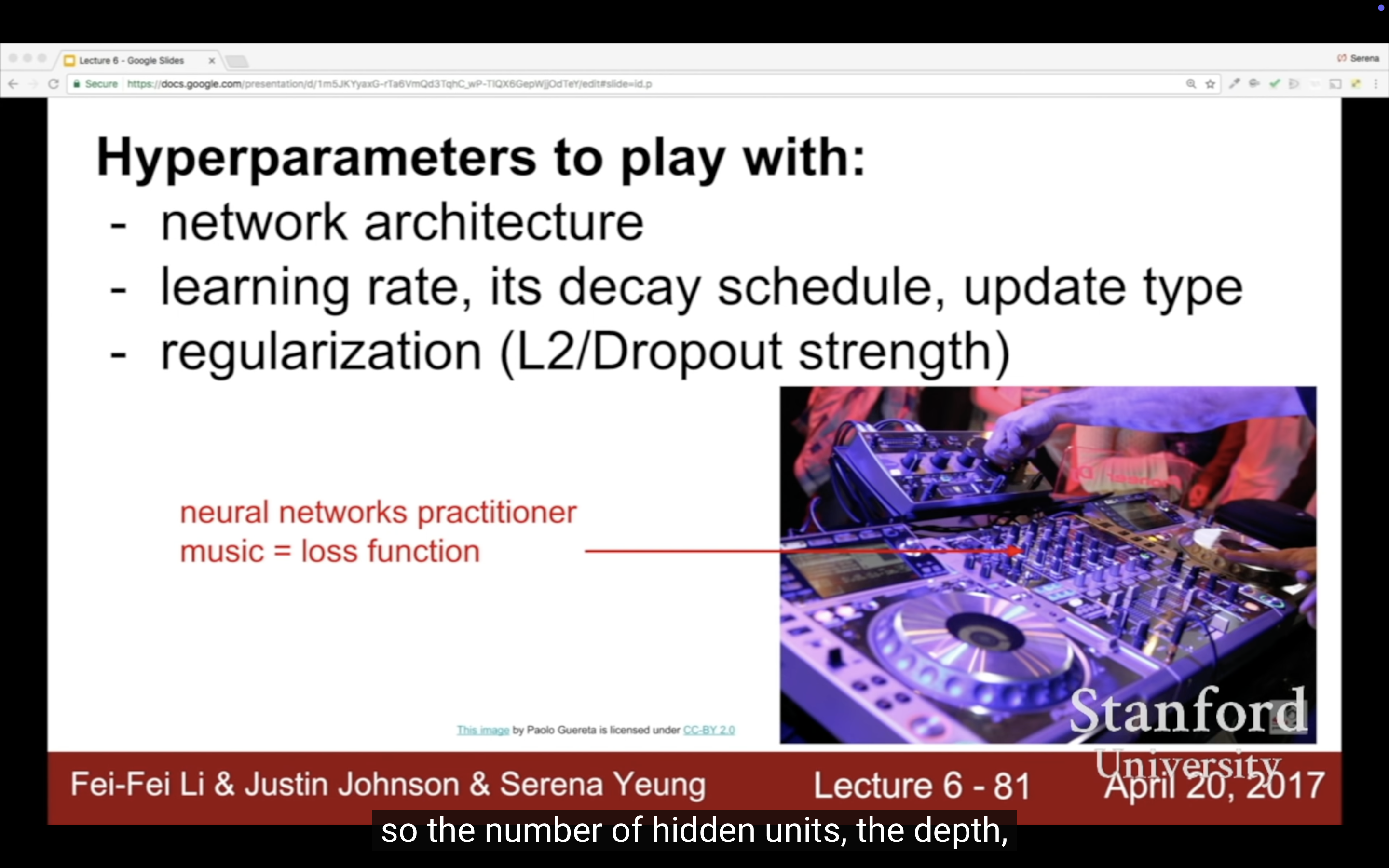

Hyperparameter Optimization

Cross-validation strategy,

先粗定大範圍,然後仔細尋找(coarse to fine search)。

justin在2017年會盡量避免一次搜索2到4個以上超參數,複雜度畢竟指數級增長。

Tip for detecting explosions in the solver:

If the cost is ever > 3 * original cost, break out early

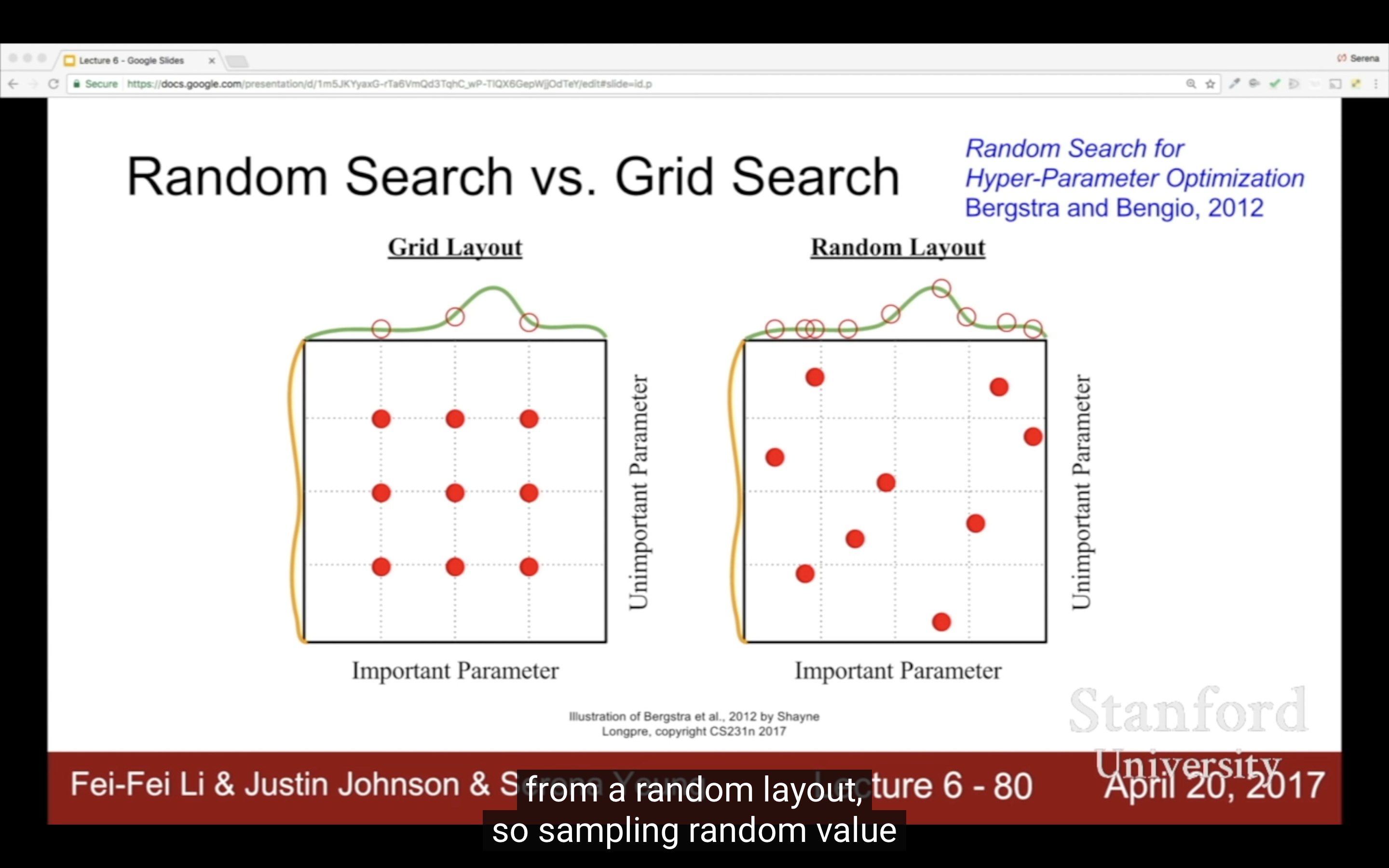

| 沒懂為什麼用10的uniform冪為範圍 | 隨機的更好? |

|---|---|

|

|

| 之前OFA和學姐做的另一個忘了名字的模型我整天就調適這玩意 | CV就是這麼枯燥,我當時做小樣本都快做瘋了,小樣本那玩意太多實驗了(找ppt |

|---|---|

|

|

| 觀察曲線調參 | ||

|---|---|---|

|

|

|

Track the ratio of weight updates / weight magnitudes

“Track the ratio of weight updates / weight magnitudes” 简单来说,指的是计算在每次训练迭代中,权重更新的大小与权重的当前大小之间的比例。

计算方式:

权重更新(Weight Updates):计算在一次迭代中,权重的更新量,通常表示为:

其中,$\eta$ 是学习率,$\nabla_w L(w)$ 是权重关于损失函数的梯度。

权重的大小(Weight Magnitudes):权重向量的模长,通常使用 L2 范数计算:

权重更新与权重大小的比率(Ratio of weight updates to weight magnitudes):

目的:

衡量更新幅度与权重大小的关系:这个比率可以反映梯度更新的幅度相对于权重当前大小的比例。

- 比率太大:可能表明学习率过高,导致梯度更新过大,容易导致训练不稳定。

- 比率太小:可能表明学习率过低,更新幅度过小,训练过程过于缓慢。

调节训练过程:通过监控这个比率,可以帮助调整学习率,以确保训练过程既不太剧烈,也不太缓慢,保持合理的收敛速度。

“Track the ratio of weight updates / weight magnitudes” 通过计算每次权重更新的大小与权重大小之间的比率,帮助评估训练是否稳定、学习率是否合适。

Lecture 7

改變了一個超參後,其他超參的最優值會改變嗎?比如改變model size,learning rate的最優解不太會變,如果已經找到一個較好的範圍了,就算最壞改變也只是讓模型更慢收斂到global optimal而已,尤其是用了比較好的optimization策略。

- Fancier optimization

- Regularization

- Transfer Learning(回想起2021年剛來,就瘋狂讓我學遷移學習,現在都沒人在提了)

Fancier optimization

注⚠️:公式裡的x實際上是w。

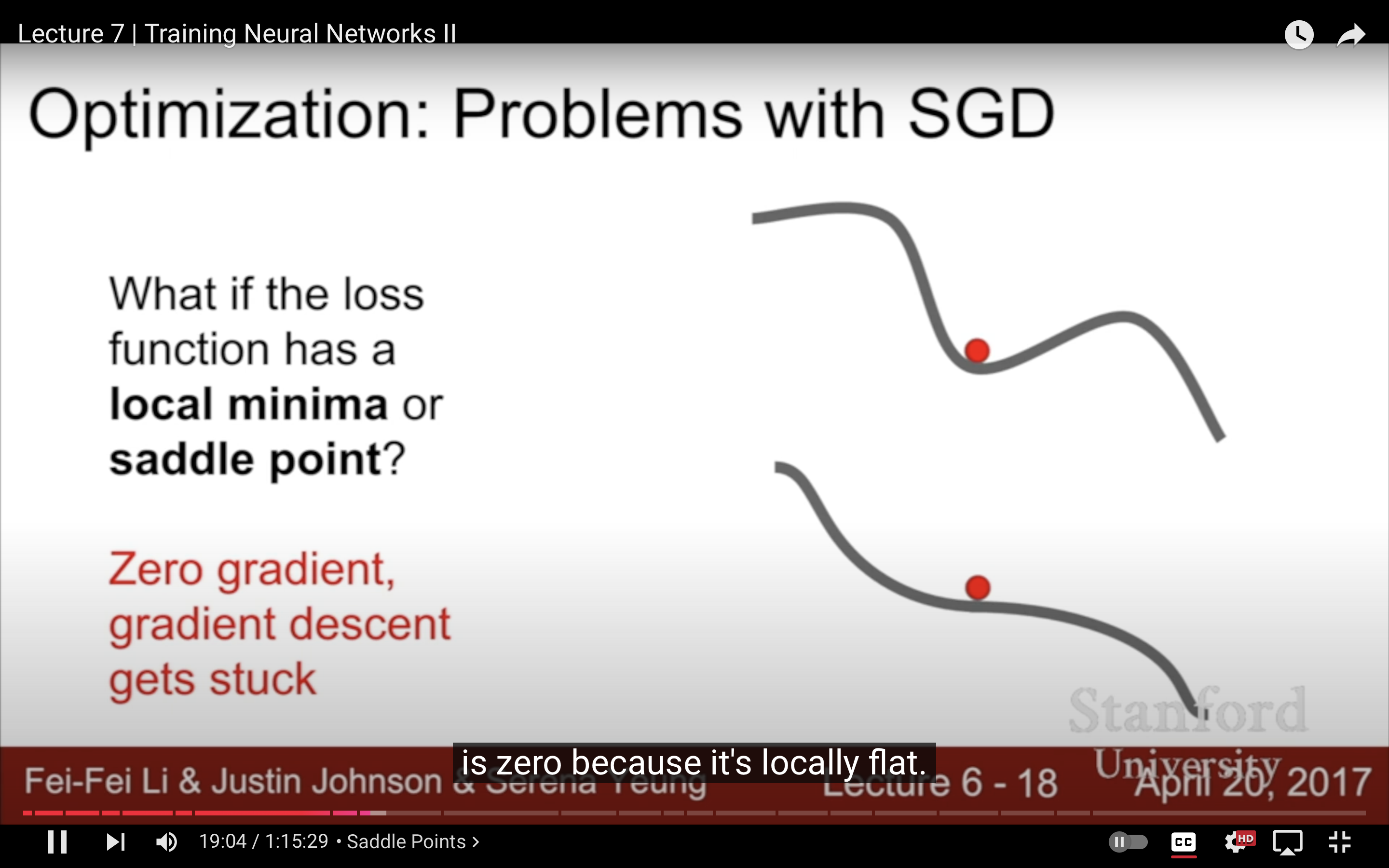

| local minima versus saddle point | |

|---|---|

|

|

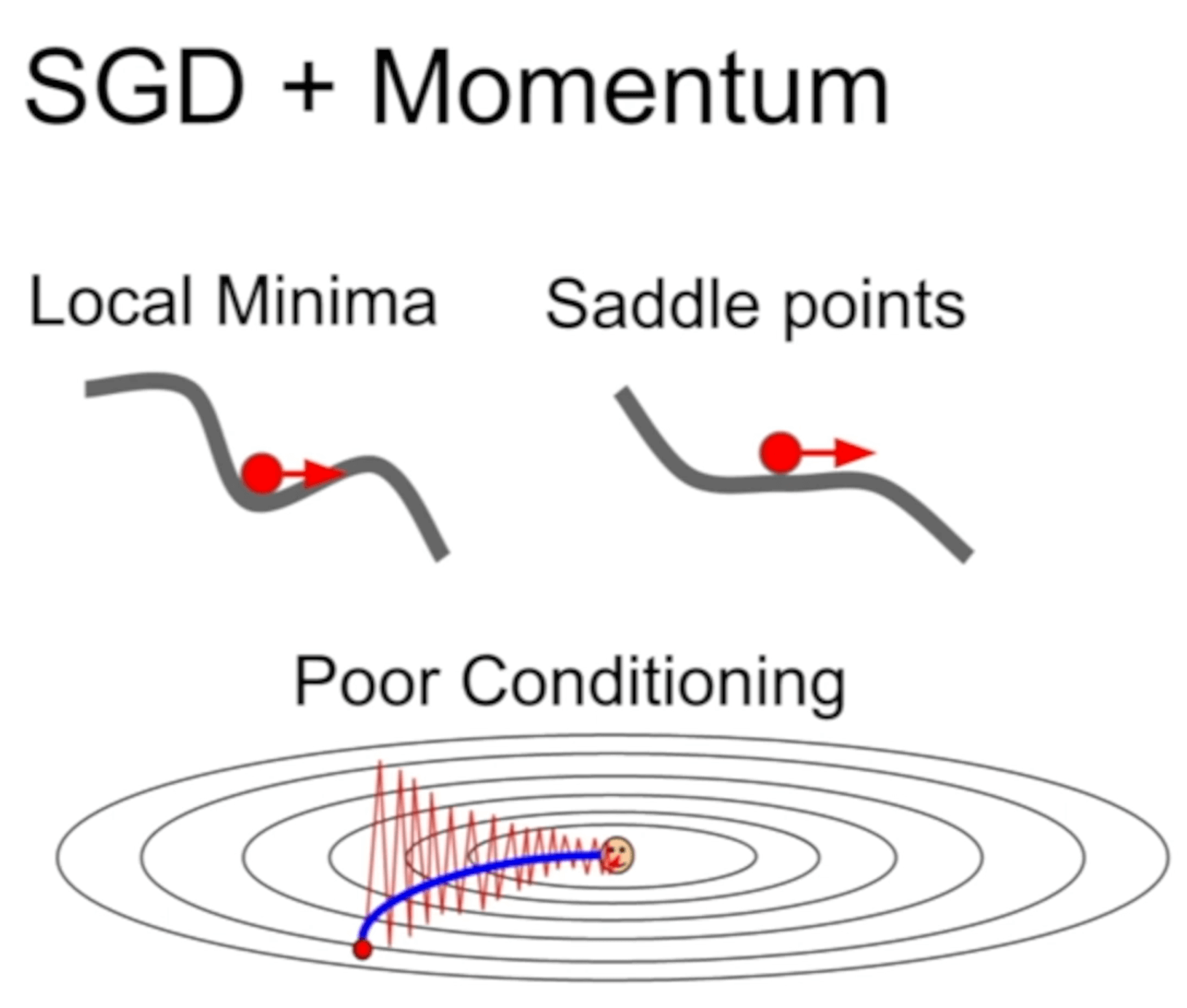

SGD Problems:

| 1.跟上面zig zag例子一樣,這個問題不光希望通過BN數據/特徵解決,也希望通過優化算法解決 | 2.local minima和saddle point,雖然一維看起來local minima比saddle point更嚴重,但比如說在100- dimension的空間裡,每一個方向都上升造成local minima是很罕見的(任何一個方向下降就不是local minima$f(x_0) \leq f(x), \quad \forall x \in 邻域U$),而且saddle point周圍斜率過低訓練過慢也是很麻煩的問題 |

|---|---|

|

|

3.因為mini-batch SGD每次只用一小部分,反應不了真實分佈,而且有很多噪音,所以訓練過程會很曲折meander,但其實full batch vanilla gradient descent還是有這些問題。

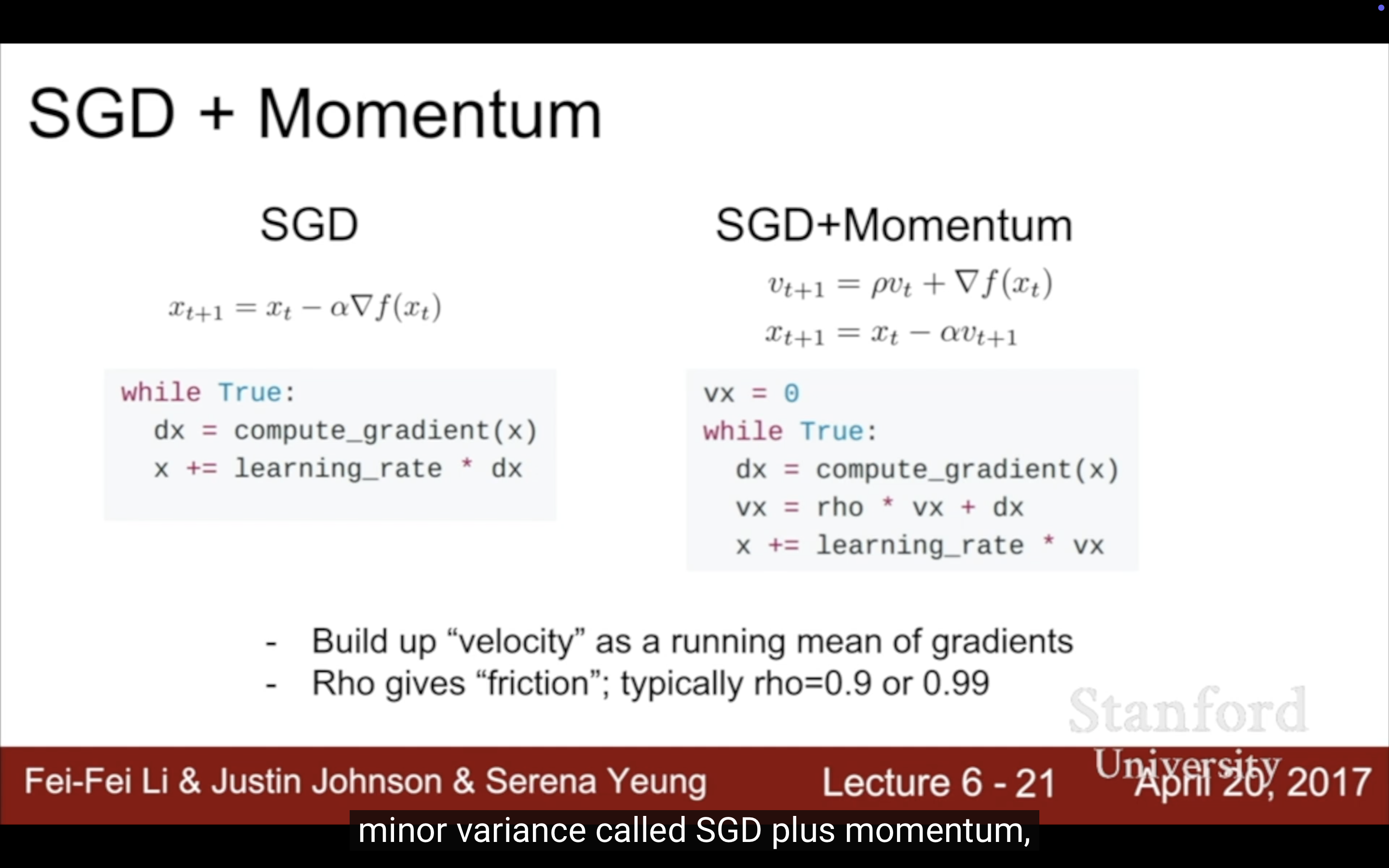

1. Momentum SGD

一些物理術語:

- velocity(速度,=speed速率+方向);

- Kinetic Energy(動能);$KE=\frac{1}{2}mv^2$

- Momentum(動量);p=mv,碰撞中的動量守恆:在兩物體碰撞過程中,雖然動能可能不守恆(如在非彈性碰撞中),但動量總是守恆的。

- Kinetic Friction(動摩擦);

- Static Friction(靜摩擦)。

動量和慣性的關係:

假設有兩個物體,質量分別為 1 kg 和 10 kg,兩者都以相同的速度 5 m/s 移動。

輕物體的動量:

重物體的動量:

儘管兩者的速度相同,但重物體的動量要比輕物體大,這意味著在相同的外力作用下,重物體的運動狀態更難改變,這就是慣性強的表現。

velocity一般就初始化為0。

有個同學的問題問到了我的疑惑,如果因為這個動量,gradient衝過了一個narrow/sharp很窄的最優點怎麼辦?Justin Johnson的解釋是,我們還是希望要一個flat平台的最優點,更robust,就算很窄的那個是最優點,我們不一定想要。

2. Nesterov Momentum

上面稍微變體。

| 公式看著有點頭疼,其實就是永遠在更新完gradient的點上計算新gradient,而不是在更新前計算gradient。現在計算有問題,希望loss和gradient一起計算,於是有了下面的版本。 | |

|---|---|

|

|

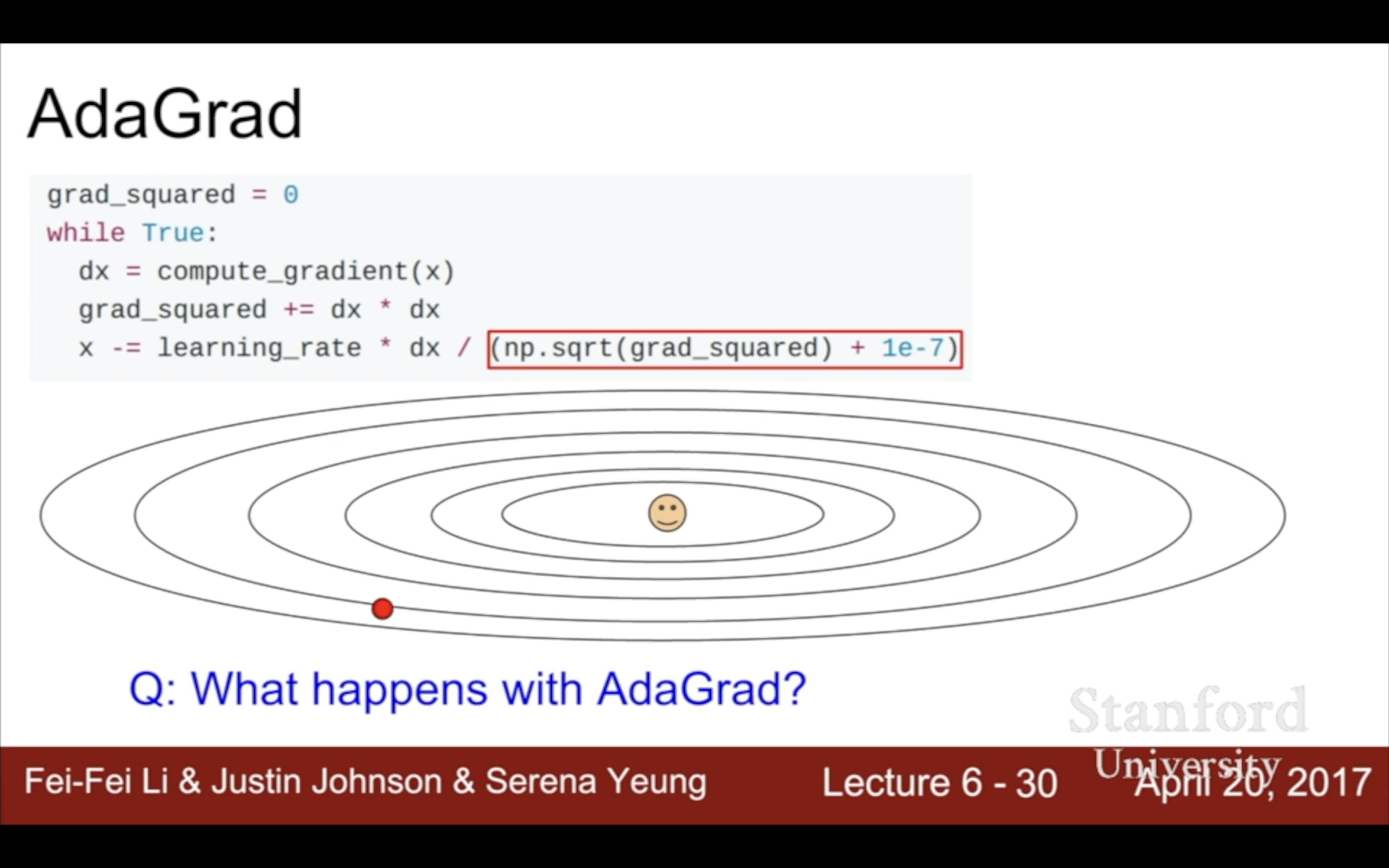

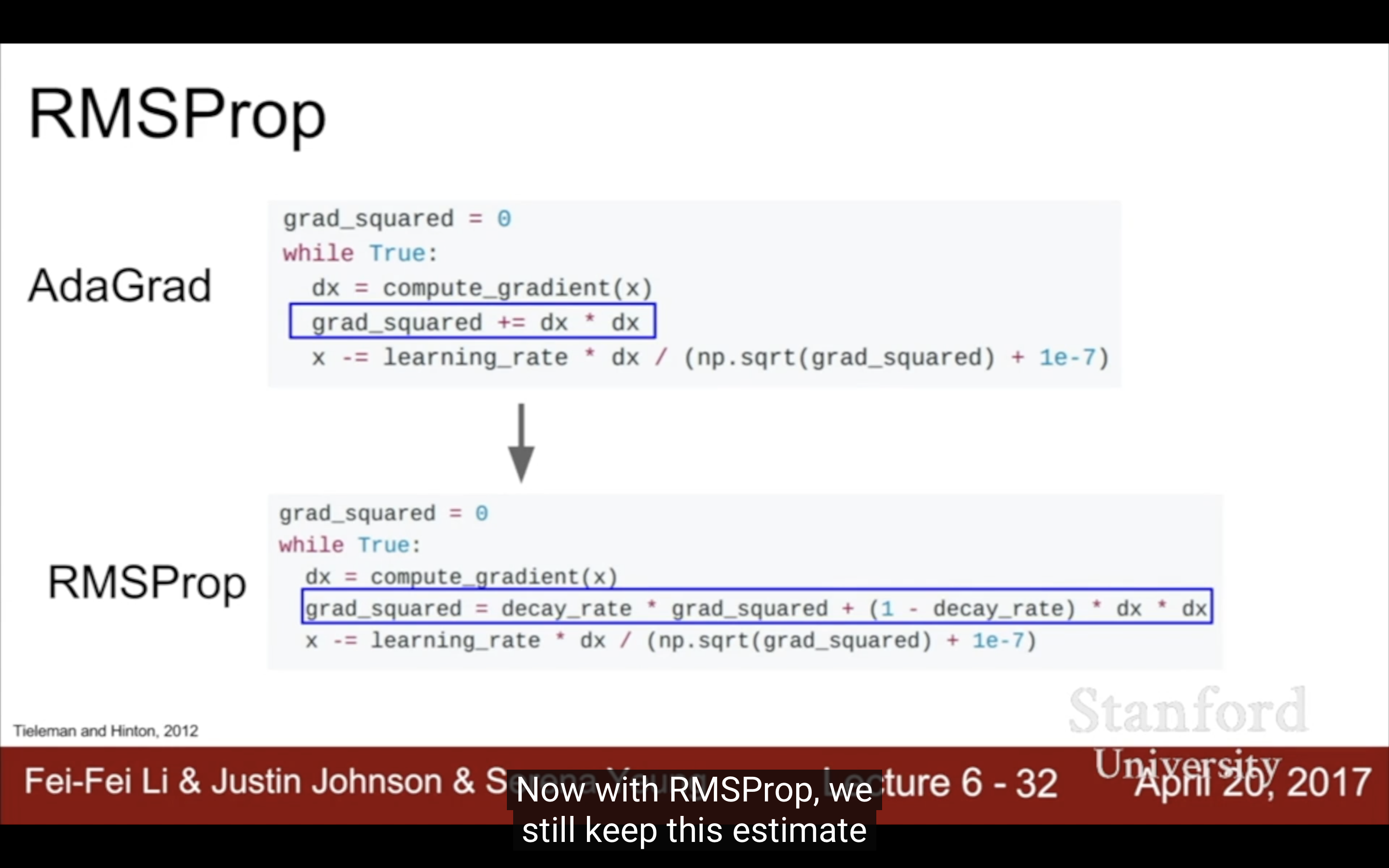

3. Ada Grad

類似於每次除以之前所有gradients的總和,目的是為了平均過大和過小的斜率/變化率/梯度以解決上面的zig-zag問題,但導致每次的梯度更新會越來越少。

4. RMSProp

上面的slight variation,這個分母會自己變小。

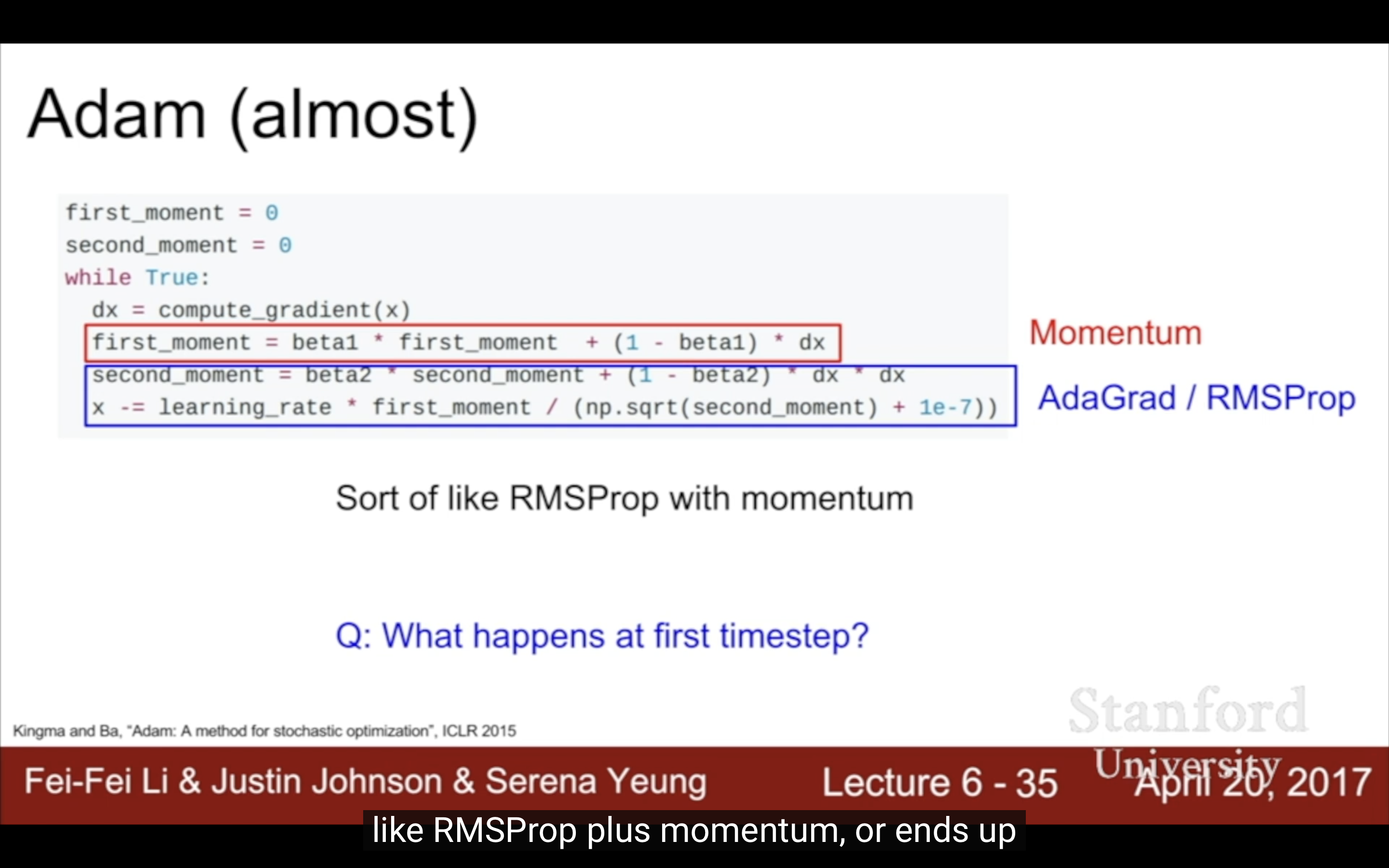

5. Adam

所以剛開始更新的時候底下分母很小,如果first moment不幸也很小的話可能導致更新幅度很大,讓模型更難收斂。要知道這不是因為loss函數斜率很大,只是因為adam 特性。

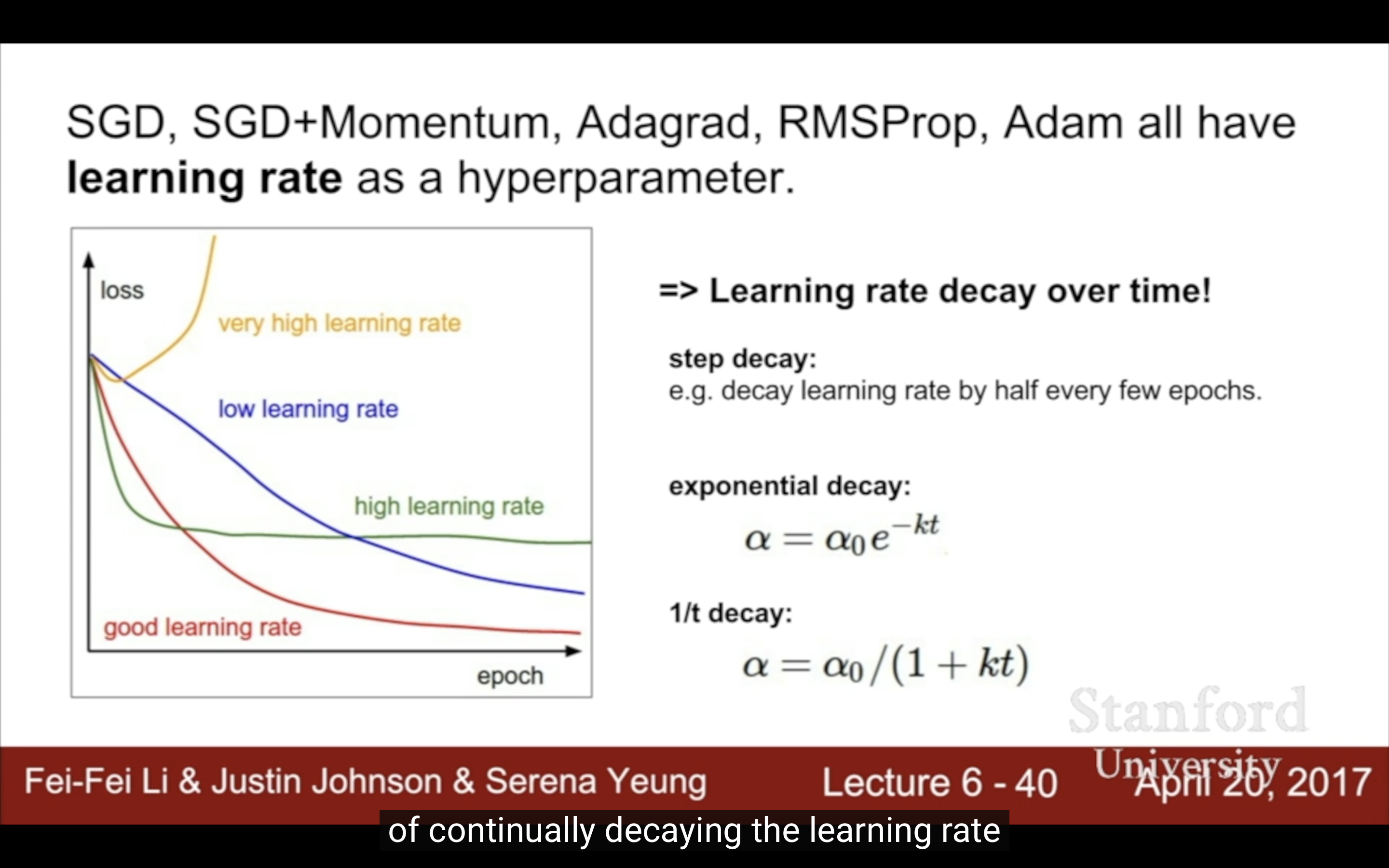

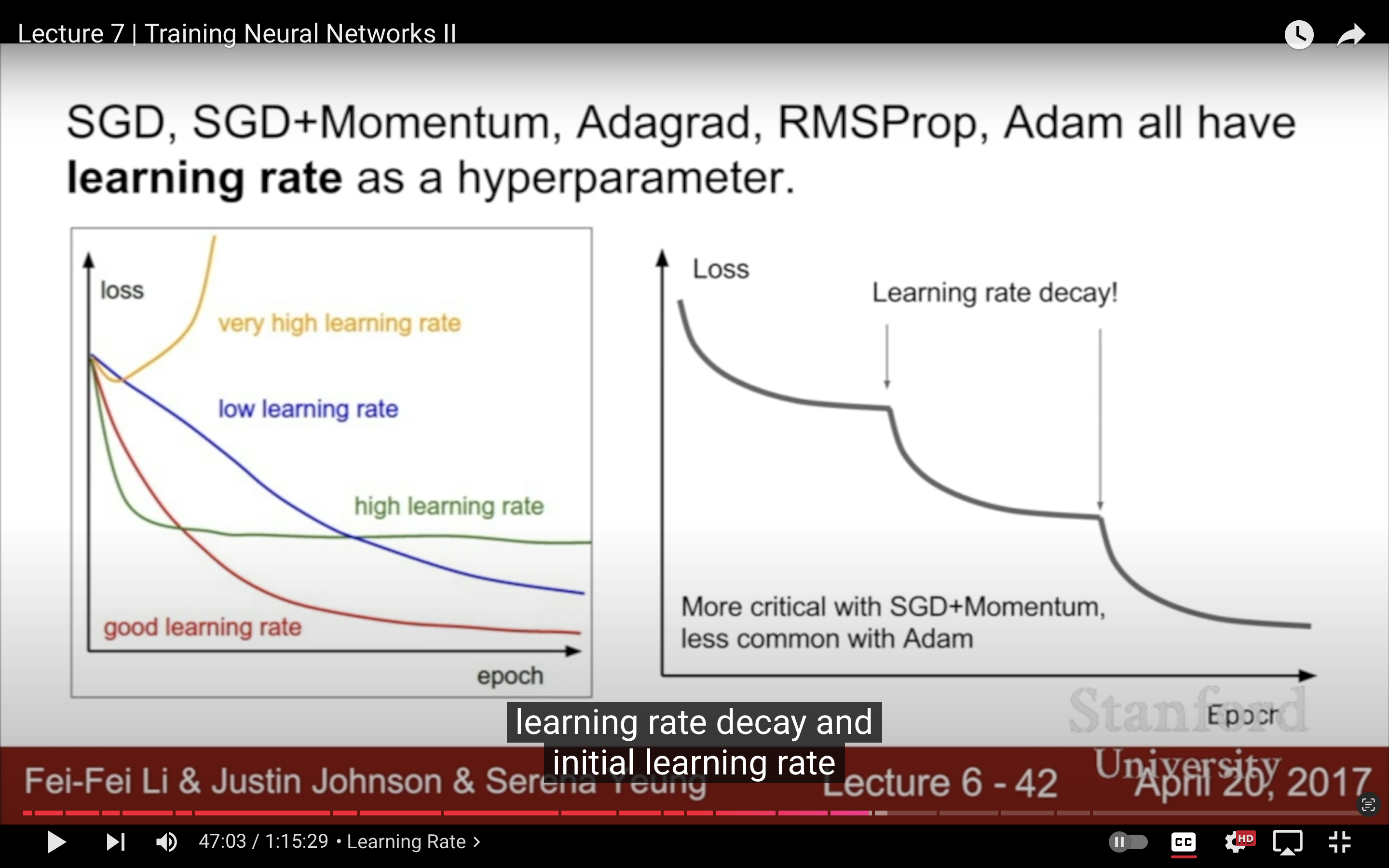

6. Learning Rate

| decay over time | 一般SGD Momentum用lr decay,而且最好先選一個lr,再用cross-validation選一個好的decay |

|---|---|

|

|

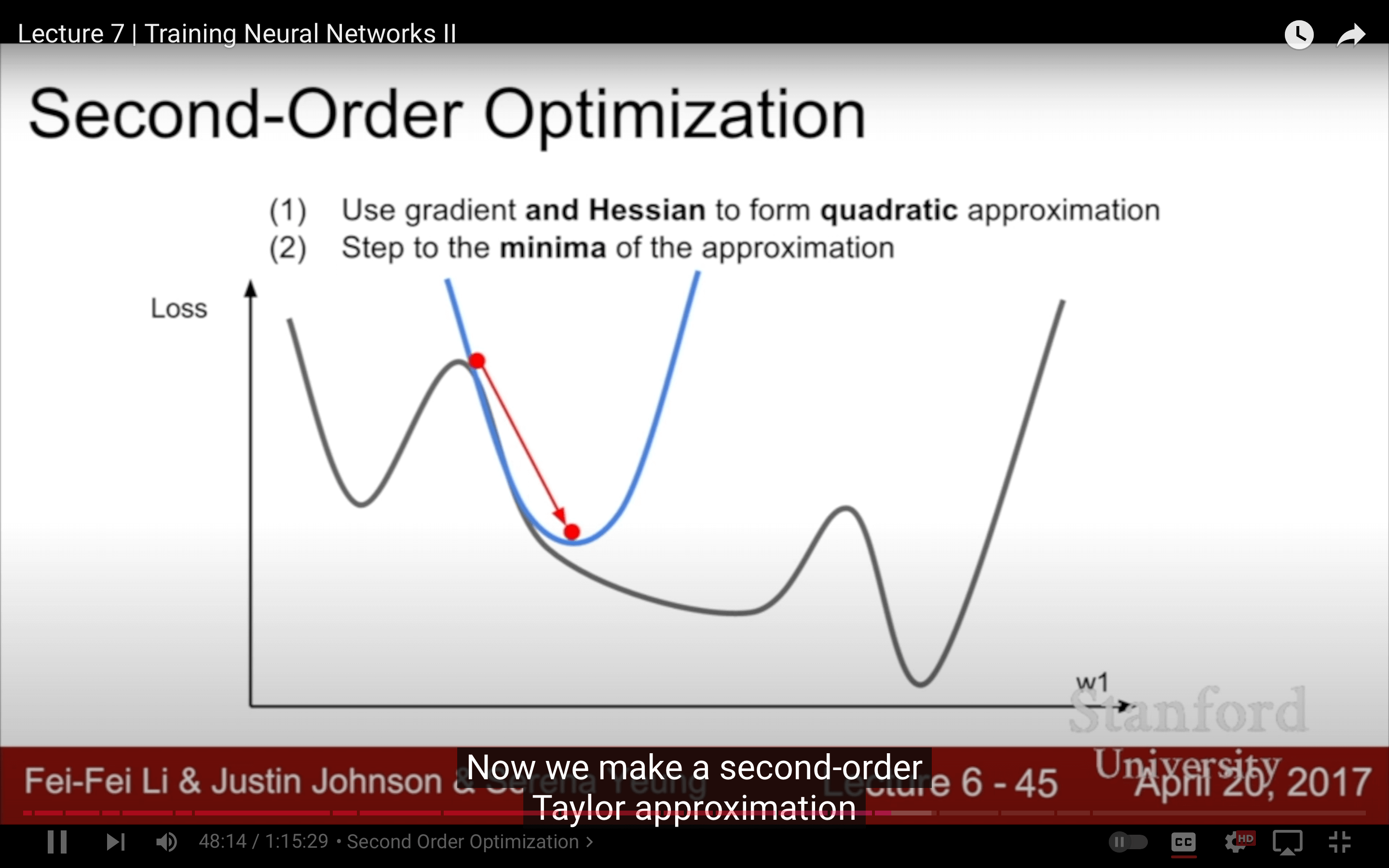

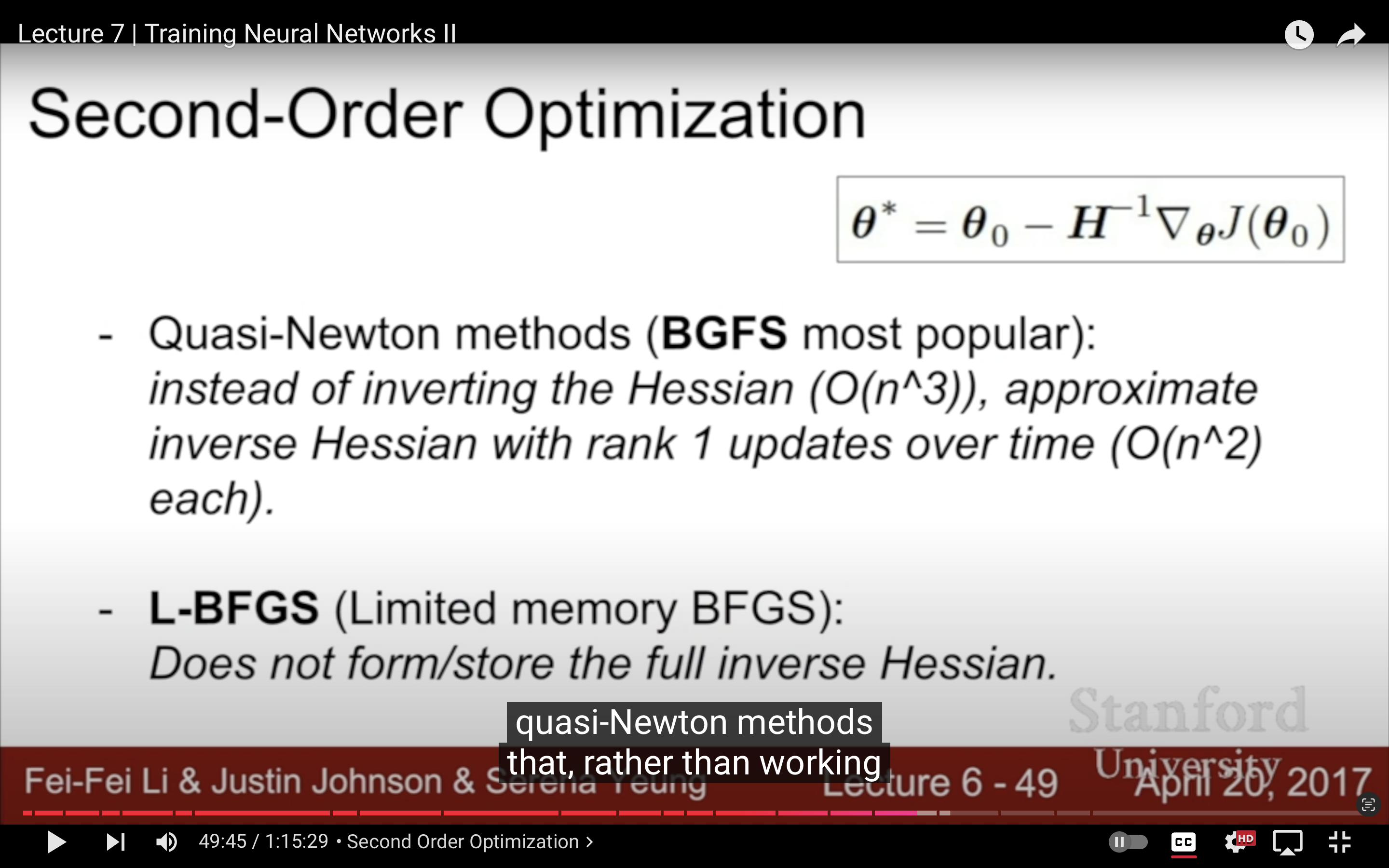

7. Second-order Optimization

好像沒見有人用過,這個倒是可以拿來當畢業論文的創新點。XD

| 考慮拿來水論文 | |

|---|---|

|

|

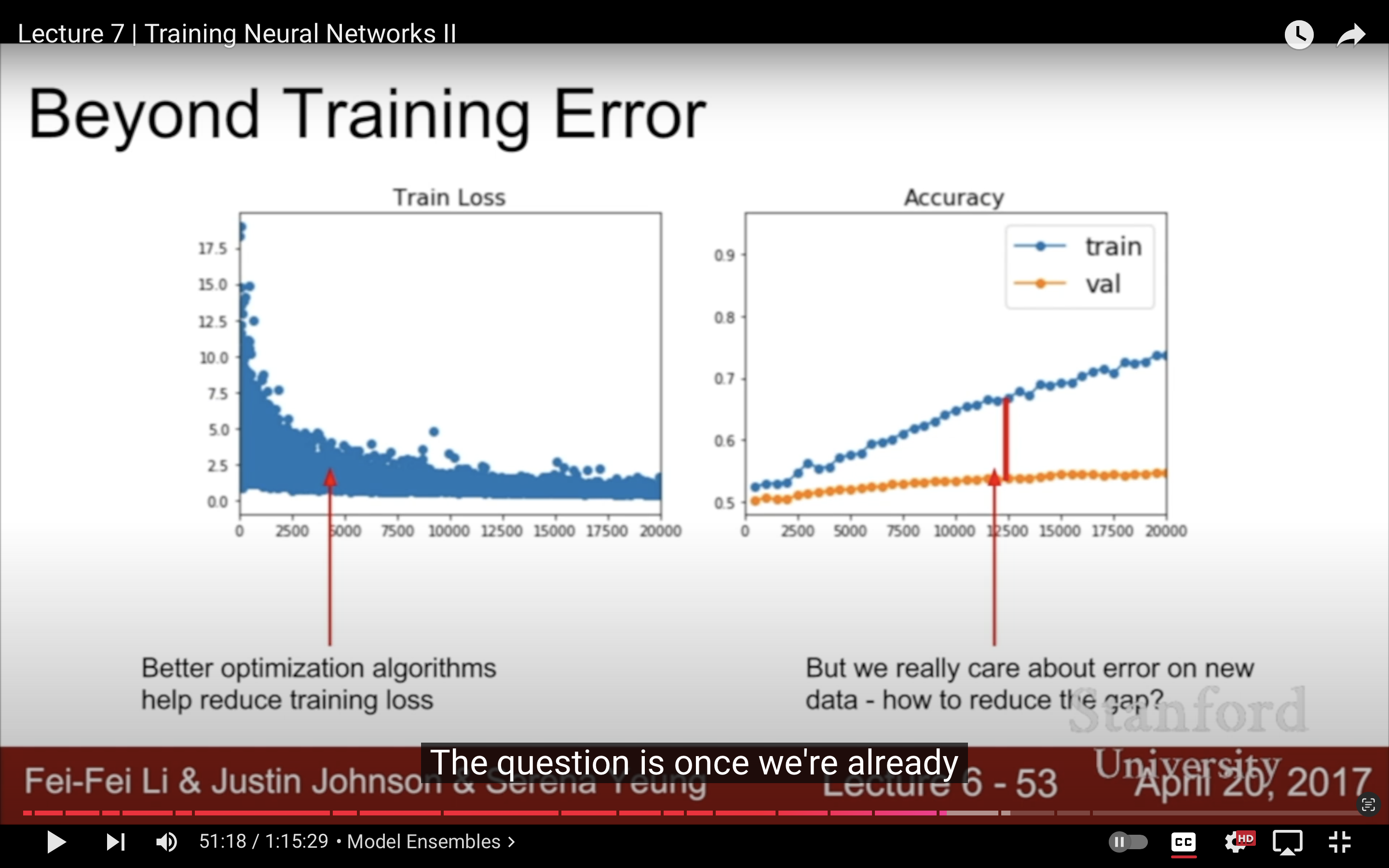

8. Test Error

| 如果在Training Dataset已經做得足夠好了,怎麼減小train error和test error之間的gap?記得嗎?test set是最後啟用的,我們只能用val set測試 | 用不同的隨機初始化訓練十個模型,平均他們的預測結果,在比賽裡還是有用的 | 或者可以在模型訓練的不同階段,把weights拿出來幾個snapshots當不同模型,自己跟不同時間的自己ensemble,2017當周的ICLR |

|---|---|---|

|

|

|

ensemble的模型可以用不同的超參數。

如果不訓練多個模型來提升泛化能力,單模型改善表現可以使用正則。

Regularization

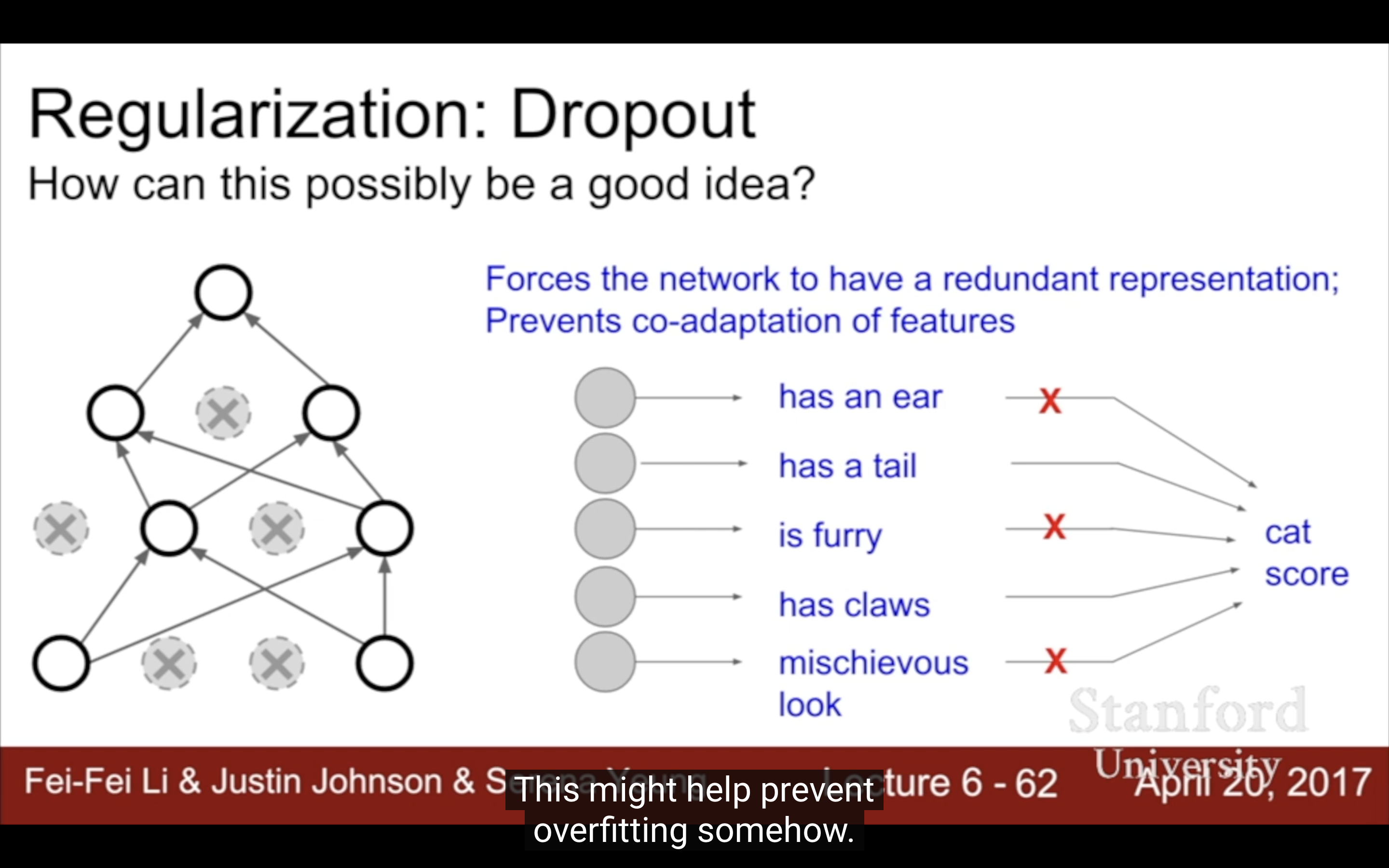

1. Dropout

在 dropout 技術中,將神經網絡中的一部分神經元的輸出設為 0,而不是將其輸入設為 0。

| 這種看起來就是totally messing with nets的行為怎麼就好用了? | |

|---|---|

|

|

反正就是好用。

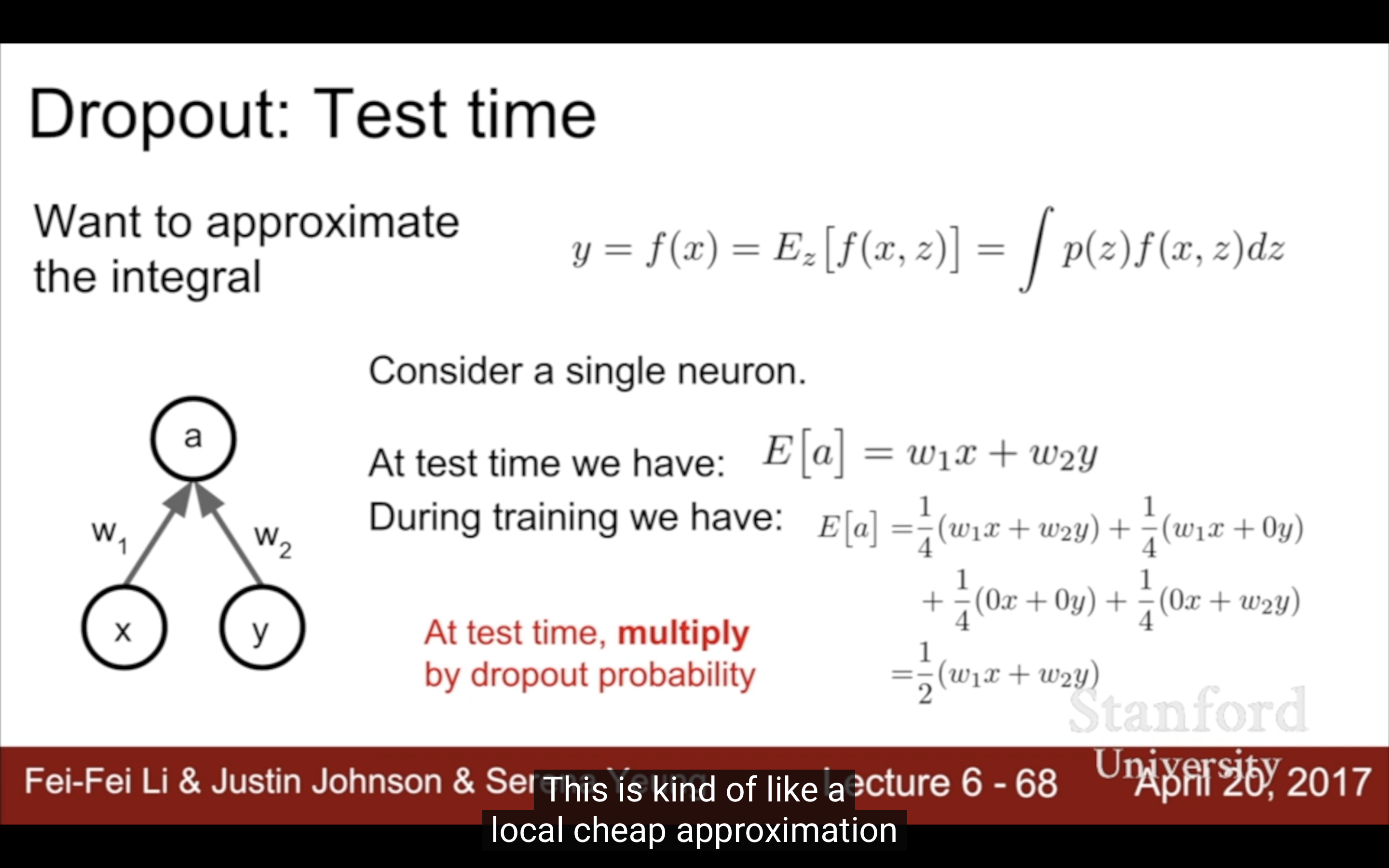

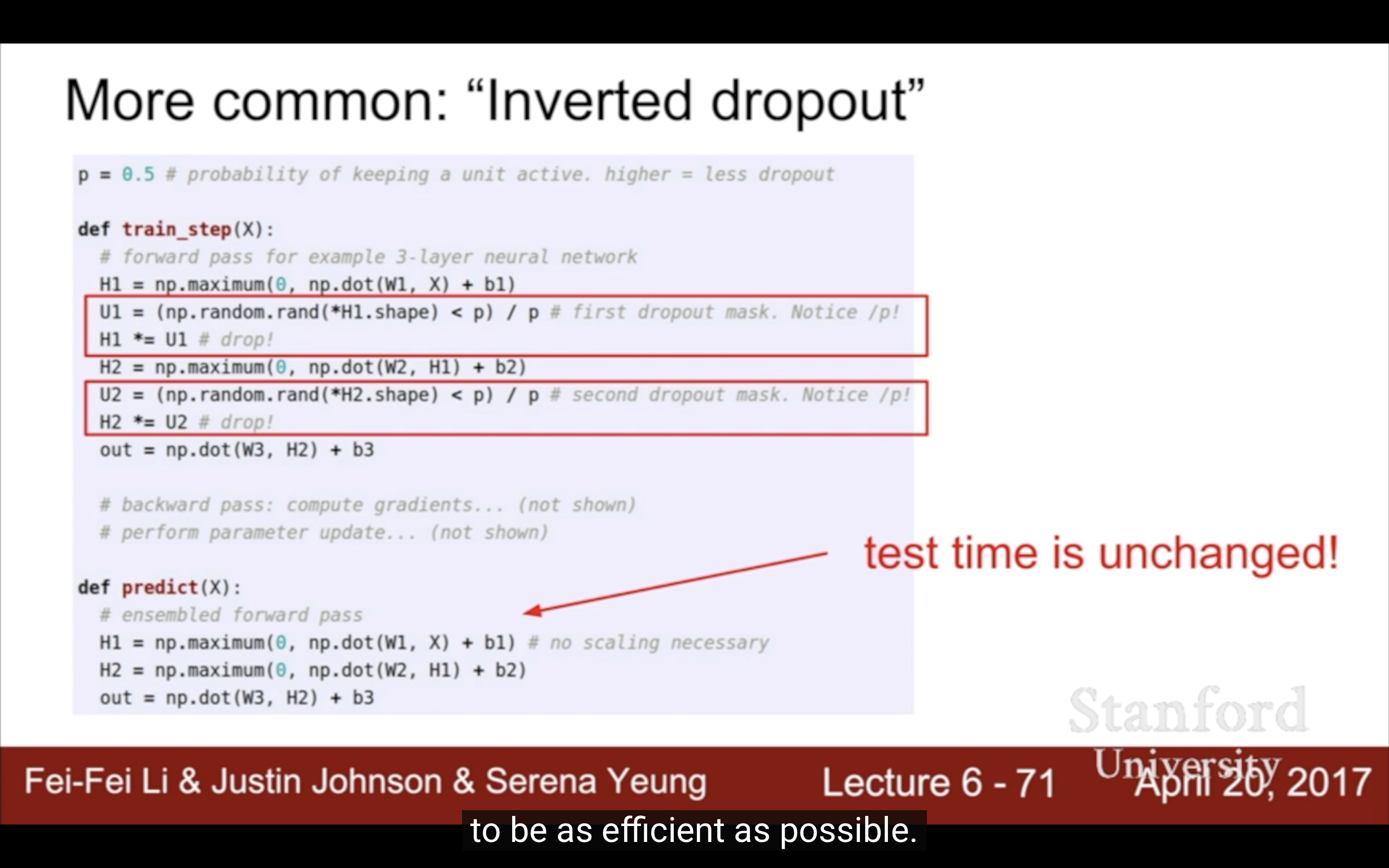

| test做法 | ||

|---|---|---|

|

|

|

dropout當然會導致training更久,因為w更新得更少了?

有點像都是引入了噪聲,有時bn就夠了,但dropout相當於給regularization加了個係數(變0的probability)更靈活了。

2. Data Augmentation

training加入stochasticity和noise的都可以看作regularization。

| pattern裡test time的marginalization是說“边缘化”,即再把噪聲給忽略掉 | 在網絡設計上加入這些“創新點”(別人的積木)可以當做大論文和專利的 |

|---|---|

|

|

每次用多少個正則手段?BN很多情況已經夠了(加速擬合、防止過擬合),應該每次感覺模型過擬合了才加入新的策略。

Transfer Learning

Off the shelf和off the wall到底啥意思?

这两个短语的含义是通过比喻或隐喻演变而来的,跟它们字面上的意思有些联系。让我分别解释一下为什么会有这样的意思:

Off the shelf

这个短语最初的字面意思是从货架上拿下来的物品。我们都知道商店里货架上的商品是直接可供购买的,顾客不需要等待生产或定制。所以,“off the shelf” 引申为“现成的”或“不需要定制的”。这个表达强调的是可以直接得到、无需额外处理的意思。例子:在一些领域,像软件、硬件、书籍等商品,有现成的商品直接从货架上取下,可以即刻使用,因此常常被形容为“off the shelf”。也可以用来描述任何“常规、标准化”的东西。

Off the wall

这个短语的起源比较有趣。它通常解释为某物“从墙上弹出来”,在字面上听起来像是某物离开了正常的轨迹,变得不受控制或不合常规。墙是一个常见的边界或框架,东西从墙上弹出来就意味着它突破了这个框架或界限。在这个意义上,“off the wall” 形容的是“跳脱框架、非常规、不拘一格”的事物。因此,原本它用来形容某事或某人行为怪异、出乎意料或充满创意,后来这个含义得到了广泛应用。

例子:如果你看到一个人的行为或想法非常独特,无法用传统的方式理解,或者说他的艺术作品完全不符合常见的审美标准,就可以用“off the wall” 来形容它的独特性或非常规性。

这些表达通常是从具体的、可观察的现象逐渐引申出更抽象的意义。

| 當時的CNN剛開始pretrain-finetune,已經不train from scratch了。 | |

|---|---|

|

|

optimization- training loss

regularization-test performance

transfer learning-less data

剛發現原來invisibility:true/false這個已經沒用了,得-BeInvisible,都給忘了。另外priority一定要有,不然推薦文章排序會bug。

Lecture 8

- CPU vs GPU

- Deep Learning Frameworks

- Caffe / Caffe2

- Theano / TensorFlow

- Torch / PyTorch

CPU vs GPU

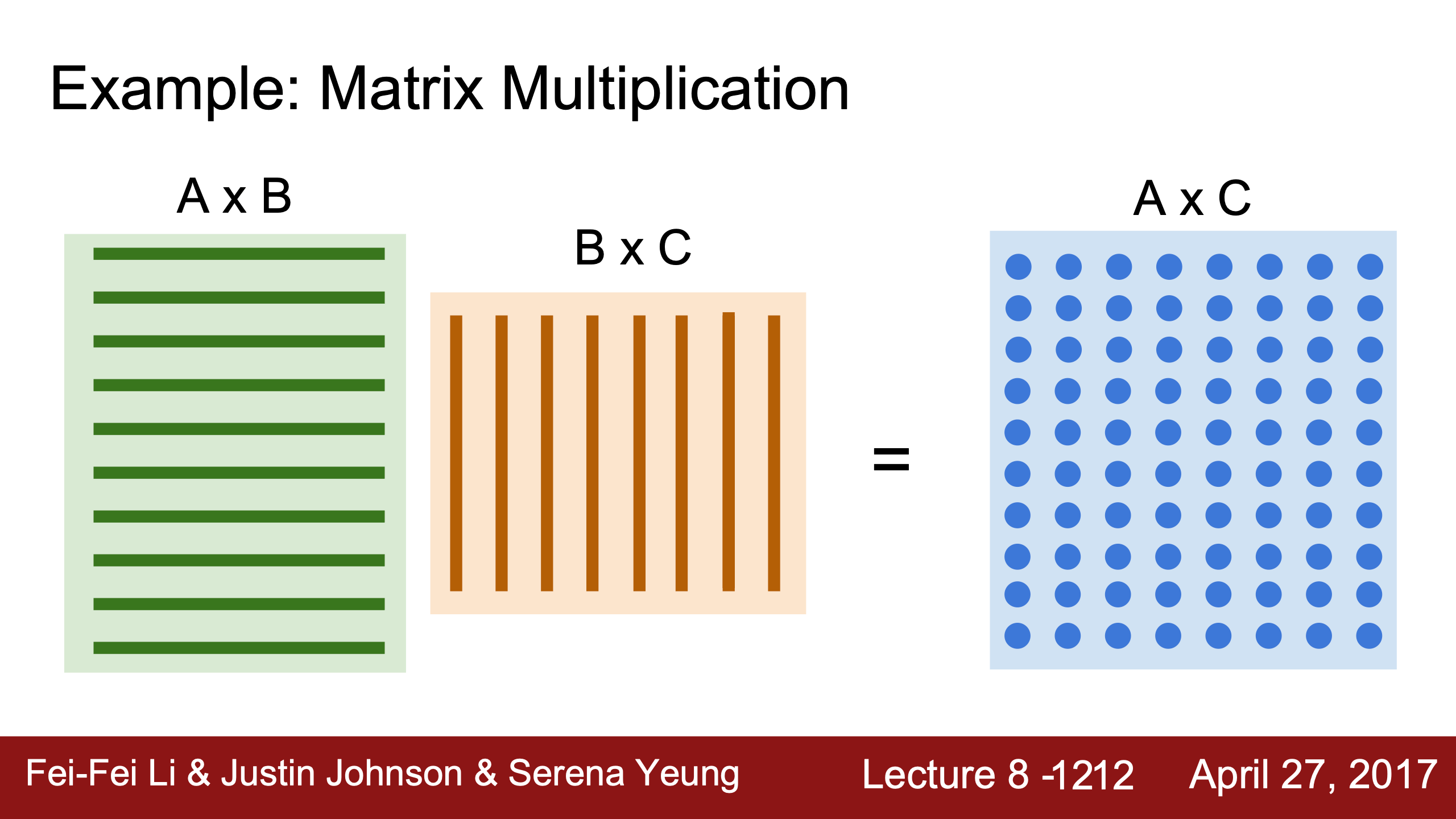

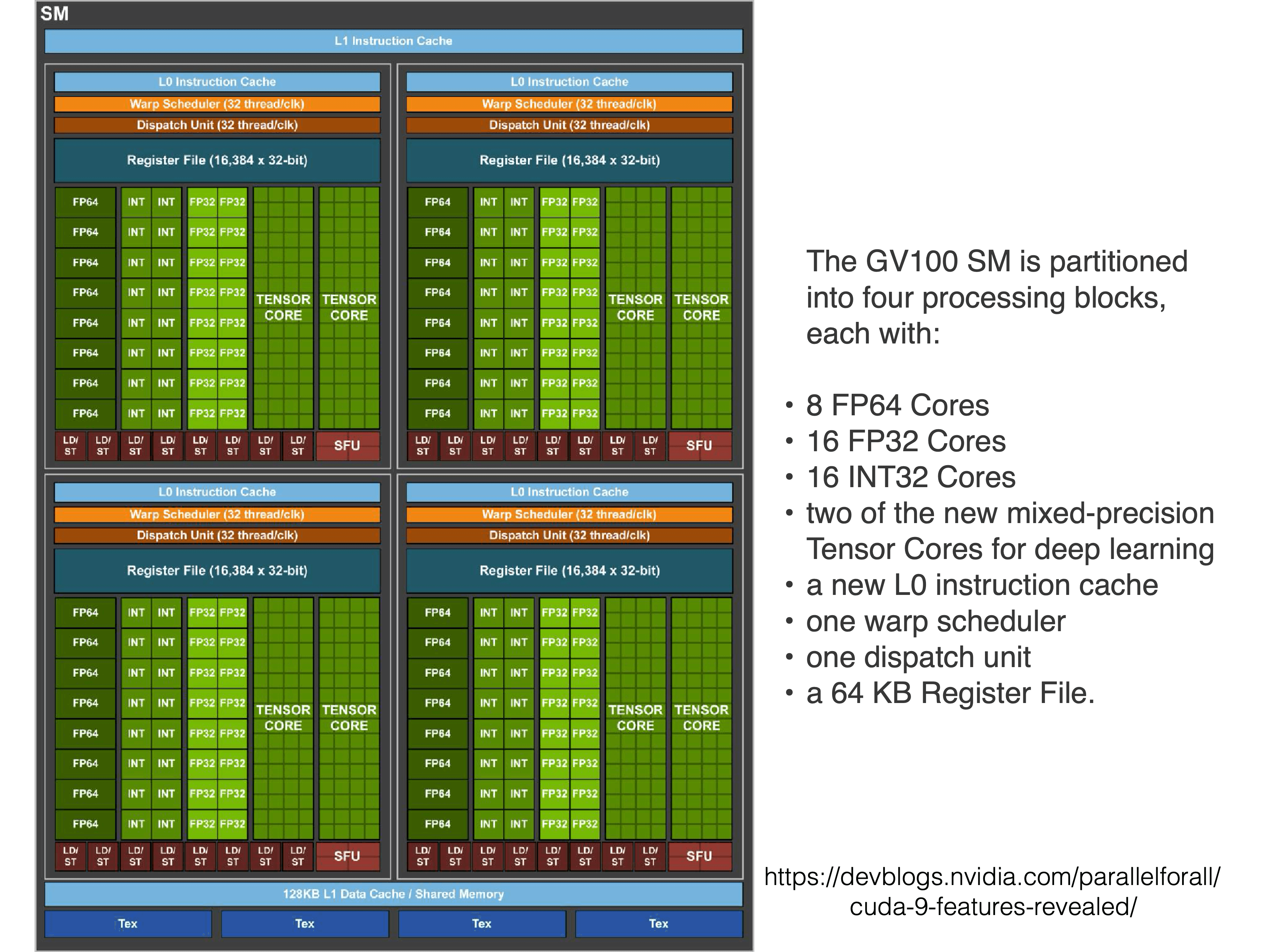

對應的行和列完全可以分別在不同的gpu core上同時運算,包括cnn的不同filter等都是parallelized任務

沒學會的cuda課,王麓涵好像是在做OpenCL系的矩陣算法優化來著,來浙大最遺憾的就是抄那門課作業糊弄及格(代碼之前又被我從郵件下回來了),在雲大最後悔的是編譯原理抄作業過關,有趣的是都是github上的校友repo,再其次就是OS課的大作業自己沒做出來抄了一段代碼。

Justin Johnson說是他從沒為自己的研究寫過cuda代碼。And cuDNN much faster than “unoptimized” CUDA.

Deep Learning Frameworks

Torch(NYU / Facebook)→PyTorch(Facebook),2017年時Justin Johnson最常用的就是Torch和Pytorch,現在也仍然是吧。

Caffe(UC Berkeley)→Caffe2(Facebook)

Theano(U Montreal)→TensorFlow(Google)

自己寫from scratch的(不是stretch伸展“Scratch”的原意是體育比賽地上畫的線)積木代碼雖然很爽,但是相比之下有三個不足:

The point of deep learning frameworks:

(1) Easily build big computational graphs

(2) Easily compute gradients in computational graphs

(3) Run it all efficiently on GPU (wrap cuNN, cuBLAS, etc)

無論是寫代碼效率還是運行效率都讓人不得不用第一代發源於academia第二代發展於industry的現成框架。

| Numpy is definitely CPU only. And it’s a pain to have to compute your own gradient. | GOAL: looks like numpy, but on GPU |

|---|---|

|

|

Tensorflow

沒有allocate memory,只是在graph裡加入這些nodes,所謂“placeholders”。

在CPU memory和GPU memory之間copy數據(weights/gradients)是開銷很大的,會成為bottleneck,定義成variable而不是placeholder可以避免這個問題:

Change w1 and w2 from placeholder (fed on each call) to Variable (persists in the graph between calls. Add assign operations to update w1 and w2 as part of the graph! Run graph once to initialize w1 and w2 first, then run many times to train.)

為什麼X和y不也放進graph裡?因為比如mini-batches裡的數據每個iteration會變,沒法提前存。

updates只是為了更新w加入的一個依賴於w的變量,因為想計算updates就要先更新前置w nodes,tf.group將多個操作聲明依賴關係,使他們作為一個整體運行,updates只是返回None。

相比一點一點group需要的參數,用tf的optimizer一兩行就夠了,內部實現跟上面一樣。

Justin Johnson也只知道placeholder是graph之外的,variable存在在graph裡面,並不清楚內部實現。

顯式定義的loss也可以用tf的函數代替。

最後可以把initial也都用簡便函數代替。除了這些還有很多高層庫能用,比如Keras就是基於tensorflow開發的(剛知道,也可以用tensorflow前身theano當後端),因為computational graph(比如ass1 ass2裡的)是很底層的實現,思考neural nets時一般會用比較高層的視角,用高層抽象的庫對開發效率是很有幫助的。在keras裡就變成了model.compile做back propagation(backward)工作,model.fit取代train()。Sklearn就不像keras是某個框架的API,也不是只面向深度學習的,是基於NumPy、SciPy 和 Cython的獨立机器学习库 。

前後對比:

| 代替前 | 代替後 |

|---|---|

|

|

Pytorch

相比tensorflow顯式更改cpu:0和gpu:0,pytorch是改數據類型——dtype = torch.FloatTensor。

|

|

torch沒有很多高層庫的選擇,只有nn.Modules。

tensorflow會先定義一個graph,然後train()時運行多次這個graph;而pytorch是每次前向forward pass裡都創造一個新的graph??這樣能讓代碼更clean。

Autograd

| 而且可以定義New Autograd Functions,就跟assignment1和2裡的layers/layer_utils一樣。 | optimizer.step()更新所有參數,tf裡是seesion.run() | 也可以Define new nnModules,跟assignment2裡classifier的fcnet和cnn非常相似。Define forward pass using child modules and autograd ops on Variables. No need to define backward - autograd will handle it. |

|---|---|---|

|

|

|

torch.clamp(input, min=None, max=None, *, out=None)會把tensor(就是gpu上的np.array)最小值截斷到min,最大值截斷到max,不改變形狀。

dataloader是方便數據分割操作的玩意兒,需要定義自己的數據class,有minibatching, shuffling, multithreading等。例子等ass2寫的時候再理解吧

visdom Somewhat similar to TensorBoard: add logging to your code, then visualized in a browser Can’t visualize computational graph structure (yet?)(Justin Johnson沒用過)

Direct ancestor of PyTorch (they share a lot of C backend)

Written in Lua, not Python?我去居然是lua。2016年Justin Johnson上課還用torch,2017的pytorch是很新的東西。

static優勢是serialization序列化,部署時比較容易?

dynamic優勢:1.conditional,pytorch要做的跟我在numpy裡做過的一樣,但tf就要用tf.cond提前在graph裡加nodes/ops,倒是可以做到一樣的能力,就是麻煩;2.loop也是,循環也需要在graph裡顯式定義出nodes,可以看出tensorflow幾乎創造了自己的計算圖的programming language。Justin Johnson覺得學著用新語言很麻煩,用torch更舒適。

Recurrent networks 、Recursive networks,cs224n的Dynamic Graph Applications例子,比如對數Tree Data Structure的數據處理,torch可以就用普通的python做法,tensorflow就究極麻煩

Caffe

- Core written in C++

- Has Python and MATLAB bindings

- Good for training or finetuning feedforward classification models

- Often no need to write code!

- Not used as much in research anymore, still popular for deploying

Caffe: Training / Finetuning

No need to write code!

- Convert data (run a script)

- Define net (edit prototxt)

- Define solver (edit prototxt)

- Train (with pretrained weights) (run a script)

上這課的時候一個周前剛Facebook發布了caffe2。

- Static graphs, somewhat similar to TensorFlow

- Core written in C++

- Nice Python interface

- Can train model in Python, then serialize and deploy without Python

- Works on iOS / Android,

|

|

Lecture 9

Case Stydies:

- LeNet-5

- AlexNet (2012 ImageNet Large Scale Visual Recognition Challenge (ILSVRC) Winner)

- VGG (ILSVRC’14 2nd in classification, 1st in localization)

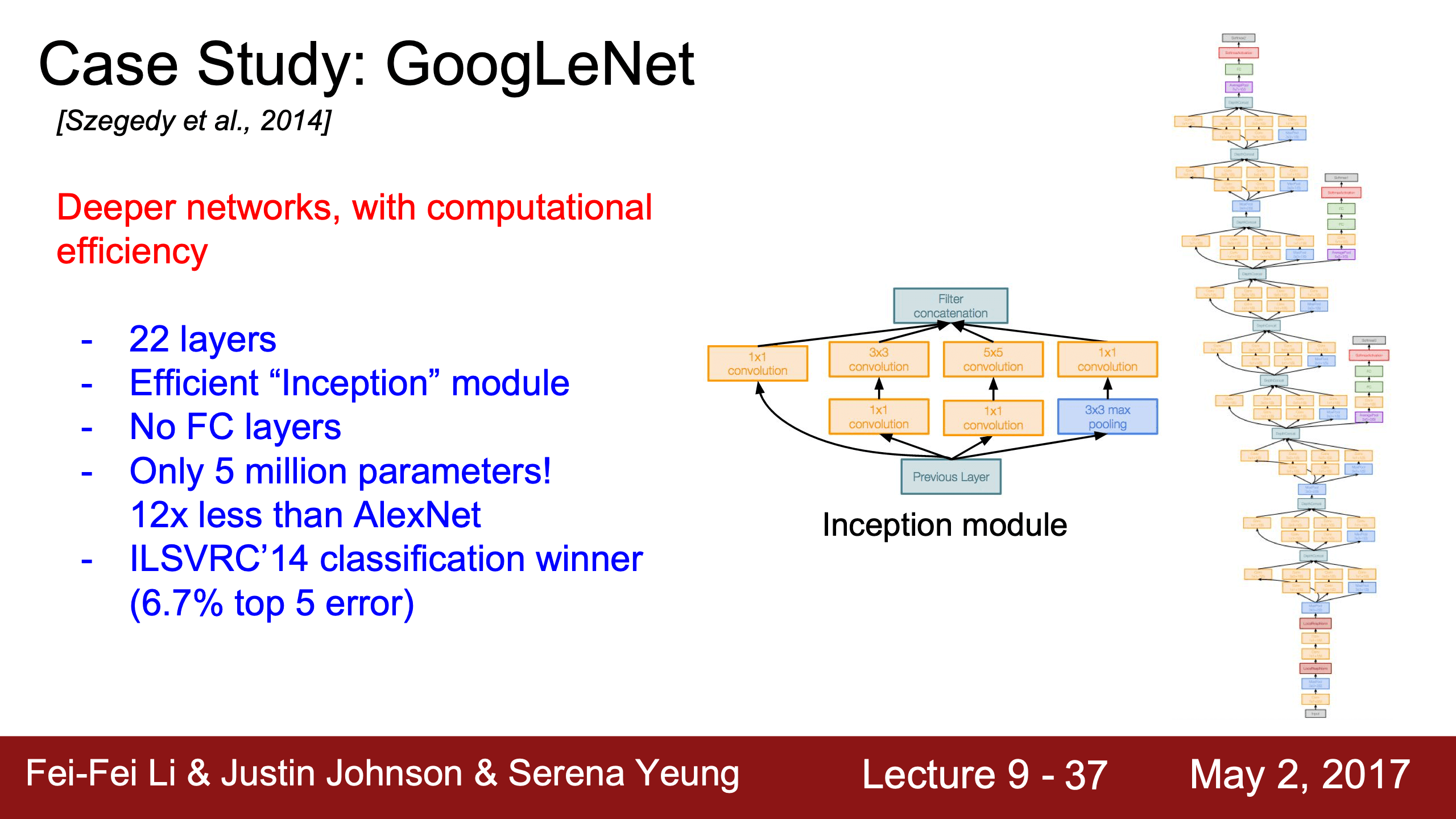

- GoogLeNet (ILSVRC’14 classification winner)

- ResNet (ILSVRC’15 winner,也在COCO’15數據集上的各比賽裡都明顯優於其他模型)

這些模型都是ILSVRC比賽的冠軍模型,空缺的2013年的ZFNet只是增加了AlexNet的參數量。

李飛飛的ImageNet只在2010年到2017年之間舉辦了這個ILSVRC比賽,因為2017年之後ImageNet分類任務的錯誤率太低,已經沒有再在這個任務上提升的必要了。

ILSVRC的成功促進了深度學習技術在計算機視覺領域的爆炸性發展,但隨著技術的進步和研究焦點的轉移,比賽完成了其歷史使命而逐漸退出舞台。

LeNet-5

AlexNet

| 有些細節沒有說明(simplified),比如開始的224變成227(Serena說有些funny pattern) | 因為當時GTX 580顯存只有3G放不下所有參數,所以分成兩半訓練 |

|---|---|

|

|

ZFNet

| 參數變了,但idea一致 | 之後就是filter變小,layers變多的趨勢 |

|---|---|

|

|

VGG

感受野(Receptive Field)指的是卷積神經網絡(CNN)中某個輸出單元對輸入圖像的感知範圍。簡單來說,它代表了輸出特徵圖上某個像素或神經元,能夠從原始輸入圖像中“看到”的區域大小。

感受野大小 就是這個像素值所受影響的輸入區域的範圍。例如:

如果感受野大小是 3×3,這意味著輸出特徵圖中某個像素對應於輸入圖像的 3×3 區域。

| 比如三層的activation maps裡,layer3上的一個點(一個像素)是由layer2的3x3範圍計算得到的,layer2的3x3是layer1上的5x5計算得到的。 | 因此7x7的一個filter可以由 3 個3x3的filter代替。所以從2014年的VGG之後都是上面所說的“filter變小,layers變多的趨勢”。 |

|---|---|

|

|

$3 * 3^2C^2 = 27C^2 < 7^2C^2 = 49C^2$,3 個 3x3 filters代替 7x7 filters,這個替換的參數量是原來的55%。

| 不是所有參數都要一直保存在顯存裡,梯度是圖裡Total Memory的2倍,無論是Hidden Layer/Activation Map還是Weights/Filters都是以浮點數存儲,FP32(32位浮點數,4字節) | VGG-16就是加FC一共16層,VGG-19多3層CONV,圖裡不知為何跟實際不太一樣,vgg應該是block1和block2有2層conv,vgg16後面3個blocks都是3層conv,vgg19後面3個blocks都是4層conv。 |

|---|---|

|

|

再詳細記錄一下數量計算,這個很有用:

- 存在顯存裡的數據:

- 模型參數Weights and Biases,每次前向和反向傳播都要用到;

- 梯度Gradients,反向傳播結束後可以釋放,前向完再佔用顯存;

- 激活值Activations(數據集dataset是在CPU Memory或磁盤裡),

- 哪些層有激活層?卷積層(Conv Layers),全連接層(FC Layers),所以這些層計算梯度需要考慮activation function;

- 哪些層沒有?批量歸一化層(BatchNorm Layers),Dropout之類的;

- 哪些激活函數需要存激活值?

- $\text{Sigmoid:} \quad \sigma’(x) = \sigma(x) \cdot (1 - \sigma(x))$

- $\text{Tanh:} \quad \frac{\partial \tanh(x)}{\partial x} = 1 - \tanh^2(x)$

- 哪些不需要存激活值,需要存激活函數的輸入而不是輸出,或者存別的?

- ReLU可以存activation的inputs而不是ouputs,或只存一個mask,輸入是正數的梯度是dout * 1,負數或0的梯度是dout * 0,這很像池化層(Pooling Layers),也是dout * MASK;

- Leaky ReLU/PReLU也差不多,只需要存一個MASK,區別是負數或0的梯度是dout * alpha;

- 除了ReLU/dropout這種存個MASK可以節省顯存之外,還可以用反向重計算(Recompute Activations)

- 如果顯存非常有限,可以在反向傳播時重新計算前向傳播的激活值,而不是在顯存中保存它們。這叫 梯度檢查點(Gradient Checkpointing),以計算時間換取存儲空間。

- 顯存使用 = 參數+激活數據+參數梯度(+激活梯度)

- 前向顯存 = 參數 + 激活數據

- 反向顯存 = 參數 + 激活數據 + 參數梯度

- 激活梯度包括$dx$和prelu裡的$d\alpha$,后者幾乎可以忽略,dx不需要存儲,因為它是逐層即時計算並傳遞的。

- 兩倍關係:反向傳播的顯存需求 = 正向傳播需求 + 參數梯度需求,大約是兩倍,在transformer這種參數量一定大於激活數據的模型裡,反向對正向是大於兩倍關係的。

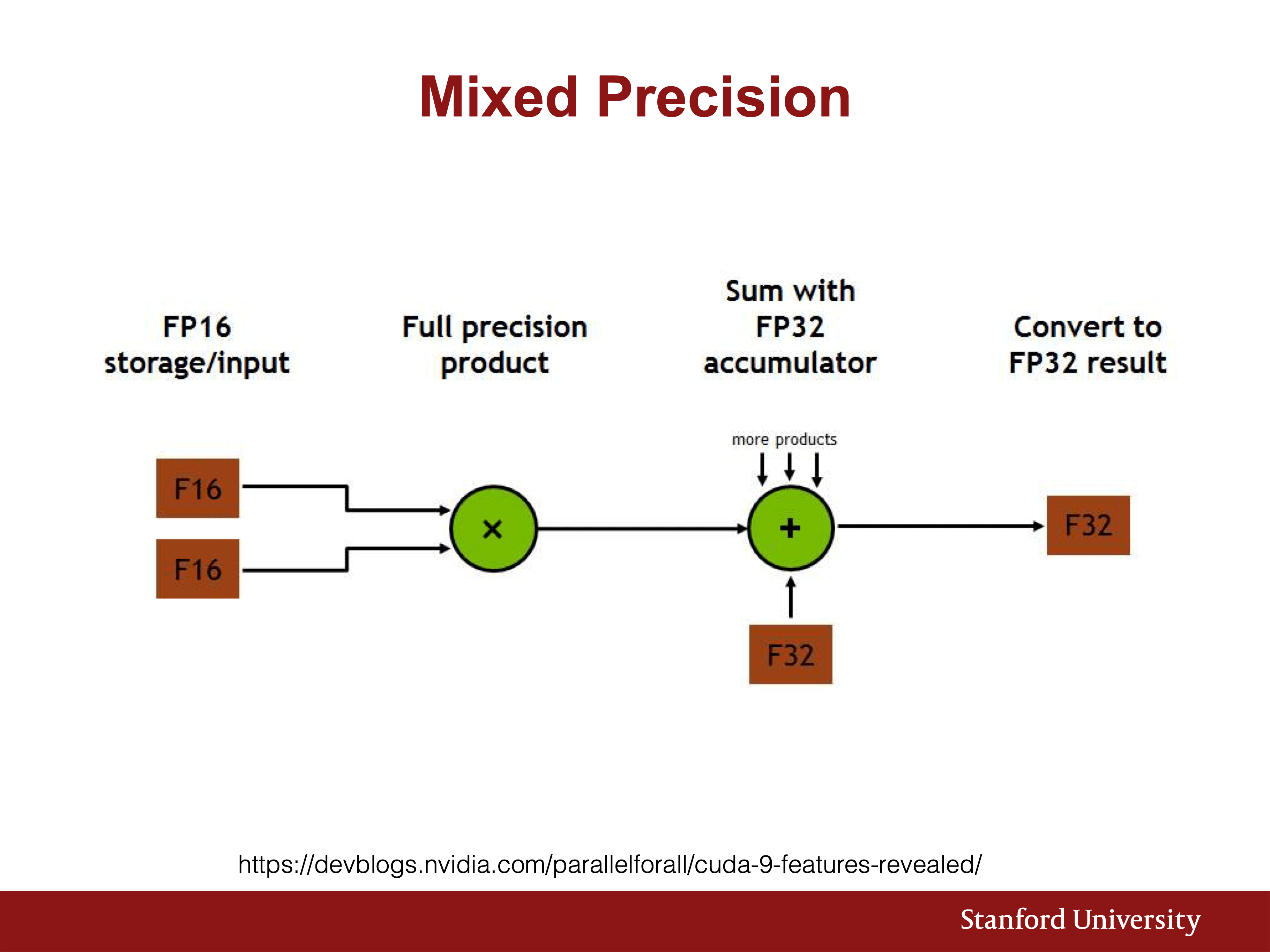

- 混合精度訓練(Mixed Precision Training): 使用 16-bit 浮點數(FP16)存儲激活數據和梯度,顯著減少Memory占用;

- 模型壓縮: 减少参数数量,通过剪枝等方法减少存储需求。改數據類型也可以用在參數上,能成倍減少開銷。

- 上面的Weights and Biases、Activations、Gradients都是以浮點數存儲,一般是FP32(32位浮點數,4字節),即實際佔用顯存量就是數據量 x 4bytes。

為什麼用Softmax沒人用SVM loss?因為就是效果好。

- 模型集成提分:Use ensembles for best results

- FC7學到的特徵可以用於其他任務:FC7 features generalize well to other tasks

GoogLeNet

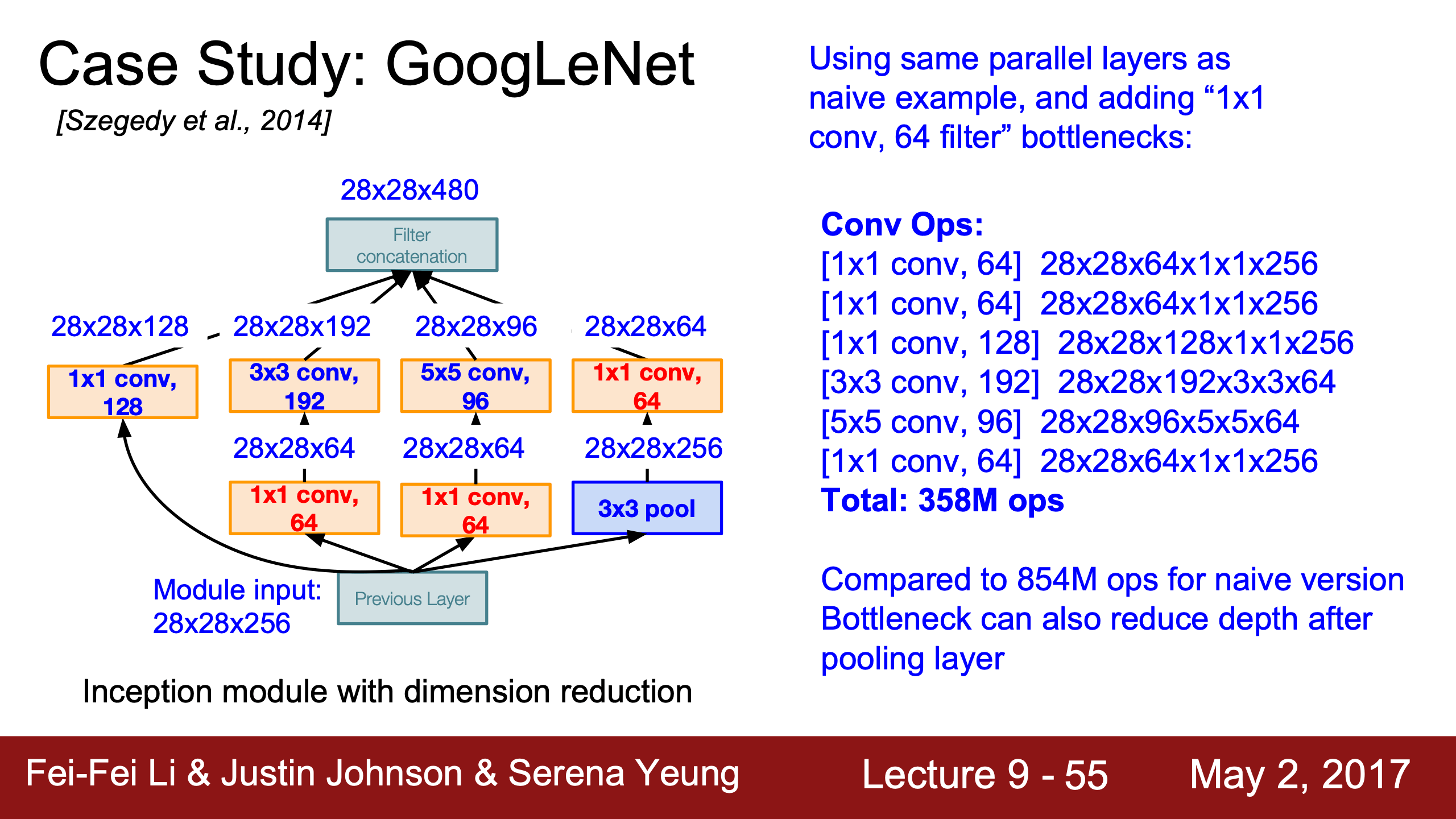

| 這裡通過padding強行讓output size都是28x28,而且pooling意味著下一個inception module的輸出只會更深層,開銷爆炸。 | 用1x1的conv減depth雖然會有一點information loss但是能降低超多開銷。 其他dimensionality reduction也是可以用的。 |

|---|---|

|

|

前面加兩個fc-loss(auxiliary outputs,training時3個loss不是分多次的只會有一次back prop,Serena也忘了inference時是三個loss取平均還是只用其中一個),更多地算前幾層梯度更新前幾層的參數,說是有更好的效果,說是有時梯度信息會在超長網絡裡丟失,這樣也可以緩解問題。

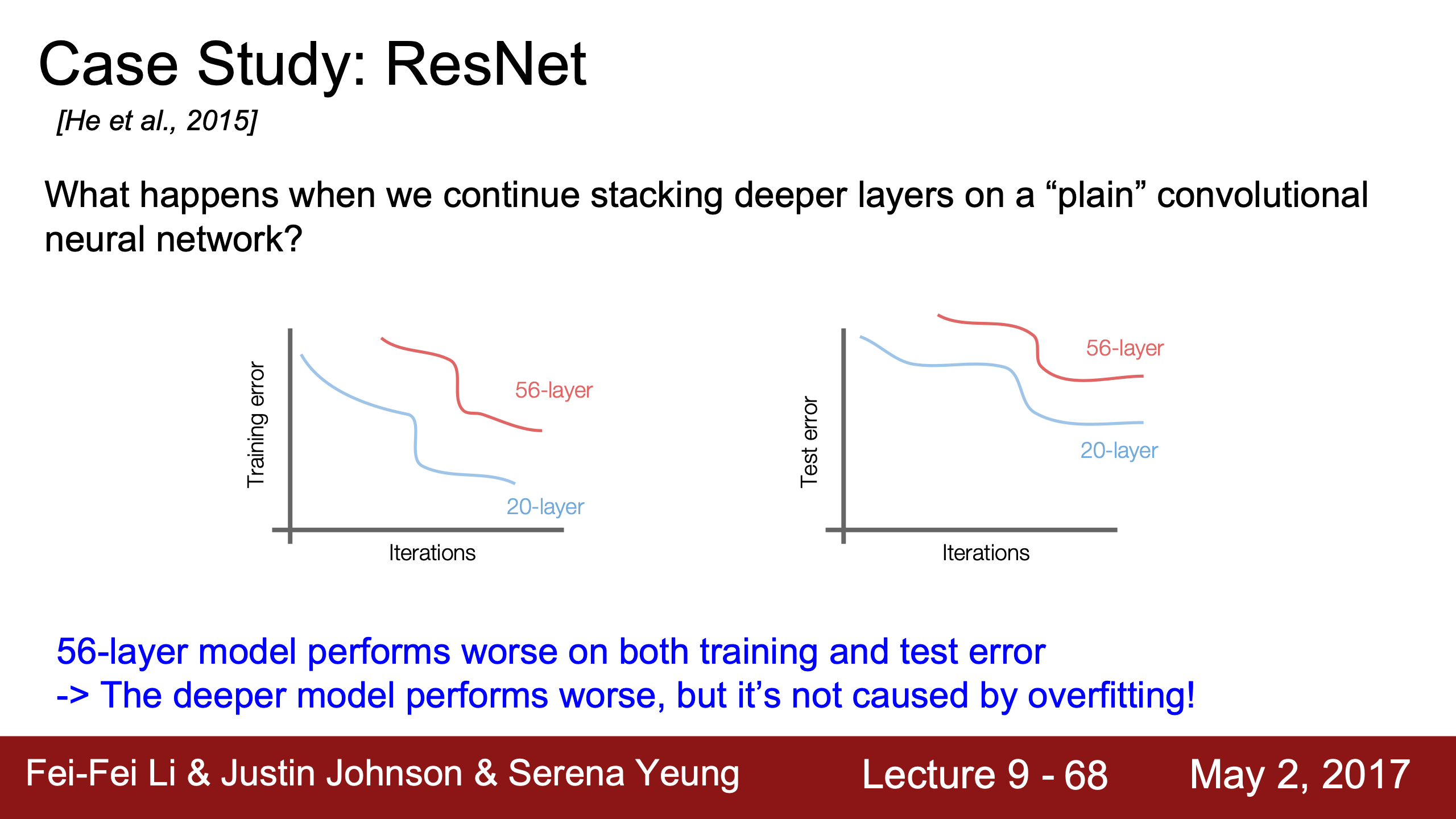

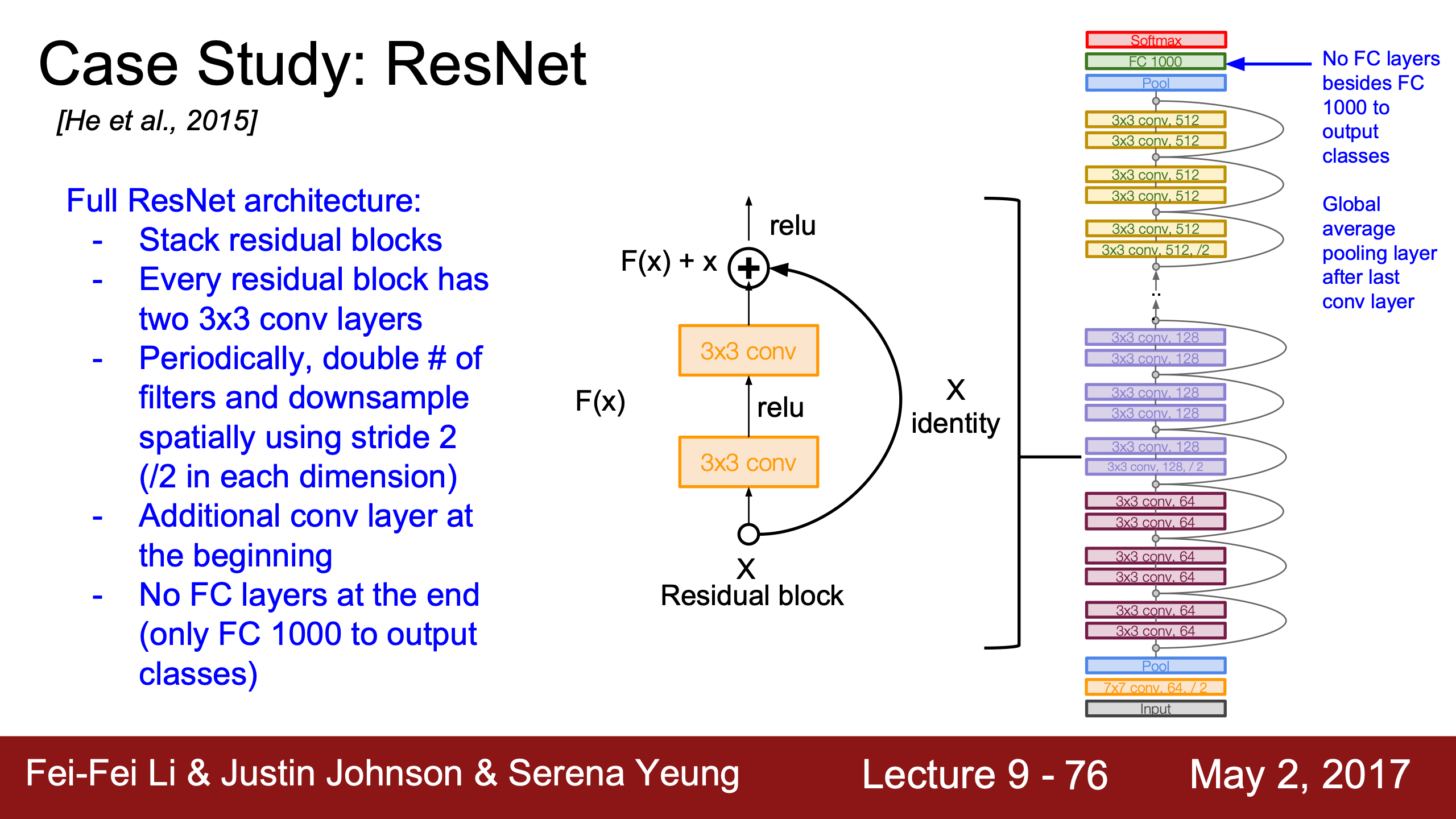

ResNet

何恺明閃亮登場。

既然趨勢是網絡越深效果越好,那可以直接狂堆層數嗎?這樣做其實會讓效果變差。而且是training/test error都高,所以並不是過擬合導致的。

一種假設是網絡越深越難優化,不然深層模型至少應該跟淺層一樣好,因為只需要copy淺層剩下的層讓input和ouput一致就行了。

那麼就讓模型學x的residual(x的殘餘),模型完全可以把f(x)學成0達到上面說的效果,也許這樣會更簡單一點。

|

|

實現細節:

| 丟掉VGG的兩層FC之後,參數量大大減少,記得上面VGG那裡計算參數量時幾乎全部都來自FC | 跟GoogLeNet一樣可以用1x1的conv減少channel depth | |

|---|---|---|

|

|

|

H(x) = f(x) + x裡,f(x) 和 x 的concatenation如果維度不同就無法逐元素相加,所以:

1. 維度本來一致時

如果 $x$ 和 $f(x)$ 的通道數和空間尺寸一致,直接相加即可:

- 條件:$x$ 和 $f(x)$ 的形狀為 $[N, C, H, W]$,其中 $N$ 是 batch size,$C$ 是通道數,$H$ 和 $W$ 是特徵圖的高和寬。

2. 通道數不一致時

當 $f(x)$ 改變了通道數時,需要對 $x$ 進行通道數匹配。

解決方法:使用 $1 \times 1$ 卷積進行投影,將 $x$ 的通道數從 $C_{\text{in}}$ 變換為 $C_{\text{out}}$:

- $W_{\text{proj}}$ 是 $1 \times 1$ 卷積核。

- $x’$ 和 $f(x)$ 的形狀一致。

3. 空間尺寸不一致時

當步幅 $s > 1$ 導致 $f(x)$ 的空間尺寸縮小(例如從 $[H, W]$ 變為 $[H/s, W/s]$),需要對 $x$ 進行下採樣。

解決方法:使用帶步幅 $s$ 的 $1 \times 1$ 卷積,同時調整通道數和空間尺寸:

- $x’$ 的形狀與 $f(x)$ 保持一致。

總之都是用 1x1 的conv修改維度。

Other Architectures

- Network in Network (NiN)

- DenseNet,原來是中國人做的,根據這個solution試試看吧。

- SqueezeNet

沒細看,又開始急了,趕緊RNN。

MLP(Multi-Layer Perceptron) = 多層 FC 層(Fully Connected Layer) + 激活函數 + 正則。

Lecture 10

JJ為什麼說AlexNet是9層?chatgpt:

AlexNet 是一個經典的卷積神經網絡,最初提出時被認為是 8 層深,但有時也被描述為 9 層。這取決於如何計算層的數量。總層數 = 卷積層(5 層)+ 全連接層(3 層)+ Softmax概率輸出層(有時算有時不算)。

2014年還沒出BN,所以VGG和GoogleNet訓練得很吃力,不太能收斂。VGG是先訓練了個11層的,後續往裡加成16/19層,JJ說GoogLeNet的兩個ugly hacks只是用來幫助收斂的。

residual也會讓梯度更好反向傳播,因為有一條x的直通路線,完全不用擔心梯度消失(爆炸還是會的吧?)。

管理梯度流在任何模型裡都很重要,包括RNN。

recurrent nn是Justin Johnson’s favourite topic.

循環nn vs. 递归nn

vanilla RNN

又叫做Simple RNN或Elman RNN。

每層用的W都是一樣的,更新 $\frac{\partial L}{\partial W}$ 的梯度則為每個time step的梯度之和:

computational graph:

|

|

|

|

|

最大概率argmax vs. 採樣sample, vanilla

sampling是根據每個詞(輸出)的概率分佈進行隨機選擇,不是均勻分布的隨機採樣,哪個詞softmax後概率大被選中的概率就大。生成更多元、創造性或不確定的輸出,提高結果的真實感。

test time不用softmax用one-hot的原因:1.如果train/test給模型的東西不一致通常會輸出garbage;2.假如vocabulary是以萬計的詞表,用softmax這種dense vector會增加計算開銷,會傾向於用one-hot這種sparse vector。

這群同學問的問題都太好了。

為降低開銷使用截斷反向傳播Truncated Backpropagation Through Time (TBPTT),其實類似於我們不做full batch的gradient descent而選擇用mini-batches的SGD,這裡只用幾百個time steps計算一次梯度。

vanilla rnn就講到這,剩下的JJ就讓自己看min-char-rnn的代碼了。

attention

| image captioning用CNN+RNN時,有很多組合的方式,比如把image information直接乘Weights加到第一個time step上。 | training階段在每個caption的最後都加一個<end>token(開頭加<start>),所以模型test階段會傾向於在最後採樣結束標誌。 |

|---|---|

|

|

可以用Microsoft Coco數據集從頭到尾訓練這樣一個CNN+RNN,也可以固定CNN最後的FC層,訓練RNN的時候捎帶更新FC。

| JJ還講到了第一篇用到hard attention(不可導,后面強化學習還要講)的文章Show, Attend and Tell: Neural Image Caption Generation with Visual Attention, ICML 2015 | 第一個在神經網絡訓練裡用soft attention的是Neural Machine Translation by Jointly Learning to Align and Translate, ICLR 2015 |

|---|---|

|

|

VQA也在用attention機制,image和word vectors的結合最常用的就是直接concatenation。

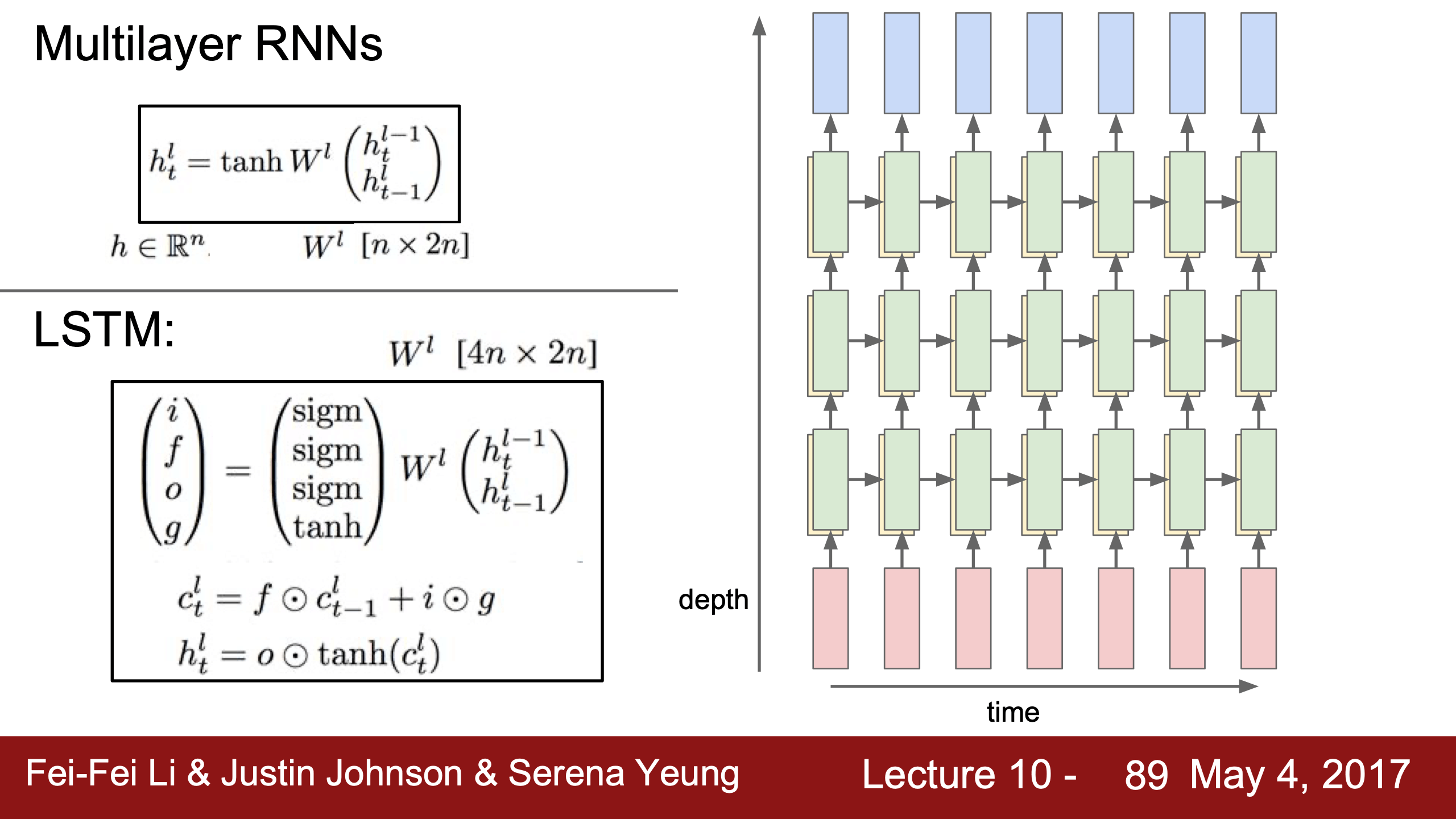

Multilayers RNN

多層也一般就三四五層,RNN沒有很深層的,LSTM也一樣。

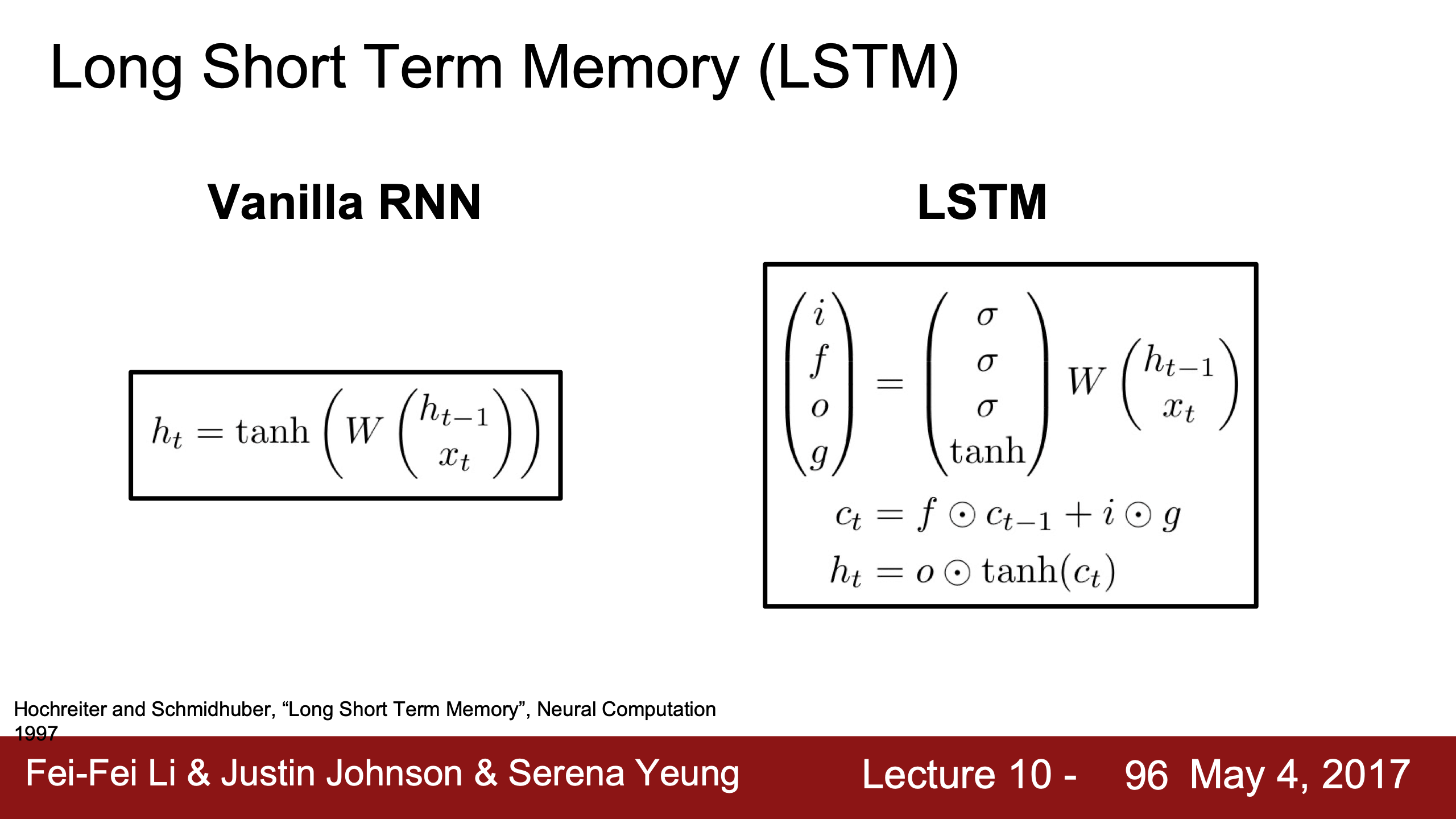

LSTM

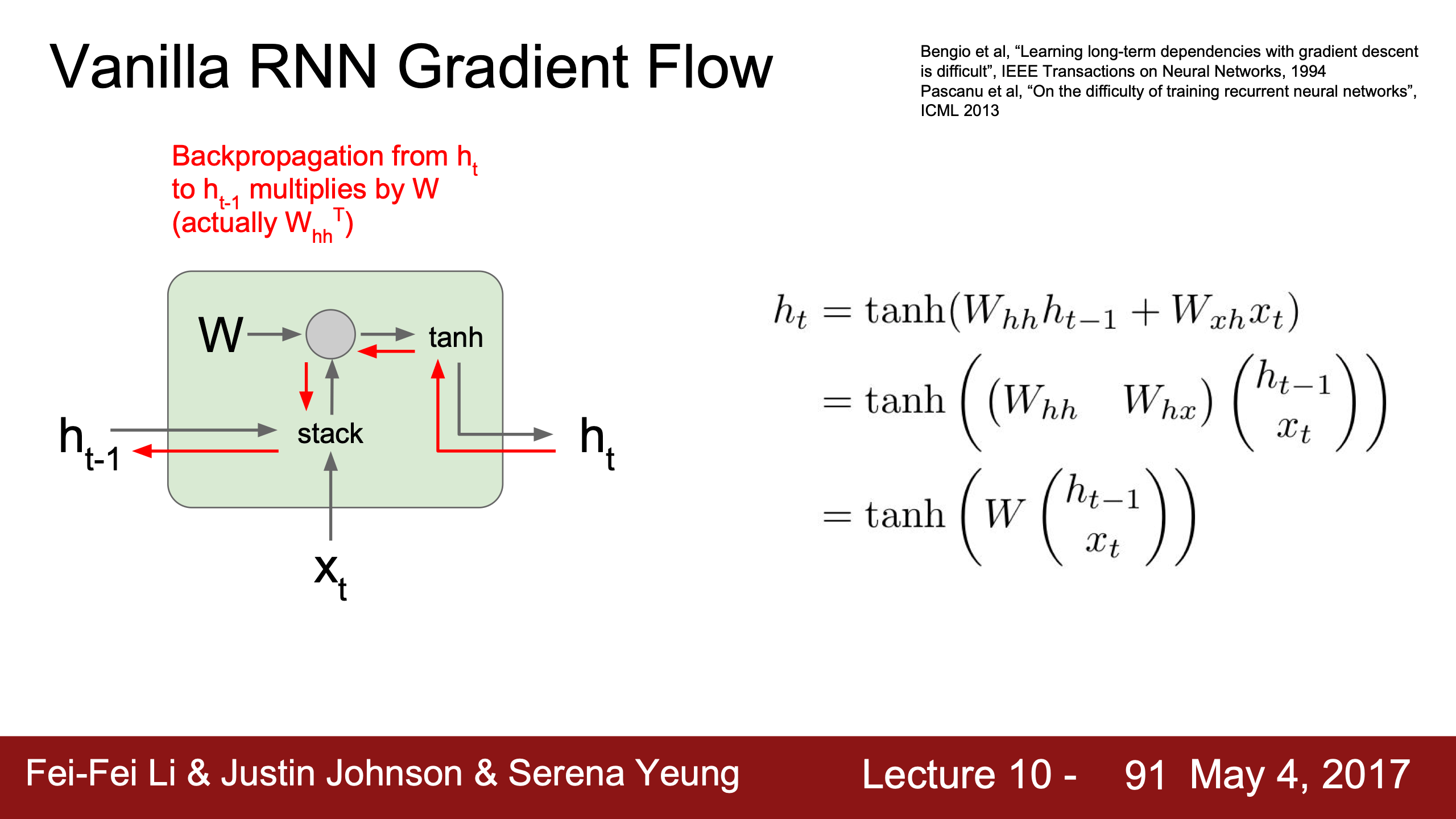

因為向前面time step傳遞梯度時,$dh$ 會不停地乘 $dtanh$ (即 $1-tanh^2$ )和 $W^T$ ,這個值是不變的(截斷back prop也要很多time steps才update params),

| 如果這個 $dtanh \cdot W^T$ 值大於1,傳遞到最開始的 $dh_0$ 就很可能梯度爆炸, | 小於1就很可能梯度消失。 |

|---|---|

|

|

解決方案是,太大就直接clamp截斷,為了應對太小的問題則需要其他RNN架構(LSTM同時能解決exploding和vanishing,已經是1997年的論文了,Long Short-Term Memory, Neural Computation, 1997, Sepp Hochreiter, Jürgen Schmidhuber (German))。

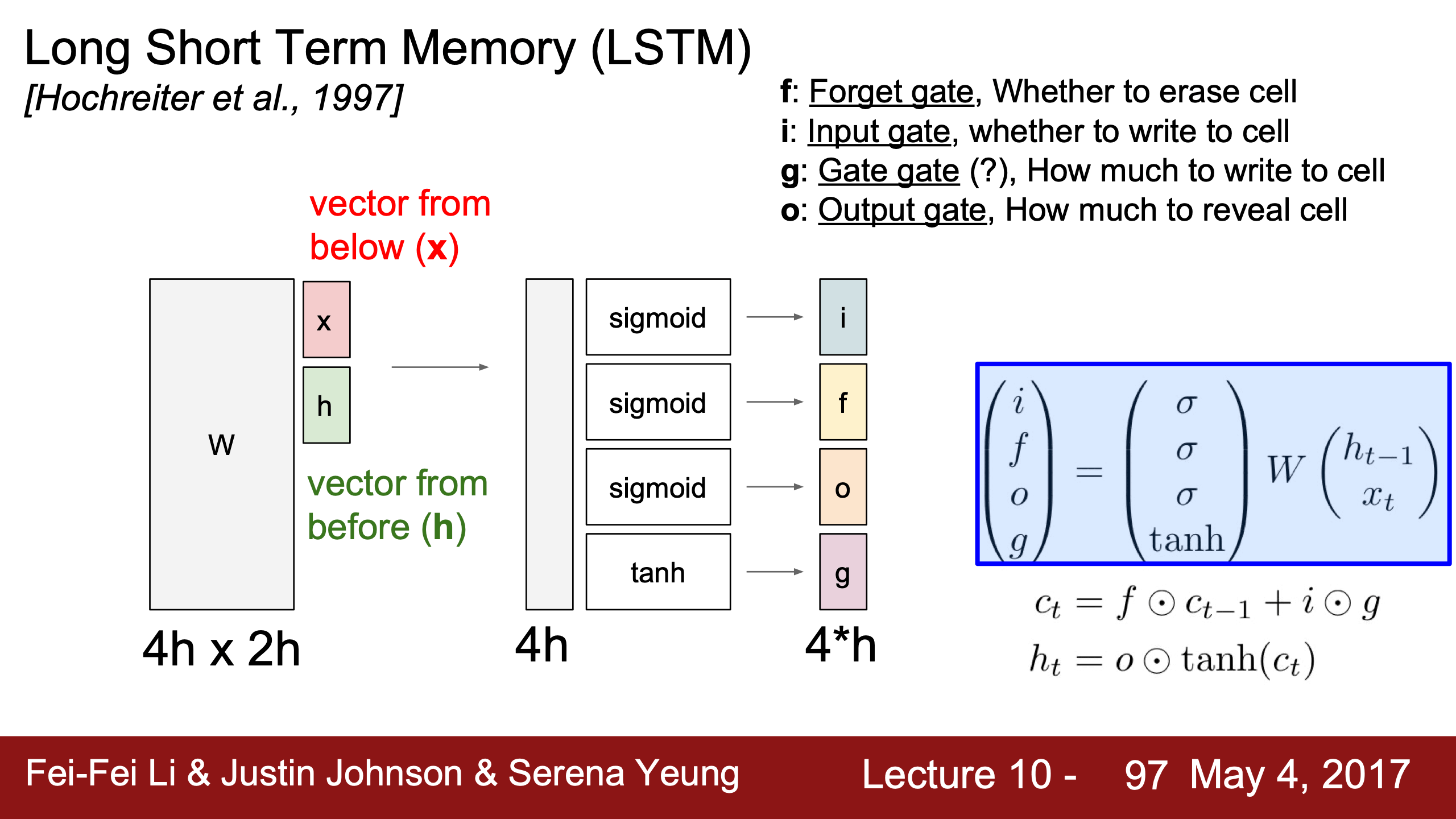

| 公式裡的 是指concatenation之後的vector,LSTM相比vanilla RNN除了hidden state $h_t$ 之外還需要maintain一個cell state $c_t$,$c_t$ 是個幾乎只在cell內部作用的內部量 | LSTM同樣是用這個stack的向量 ((h+x), 1) 乘一個大的W (4h, (h+x)),結果直接切分成4個(h, 1)維向量,然後分別通過3個sigmoid和1個tanh激活函數得到4個跟hidden state(h)維度相同的門gates(i f o g)。 |

|---|---|

|

|

理解下右邊右下角公式:

- f是被sigmoid拉到0~1的值,跟cell state相乘可以理解成是否遺忘上一個時間的狀態,0為遺忘1為記住;

- i也是0~1,用於決定本個LSTM cell的信息是否被寫入cell state;

- g是-1~1的值,中文是“候選記憶單元”,是待寫入cell state的信息;

- 所以 $c_t$ 的更新規則為,除了決定是否記住/忘記上個cell state,每個time step還會加一個(-1, 1)之間的值;

- 所以其實 $c_t$ 類似於一個time step的計數器,每個time step ±1;

- 在計算完cell state之後,就用 $c_t$ 來計算真正暴露在cell外的外部量,hidden state;

- o是被sigmoid壓縮到0~1的值,$c_t$ 通過 tanh 被 squashed 壓縮到 (-1, 1)之間與 $o$ 相乘,所以 $o$ 用來決定是否把 $c_t$ 用於外部計算。

一個最直接的疑問可能是:這樣被壓縮到0到1之間的 $x_t$ 和 $h_t$ 不會造成信息損失嗎?——其實是不會的,不管那些“平滑變換”之類的說法,vanilla RNN本身和FC和CNN都是會用所謂的non-linearity把值 squash 到 0~1 或 -1~1 之間。

在本節最下面再討論一次激活函數non-linearity的問題。

| 上面的加法只會直接傳遞upstream,乘法會讓upstream逐元素乘forget gate f,1.這樣傳遞梯度只會有逐元素乘,优於vanilla RNN的 $dtanh \cdot W^T$的矩陣乘;2.這樣每個time step的梯度反向傳播不會不斷地反覆地乘一個W,而會是乘不同的0~1之間的f,這樣不容易梯度消失? | cell state這條通過additive和element wise multiplicative interactions傳遞梯度的highway跟resnet很像 |

|---|---|

|

|

關於上面JJ說的的兩個好處我滿滿都是疑問:

- 為什麼只有逐元素乘?因為更新W是通過i f o g四個門更新的,這些正向都是逐元素乘操作,所以反向梯度也是逐元素乘;

- 但為什麼逐元素乘好過矩陣乘?不知道是說訓練效率還是模型效果;

- 為什麼反覆乘一個f不會導致梯度消失?f在0~1之間,就算一個位置一直是0.99經過100個time steps也會變成0.366!

- 說是乘W是固定一直乘一個,f是動態的,所以好;

- 說是傳遞cell state的梯度不經過tanh只經過加法操作(f i g都沒有tanh,只有o有,但是它們本身的sigmoid不會影響穩定性嗎?)梯度傳遞更穩定。

- 1:08:41原來JJ講到了!我太喜歡他們了——

- 說是確實會有這種問題,所以在實踐中大家可能會把forget gate的biases都初始化為正數,所以在訓練剛開始時forget gate會一直接近1保證乾淨的梯度流,

- 確實仍然會存在vanishing的問題,但是會比vanilla RNN好非常多,就是因為1. forget gate是變化的,而且2. 是元素乘不是矩陣乘。

總之我們關心的只有W和dW,原本的RNN的 $\frac{\partial L}{\partial W}$ 只會通過h傳導而存在不停乘 $W^T$ 的問題,現在LSTM的 $\frac{\partial L}{\partial W}$ 同時通過 c 和 h 傳導,而 c 的梯度相比 h 有以上那些好處,所以回傳的梯度會更乾淨更穩定。

Takeaway:

後來二十多年的研究裡並沒有效果全面超過LSTM或GRU的,可能某一個任務強但是其他任務弱。

可能直接用LSTM或GRU不會有什麼神奇的效果,但是通過添加 加法additive connections 和 乘法門multiplicative gates 來讓梯度流更合理地反向傳播的思路往往很有用。

激活函數non-linearity

sigmoid、tanh、relu的目的是对数据进行平滑变换,不會丟棄信息,通过将输入映射到一个新的范围,使其在更合理的范围内流动,而不会出现过大的数值波动(避免梯度爆炸)或数值消失(避免梯度消失)。

它們基本都保留了輸入信號的大小和方向,而且能允许网络捕捉复杂的非线性关系。

在上面Lecture 4那也想過相關問題,“這裡其實我一直有個疑問,如果X裡有x1 x1x2 x1x2x3這種高階特徵,那豈不是不再線性了?這個問題其實有點蠢,因為線性關係是指x1和f(x1)、x1x2和f(x1x2)、x1x2x3和f(x1x2x3)之間是線性/直線,而不是x1x2/x1x2x3跟f(x1)”。

Lecture 10 Summary

- RNNs allow a lot of flexibility in architecture design

- Vanilla RNNs are simple but don’t work very well

- Common to use LSTM or GRU: their additive interactions improve gradient flow

- Backward flow of gradients in RNN can explode or vanish. Exploding is controlled with gradient clipping. Vanishing is controlled with additive interactions (LSTM)

- Better/simpler architectures are a hot topic of current research

- Better understanding (both theoretical and empirical) is needed.

RNN本身效果太差,用就用LSTM,雖然equations看起來crazy,但是make sense,因為優化了backprop gradient flow。

Lecture 11

HyperQuest它們開發完了,對他們同學有extra credit的調參遊戲,有空(when?)跟上面之前幾個demo一起玩一玩。

之前的主題都是image classification,這節課講detection/segmentation/localization和其他tasks。

Semantic Segmentation

語義分割任務目標是給每一個像素分一個label,這裡跟圖像分類一樣,數據集裡我們關心的類別是10個100個1000個提前確定的類。

右邊不區分兩頭牛都打上cow是語義分割的一個短板,instance segmentation實例分割會解決這個問題。

所以這類任務的數據很昂貴,需要用軟件手動畫邊界。

| 對應降維的pooling層,升維時是unpooling/upsampling,即復原MASK其他的位置都補0。 | 對應降維的conv層,升維時還是用filter走stride,只不過把conv的內積變成逐元素乘。 |

|---|---|

|

|

| 用矩陣乘表示convolution操作的話,現在的升維convolution就是輸入transpose一下,這裡是stride=1的演示 | stride = 2 |

|---|---|

|

|

transpose convolution真是個好主意,叫做”transpose”也真的很聰明,但其實也就是玩維度遊戲,剩下的一切交給optimizer罷了。不要叫deconvolution,因為反卷積不是這個操作。我在上面cnn convolution部分討論原初的signal processing convolution的地方補充了反卷積的概念,以及改掉了一開始chatgpt的錯誤例子。

用的都是很熟悉的模塊,但是稍加修改立刻就能應用到其他任務上,這super cool也super 爽。我的論文可以學這裡把模型遷移到其他任務的思路,兵來將擋水來土掩,包括diffusion和transformer之外用上面的LSTM機制會看起來很屌。

Classification + Localization

這個任務跟目標檢測object detection的區別是,Classification + Localization 分类 + 定位任務事先假設只有 1 個目標或者exact多個目標只生成exact 1 個bounding box邊界框。

| 如果這個multitask loss不是直接加起來,而是用一個weight做weighted sum,那麼就需要一個loss之外的metric衡量performance,因為一般我們調超參都是以loss為指標,換幾個hyper parameters看loss怎麼變化,但這個weighting parameter是會直接影響loss值的 | 這個任務可以應用到其他地方,比如Human Pose Estimation人体姿态估计。 |

|---|---|

|

|

- 把兩條路合成一個可行嗎?未必,這裡只是basic setup。

- 那如果不把兩個loss合成一個multitask loss而是分辨訓練兩個FC呢?JJ說在Transfer Learning時Fine Tune Jointly(聯合訓練)永遠效果都好過分開tune,因為features的mismatch,但是也有一個trick是分開訓練完都converge收斂了,再合在一起jointly訓練一下,這樣也是可以的。

這裡同學的一個問題很好:為什麼這裡JJ說Human Pose Estimation用“regression loss”,指的是什麼?

JJ說他指的就是cross-entropy(softmax)或者SVM loss之外的loss,比如L2和L1 loss,如果你希望輸出是離散的(如classification)就用softmax loss(classification loss),如果希望輸出是連續的(比如這裡)那就用L2(regression loss)。

單獨討論一下回歸問題和分類問題吧。

回歸vs.分類 (Classification vs. Regression)

簡單來說,

- 回归是預測連續值,使用MSE (Mean Squared Error, 均方误差) 损失函数。

分类是預測離散值,把數據分配到離散類別,使用交叉熵损失函数。

- MSE确实可以用于分类任务,但它并没有交叉熵损失那么直观且有效,尤其在处理概率和梯度更新方面。

- 交叉熵更适合分类任务,它是专门为概率分布设计的,能够更好地处理类别之间的关系,并且有更稳定和有意义的梯度。

假设我们有一个二分类问题,类别0和类别1。

- 模型的输出为0.7,表示模型认为它属于类别1的概率为0.7。

- 真实标签是类别0(即标签为0)。

$\text{MSE} = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2$

MSE = (0 - 0.7)² = 0.49

$\text{Cross-Entropy Loss} = -\left( y \log(\hat{y}) + (1 - y) \log(1 - \hat{y}) \right) = -(0 \cdot \log(0.7) + (1 - 0) \cdot \log(1 - 0.7)) = - \log(0.3) \approx 1.204 $

可以發現,

- 交叉熵的loss更大,即對錯誤的懲罰更大,錯得越離譜用log就大得越多;

- 還是因為這個對數,對數曲線是越接近0時越陡,根據上面的公式模型預測越錯誤log的自變量就越接近0,梯度就越大,模型更新得就越快。

反過來看回歸的例子:

- 假如我們在預測房價,一個數據的真實房價是3.5,預測值是3。